Introducción a la ciencia I (parte 2)

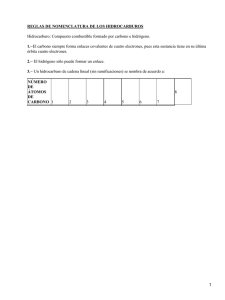

Anuncio