Minería de Datos - Técnicas Descriptivas y Predictivas de Clasificación

Anuncio

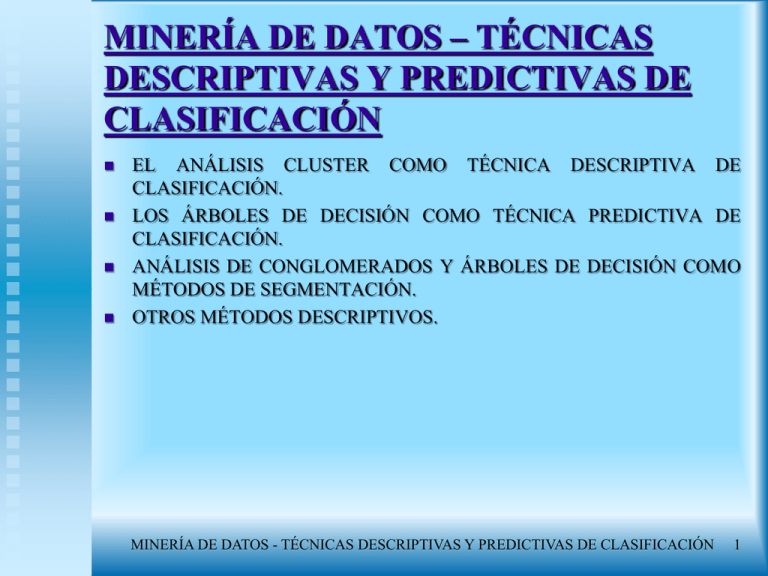

MINERÍA DE DATOS – TÉCNICAS

DESCRIPTIVAS Y PREDICTIVAS DE

CLASIFICACIÓN

EL ANÁLISIS CLUSTER COMO TÉCNICA DESCRIPTIVA DE

CLASIFICACIÓN.

LOS ÁRBOLES DE DECISIÓN COMO TÉCNICA PREDICTIVA DE

CLASIFICACIÓN.

ANÁLISIS DE CONGLOMERADOS Y ÁRBOLES DE DECISIÓN COMO

MÉTODOS DE SEGMENTACIÓN.

OTROS MÉTODOS DESCRIPTIVOS.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN

1

EL ANÁLISIS CLUSTER COMO

TÉCNICA DESCRIPTIVA DE

CLASIFICACIÓN

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN

2

EL ANÁLISIS CLUSTER

EL ANÁLISIS CLUSTER ES UNA TÉCNICA DE CLASIFICACIÓN

AUTOMÁTICA DE DATOS.

SU FINALIDAD ESENCIAL ES REVELAR CONCENTRACIONES EN

LOS DATOS (CASOS O VARIABLES) PARA SU AGRUPAMIENTO

EFICIENTE EN CLUSTERS (O CONGLOMERADOS) SEGÚN SU

HOMOGENEIDAD.

EL AGRUPAMIENTO PUEDE REALIZARSE TANTO PARA CASOS

COMO PARA VARIABLES, PUDIENDO UTILIZARSE VARIABLES

CUALITATIVAS O CUANTITATIVAS.

LOS GRUPOS DE CASOS O VARIABLES SE REALIZAN BASÁNDOSE

EN LA PROXIMIDAD O LEJANÍA DE UNOS CON OTRAS:

ES ESENCIAL EL USO ADECUADO DEL CONCEPTO DE

DISTANCIA.

ES FUNDAMENTAL QUE LOS ELEMENTOS DENTRO DE UN

CLUSTER SEAN HOMOGÉNEOS Y LO MÁS DIFERENTES

POSIBLES DE LOS CONTENIDOS EN OTROS CLUSTERS.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN

3

EL ANÁLISIS CLUSTER

EL ANÁLISIS CLUSTER ES UNA TÉCNICA DE CLASIFICACIÓN,

CONOCIÉNDOSE TAMBIÉN COMO TAXONOMÍA NUMÉRICA,

ANÁLISIS DE CONGLOMERADOS, ANÁLISIS TIPOLÓGICO,

CLASIFICACIÓN AUTOMÁTICA Y OTRAS.

EL NÚMERO DE CLUSTERS NO ES CONOCIDO DE ANTEMANO Y

LOS GRUPOS SE CREAN EN FUNCIÓN DE LA NATURALEZA DE LOS

DATOS:

SE TRATA POR TANTO DE UNA TÉCNICA DE CLASIFICACIÓN

POST HOC.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN

4

EL ANÁLISIS CLUSTER

EL ANÁLISIS CLUSTER ES UN MÉTODO ESTADÍSTICO

MULTIVARIANTE DE CLASIFICACIÓN AUTOMÁTICA:

A PARTIR DE UNA TABLA DE DATOS (CASOS-VARIABLES),

TRATA DE SITUARLOS EN GRUPOS HOMOGÉNEOS,

CONGLOMERADOS O CLUSTERS NO CONOCIDOS DE

ANTEMANO.

LOS

INDIVIDUOS QUE PUEDEN SER CONSIDERADOS

SIMILARES SON ASIGNADOS A UN MISMO CLUSTER.

LOS INDIVIDUOS DIFERENTES (DISIMILARES) SE LOCALIZAN

EN CLUSTERS DISTINTOS.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN

5

EL ANÁLISIS CLUSTER

LA DIFERENCIA ESENCIAL CON EL ANÁLISIS DISCRIMINANTE

ESTRIBA EN QUE:

EN

EL

ANÁLISIS

DISCRIMINANTE

ES

NECESARIO

ESPECIFICAR PREVIAMENTE LOS GRUPOS POR UN CAMINO

OBJETIVO (TÉCNICA DE CLASIFICACIÓN AD HOC).

EL ANÁLISIS CLUSTER DEFINE GRUPOS TAN DISTINTOS

COMO SEA POSIBLE EN FUNCIÓN DE LOS PROPIOS DATOS

SIN ESPECIFICACIÓN PREVIA DE LOS CITADOS GRUPOS

(TÉCNICA DE CLASIFICACIÓN POST HOC).

SI LAS VARIABLES DE AGLOMERACIÓN ESTÁN EN ESCALAS

MUY DIFERENTES SERÁ NECESARIO:

ESTANDARIZAR PREVIAMENTE LAS VARIABLES, O.

TRABAJAR CON DESVIACIONES RESPECTO DE LA MEDIA.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN

6

EL ANÁLISIS CLUSTER

ES NECESARIO OBSERVAR LOS VALORES ATÍPICOS Y

DESAPARECIDOS PORQUE:

LOS MÉTODOS JERÁRQUICOS NO TIENEN SOLUCIÓN CON

VALORES PERDIDOS.

LOS VALORES ATÍPICOS DEFORMAN LAS DISTANCIAS Y

PRODUCEN CLUSTERS UNITARIOS.

TAMBIÉN ES NOCIVA LA PRESENCIA DE VARIABLES

CORRELACIONADAS:

ES

IMPORTANTE

EL

ANÁLISIS

PREVIO

DE

MULTICOLINEALIDAD.

ES NECESARIO REALIZAR UN ANÁLISIS FACTORIAL PREVIO

Y POSTERIORMENTE SE AGLOMERAN LAS PUNTUACIONES

FACTORIALES.

LA SOLUCIÓN DEL ANÁLISIS CLUSTER NO TIENE POR QUÉ SER

ÚNICA:

NO DEBEN ENCONTRARSE SOLUCIONES CONTRADICTORIAS

POR DISTINTOS MÉTODOS.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN

7

EL ANÁLISIS CLUSTER

EL NÚMERO DE OBSERVACIONES EN CADA CLUSTER DEBE SER

RELEVANTE:

EN CASO CONTRARIO PUEDE HABER VALORES ATÍPICOS QUE

DIFUMINEN LA CONSTRUCCIÓN DE LOS CLUSTERS.

LOS CONGLOMERADOS DEBEN TENER SENTIDO CONCEPTUAL Y

NO VARIAR MUCHO AL VARIAR LA MUESTRA O EL MÉTODO DE

AGLOMERACIÓN.

LOS GRUPOS FINALES SERÁN TAN DISTINTOS COMO PERMITAN

LOS DATOS.

CON ESTOS GRUPOS SE PODRÁN REALIZAR OTROS ANÁLISIS:

DESCRIPTIVOS,

DISCRIMINANTE, REGRESIÓN LOGÍSTICA,

DIFERENCIA...

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN

8

EL ANÁLISIS CLUSTER

MEDIDAS DE SIMILITUD

SEGÚN LA CLASIFICACIÓN DE SNEATH Y SOKAL EXISTEN

CUATRO GRANDES TIPOS DE MEDIDAS DE SIMILITUD:

DISTANCIAS.

COEFICIENTES DE ASOCIACIÓN.

COEFICIENTES ANGULARES.

COEFICIENTES DE SIMILITUD PROBABILÍSTICA.

DISTANCIAS:

SE TRATA DE LAS DISTINTAS MEDIDAS ENTRE LOS PUNTOS

DEL ESPACIO DEFINIDO POR LOS INDIVIDUOS:

SE

TRATA DE LAS MEDIDAS INVERSAS DE LAS

SIMILITUDES, ES DECIR, DISIMILITUDES:

• EJ.: DISTANCIA EUCLÍDEA.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN

9

EL ANÁLISIS CLUSTER

MEDIDAS DE SIMILITUD

COEFICIENTES DE ASOCIACIÓN:

SE

UTILIZAN CUANDO SE TRABAJA CON DATOS

CUALITATIVOS.

TAMBIÉN SE PUEDEN APLICAR A DATOS CUANTITATIVOS SI

SE ESTÁ DISPUESTO A SACRIFICAR ALGUNA INFORMACIÓN

PROPORCIONADA POR LOS INDIVIDUOS O LAS VARIABLES.

ESTAS

MEDIDAS SON UNA FORMA DE MEDIR LA

CONCORDANCIA O CONFORMIDAD ENTRE LOS ESTADOS DE

DOS COLUMNAS DE DATOS.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 10

EL ANÁLISIS CLUSTER

MEDIDAS DE SIMILITUD

COEFICIENTES ANGULARES:

SE UTILIZAN PARA MEDIR LA PROPORCIONALIDAD E

INDEPENDENCIA ENTRE LOS VECTORES QUE DEFINEN LOS

INDIVIDUOS.

EL MÁS COMÚN ES EL COEFICIENTE DE CORRELACIÓN

APLICADO A VARIABLES CONTINUAS.

COEFICIENTES DE SIMILITUD PROBABILÍSTICA:

MIDEN LA HOMOGENEIDAD DEL SISTEMA POR PARTICIONES

O SUBPARTICIONES DEL CONJUNTO DE LOS INDIVIDUOS E

INCLUYEN INFORMACIÓN ESTADÍSTICA.

ESTOS COEFICIENTES SE DISTRIBUYEN COMO LA CHICUADRADO.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 11

EL ANÁLISIS CLUSTER

MEDIDAS DE SIMILITUD

EJEMPLOS MÁS CARACTERÍSTICOS DE CADA UNO DE LOS TIPOS

DE MEDIDAS DE SIMILITUD:

Distancias

𝐷𝑖𝑠𝑡𝑎𝑛𝑐𝑖𝑎 𝑒𝑢𝑐𝑙í𝑑𝑒𝑎 𝑎𝑙 𝑐𝑢𝑎𝑑𝑟𝑎𝑑𝑜 𝑑 𝑖, 𝑗

2

=

𝑘

𝐷𝑖𝑠𝑡𝑎𝑛𝑐𝑖𝑎 𝑒𝑢𝑐𝑙í𝑑𝑒𝑎 𝑑 𝑖, 𝑗 =

𝑘

𝐷𝑖𝑠𝑡𝑎𝑛𝑐𝑖𝑎 𝑑𝑒𝑀𝑖𝑛𝑘𝑜𝑤𝑠𝑘𝑖 𝑑𝑞 𝑖, 𝑗 =

𝑘

𝑥𝑖𝑘 − 𝑥𝑗𝑘

𝑥𝑖𝑘 − 𝑥𝑗𝑘

𝑥𝑖𝑘 − 𝑥𝑗𝑘

𝐷𝑖𝑠𝑡𝑎𝑛𝑐𝑖𝑎 𝐶𝑖𝑡𝑦 − 𝐵𝑙𝑜𝑐𝑘 𝑜 𝑑𝑒 𝑀𝑎𝑛ℎ𝑎𝑡𝑎𝑛 𝑑1 𝑖, 𝑗 =

𝑘

2

2

q

1/q

𝑥𝑖𝑘 − 𝑥𝑗𝑘

𝐷𝑖𝑠𝑡𝑎𝑛𝑐𝑖𝑎 𝑑𝑒 𝐶ℎ𝑒𝑏𝑖𝑐ℎ𝑒𝑣 𝑑∞ 𝑖, 𝑗 = 𝑀𝑎𝑥𝑘 𝑥𝑖𝑘 − 𝑥𝑗𝑘

𝐷𝑖𝑠𝑡𝑎𝑛𝑐𝑖𝑎 𝑑𝑒 𝐶𝑎𝑛𝑏𝑒𝑟𝑟𝑎 𝑑𝐶𝐴𝑁𝐵 𝑖, 𝑗 =

𝑥 𝑖𝑘 −𝑥 𝑗𝑘

𝑘 𝑥 𝑖𝑘 +𝑥 𝑗𝑘

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 12

EL ANÁLISIS CLUSTER

MEDIDAS DE SIMILITUD

LA DISTANCIA EUCLÍDEA AL CUADRADO ENTRE DOS

INDIVIDUOS SE DEFINE COMO LA SUMA DE LOS CUADRADOS DE

LAS DIFERENCIAS DE TODAS LAS COORDENADAS DE LOS DOS

PUNTOS:

LA DISTANCIA EUCLÍDEA SE DEFINE COMO LA RAÍZ

CUADRADA POSITIVA DE LA DISTANCIA ANTERIOR.

LA DISTANCIA DE MINKOWSKI ES UNA DISTANCIA GENÉRICA

QUE DA LUGAR A OTRAS DISTANCIAS EN CASOS PARTICULARES

Y SE DEFINE COMO LA RAÍZ q-ÉSIMA DE LA SUMA DE LAS

POTENCIAS q-ÉSIMAS DE LAS DIFERENCIAS, EN VALOR

ABSOLUTO, DE LAS COORDENADAS DE LOS DOS PUNTOS

CONSIDERADOS.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 13

EL ANÁLISIS CLUSTER

MEDIDAS DE SIMILITUD

LA DISTANCIA CITY-BLOCK O DISTANCIA DE MANHATAN:

ES UN CASO PARTICULAR DE LA DISTANCIA O MEDIDA DE

MINKOWSKI CUANDO q = 1.

ES LA SUMA DE LAS DIFERENCIAS, EN VALOR ABSOLUTO, DE

TODAS LAS COORDENADAS DE LOS DOS INDIVIDUOS CUYA

DISTANCIA SE CALCULA.

ES CERO PARA LA SIMILITUD PERFECTA Y AUMENTA A

MEDIDA QUE LOS OBJETOS SON MÁS DISIMILARES.

LA DISTANCIA DE CHEBYCHEV:

SE DEFINE COMO EL CASO LÍMITE DE LA MEDIDA DE

MINKOWSKI PARA q → ∞.

ES EL MÁXIMO DE LAS DIFERENCIAS ABSOLUTAS DE LOS

VALORES DE TODAS LAS COORDENADAS.

LA DISTANCIA CANBERRA ES UNA MODIFICACIÓN DE LA

DISTANCIA MANHATAN QUE ES SENSIBLE A PROPORCIONES Y NO

SÓLO A VALORES ABSOLUTOS.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 14

EL ANÁLISIS CLUSTER

MEDIDAS DE SIMILITUD

LOS COEFICIENTES DE ASOCIACIÓN SUELEN UTILIZARSE PARA

EL CASO DE VARIABLES CUALITATIVAS, Y EN GENERAL PARA

EL CASO DE DATOS BINARIOS (O DICOTÓMICOS):

SON AQUELLOS QUE SÓLO PUEDEN PRESENTAR DOS

OPCIONES:

BLANCO - NEGRO, SI - NO, HOMBRE - MUJER, VERDADERO FALSO, ETC.

EXISTEN

DIFERENTES MEDIDAS DE PROXIMIDAD O

SIMILITUD, PARTIENDO DE UNA TABLA DE FRECUENCIAS

2X2 EN LA QUE SE REPRESENTA EL NÚMERO DE ELEMENTOS

DE LA POBLACIÓN EN LOS QUE SE CONSTATA LA PRESENCIA

O AUSENCIA DEL CARÁCTER (VARIABLE CUALITATIVA) EN

ESTUDIO.

Variable 1

Variable 2

Presencia

Ausencia

Presencia

Ausencia

a

c

b

d

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 15

EL ANÁLISIS CLUSTER

MEDIDAS DE SIMILITUD

𝑎

𝑎

=

(𝑎 + 𝑢)

(𝑎 + 𝑏 + 𝑐)

𝐶𝑜𝑒𝑓𝑖𝑐𝑖𝑒𝑛𝑡𝑒 𝑑𝑒 𝑒𝑚𝑝𝑎𝑟𝑒𝑗𝑎𝑚𝑖𝑒𝑛𝑡𝑜 𝑠𝑖𝑚𝑝𝑙𝑒

𝑚

𝑚

(𝑎 + 𝑑)

𝑆𝑆𝑀 =

= =

Coeficientes de asociación

(𝑚 + 𝑢) 𝑛

(𝑎 + 𝑏 + 𝑐 + 𝑑)

(𝑎𝑑 − 𝑏𝑐)

𝐶𝑜𝑒𝑓𝑖𝑐𝑖𝑒𝑛𝑡𝑒 𝑑𝑒 𝑌𝑢𝑙𝑒 𝑆𝑌 =

(𝑎𝑑 + 𝑏𝑐)

𝐽𝑎𝑐𝑐𝑎𝑟𝑑 − 𝑆𝑛𝑒𝑎𝑡ℎ 𝑆𝑗 =

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 16

EL ANÁLISIS CLUSTER

MEDIDAS DE SIMILITUD

EL COEFICIENTE DE JACCARD – SNEATH:

ES UNO DE LOS MÁS SENCILLOS.

NO TIENE EN CUENTA LOS EMPAREJAMIENTOS NEGATIVOS.

SE DEFINE COMO EL N° DE EMPAREJAMIENTOS POSITIVOS

ENTRE LA SUMA DE LOS EMPAREJAMIENTOS POSITIVOS Y

LOS DESACUERDOS.

A PARTIR DE SU EXPRESIÓN SE DEDUCE QUE Sj TIENDE A

CERO CUANDO a/u TIENDE A CERO:

Sj ES CERO CUANDO EL N° DE EMPAREJAMIENTOS

POSITIVOS COINCIDE CON EL DE DESACUERDOS.

Sj TIENDE A UNO CUANDO u TIENDE A CERO, ES DECIR, Sj

VALE UNO CUANDO NO HAY DESACUERDOS.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 17

EL ANÁLISIS CLUSTER

MEDIDAS DE SIMILITUD

EL COEFICIENTE DE YULE VARÍA ENTRE +1 Y -1.

EL COEFICIENTE DE EMPAREJAMIENTO SIMPLE:

SE DEFINE COMO EL COCIENTE ENTRE EL

EMPAREJAMIENTOS Y EL N° TOTAL DE

CONSIDERADOS.

DE SU EXPRESIÓN SE DEDUCE:

𝑚

𝑢

𝑆𝑆𝑀 → 0 𝑠𝑖

→ 0 𝑦 𝑆𝑗 → 1 𝑠𝑖

→1

𝑢

𝑚

N° DE

CASOS

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 18

EL ANÁLISIS CLUSTER

MEDIDAS DE SIMILITUD

EN EL CASO DE LOS COEFICIENTES ANGULARES SU CAMPO DE

VARIACIÓN ESTÁ ENTRE -1 Y +1:

LOS VALORES CERCANOS A 0 INDICAN DISIMILITUD ENTRE

LOS INDIVIDUOS.

LOS VALORES QUE SE ACERCAN A +1 O A -1 INDICAN

SIMILITUD POSITIVA O NEGATIVA RESPECTIVAMENTE.

EL CÁLCULO DE ESTE COEFICIENTE ENTRE LOS INDIVIDUOS i

Y j SE REALIZA EN FUNCIÓN DE Xi Y Xj QUE SON LAS MEDIAS

CORRESPONDIENTES A LOS INDIVIDUOS i Y j.

k

𝐶𝑜𝑒𝑓𝑖𝑐𝑖𝑒𝑛𝑡𝑒 𝑑𝑒 𝑐𝑜𝑟𝑟𝑒𝑙𝑎𝑐𝑖ó𝑛 𝑟𝑖𝑗 =

k

x𝑖𝑗 − Xi xjk − Xj

xik − X𝑖

Coeficientes angulares

𝑘

𝐷𝑖𝑠𝑡𝑎𝑛𝑐𝑖𝑎 𝑑𝑒𝑙 𝑐𝑜𝑠𝑒𝑛𝑜 𝑐𝑜𝑠𝛼𝑖𝑗 =

𝑘

𝑥𝑖𝑘

2

k

xjk − Xj

2 1/2

𝑥𝑖𝑘 − 𝑥𝑗𝑘

2

𝑘

𝑥𝑗𝑘

2 1/2

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 19

EL ANÁLISIS CLUSTER

MEDIDAS DE SIMILITUD

LOS COEFICIENTES DE SIMILITUD PROBABILÍSTICA:

CALCULAN LA PROBABILIDAD ACUMULADA DE QUE UN PAR

DE INDIVIDUOS i Y j, SEAN TAN SIMILARES, O MÁS, QUE LO

QUE EMPÍRICAMENTE SE PUEDE AFIRMAR SOBRE LA BASE DE

LA DISTRIBUCIÓN OBSERVADA.

PARA EL CASO DE VARIABLES CUALITATIVAS Y EN GENERAL

PARA EL CASO DE DATOS BINARIOS O DICOTÓMICOS EXISTEN

VARIAS MEDIDAS DE SIMILARIDAD ADICIONALES:

Russel y Rao

Parejas simples

Jaccard

Dice y Sorensen

𝑎

𝑅𝑅𝑥𝑦 = 𝑎+𝑏+𝑐

𝑃𝑆𝑥𝑦 =

𝑎+𝑑

𝑎+𝑏+𝑐+𝑑

𝑎

𝐽𝑥𝑦 = 𝑎+𝑏+𝑐

2𝑎

𝐷𝑥𝑦 = 2𝑎+𝑏+𝑐

Sokal y Sneath

𝑆𝑆𝑥𝑦 = 2

Rogers y Tanimoto 𝑅𝑇𝑥𝑦 =

2(𝑎+𝑑)

𝑎+𝑑 +𝑏+𝑐

𝑎+𝑑

𝑎+𝑑+2(𝑏+𝑐)

𝑎

Sokal y Sneath(2) 𝑆𝑆2𝑥𝑦 = 𝑎+2(𝑏+𝑐)

Kulczynski

𝑎

𝐾𝑥𝑦 = 𝑏+𝑐

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 20

EL ANÁLISIS CLUSTER

MEDIDAS DE SIMILITUD

ENTRE LAS MEDIDAS DE SIMILARIDAD PARA PROBABILIDADES

CONDICIONALES DESTACAN LAS SIGUIENTES:

Kulczynski (medida 2)

Sokal y Sneath (medida 4)

Hamann

𝐾2𝑥𝑦 =

𝑎/(𝑎+𝑏)+𝑎/(𝑎+𝑐)

𝑆𝑆4𝑥𝑦 =

𝐻𝑥𝑦 =

2

𝑎 (𝑎+𝑏)+𝑎 (𝑎+𝑐 )+𝑑/(𝑏+𝑑)+𝑑/(𝑐+𝑑)

𝑎+𝑑 −(𝑏+𝑐)

4

𝑎+𝑏+𝑐+𝑑

ENTRE LAS MEDIDAS DE PREDICCIÓN SE ENCUENTRAN LA Dxy

DE ANDERBERG, LA Yxy DE YULE Y LA Qxy DE YULE:

Dxy =

𝑚𝑎𝑥 𝑎,𝑏 +𝑚𝑎𝑥 𝑐,𝑑 +𝑚𝑎𝑥 𝑎,𝑐 +𝑚𝑎𝑥 𝑏,𝑑 −𝑚𝑎𝑥 𝑎+𝑐,𝑏+𝑑 −𝑚𝑎𝑥 𝑎+𝑏,𝑐+𝑑

2(𝑎+𝑏+𝑐+𝑑)

𝑌𝑥𝑦 =

𝑎𝑑 − 𝑏𝑐

𝑎𝑑 +

𝑏𝑐

𝑎𝑑 −𝑏𝑐

𝑄𝑥𝑦 = 𝑎𝑑 + 𝑏𝑐

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 21

EL ANÁLISIS CLUSTER

MEDIDAS DE SIMILITUD

TAMBIÉN SE USAN OTRAS MEDIDAS BINARIAS:

Ochiai

𝑂𝑥𝑦 =

Sokal y Sneath(3)

Euclídea binaria

Euclídea binaria2

Dispersión

Lance y Williams

𝑎

.

𝑎

𝑎+𝑏 𝑎+𝑐

𝑎+𝑑

𝑆𝑆3𝑥𝑦 =

𝑏+𝑐

𝐸𝐵𝑥𝑦 = 𝑏 + 𝑐

2

𝐸𝐵𝑥𝑦

=𝑏+𝑐

𝐷𝑥𝑦 =

𝑎𝑑 −𝑏𝑐

(𝑎+𝑏+𝑐+𝑑)2

𝑏+𝑐

𝐷𝑥𝑦 =

2𝑎+𝑏+𝑐

Sokal y Sneath(5)

Correlación phi

Diferencia de forma

𝑆𝑆𝑆𝑥𝑦 =

𝜙𝑥𝑦 =

𝐷𝐹𝑥𝑦 =

Varianza disimilar

𝑉𝑥𝑦 =

Diferencia de tamaño

𝑇𝑥𝑦 =

Diferencia de patrón

𝑃𝑥𝑦 =

𝑎𝑑

𝑎+𝑏 𝑎+𝑐 𝑏+𝑑 𝑐+𝑑

𝑎𝑑 −𝑏𝑐

𝑎+𝑏 𝑎+𝑐 𝑏+𝑑 𝑐+𝑑

𝑎+𝑏+𝑐+𝑑 𝑏+𝑐 −(𝑏−𝑐)2

𝑎+𝑏+𝑐+𝑑 2

𝑏+𝑐

4 𝑎+𝑏+𝑐+𝑑

(𝑏−𝑐)2

𝑎+𝑏+𝑐+𝑑 2

𝑏𝑐

𝑎+𝑏+𝑐+𝑑 2

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 22

EL ANÁLISIS CLUSTER

TÉCNICAS EN EL ANÁLISIS CLUSTER

EL ANÁLISIS DE CONGLOMERADOS O ANÁLISIS CLUSTER ES UN

CONJUNTO DE MÉTODOS Y TÉCNICAS ESTADÍSTICAS QUE

PERMITEN

DESCRIBIR

Y

RECONOCER

DIFERENTES

AGRUPACIONES QUE SUBYACEN EN UN CONJUNTO DE DATOS:

PERMITEN CLASIFICAR, O DIVIDIR EN GRUPOS MÁS O

MENOS HOMOGÉNEOS, UN CONJUNTO DE INDIVIDUOS QUE

ESTÁN DEFINIDOS POR DIFERENTES VARIABLES.

EL OBJETIVO PRINCIPAL CONSISTE EN CONSEGUIR UNA O MÁS

PARTICIONES DE UN CONJUNTO DE INDIVIDUOS EN BASE A

DETERMINADAS CARACTERÍSTICAS DE LOS MISMOS:

ESTAS CARACTERÍSTICAS ESTARÁN DEFINIDAS POR LAS

PUNTUACIONES QUE CADA UNO DE ELLOS TIENE CON

RELACIÓN A DIFERENTES VARIABLES.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 23

EL ANÁLISIS CLUSTER

TÉCNICAS EN EL ANÁLISIS CLUSTER

SE PODRÁ DECIR QUE DOS INDIVIDUOS SON SIMILARES SI

PERTENECEN A LA MISMA CLASE, GRUPO, CONGLOMERADO O

CLUSTER.

TODOS LOS INDIVIDUOS QUE ESTÁN CONTENIDOS EN EL MISMO

CONGLOMERADO:

SE PARECERÁN ENTRE SÍ.

SERÁN DIFERENTES DE LOS INDIVIDUOS QUE PERTENECEN A

OTRO CONGLOMERADO.

LOS MIEMBROS DE UN CONGLOMERADO GOZARÁN DE

CARACTERÍSTICAS COMUNES QUE LOS DIFERENCIAN DE LOS

MIEMBROS DE OTROS CONGLOMERADOS:

ESTAS CARACTERÍSTICAS DEBERÁN SER GENÉRICAS.

DIFÍCILMENTE UNA ÚNICA CARACTERÍSTICA PODRÁ

DEFINIR UN CONGLOMERADO.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 24

EL ANÁLISIS CLUSTER

TÉCNICAS EN EL ANÁLISIS CLUSTER

EL MÉTODO PARA EJECUTAR UN ANÁLISIS DE CONGLOMERADOS

COMIENZA CON LA SELECCIÓN DE LOS INDIVIDUOS OBJETO DEL

ESTUDIO:

SI CORRESPONDE SE INCLUYE:

SU CODIFICACIÓN A PARTIR DE LAS VARIABLES O

CARACTERES QUE LOS DEFINEN.

SU TRANSFORMACIÓN ADECUADA PARA SOMETERLOS

AL ANÁLISIS SI ES NECESARIO (TIPIFICACIÓN DE

VARIABLES, DESVIACIONES RESPECTO DE LA MEDIA,

ETC.).

SE DETERMINA LA MATRIZ DE DISIMILITUDES DEFINIENDO LAS

DISTANCIAS, SIMILITUDES O DISIMILITUDES DE LOS INDIVIDUOS.

SE EJECUTA EL ALGORITMO QUE FORMARÁ LAS DIFERENTES

AGRUPACIONES O CONGLOMERADOS DE INDIVIDUOS.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 25

EL ANÁLISIS CLUSTER

TÉCNICAS EN EL ANÁLISIS CLUSTER

SE OBTIENE UNA REPRESENTACIÓN GRÁFICA DE LOS

CONGLOMERADOS OBTENIDOS:

DENDOGRAMA.

SE INTERPRETAN LOS RESULTADOS OBTENIDOS.

LOS DIFERENTES MÉTODOS DE ANÁLISIS DE CONGLOMERADOS

SURGEN DE LAS DISTINTAS FORMAS DE AGRUPACIÓN DE LOS

INDIVIDUOS:

DEPENDIENDO DEL ALGORITMO QUE SE UTILICE PARA

LLEVAR A CABO LA AGRUPACIÓN DE INDIVIDUOS, SE

OBTIENEN DIFERENTES MÉTODOS DE ANÁLISIS DE

CONGLOMERADOS.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 26

EL ANÁLISIS CLUSTER

TÉCNICAS EN EL ANÁLISIS CLUSTER

UNA CLASIFICACIÓN ES LA SIGUIENTE:

MÉTODOS AGLOMERATIVOS-DIVISIVOS.

MÉTODOS JERÁRQUICOS-NO JERÁRQUICOS.

MÉTODOS SOLAPADOS-EXCLUSIVOS.

MÉTODOS SECUENCIALES-SIMULTÁNEOS.

MÉTODOS MONOTÉTICOS-POLITÉTICOS.

MÉTODOS DIRECTOS-ITERATIVOS.

MÉTODOS PONDERADOS-NO PONDERADOS.

MÉTODOS ADAPTATIVOS-NO ADAPTATIVOS.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 27

EL ANÁLISIS CLUSTER

TÉCNICAS EN EL ANÁLISIS CLUSTER

MÉTODOS AGLOMERATIVOS-DIVISIVOS:

UN MÉTODO AGLOMERATIVO:

CONSIDERA TANTOS GRUPOS COMO INDIVIDUOS.

SUCESIVAMENTE VA FUSIONANDO LOS DOS GRUPOS

MÁS SIMILARES, HASTA LLEGAR A UNA CLASIFICACIÓN

DETERMINADA.

UN MÉTODO DIVISIVO:

PARTE DE UN SOLO GRUPO FORMADO POR TODOS LOS

INDIVIDUOS.

EN CADA ETAPA VA SEPARANDO INDIVIDUOS DE LOS

GRUPOS ESTABLECIDOS ANTERIORMENTE, FORMÁNDOSE

ASÍ NUEVOS GRUPOS.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 28

EL ANÁLISIS CLUSTER

TÉCNICAS EN EL ANÁLISIS CLUSTER

MÉTODOS JERÁRQUICOS-NO JERÁRQUICOS:

UN MÉTODO ES JERÁRQUICO SI CONSISTE EN UNA

SECUENCIA DE g+1 CLUSTERS: G0,…, Gg EN LA QUE:

G0

ES LA PARTICIÓN DISJUNTA DE TODOS LOS

INDIVIDUOS Y Gg ES EL CONJUNTO PARTICIÓN:

• EL N° DE PARTES DE C/U DE LAS PARTICIONES

DISMINUYE PROGRESIVAMENTE.

• LAS PARTICIONES SON CADA VEZ MÁS AMPLIAS Y

MENOS HOMOGÉNEAS.

UN MÉTODO SE DICE NO JERÁRQUICO CUANDO SE FORMAN

GRUPOS HOMOGÉNEOS SIN ESTABLECER RELACIONES DE

ORDEN O JERÁRQUICAS ENTRE DICHOS GRUPOS.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 29

EL ANÁLISIS CLUSTER

TÉCNICAS EN EL ANÁLISIS CLUSTER

MÉTODOS SOLAPADOS-EXCLUSIVOS:

UN MÉTODO ES SOLAPADO SI ADMITE QUE UN INDIVIDUO

PUEDA PERTENECER A DOS GRUPOS SIMULTÁNEAMENTE EN

ALGUNA DE LAS ETAPAS DE CLASIFICACIÓN.

ES EXCLUSIVO SI NINGÚN INDIVIDUO PUEDE PERTENECER

SIMULTÁNEAMENTE A DOS GRUPOS EN LA MISMA ETAPA.

MÉTODOS SECUENCIALES-SIMULTÁNEOS:

UN MÉTODO ES SECUENCIAL SI A CADA GRUPO SE LE APLICA

EL MISMO ALGORITMO EN FORMA RECURSIVA.

LOS MÉTODOS SIMULTÁNEOS SON AQUELLOS EN LOS QUE

LA CLASIFICACIÓN SE LOGRA POR UNA SIMPLE Y NO

REITERADA OPERACIÓN SOBRE LOS INDIVIDUOS.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 30

EL ANÁLISIS CLUSTER

TÉCNICAS EN EL ANÁLISIS CLUSTER

MÉTODOS MONOTÉTICOS-POLITÉTICOS:

UN MÉTODO SE DICE MONOTÉTICO SI ESTÁ BASADO EN UNA

CARACTERÍSTICA ÚNICA DE LOS OBJETOS A CLASIFICAR.

ES POLITÉTICO SI SE BASA EN VARIAS CARACTERÍSTICAS

DE LOS MISMOS:

SIN EXIGIR QUE TODOS LOS OBJETOS LAS POSEAN.

AUNQUE SÍ DEBEN POSEER LAS SUFICIENTES COMO

PARA PODER JUSTIFICAR LA ANALOGÍA ENTRE LOS

MIEMBROS DE UNA MISMA CLASE.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 31

EL ANÁLISIS CLUSTER

TÉCNICAS EN EL ANÁLISIS CLUSTER

MÉTODOS DIRECTOS-ITERATIVOS:

UN MÉTODO ES DIRECTO SI UTILIZA ALGORITMOS EN LOS

QUE. UNA VEZ ASIGNADO UN INDIVIDUO A UN GRUPO YA

NO SE SACA DEL MISMO

LOS MÉTODOS ITERATIVOS CORRIGEN LAS ASIGNACIONES

PREVIAS:

VUELVEN A COMPROBAR EN POSTERIORES ITERACIONES

SI LA ASIGNACIÓN DE UN INDIVIDUO A UN

CONGLOMERADO ES ÓPTIMA.

LLEVAN A CABO UN NUEVO REAGRUPAMIENTO DE LOS

INDIVIDUOS SI ES NECESARIO.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 32

EL ANÁLISIS CLUSTER

TÉCNICAS EN EL ANÁLISIS CLUSTER

MÉTODOS PONDERADOS-NO PONDERADOS:

LOS MÉTODOS NO PONDERADOS SON AQUELLOS QUE

ESTABLECEN

EL

MISMO

PESO

A

TODAS

LAS

CARACTERÍSTICAS DE LOS INDIVIDUOS A CLASIFICAR.

LOS PONDERADOS HACEN RECAER MAYOR PESO EN

DETERMINADAS CARACTERÍSTICAS.

MÉTODOS ADAPTATIVOS-NO ADAPTATIVOS:

LOS MÉTODOS NO ADAPTATIVOS SON AQUELLOS PARA LOS

QUE EL ALGORITMO UTILIZADO SE DIRIGE HACIA UNA

SOLUCIÓN EN LA QUE EL MÉTODO DE FORMACIÓN DE

CONGLOMERADOS ES FIJO Y ESTÁ PREDETERMINADO.

LOS ADAPTATIVOS (MENOS UTILIZADOS) SON AQUELLOS

QUE DE ALGUNA MANERA APRENDEN DURANTE EL

PROCESO DE FORMACIÓN DE LOS GRUPOS Y MODIFICAN

EL CRITERIO DE OPTIMIZACIÓN O LA MEDIDA DE

SIMILITUD A UTILIZAR.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 33

EL ANÁLISIS CLUSTER

CLUSTERS JERÁRQUICOS, SECUENCIALES, AGLOMERATIVOS Y

EXCLUSIVOS (S.A.H.N.)

LOS MÉTODOS MÁS USADOS SON LOS QUE SON A LA VEZ:

SECUENCIALES.

AGLOMERATIVOS.

JERÁRQUICOS.

EXCLUSIVOS.

RECIBEN EL ACRÓNIMO, EN LENGUA INGLESA, DE S.A.H.N.

(SEQUENTIAL,

AGGLOMERATIVE,

HIERARCHIC

Y

NONOVERLAPING).

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 34

EL ANÁLISIS CLUSTER

CLUSTERS JERÁRQUICOS, SECUENCIALES, AGLOMERATIVOS Y

EXCLUSIVOS (S.A.H.N.)

ALGUNOS MÉTODOS DE TIPO S.A.H.N. SON:

METODO DE UNIÓN SIMPLE (SINGLE LINKAGE CLUSTERING),

ENTORNO O VECINO MÁS CERCANO (NEAREST NEIGHBOUR)

O MÉTODO DEL MÍNIMO (MINIMUM METHOD).

MÉTODO DE LA DISTANCIA MÁXIMA O MÉTODO DEL

MÁXIMO (COMPLETE LINKAGE CLUSTERING, FURTHEST

NEIGHBOUR O MAXIMUM METHOD).

MÉTODO DE LA MEDIA O DE LA DISTANCIA PROMEDIO NO

PONDERADO (WEIGHTED PAIR GROUPS METHOD USING

ARITHMETIC AVERAGES WPGMW).

MÉTODO DE LA MEDIA PONDERADA O DE LA DISTANCIA

PROMEDIO PONDERADO (GROUP AVERAGE O UNWEIGHTED

PAIR GROUPS METHOD USING ARITHMETIC AVERAGES

UPGMA).

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 35

EL ANÁLISIS CLUSTER

CLUSTERS JERÁRQUICOS, SECUENCIALES, AGLOMERATIVOS Y

EXCLUSIVOS (S.A.H.N.)

ALGUNOS MÉTODOS DE TIPO S.A.H.N. SON:

MÉTODO DE LA MEDIANA O DE LA DISTANCIA MEDIANA

(WEIGHTED PAIR GROUP CENTROID METHOD WPGMC).

MÉTODO DEL CENTROIDE O DE LA DISTANCIA PROTOTIPO

(UNWEIGHTED PAIR GROUP CENTROID METHOD UPGMC).

MÉTODO DE WARD O DE MÍNIMA VARIANZA.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 36

EL ANÁLISIS CLUSTER

EL DENDOGRAMA EN EL ANÁLISIS CLUSTER JERÁRQUICO

ES HABITUAL LA NECESIDAD DE CLASIFICAR LOS DATOS EN

GRUPOS

CON

ESTRUCTURA

ARBORESCENTE

DE

DEPENDENCIA, DE ACUERDO CON DIFERENTES NIVELES DE

JERARQUÍA:

SE

PARTE DE TANTOS GRUPOS INICIALES COMO

INDIVIDUOS SE ESTUDIAN.

SE TRATA DE CONSEGUIR AGRUPACIONES SUCESIVAS

ENTRE ELLOS DE FORMA QUE PROGRESIVAMENTE SE VAYAN

INTEGRANDO EN CLUSTERS.

LOS CLUSTERS, A SU VEZ, SE UNIRÁN ENTRE SÍ EN UN

NIVEL SUPERIOR FORMANDO GRUPOS MAYORES QUE MÁS

TARDE SE JUNTARAN HASTA LLEGAR AL CLUSTER FINAL.

EL CLUSTER FINAL CONTIENE TODOS LOS CASOS

ANALIZADOS.

LA REPRESENTACIÓN GRÁFICA DE ESTAS ETAPAS DE

FORMACIÓN DE GRUPOS, A MODO DE ÁRBOL INVERTIDO, SE

DENOMINA DENDOGRAMA.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 37

EL ANÁLISIS CLUSTER

EL DENDOGRAMA EN EL ANÁLISIS CLUSTER JERÁRQUICO

DENDOGRAMA:

Nivel de jerarquía

H

G

F

E

D

C

B

1

2

A

3

4

5 6

7

8

9

10 Indiv.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 38

EL ANÁLISIS CLUSTER

EL DENDOGRAMA EN EL ANÁLISIS CLUSTER JERÁRQUICO

EJEMPLO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 39

EL ANÁLISIS CLUSTER

EL DENDOGRAMA EN EL ANÁLISIS CLUSTER JERÁRQUICO

EJEMPLO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 40

EL ANÁLISIS CLUSTER

EL DENDOGRAMA EN EL ANÁLISIS CLUSTER JERÁRQUICO

EJEMPLO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 41

EL ANÁLISIS CLUSTER

EJEMPLO DE ANÁLISIS CLUSTER JERÁRQUICO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 42

EL ANÁLISIS CLUSTER

EJEMPLO DE ANÁLISIS CLUSTER JERÁRQUICO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 43

EL ANÁLISIS CLUSTER

EJEMPLO DE ANÁLISIS CLUSTER JERÁRQUICO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 44

EL ANÁLISIS CLUSTER

EJEMPLO DE ANÁLISIS CLUSTER JERÁRQUICO

RESULTADOS COMPLETOS

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 45

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

LA CLASIFICACIÓN DE TODOS LOS CASOS DE UNA TABLA DE

DATOS EN GRUPOS SEPARADOS QUE CONFIGURA EL PROPIO

ANÁLISIS PROPORCIONA CLUSTERS NO JERÁRQUICOS:

NO HAY UNA ESTRUCTURA VERTICAL DE DEPENDENCIA

ENTRE LOS GRUPOS FORMADOS.

LOS GRUPOS NO SE PRESENTAN EN DISTINTOS NIVELES

DE JERARQUÍA.

EL ANÁLISIS PRECISA QUE SE FIJE DE ANTEMANO EL N° DE

CLUSTERS EN QUE QUIERE AGRUPAR SUS DATOS.

SI NO EXISTE UN N° DEFINIDO DE GRUPOS O, SI EXISTE PERO NO

SE CONOCE EL N°:

SE DEBE REPETIR LA PRUEBA CON DIFERENTE N° A FIN DE

EVALUAR LA CLASIFICACIÓN:

QUE MEJOR SE AJUSTE AL OBJETIVO DEL PROBLEMA, O.

QUE BRINDE LA MÁS CLARA INTERPRETACIÓN.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 46

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

LOS MÉTODOS NO JERÁRQUICOS TAMBIÉN SE CONOCEN COMO

MÉTODOS PARTITIVOS O DE OPTIMIZACIÓN:

TIENEN POR OBJETIVO REALIZAR UNA SOLA PARTICIÓN DE

LOS INDIVIDUOS EN K GRUPOS:

ESTO IMPLICA QUE SE DEBE ESPECIFICAR A PRIORI LOS

GRUPOS QUE DEBEN SER FORMADOS.

ESTA ES UNA IMPORTANTE DIFERENCIA RESPECTO DE

LOS MÉTODOS JERÁRQUICOS.

LA ASIGNACIÓN DE INDIVIDUOS A LOS GRUPOS SE HACE

MEDIANTE ALGÚN PROCESO QUE OPTIMICE EL

CRITERIO DE SELECCIÓN.

SE TRABAJA CON LA MATRIZ DE DATOS ORIGINAL Y NO SE

REQUIERE SU CONVERSIÓN EN UNA MATRIZ DE PROXIMIDADES.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 47

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

PEDRET AGRUPA LOS MÉTODOS NO JERÁRQUICOS EN LAS

CUATRO FAMILIAS SIGUIENTES:

REASIGNACIÓN.

BÚSQUEDA DE LA DENSIDAD.

DIRECTOS.

REDUCCIÓN DE DIMENSIONES.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 48

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

LOS MÉTODOS DE REASIGNACIÓN PERMITEN QUE UN

INDIVIDUO ASIGNADO A UN GRUPO EN UN DETERMINADO PASO

DEL PROCESO SEA REASIGNADO A OTRO GRUPO EN UN PASO

POSTERIOR SI ESTO OPTIMIZA EL CRITERIO DE SELECCIÓN:

EL PROCESO TERMINA CUANDO NO QUEDAN INDIVIDUOS

CUYA REASIGNACIÓN PERMITA OPTIMIZAR EL RESULTADO

QUE SE HA CONSEGUIDO.

EJEMPLOS DE ALGORITMOS:

MÉTODO K-MEANS (O K-MEDIAS) DE MCQUEEN (1967).

QUICK CLUSTER ANALYSIS.

MÉTODO DE FORGY.

SE SUELEN AGRUPAR COMO MÉTODOS CENTROIDES O

CENTROS DE GRAVEDAD.

MÉTODO DE LAS NUBES DINÁMICAS DE DIDAY.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 49

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

LOS MÉTODOS DE BÚSQUEDA DE LA DENSIDAD PRESENTAN

UNA APROXIMACIÓN TIPOLÓGICA Y UNA APROXIMACIÓN

PROBABILÍSTICA:

EN LA APROXIMACIÓN TIPOLÓGICA LOS GRUPOS SE

FORMAN BUSCANDO LAS ZONAS EN LAS CUALES SE DA UNA

MAYOR CONCENTRACIÓN DE INDIVIDUOS:

LOS ALGORITMOS MÁS CONOCIDOS SON EL ANÁLISIS

MODAL DE WISHART, EL MÉTODO DE TAXMAP DE

CARMICHAEL Y SNEATH, Y EL MÉTODO DE FORTIN.

EN LA APROXIMACIÓN PROBABILÍSTICA SE PARTE DEL

POSTULADO DE QUE LAS VARIABLES SIGUEN UNA LEY DE

PROBABILIDAD SEGÚN LA CUAL LOS PARÁMETROS VARÍAN

DE UN GRUPO A OTRO:

SE

TRATA DE ENCONTRAR LOS INDIVIDUOS QUE

PERTENECEN A LA MISMA DISTRIBUCIÓN.

SE DESTACA EL MÉTODO DE LAS COMBINACIONES DE

WOLF.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 50

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

LOS

MÉTODOS

DIRECTOS

PERMITEN

CLASIFICAR

SIMULTÁNEAMENTE A LOS INDIVIDUOS Y A LAS VARIABLES:

LAS ENTIDADES AGRUPADAS SON LAS OBSERVACIONES, ES

DECIR, LOS CRUCES QUE CONFIGURAN LA MATRIZ DE DATOS.

LOS MÉTODOS DE REDUCCIÓN DE DIMENSIONES, COMO EL

ANÁLISIS FACTORIAL DE TIPO Q, GUARDAN RELACIÓN CON EL

ANÁLISIS CLUSTER:

CONSISTE EN BUSCAR FACTORES EN EL ESPACIO DE LOS

INDIVIDUOS, CORRESPONDIENDO CADA FACTOR A UN GRUPO.

LA

INTERPRETACIÓN DE LOS GRUPOS PUEDE SER

COMPLEJA

DADO

QUE

CADA

INDIVIDUO

PUEDE

CORRESPONDER A VARIOS FACTORES DIFERENTES.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 51

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

SE SUPONE QUE UNA CLASIFICACIÓN CORRECTA DEBE SER

AQUELLA EN QUE LA DISPERSIÓN DENTRO DE CADA GRUPO

FORMADO SEA LA MENOR POSIBLE:

ES EL CRITERIO DE VARIANZA.

LLEVA A SELECCIONAR UNA CONFIGURACIÓN CUANDO LA

SUMA DE LAS VARIANZAS DENTRO DE CADA GRUPO SEA

MÍNIMA:

VARIANZA RESIDUAL MÍNIMA.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 52

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

HAY DIVERSOS ALGORITMOS DE CLASIFICACIÓN NO

JERÁRQUICA:

INTENTAN MINIMIZAR PROGRESIVAMENTE LA VARIANZA.

DIFIEREN EN:

LA ELECCIÓN DE LOS CLUSTERS PROVISIONALES QUE

NECESITA EL ARRANQUE DEL PROCESO.

MÉTODO

DE ASIGNACIÓN DE INDIVIDUOS A LOS

GRUPOS.

LOS MÁS UTILIZADOS SON:

ALGORITMO DE LA H-MEDIAS.

ALGORITMO DE LAS K-MEDIAS.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 53

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

EL ALGORITMO DE LAS H-MEDIAS:

PARTE DE UNA PRIMERA CONFIGURACIÓN ARBITRARIA DE

GRUPOS CON SU CORRESPONDIENTE MEDIA.

SE ELIGE UN PRIMER INDIVIDUO DE ARRANQUE DE CADA

GRUPO.

SE ASIGNA POSTERIORMENTE CADA CASO AL GRUPO CUYA

MEDIA ES MÁS CERCANA.

SE CALCULA DE NUEVO LAS MEDIAS O CENTROIDES Y SE

LAS TOMA EN LUGAR DE LOS PRIMEROS INDIVIDUOS COMO

UNA MEJOR APROXIMACIÓN DE LOS MISMOS.

SE REPITE EL PROCESO MIENTRAS LA VARIANZA RESIDUAL

VAYA DISMINUYENDO.

LA PARTICIÓN DE ARRANQUE DEFINE EL N° CLUSTERS:

PUEDE DISMINUIR SI NINGÚN CASO ES ASIGNADO A

ALGUNO DE ELLOS.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 54

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

EL ALGORITMO DE LAS K-MEDIAS:

ES EL MÁS IMPORTANTE DESDE LOS PUNTOS DE VISTA

CONCEPTUAL Y PRÁCTICO.

PARTE TAMBIÉN DE UNAS MEDIAS ARBITRARIAS.

CONTRASTA EL EFECTO QUE SOBRE LA VARIANZA

RESIDUAL TIENE LA ASIGNACIÓN DE C/U DE LOS CASOS A

C/U DE LOS GRUPOS.

EL VALOR MÍNIMO DE VARIANZA DETERMINA UNA

CONFIGURACIÓN

DE

NUEVOS

GRUPOS

CON

SUS

RESPECTIVAS MEDIAS.

SE ASIGNAN OTRA VEZ TODOS LOS CASOS A ESTOS NUEVOS

CENTROIDES.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 55

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

EL PROCESO QUE SE REPITE:

HASTA

QUE NINGUNA TRANSFERENCIA PUEDE YA

DISMINUIR LA VARIANZA RESIDUAL, O.

SE ALCANCE OTRO CRITERIO DE PARADA:

• UN NÚMERO LIMITADO DE PASOS DE ITERACIÓN.

• QUE LA DIFERENCIA OBTENIDA ENTRE LOS

CENTROIDES DE DOS PASOS CONSECUTIVOS SEA

MENOR QUE UN VALOR PREFIJADO.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 56

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

EL PROCEDIMIENTO CONFIGURA LOS GRUPOS MAXIMIZANDO

LA DISTANCIA ENTRE SUS CENTROS DE GRAVEDAD:

COMO LA VARIANZA TOTAL ES FIJA:

MINIMIZAR LA RESIDUAL HACE MÁXIMA LA FACTORIAL O

INTERGRUPOS.

MINIMIZAR LA VARIANZA RESIDUAL ES EQUIVALENTE A

CONSEGUIR QUE SEA MÍNIMA LA SUMA DE DISTANCIAS AL

CUADRADO DESDE LOS CASOS A LA MEDIA DEL CLUSTER

AL QUE VAN A SER ASIGNADOS.

EL

MÉTODO UTILIZA LA DISTANCIA EUCLÍDEA AL

CUADRADO.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 57

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

PROPORCIONA UNA SOLUCIÓN FINAL ÚNICA PARA EL N° DE

CLUSTERS ELEGIDO:

SE LLEGARÁ CON MENOR NÚMERO DE ITERACIONES

CUANTO MÁS CERCA ESTÉN LAS “MEDIAS” DE ARRANQUE

DE LAS QUE VAN A SER FINALMENTE OBTENIDAS.

SE SELECCIONAN ESTOS PRIMEROS VALORES, TANTOS

COMO GRUPOS SE PRETENDA FORMAR, ENTRE LOS PUNTOS

MÁS SEPARADOS DE LA NUBE.

LOS CLUSTERS NO JERÁRQUICOS ESTÁN INDICADOS PARA:

GRANDES TABLAS DE DATOS.

DETECCIÓN DE CASOS ATÍPICOS:

SI SE ELIGE PREVIAMENTE UN N° ELEVADO DE GRUPOS,

SUPERIOR AL DESEADO, AQUELLOS QUE CONTENGAN

MUY POCOS INDIVIDUOS SERVIRÍAN PARA DETECTAR

CASOS EXTREMOS QUE PODRÍAN DISTORSIONAR LA

CONFIGURACIÓN.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 58

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

UN PROBLEMA IMPORTANTE ES LA ELECCIÓN DE UN N°

ADECUADO DE CLUSTERS.

SE USAN CRITERIOS TANTO MATEMÁTICOS COMO DE

INTERPRETABILIDAD.

ENTRE LOS CRITERIOS MATEMÁTICOS SE HAN DEFINIDO

NUMEROSOS INDICADORES DE ADECUACIÓN:

CRITERIO CÚBICO DE CLUSTERS.

PSEUDO F.

EL USO INTELIGENTE DE LOS CRITERIOS MATEMÁTICOS,

COMBINADO CON LA INTERPRETABILIDAD PRÁCTICA DE LOS

GRUPOS:

CONSTITUYE

EL ARTE DE LA DECISIÓN EN LA

CLASIFICACIÓN MULTIVARIANTE DE DATOS.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 59

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

SE SUPONE QUE N ES EL N° DE SUJETOS A CLASIFICAR

FORMANDO K GRUPOS, RESPECTO A N VARIABLES X1,…, Xn.

SEAN W, B Y T LAS MATRICES DE DISPERSIÓN DENTRO GRUPOS,

ENTRE GRUPOS Y TOTAL RESPECTIVAMENTE:

T = B + W.

T NO DEPENDE DE LA FORMA EN QUE HAN SIDO AGRUPADOS

LOS SUJETOS.

UN CRITERIO RAZONABLE DE CLASIFICACIÓN CONSISTE EN:

CONSTRUIR K GRUPOS.

LOGRAR QUE B SEA MÁXIMA O W SEA MÍNIMA,

SIGUIENDO ALGÚN CRITERIO APROPIADO.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 60

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

ALGUNOS DE ESTOS CRITERIOS APROPIADOS SON:

a) Minimizar la Traza(W)

b) Minimizar Determinante(W)

c) Minimizar Det(W)/Det(T)

d) Maximizar Traza(W-1B)

𝑁𝑖

−1

e) Minimizar 𝐾

𝑋𝑖ℎ − 𝑋𝑖

𝑖=1 ℎ=1 𝑋𝑖ℎ − 𝑋𝑖 ′𝑆𝑖

LOS CRITERIOS a) Y b) SE JUSTIFICAN PORQUE TRATAN DE

MINIMIZAR LA MAGNITUD DE LA MATRIZ W.

EL CRITERIO e) ES LLAMADO CRITERIO DE WILKS Y ES

EQUIVALENTE A b) PORQUE det(T) ES CONSTANTE.

EL CASO d) ES EL LLAMADO CRITERIO DE HOTTELLING.

EL CRITERIO e) REPRESENTA LA SUMA DE LAS DISTANCIAS DE

MAHALANOBIS DE CADA SUJETO AL CENTROIDE DEL GRUPO

AL QUE ES ASIGNADO.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 61

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

COMO EL N° DE FORMAS DE AGRUPAR N SUJETOS EN K GRUPOS

ES DEL ORDEN DE KN*K!, UNA VEZ ELEGIDO EL CRITERIO DE

OPTIMIZACIÓN:

ES NECESARIO SEGUIR ALGÚN ALGORITMO ADECUADO DE

CLASIFICACIÓN PARA EVITAR UN N° TAN ELEVADO DE

AGRUPAMIENTOS.

EL MÉTODO ISODATA, INTRODUCIDO POR BALL Y HALL (1967),

ES UNO DE LOS MÁS CONOCIDOS:

CONSISTE EN PARTIR DE K CLASES (CONSTRUIDAS POR

EJEMPLO ALEATORIAMENTE).

REASIGNAR UN SUJETO DE UNA CLASE i A UNA CLASE j SI SE

MEJORA EL CRITERIO ELEGIDO DE OPTIMIZACIÓN.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 62

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

EJEMPLO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 63

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

EJEMPLO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 64

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

EJEMPLO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 65

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

EJEMPLO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 66

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

EJEMPLO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 67

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

EJEMPLO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 68

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

EJEMPLO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 69

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

EJEMPLO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 70

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

EJEMPLO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 71

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

EJEMPLO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 72

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

EJEMPLO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 73

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

EJEMPLO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 74

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

EJEMPLO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 75

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

EJEMPLO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 76

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

EJEMPLO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 77

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

EJEMPLO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 78

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

EJEMPLO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 79

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

EJEMPLO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 80

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

EJEMPLO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 81

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

EJEMPLO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 82

EL ANÁLISIS CLUSTER

ANÁLISIS CLUSTER NO JERÁRQUICO

EJEMPLO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 83

EL ANÁLISIS CLUSTER

EJEMPLO DE ANÁLISIS CLUSTER NO JERÁRQUICO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 84

EL ANÁLISIS CLUSTER

EJEMPLO DE ANÁLISIS CLUSTER NO JERÁRQUICO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 85

EL ANÁLISIS CLUSTER

EJEMPLO DE ANÁLISIS CLUSTER NO JERÁRQUICO

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 86

EL ANÁLISIS CLUSTER

EJEMPLO DE ANÁLISIS CLUSTER NO JERÁRQUICO

RESULTADOS COMPLETOS

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 87

LOS ÁRBOLES DE DECISIÓN COMO

TÉCNICA PREDICTIVA DE

CLASIFICACIÓN

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 88

LOS ÁRBOLES DE DECISIÓN

LOS ÁRBOLES DE DECISIÓN, TAMBIÉN LLAMADOS ÁRBOLES DE

CLASIFICACIÓN:

PRESENTAN UN ASPECTO SIMILAR A LOS DENDOGRAMAS

DEL ANÁLISIS DE CONGLOMERADOS JERÁRQUICO.

SE

CONSTRUYEN

E

INTERPRETAN

DE

FORMA

COMPLETAMENTE DISTINTA.

SON MÉTODOS:

MUY FLEXIBLES.

PUEDEN MANEJAR:

UN GRAN N° DE VARIABLES.

COMPLICADAS INTERACCIONES ENTRE ELLAS.

LOS

RESULTADOS

RESULTAN

FÁCILMENTE

INTERPRETABLES PARA CUALQUIER PERSONA.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 89

LOS ÁRBOLES DE DECISIÓN

LOS ÁRBOLES DE CLASIFICACIÓN:

SON PARTICIONES SECUENCIALES DEL CONJUNTO DE

DATOS.

SE BUSCA MAXIMIZAR LAS DIFERENCIAS DE LA VARIABLE

DEPENDIENTE O CRITERIO BASE:

CONLLEVAN LA DIVISIÓN DE LAS OBSERVACIONES EN

GRUPOS QUE DIFIEREN RESPECTO A UNA VARIABLE DE

INTERÉS.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 90

LOS ÁRBOLES DE DECISIÓN

ESTOS MÉTODOS DESARROLLAN UN PROCESO DE DIVISIÓN DE

FORMA ARBORESCENTE:

SE DETERMINA LA DIVISIÓN MÁS DISCRIMINANTE DE ENTRE

LOS CRITERIOS SELECCIONADOS:

AQUELLA QUE PERMITE DIFERENCIAR MEJOR A LOS

DISTINTOS GRUPOS DEL CRITERIO BASE:

• SE OBTIENE DE ESTE MODO LA PRIMERA

SEGMENTACIÓN.

SE REALIZAN NUEVAS SEGMENTACIONES DE C/U DE LOS

SEGMENTOS RESULTANTES.

SE SIGUE HASTA QUE EL PROCESO FINALIZA:

CON ALGUNA NORMA ESTADÍSTICA PREESTABLECIDA, O.

INTERRUMPIDO

VOLUNTARIAMENTE EN CUALQUIER

MOMENTO.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 91

LOS ÁRBOLES DE DECISIÓN

EJEMPLO

SE SUPONE QUE SE DESEA CONOCER QUÉ PASAJEROS DEL

TITANIC TUVIERON MÁS PROBABILIDADES DE SOBREVIVIR A SU

HUNDIMIENTO, Y QUÉ CARACTERÍSTICAS ESTUVIERON

ASOCIADAS A LA SUPERVIVENCIA AL NAUFRAGIO.

LA VARIABLE DE INTERÉS (VD) ES EL GRADO DE

SUPERVIVENCIA.

SE PODRÍA ENTONCES DIVIDIR A LOS PASAJEROS EN GRUPOS DE

EDAD, SEXO Y CLASE EN LA QUE VIAJABAN Y OBSERVAR LA

PROPORCIÓN DE SUPERVIVIENTES DE CADA GRUPO.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 92

LOS ÁRBOLES DE DECISIÓN

EJEMPLO

UN

PROCEDIMIENTO

ARBORESCENTE

SELECCIONA

AUTOMÁTICAMENTE LOS GRUPOS HOMOGÉNEOS CON LA

MAYOR DIFERENCIA EN PROPORCIÓN DE SUPERVIVIENTES

ENTRE ELLOS; EN ESTE CASO, EL SEXO (HOMBRES Y MUJERES).

EL SIGUIENTE PASO ES SUBDIVIDIR CADA UNO DE LOS GRUPOS

EN FUNCIÓN DE OTRA CARACTERÍSTICA, RESULTANDO QUE

LOS HOMBRES SON DIVIDIDOS EN ADULTOS Y NIÑOS, MIENTRAS

QUE LAS MUJERES SE DIVIDEN EN GRUPOS BASADOS EN LA

CLASE EN LA QUE VIAJAN EN EL BARCO.

UTILIZAR DIFERENTES PREDICTORES EN CADA NIVEL DEL

PROCESO DE DIVISIÓN SUPONE UNA FORMA SENCILLA Y

ELEGANTE DE MANEJAR INTERACCIONES QUE A MENUDO

COMPLICAN

EN

EXCESO

LOS

MODELOS

LINEALES

TRADICIONALES.

CUANDO SE HA COMPLETADO EL PROCESO DE SUBDIVISIÓN EL

RESULTADO ES UN CONJUNTO DE REGLAS QUE PUEDEN

VISUALIZARSE FÁCILMENTE MEDIANTE UN ÁRBOL.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 93

LOS ÁRBOLES DE DECISIÓN

EJEMPLO

SI UN PASAJERO DEL TITANIC ES HOMBRE Y ES ADULTO,

ENTONCES TIENE UNA PROBABILIDAD DE SOBREVIVIR DEL 20

POR CIENTO.

LA PROPORCIÓN DE SUPERVIVENCIA EN C/U DE LAS

SUBDIVISIONES PUEDE UTILIZARSE CON FINES PREDICTIVOS

PARA VATICINAR EL GRADO DE SUPERVIVENCIA DE LOS

MIEMBROS DE ESE GRUPO.

PASAJEROS

HOMBRES

ADULTOS

20%

MUJERES

NIÑOS

45%

1° y 2° CLASE

93%

3° CLASE Y TRIPUL.

46%

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 94

LOS ÁRBOLES DE DECISIÓN

EJEMPLO 2

ALGORITMO DIVIDE Y VENCERÁS:

1. SE CREA UN NODO RAÍZ CON S:= TODOS LOS EJEMPLOS.

2. SI TODOS LOS ELEMENTOS DE S SON DE LA MISMA

CLASE,

EL

SUBÁRBOL

SE

CIERRA.

SOLUCIÓN

ENCONTRADA.

3. SE ELIGE UNA CONDICIÓN DE PARTICIÓN SIGUIENDO UN

CRITERIO DE PARTICIÓN (SPLIT CRITERION).

4. EL PROBLEMA (Y S) QUEDA SUBDIVIDO EN DOS

SUBÁRBOLES (LOS QUE CUMPLEN LA CONDICIÓN Y LOS

QUE NO) Y SE VUELVE A 2 PARA CADA UNO DE LOS DOS

SUBÁRBOLES.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 95

LOS ÁRBOLES DE DECISIÓN

EJEMPLO 2

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 96

LOS ÁRBOLES DE DECISIÓN

EJEMPLO 3

EJEMPLO CON DATOS DISCRETOS

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 97

LOS ÁRBOLES DE DECISIÓN

EJEMPLO 3

EJEMPLO CON DATOS DISCRETOS

REPRESENTACIÓN LÓGICA:

(OUTLOOK=SUNNY

AND

HUMIDITY=NORMAL)

OR

(OUTLOOK=OVERCAST)

OR

(OUTLOOK=RAIN

AND

WIND=WEAK).

EJ.: LA INSTANCIA (OUTLOOK = SUNNY, TEMPERATURE =

COOL, HUMIDITY = HIGH, WIND = STRONG) ES NO.

MINERÍA

DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 98

LOS ÁRBOLES DE DECISIÓN

CARACTERÍSTICAS DE LOS ÁRBOLES DE DECISIÓN

LAS CARACTERÍSTICAS MÁS IMPORTANTES SON:

LA ESPECIFICACIÓN DE LOS CRITERIOS PARA MINIMIZAR

LOS COSTES.

LA SELECCIÓN DEL MÉTODO DE DIVISIÓN.

LA ELECCIÓN DEL TRAMO DE ÁRBOL ADECUADO O

PROBLEMA DEL SOBREAJUSTE.

EN CUANTO A LA ESPECIFICACIÓN DE LOS CRITERIOS PARA

MINIMIZAR LOS COSTES, EL OBJETIVO ES CLASIFICAR O

PREDECIR CON EL MÍNIMO COSTE.

GENERALMENTE LOS COSTES HACEN REFERENCIA A LA

PROPORCIÓN DE CASOS MAL CLASIFICADOS.

PUEDEN INFLUIR TAMBIÉN EN LOS COSTES FINALES DE UNA

CLASIFICACIÓN:

LAS PROBABILIDADES A PRIORI.

LOS COSTES DE UNA CLASIFICACIÓN ERRÓNEA.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 99

LOS ÁRBOLES DE DECISIÓN

CARACTERÍSTICAS DE LOS ÁRBOLES DE DECISIÓN

LAS PROBABILIDADES A PRIORI O PONDERACIONES DE CLASE:

ESPECIFICAN LA PROBABILIDAD, SIN TENER NINGÚN

CONOCIMIENTO PREVIO DE LOS VALORES DE LOS

PREDICTORES, DE QUE UN CASO CAIGA EN C/U DE LAS

CLASES DE LA VARIABLE DEPENDIENTE.

EJ.: EN UN ESTUDIO EDUCACIONAL, SE OBSERVA QUE EN

GENERAL EN SECUNDARIA EXISTEN MUCHOS MENOS

ABANDONOS ESCOLARES QUE CHICOS QUE SIGUEN

ESTUDIANDO:

LA PROBABILIDAD A PRIORI DE QUE UN ESTUDIANTE

ABANDONE LA ESCUELA ES MENOR QUE LA

PROBABILIDAD DE QUE PERMANEZCA EN ELLA.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 100

LOS ÁRBOLES DE DECISIÓN

CARACTERÍSTICAS DE LOS ÁRBOLES DE DECISIÓN

LAS PROBABILIDADES A PRIORI CONSTITUYEN ELEMENTOS

CENTRALES DE CUALQUIER ÁRBOL DE DECISIÓN.

ES POSIBLE UTILIZAR PONDERACIONES ESTIMADAS SEGÚN LAS

PROPORCIONES DE CADA CLASE.

OTRA POSIBILIDAD ES ESPECIFICAR PROBABILIDADES IGUALES

PARA CADA CLASE, TRATANDO A TODAS ELLAS COMO SI FUESEN

DEL MISMO TAMAÑO.

OTRO FACTOR QUE INFLUYE EN EL COSTE DE UNA

CLASIFICACIÓN SON LOS COSTES DE UNA CLASIFICACIÓN

ERRÓNEA.

LA MAYOR PARTE DE LOS ÁRBOLES DE DECISIÓN PERMITEN

ESPECIFICAR

TAMBIÉN

COSTES

VARIABLES

DE

UNA

CLASIFICACIÓN ERRÓNEA.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 101

LOS ÁRBOLES DE DECISIÓN

CARACTERÍSTICAS DE LOS ÁRBOLES DE DECISIÓN

EJ. DE COSTE VARIABLE:

QUE PARA UN BANCO SEA 10 VECES MÁS COSTOSO NO SER

CAPAZ DE DETECTAR UNA TRANSACCIÓN FRAUDULENTA

QUE DETENER UNA TRANSACCIÓN LEGAL.

QUE SEA 200 VECES MÁS COSTOSO PARA UN HOSPITAL NO

DETECTAR UNA ENFERMEDAD CONTAGIOSA EN UN PACIENTE

QUE DIAGNOSTICAR COMO CONTAGIOSA UNA ENFERMEDAD

QUE NO LO ES.

NORMALMENTE ESTOS COSTES SE COMPUTAN CUANDO EL

ÁRBOL YA HA SIDO DESARROLLADO COMPLETAMENTE:

NO TIENEN IMPACTO SOBRE SU ESTRUCTURA BÁSICA.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 102

LOS ÁRBOLES DE DECISIÓN

CARACTERÍSTICAS DE LOS ÁRBOLES DE DECISIÓN

REGLA GENERAL: CONVIENE TENER EN CUENTA QUE

MINIMIZAR LOS COSTES SE CORRESPONDE CON MINIMIZAR LA

PROPORCIÓN DE CASOS MAL CLASIFICADOS ÚNICAMENTE

CUANDO:

LAS PROBABILIDADES A PRIORI SE ESTIMAN DE FORMA

PROPORCIONAL AL TAMAÑO DE CADA CLASE.

LOS COSTES DE UNA CLASIFICACIÓN ERRÓNEA SON IGUALES

EN CADA CLASE.

LA SELECCIÓN DEL MÉTODO DE DIVISIÓN TRATA DE ESCOGER

EL MÉTODO CON EL QUE SELECCIONAR, EN C/U DE LOS NIVELES

DEL PROCESO DE DIVISIÓN, LA MEJOR DIVISIÓN POSIBLE DEL

MEJOR PREDICTOR.

LOS ENFOQUES PREDOMINANTES SON:

MÉTODOS EXHAUSTIVOS.

MÉTODOS DE TIPO DISCRIMINANTE.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 103

LOS ÁRBOLES DE DECISIÓN

CARACTERÍSTICAS DE LOS ÁRBOLES DE DECISIÓN

MÉTODOS

EXHAUSTIVOS:

EL

MÁS

CONOCIDO

Y

CONCEPTUALMENTE MÁS SIMPLE CONSISTE EN:

EXAMINAR TODAS LAS POSIBLES DIVISIONES DE LOS DATOS

SEGÚN CADA PREDICTOR.

SELECCIONAR LA DIVISIÓN QUE PRODUCE CLASIFICACIONES

MÁS PURAS (OBSERVANDO LA MEJORÍA EN LA BONDAD DE

AJUSTE).

LA BONDAD DE AJUSTE SE DETERMINA MEDIANTE:

UNA SERIE DE MEDIDAS:

GINI, ENTROPÍA, CHI-CUADRADO, TWOING, SYMGINI,

TWOING

ORDENADO,

DESVIACIÓN

DE

MÍNIMOS

CUADRADOS, COMBINACIONES LINEALES.

CADA MEDIDA UTILIZAN ESTRATEGIAS MUY DIFERENTES Y

DESARROLLA

ÁRBOLES

DE

CLASIFICACIÓN

SUSTANCIALMENTE DISTINTOS.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 104

LOS ÁRBOLES DE DECISIÓN

CARACTERÍSTICAS DE LOS ÁRBOLES DE DECISIÓN

NO EXISTE UNA MEDIDA UNIVERSALMENTE PREFERIBLE PARA

CUALQUIER PROBLEMA:

RESULTA CONVENIENTE DISPONER DE UNA AMPLIA GAMA

DE COEFICIENTES PARA PODER SELECCIONAR EL QUE

MEJOR SE ADAPTA A CADA PROBLEMA CONCRETO.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 105

LOS ÁRBOLES DE DECISIÓN

CARACTERÍSTICAS DE LOS ÁRBOLES DE DECISIÓN

PRINCIPALES PROBLEMAS DE LOS MÉTODOS EXHAUSTIVOS

SON:

SU COMPLEJIDAD COMPUTACIONAL (CUANDO HAY UN

GRAN N° DE PREDICTORES CON MUCHOS NIVELES C/U, EL N°

TOTAL DE DIVISIONES POSIBLES QUE DEBEN SER

EXAMINADAS POR EL PROGRAMA LLEGA A SER ENORME).

EL SESGO PARA SELECCIONAR VARIABLES, YA QUE ESTOS

MÉTODOS TIENDEN A SELECCIONAR PRIMERO LOS

PREDICTORES CON MÁS CATEGORÍAS.

LOS

MÉTODOS DE TIPO DISCRIMINANTE LOGRAN

RESOLVER AMBOS PROBLEMAS.

MÉTODOS DE TIPO DISCRIMINANTE: ESTE TIPO DE MÉTODOS

SIGUEN UN PROCESO DIFERENTE, COMPUTACIONALMENTE MÁS

SENCILLO.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 106

LOS ÁRBOLES DE DECISIÓN

CARACTERÍSTICAS DE LOS ÁRBOLES DE DECISIÓN

EN CADA NODO:

CALCULAN PRIMERO:

UN

TEST CHI-CUADRADO: PARA CADA PREDICTOR

CATEGÓRICO.

UN ANOVA: PARA CADA PREDICTOR MÉTRICO.

SELECCIONAN

DE ENTRE TODAS LAS VARIABLES

SIGNIFICATIVAS, LA QUE PROPORCIONA PROBABILIDADES

ASOCIADAS MENORES.

SE APLICA UN ANÁLISIS DISCRIMINANTE SOBRE EL

PREDICTOR CON EL FIN DE ENCONTRAR LA MEJOR DIVISIÓN

POSIBLE DE LA VARIABLE.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 107

LOS ÁRBOLES DE DECISIÓN

CARACTERÍSTICAS DE LOS ÁRBOLES DE DECISIÓN

EN CUANTO A LA ELECCIÓN DEL TAMAÑO ADECUADO O

PROBLEMA DEL SOBREAJUSTE, UNA CARACTERÍSTICA DE LOS

ÁRBOLES DE CLASIFICACIÓN ES QUE:

SI NO SE ESTABLECE NINGÚN LÍMITE EN EL N° DE

DIVISIONES A EJECUTAR, SE CONSIGUE SIEMPRE UNA

CLASIFICACIÓN PURA, EN LA QUE CADA NODO CONTIENE

ÚNICAMENTE UNA SOLA CLASE DE OBJETOS.

LAS

CLASIFICACIONES

PURAS

PRESENTAN

VARIOS

INCONVENIENTES PORQUE SUELEN SER POCO REALISTAS.

SE CORRE EL RIESGO DE ENCONTRARNOS CON MUY POCOS

ELEMENTOS EN CADA CLASE.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 108

LOS ÁRBOLES DE DECISIÓN

CARACTERÍSTICAS DE LOS ÁRBOLES DE DECISIÓN

ESTA FALTA DE GENERALIZACIÓN, DE REPLICACIÓN A OTRAS

MUESTRAS,

SE

CONOCE

COMO

SOBREAJUSTE

(O

SOBREAPRENDIZAJE EN EL MARCO DE LAS REDES

NEURONALES):

PARA SOLUCIONARLO SE HAN PLANTEADO NUMEROSAS

ESTRATEGIAS

DIFERENTES

Y

EN

OCASIONES

COMPLEMENTARIAS.

LAS PRINCIPALES SON:

LAS REGLAS DE PARADA.

LA PODA.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 109

LOS ÁRBOLES DE DECISIÓN

CARACTERÍSTICAS DE LOS ÁRBOLES DE DECISIÓN

REGLAS DE PARADA:

UNA PRIMERA ESTRATEGIA CONSISTE EN DETENER LA

GENERACIÓN DE NUEVAS DIVISIONES CUANDO ESTAS

SUPONGAN UNA MEJORA MUY PEQUEÑA DE LA PREDICCIÓN.

EJEMPLO:

SI CON DIEZ DIVISIONES SE CLASIFICAN CORRECTAMENTE AL

90 POR CIENTO DE LOS SUJETOS Y CON 11 DIVISIONES EL

PORCENTAJE SUBE AL 90,1 POR CIENTO, NO TIENE MUCHO

SENTIDO AÑADIR MÁS AL ÁRBOL.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 110

LOS ÁRBOLES DE DECISIÓN

CARACTERÍSTICAS DE LOS ÁRBOLES DE DECISIÓN

HAY MUCHAS REGLAS DE PARADA DIRECTA PARA DETENER LA

CONSTRUCCIÓN DEL ÁRBOL.

LAS PRINCIPALES SON LAS SIGUIENTES:

EXTENSIÓN MÁXIMA DEL ÁRBOL, ES DECIR, N° DE NIVELES

MÁXIMOS PERMITIDOS POR DEBAJO DEL NODO RAÍZ.

MÍNIMO N° DE CASOS EN UN NODO, ESPECIFICA QUE LOS

NODOS NO SOBREPASEN UN NÚMERO DETERMINADO DE

CASOS.

MÍNIMA FRACCIÓN DE OBJETOS, QUE CONSISTE EN QUE LOS

NODOS NO CONTENGAN MÁS CASOS QUE UNA FRACCIÓN

DETERMINADA DEL TAMAÑO DE UNA O MÁS CLASES.

LA REGLA DE PARADA LA ESTABLECE A PRIORI EL PROPIO

INVESTIGADOR, EN FUNCIÓN DE INVESTIGACIONES PASADAS,

ANÁLISIS PREVIOS, O INCLUSO EN FUNCIÓN DE SU PROPIA

EXPERIENCIA E INTUICIÓN.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 111

LOS ÁRBOLES DE DECISIÓN

CARACTERÍSTICAS DE LOS ÁRBOLES DE DECISIÓN

PARA DETERMINAR SI EL TAMAÑO DE NUESTRO ÁRBOL ES EL

ADECUADO SE DEBE

EVALUAR, UNA VEZ DETENIDO EL

PROCESO DE DIVISIÓN, SU CALIDAD PREDICTIVA EN MUESTRAS

DISTINTAS A LAS UTILIZADAS PARA SU CÁLCULO.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 112

LOS ÁRBOLES DE DECISIÓN

CARACTERÍSTICAS DE LOS ÁRBOLES DE DECISIÓN

LAS PRINCIPALES FORMAS DE VALIDACIÓN CRUZADA DE LA

CALIDAD PREDICTIVA DE UN ÁRBOL SON:

VALIDACIÓN CRUZADA EN DOS MITADES:

CONSISTE EN DIVIDIR LOS DATOS DISPONIBLES EN DOS

PARTES, LA MUESTRA DE ESTIMACIÓN Y LA MUESTRA

DE VALIDACIÓN.

DESARROLLAR UN ÁRBOL A PARTIR DE LA MUESTRA DE

ESTIMACIÓN.

UTILIZARLO PARA PREDECIR LA CLASIFICACIÓN DE LA

MUESTRA DE VALIDACIÓN.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 113

LOS ÁRBOLES DE DECISIÓN

CARACTERÍSTICAS DE LOS ÁRBOLES DE DECISIÓN

VALIDACIÓN CRUZADA EN v PARTES:

DE

LA

MUESTRA

DISPONIBLE

SE

EXTRAE

ALEATORIAMENTE v SUBMUESTRAS.

SE CALCULAN v ÁRBOLES DE CLASIFICACIÓN, CADA VEZ

DEJANDO FUERA UNA DE LAS v SUBMUESTRAS PARA

VALIDAR EL ANÁLISIS.

CADA SUBMUESTRA SE UTILIZA v - 1 VECES PARA

OBTENER EL ÁRBOL Y UNA SOLA VEZ PARA VALIDARLO:

• OPCIÓN

SUMAMENTE

ÚTIL

CON

MUESTRAS

PEQUEÑAS.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 114

LOS ÁRBOLES DE DECISIÓN

CARACTERÍSTICAS DE LOS ÁRBOLES DE DECISIÓN

VALIDACIÓN CRUZADA GLOBAL:

SE

REPLICA EL ANÁLISIS COMPLETO UN N°

DETERMINADO DE VECES.

SE APARTA UNA FRACCIÓN DE LOS CASOS (CASOS

HOLDOUT) PARA VALIDAR EL ÁRBOL SELECCIONADO.

RESULTA ESPECIALMENTE ÚTIL EN COMBINACIÓN CON

LAS TÉCNICAS AUTOMÁTICAS DE SELECCIÓN DE

ARBOLES:

• ENLAZA CON LA SEGUNDA DE LAS ESTRATEGIAS

PARA EVITAR EL SOBREAJUSTE: LA PODA.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 115

LOS ÁRBOLES DE DECISIÓN

CARACTERÍSTICAS DE LOS ÁRBOLES DE DECISIÓN

PODA

BREIMAN, FRIEDMAN, LOSEN Y STONE (1984) LLEGARON A LA

CONCLUSIÓN DE QUE RESULTA IMPOSIBLE ESPECIFICAR UNA

REGLA QUE SEA TOTALMENTE FIABLE.

EXISTE SIEMPRE EL RIESGO DE NO DESCUBRIR ESTRUCTURAS

RELEVANTES EN LOS DATOS DEBIDO A UNA FINALIZACIÓN

PREMATURA DEL ANÁLISIS.

SUGIEREN UN ENFOQUE ALTERNATIVO EN DOS FASES:

PRIMERA FASE: SE DESARROLLA UN ENORME ÁRBOL QUE

CONTENGA CIENTOS O INCLUSO MILES DE NODOS.

SEGUNDA FASE: EL ÁRBOL ES PODADO, ELIMINÁNDOSE LAS

RAMAS INNECESARIAS HASTA DAR CON EL TAMAÑO

ADECUADO DEL ÁRBOL.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 116

LOS ÁRBOLES DE DECISIÓN

CARACTERÍSTICAS DE LOS ÁRBOLES DE DECISIÓN

PODA

PARA CALCULAR LOS COSTES DE VALIDACIÓN SE UTILIZA UNA

FUNCIÓN QUE PENALIZA LA PROGRESIVA COMPLEJIDAD DEL

ÁRBOL A MEDIDA QUE ÉSTE VA TENIENDO MÁS RAMAS.

ESTA FUNCIÓN ENTRA EN FUNCIONAMIENTO CUANDO SE

ALCANZA UN VALOR CRÍTICO QUE SOBREPASA LOS COSTES

DEL PROCESO DE DIVISIÓN (CADA VEZ MENORES).

EN ESE MOMENTO, LOS COSTES DEJAN DE DESCENDER Y

COMIENZAN A ASCENDER LIGERAMENTE, Y ES ALREDEDOR DE

ESE PUNTO DE INFLEXIÓN DONDE SE LOCALIZA EL TAMAÑO

IDÓNEO DEL ÁRBOL.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 117

LOS ÁRBOLES DE DECISIÓN

CARACTERÍSTICAS DE LOS ÁRBOLES DE DECISIÓN

PODA

COMO ES COMÚN QUE EXISTAN VARIOS ÁRBOLES CON COSTES

VC (VALIDACIÓN CRUZADA) CERCA DEL MÍNIMO, SE PUEDE

UTILIZAR LA REGLA 1ET:

SELECCIONAR EL ÁRBOL DE MENOR COMPLEJIDAD DE

ENTRE TODOS LOS ÁRBOLES QUE NO SUPEREN EL MÍNIMO

COSTE VC MÁS 1 MEDIDA DE SU ERROR TÍPICO.

OTROS MÉTODOS DE PODA SON:

DESVIANZA-COMPLEJIDAD, ERROR REDUCIDO Y PODA

PESIMISTA.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 118

LOS ÁRBOLES DE DECISIÓN

HERRAMIENTAS PARA EL TRABAJO CON ÁRBOLES DE

DECISIÓN

UNA CLASIFICACIÓN DE LOS PRINCIPALES PROGRAMAS DE

ÁRBOLES DE CLASIFICACIÓN PODRÍA SER LA SIGUIENTE:

FAMILIA CART:

CART, TREE(S), ETC.

SU PROPÓSITO INICIAL ES LA PREDICCIÓN ESTADÍSTICA.

REALIZA ÚNICAMENTE DIVISIONES BINARIAS.

RECURRE A LA VALIDACIÓN CRUZADA Y A LA PODA PARA

DETERMINAR EL TAMAÑO CORRECTO DEL ÁRBOL.

LA VARIABLE DEPENDIENTE PUEDE SER CUANTITATIVA O

NOMINAL.

LAS VARIABLES PREDICTORAS PUEDEN SER NOMINALES U

ORDINALES, AUNQUE LAS ÚLTIMAS VERSIONES TAMBIÉN

ADMITEN VARIABLES CONTINUAS.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 119

LOS ÁRBOLES DE DECISIÓN

HERRAMIENTAS PARA EL TRABAJO CON ÁRBOLES DE

DECISIÓN

FAMILIA CLS:

CLS, ID3, C4.5, C5.0, ETC.

SU

PROPÓSITO INICIAL ES DETECTAR RELACIONES

ESTADÍSTICAS COMPLEJAS.

EL N° DE RAMAS QUE PUEDE ORIGINAR VARÍA ENTRE DOS Y

EL N° DE CATEGORÍAS DEL PREDICTOR.

PARA DETERMINAR EL TAMAÑO DEL ÁRBOL UTILIZA TESTS

DE SIGNIFICACIÓN ESTADÍSTICA (CON AJUSTES DE

MULTIPLICIDAD EN LAS ÚLTIMAS VERSIONES).

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 120

LOS ÁRBOLES DE DECISIÓN

HERRAMIENTAS PARA EL TRABAJO CON ÁRBOLES DE

DECISIÓN

MÉTODOS DE TIPO DISCRIMINANTE:

FACT Y QUEST.

SU PROPÓSITO INICIAL ES SOLUCIONAR PROBLEMAS DE LOS

MÉTODOS EXHAUSTIVOS.

EN CONCRETO, TRATAN DE ELIMINAR EL DENOMINADO

SESGO DE SELECCIÓN DE LA VARIABLE, QUE PRESENTAN

MÉTODOS COMO CART Y QUE CONSISTE EN LA TENDENCIA A

SELECCIONAR EN PRIMER LUGAR LAS VARIABLES CON MÁS

CATEGORÍAS.

FACT

ELIMINA ESTE SESGO SÓLO CUANDO UTILIZA

VARIABLES DEPENDIENTES ORDINALES.

QUEST LOGRA ELIMINAR ESTE SESGO, SEA LA VD NOMINAL U

ORDINAL.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 121

LOS ÁRBOLES DE DECISIÓN

HERRAMIENTAS PARA EL TRABAJO CON ÁRBOLES DE

DECISIÓN

COMBINACIONES LINEALES:

OC1, ÁRBOLES SE, ETC.

SU PROPÓSITO INICIAL ES DETECTAR RELACIONES LINEALES

COMBINADAS CON EL APRENDIZAJE DE CONCEPTOS.

EL NÚMERO DE RAMAS VARÍA ENTRE DOS Y EL NÚMERO DE

CATEGORÍAS DEL PREDICTOR.

MODELOS HÍBRIDOS:

IND, KNOWLEDGE SEEKER, ETC.

SU PROPÓSITO INICIAL ES COMBINAR MÉTODOS DE OTRAS

FAMILIAS.

IND COMBINA EL CART Y C4.5, ASÍ COMO MÉTODOS

BAYESIANOS Y DE CODIFICACIÓN MÍNIMA.

KNOWLEDGE SEEKER COMBINA CHAID Y EL ID3 CON UN

NOVEDOSO AJUSTE DE MULTIPLICIDAD.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 122

LOS ÁRBOLES DE DECISIÓN

HERRAMIENTAS PARA EL TRABAJO CON ÁRBOLES DE

DECISIÓN

LOS PROCEDIMIENTOS ARBORESCENTES MÁS ACEPTADOS

TANTO EN LOS ÁMBITOS TEÓRICO COMO APLICADO SON:

ÁRBOLES CHAID (KASS).

ÁRBOLES CART (BREIMAN).

ÁRBOLES QUEST (LOH Y SHIH).

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 123

LOS ÁRBOLES DE DECISIÓN

ÁRBOLES CHAID

CHAID O CHI-SQUARE AUTOMATIC INTERACTION DETECTOR:

ES UN MÉTODO EXPLORATORIO DE ANÁLISIS DE DATOS.

ES ÚTIL PARA IDENTIFICAR VARIABLES IMPORTANTES Y

SUS INTERACCIONES CON FINES DE SEGMENTACIÓN,

ANÁLISIS DESCRIPTIVOS O COMO PASO PREVIO A OTROS

ANÁLISIS POSTERIORES.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 124

LOS ÁRBOLES DE DECISIÓN

ÁRBOLES CHAID

LA MEDIDA DEPENDIENTE PUEDE SER CUALITATIVA

(NOMINAL U ORDINAL) O CUANTITATIVA:

PARA VARIABLES CUALITATIVAS:

EL ANÁLISIS LLEVA A CABO UNA SERIE DE ANÁLISIS CHI

CUADRADO ENTRE LAS VARIABLES DEPENDIENTES Y

PREDICTORAS.

PARA VARIABLES DEPENDIENTES CUANTITATIVAS:

SE RECURRE A MÉTODOS DE ANÁLISIS DE VARIANZA.

LOS

INTERVALOS (DIVISIONES)

SE DETERMINAN

ÓPTIMAMENTE PARA LAS VARIABLES INDEPENDIENTES

DE FORMA QUE MAXIMICEN LA CAPACIDAD PARA

EXPLICAR LA VARIANZA DE LA MEDIDA DEPENDIENTE.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 125

LOS ÁRBOLES DE DECISIÓN

ÁRBOLES CHAID

PERMITE TRABAJAR TANTO CON VARIABLES DEPENDIENTES

CATEGÓRICAS COMO MÉTRICAS.

LAS VARIABLES CATEGÓRICAS UTILIZAN EL ESTADÍSTICO CHICUADRADO Y DAN LUGAR A UN ÁRBOL DE CLASIFICACIÓN.

LAS VARIABLES MÉTRICAS UTILIZAN EL ESTADÍSTICO F Y DAN

LUGAR A LOS ÁRBOLES DE REGRESIÓN.

TAMBIÉN PERMITE UTILIZAR PREDICTORES DE TIPO MÉTRICO,

MEDIANTE

SU

CONVERSIÓN

PREVIA

EN

VARIABLES

CATEGÓRICAS.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 126

LOS ÁRBOLES DE DECISIÓN

ÁRBOLES CART

CART (CLASSIFICATION AND REGRESSION TREES) O C&RT:

CONSTITUYEN UNA ALTERNATIVA AL CHAID EXHAUSTIVO

PARA DESARROLLAR ÁRBOLES DE CLASIFICACIÓN.

FUE DESARROLLADO PARA INTENTAR SUPERAR ALGUNAS DE

LAS DEFICIENCIAS Y DEBILIDADES DEL CHAID ORIGINAL.

EXISTÍA LA NECESIDAD DE UN MÉTODO QUE PERMITIESE

UTILIZAR CRITERIOS Y PREDICTORES DE CUALQUIER NIVEL

DE MEDIDA.

CART SE FORTALECIÓ CON TODA UNA ESTRUCTURA

ESTADÍSTICA DE VALIDACIÓN CRUZADA Y FUE ADOPTADO EN

ENTORNOS MÉDICOS Y DE INVESTIGACIÓN.

RESULTA APROPIADO PARA ÁRBOLES DE CLASIFICACIÓN (VD

CUALITATIVA) O DE REGRESIÓN (VD CUANTITATIVA).

GENERA ÁRBOLES BINARIOS.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 127

LOS ÁRBOLES DE DECISIÓN

ÁRBOLES CART

SE CONSTRUYE DIVIDIENDO LA MUESTRA EN SUBCONJUNTOS

DE DATOS.

EN CADA DIVISIÓN SE EVALÚA CADA PREDICTOR PARA

ENCONTRAR EL MEJOR PUNTO DE CORTE (CON PREDICTORES

CUANTITATIVOS) O LAS MEJORES AGRUPACIONES DE

CATEGORÍAS (CON PREDICTORES CATEGÓRICOS).

SE

COMPARAN

TAMBIÉN

LOS

PREDICTORES,

SELECCIONÁNDOSE EL PREDICTOR Y LA DIVISIÓN QUE PRODUCE

LA MAYOR BONDAD DE AJUSTE.

COMO REGLA DE DIVISIÓN SE UTILIZAN MEDIDAS DE BONDAD

O DE IMPUREZA DE NODOS:

PARA VARIABLES CUANTITATIVAS, LA REDUCCIÓN DEL

ERROR CUADRÁTICO O LA DESVIACIÓN MEDIA ABSOLUTA

DE LA MEDIANA.

CON VARIABLES CUALITATIVAS, EL COEFICIENTE GINI, LA

MEDIDA CHI-CUADRADO DE BARTLETT, LA MEDIDA GCUADRADO, EL COEFICIENTE TWOING.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 128

LOS ÁRBOLES DE DECISIÓN

ÁRBOLES QUEST

QUEST PROVIENE DE QUICK, UNBIASED, EFFICIENT,

STATISTICAL TREE (LOH Y SHIH).

SE TRATA DE UN ALGORITMO CREADO ESPECÍFICAMENTE PARA

RESOLVER DOS DE LOS PRINCIPALES PROBLEMAS DE CART Y

CHAID EXHAUSTIVO A LA HORA DE DIVIDIR UN GRUPO DE

SUJETOS EN FUNCIÓN DE UNA VARIABLE INDEPENDIENTE:

LA COMPLEJIDAD COMPUTACIONAL.

LOS SESGOS EN LA SELECCIÓN DE VARIABLES.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 129

LOS ÁRBOLES DE DECISIÓN

ÁRBOLES QUEST

EL ALGORITMO DE CÁLCULO RESULTA MUCHO MÁS SENCILLO

QUE LOS MÉTODOS EXHAUSTIVOS:

EN VEZ DE INTENTAR SELECCIONAR A LA VEZ EL MEJOR

PREDICTOR Y SU MEJOR PUNTO DE CORTE, QUEST ABORDA

ESTOS DOS PROBLEMAS POR SEPARADO.

EN CADA NODO:

SE CALCULA LA ASOCIACIÓN ENTRE CADA PREDICTOR Y

LA VD (VARIABLE DEPENDIENTE) MEDIANTE:

• EL ESTADÍSTICO F DEL ANOVA O LA F DE LEVENE

(EN EL CASO DE PREDICTORES CONTINUOS Y

ORDINALES), O.

• MEDIANTE UNA CHI-CUADRADO DE PEARSON (EN EL

CASO DE PREDICTORES NOMINALES).

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 130

LOS ÁRBOLES DE DECISIÓN

ÁRBOLES QUEST

UNA

COMPARACIÓN

DE

LOS

PRINCIPALES

MÉTODOS

ARBORESCENTES (SONG Y YOON) HA DEMOSTRADO QUE QUEST

ES EL ÚNICO MÉTODO QUE NO MUESTRA SESGOS SERIOS A LA

HORA DE SELECCIONAR UNA VARIABLE U OTRA.

CHAID PRESENTA UN SUAVE SESGO.

CART ESTÁ CLARAMENTE SESGADO HACIA PREDICTORES

CONTINUOS Y/O CON MUCHAS CATEGORÍAS.

EN LÍNEAS GENERALES, QUEST PARECE SER SUPERIOR A CART

Y ESTE, A SU VEZ, SUPERIOR A CHAID:

LOS RESULTADOS DEPENDEN EN GRAN MEDIDA DEL TIPO

DE PROBLEMA CONCRETO QUE SE ESTÉ ABORDANDO.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 131

ANÁLISIS DE CONGLOMERADOS Y

ÁRBOLES DE DECISIÓN COMO

MÉTODOS DE SEGMENTACIÓN

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 132

ANÁLISIS DE CONGLOMERADOS Y

ÁRBOLES DE DECISIÓN

EL ANÁLISIS DE CONGLOMERADOS O ANÁLISIS CLUSTER,

CONSTITUYE UNO DE LOS PROCEDIMIENTOS ESTADÍSTICOS MÁS

UTILIZADOS HOY EN DÍA PARA LA SEGMENTACIÓN.

LA DEFINICIÓN DE LA TÉCNICA SE ASEMEJA A LOS FINES

GENÉRICOS QUE PERSIGUE LA SEGMENTACIÓN:

IDENTIFICAR GRUPOS DE SUJETOS LO MÁS HETEROGÉNEOS

POSIBLE ENTRE SÍ Y LO MÁS HOMOGÉNEOS POSIBLE DENTRO

DE CADA GRUPO.

SE ESTABLECEN DICHOS GRUPOS BASÁNDOSE EN LA SIMILITUD

QUE PRESENTAN UN CONJUNTO DE ENTIDADES (POR EJEMPLO,

TURISTAS) RESPECTO A UNA SERIE DE CARACTERÍSTICAS QUE

EL INVESTIGADOR HA DE ESPECIFICAR PREVIAMENTE

(MOTIVACIONES, NECESIDADES, BENEFICIOS BUSCADOS, ETC.).

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 133

ANÁLISIS DE CONGLOMERADOS Y

ÁRBOLES DE DECISIÓN

ES EL ANÁLISIS, Y NO EL ANALISTA, EL QUE FINALMENTE

EXTRAE LOS GRUPOS DE SUJETOS Y SUS CARACTERÍSTICAS

DEFINITORIAS:

NÚMERO DE SEGMENTOS, NÚMERO DE INTEGRANTES DE

CADA SEGMENTO, ETC.

EL ANÁLISIS DE CONGLOMERADOS CONSTITUYE EL EJEMPLO

PARADIGMÁTICO DEL ENFOQUE DE SEGMENTACIÓN POST HOC.

SE TRATA DE UN MÉTODO DESCRIPTIVO DE SEGMENTACIÓN.

POR OTRA LADO, LOS ÁRBOLES DE DECISIÓN CONSTITUYEN

MÉTODOS PREDICTIVOS DE SEGMENTACIÓN Y SON LA

HERRAMIENTA MÁS UTILIZADA HOY EN DÍA PARA SEGMENTAR.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 134

ANÁLISIS DE CONGLOMERADOS Y

ÁRBOLES DE DECISIÓN

EJEMPLO DE ÁRBOLES DE DECISIÓN O CLASIFICACIÓN

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 135

ANÁLISIS DE CONGLOMERADOS Y

ÁRBOLES DE DECISIÓN

EJEMPLO DE ÁRBOLES DE DECISIÓN O CLASIFICACIÓN

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 136

ANÁLISIS DE CONGLOMERADOS Y

ÁRBOLES DE DECISIÓN

EJEMPLO DE ÁRBOLES DE DECISIÓN O CLASIFICACIÓN

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 137

ANÁLISIS DE CONGLOMERADOS Y

ÁRBOLES DE DECISIÓN

EJEMPLO DE ÁRBOLES DE DECISIÓN O CLASIFICACIÓN

RESULTADOS COMPLETOS 1

RESULTADOS COMPLETOS 2

RESULTADOS COMPLETOS 3

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 138

ESQUEMA GENERAL DEL ANÁLISIS

CLUSTER

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 139

OBJETIVOS DE LA INVESTIGACIÓN

¿Se aglomeran variables o casos?

Casos

Variables

Análisis Cluster de casos

Análisis Cluster de variables

DISEÑOS DE LA INVESTIGACIÓN

¿Hay valores atípicos? ¿Se estandariza? ¿Son los datos

métricos? ¿Distancias?

ASUNCIONES

¿Es representativa la muestra de la población? ¿Existe multicolinealidad

suficientemente sustancial para que afecte a los datos?

MÉTODO CLUSTER

¿Método jerárquico o no jerárquico?

Jerárquico

No jerárquico

Dos Fases

K-Medias…

Ward, Centroide…

NÚMEROS DE CLUSTERS

Examen de coeficientes de aglomeración Dendograma y

gráfico de carámbanos

REDEFINICIÓN DEL ANÁLISIS CLUSTER

¿Clusters pequeños? ¿Valores atípicos borrados?

NO

SÍ

INTERPRETACIÓN DE CLUSTERS

Variables de aglomeración, nombres,…

VALIDACIÓN DEL MÉTODO

¿Cambian los clusters con el método o la muestra?

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 140

OTROS MÉTODOS DESCRIPTIVOS

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 141

OTROS MÉTODOS DESCRIPTIVOS

MÉTODOS DESCRIPTIVOS: CORRELACIONES Y ESTUDIOS

FACTORIALES

PERMITEN ESTABLECER RELEVANCIA / IRRELEVANCIA DE

FACTORES Y SI AQUÉLLA ES POSITIVA O NEGATIVA RESPECTO A

OTRO FACTOR O VARIABLE A ESTUDIAR.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 142

OTROS MÉTODOS DESCRIPTIVOS

EJEMPLO: ESTUDIO DE VISITAS: 11 PACIENTES, 7 FACTORES:

HEALTH: SALUD DEL PACIENTE (REFERIDA A LA CAPACIDAD

DE IR A LA CONSULTA). (1-10).

NEED: CONVICCIÓN DEL PACIENTE QUE LA VISITA ES

IMPORTANTE. (1-10).

TRANSPORTATION: DISPONIBILIDAD DE TRANSPORTE DEL

PACIENTE AL CENTRO. (1-10).

CHILD CARE: DISPONIBILIDAD DE DEJAR LOS NIÑOS A

CUIDADO. (1-10).

SICK TIME: SI EL PACIENTE ESTÁ TRABAJANDO, PUEDE DARSE

DE BAJA. (1-10).

SATISFACTION: SATISFACCIÓN DEL CLIENTE CON SU MÉDICO.

(1-10).

EASE: FACILIDAD DEL CENTRO PARA CONCERTAR CITA Y

EFICIENCIA DE LA MISMA. (1-10).

NO-SHOW: INDICA SI EL PACIENTE NO SE HA PASADO POR EL

MÉDICO DURANTE EL ÚLTIMO AÑO (0-SE HA PASADO, 1 NO SE

HA PASADO).

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 143

OTROS MÉTODOS DESCRIPTIVOS

MATRIZ DE CORRELACIONES:

Health

Need

Transportation

Child Care

Sick Time

Satisfaction

Ease

No-Show

Health

1

-0.7378

0.3116

0.3116

0.2771

0.22008

0.3887

0.3955

Need

Transp’tion

Child Care

Sick Time

Satisfaction

Ease

No-Show

1

-01041

-01041

0.0602

-0.1337

-0.0334

-0.5416

1

1

0.6228

0.6538

0.6504

-0.5031

1

0.6228

0.6538

0.6504

-0.5031

1

0.6257

0.6588

-0.7249

1

0.8964

-0.3988

1

-0.3278

1

COEFICIENTES DE REGRESIÓN:

INDICA QUE UN INCREMENTO DE 1 EN EL FACTOR

HEALTH AUMENTA LA PROBABILIDAD DE QUE NO

APAREZCA EL PACIENTE EN UN 64.34%.

Independent Variable

Health

Need

Transportation

Child Care

Sick Time

Satisfaction

Ease

Coefficient

.6434

.0445

-.2391

-.0599

-.7584

.3537

-.0786

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 144

OTROS MÉTODOS DESCRIPTIVOS

MÉTODOS DESCRIPTIVOS: REGLAS DE ASOCIACIÓN Y

DEPENDENCIA:

LA TERMINOLOGÍA NO ES MUY COHERENTE EN ESTE CAMPO.

FAYYAD, P.EJ. SUELE LLAMAR ASOCIACIONES A TODO Y

REGLA DE ASOCIACIÓN A LAS DEPENDENCIAS.

ASOCIACIONES:

SE BUSCAN ASOCIACIONES DE LA SIGUIENTE FORMA:

• (X1 = a) (X4 = b).

DE

LOS n CASOS DE LA TABLA, QUE LAS DOS

COMPARACIONES SEAN VERDADERAS O FALSAS SERÁ

CIERTO EN RC CASOS.

EL PARÁMETRO TC (CONFIDENCE) ES:

• TC= CERTEZA DE LA REGLA = RC/n.

SI CONSIDERAMOS VALORES NULOS, TENEMOS TAMBIÉN

UN NÚMERO DE CASOS EN LOS QUE SE APLICA

SATISFACTORIAMENTE

(DIFERENTE

DE

TC)

Y

DENOMINADO TS.

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 145

OTROS MÉTODOS DESCRIPTIVOS

DEPENDENCIAS DE VALOR:

SE BUSCAN DEPENDENCIAS DE LA SIGUIENTE FORMA (IF

ANTE THEN CONS):

• P.EJ.:

IF (X1= a, X3=c, X5=d) THEN (X4=b, X2=a).

DE LOS n CASOS DE LA TABLA, EL ANTECENDENTE SE PUEDE

HACER CIERTO EN ra CASOS Y DE ESTOS EN rc CASOS SE HACE

TAMBIÉN EL CONSECUENTE, TENEMOS LOS PARÁMETROS:

• TC (CONFIDENCE/ACCURACY) Y TS (SUPPORT).

• TC= CERTEZA DE LA REGLA =rc/ra, FUERZA O CONFIANZA

P(CONS|ANTE).

• TS = MÍNIMO Nº DE CASOS O PORCENTAJE EN LOS QUE

SE APLICA

SATISFACTORIAMENTE (rc O rc /n

RESPECTIVAMENTE):

• TAMBIÉN SE LO DENOMINA PREVALENCIA: P(CONS

ANTE).

MINERÍA DE DATOS - TÉCNICAS DESCRIPTIVAS Y PREDICTIVAS DE CLASIFICACIÓN 146

OTROS MÉTODOS DESCRIPTIVOS

EJEMPLO:

ASOCIACIONES:

• CASADO E (HIJOS > 0) ESTÁN ASOCIADOS (80%, 4

CASOS).

• OBESO Y CASADO ESTÁN ASOCIADOS (80%, 4 CASOS).

DEPENDENCIAS:

• (HIJOS > 0) CASADO (100%, 2 CASOS).

• CASADO OBESO (100%, 3 CASOS).

DNI

11251545

30512526

22451616

25152516

23525251

Renta Familiar

5.000.000

1.000.000

3.000.000

2.000.000

1.500.000

Ciudad

Barcelona

Melilla

León

Valencia

Benidorm

Profesión

Ejecutivo

Abogado

Ejecutivo

Camarero

Animador

Parque

Temático

Edad

45

25

35

30

30

Hijos

3

0

2

0

0

Obeso

S

S

S

S

N