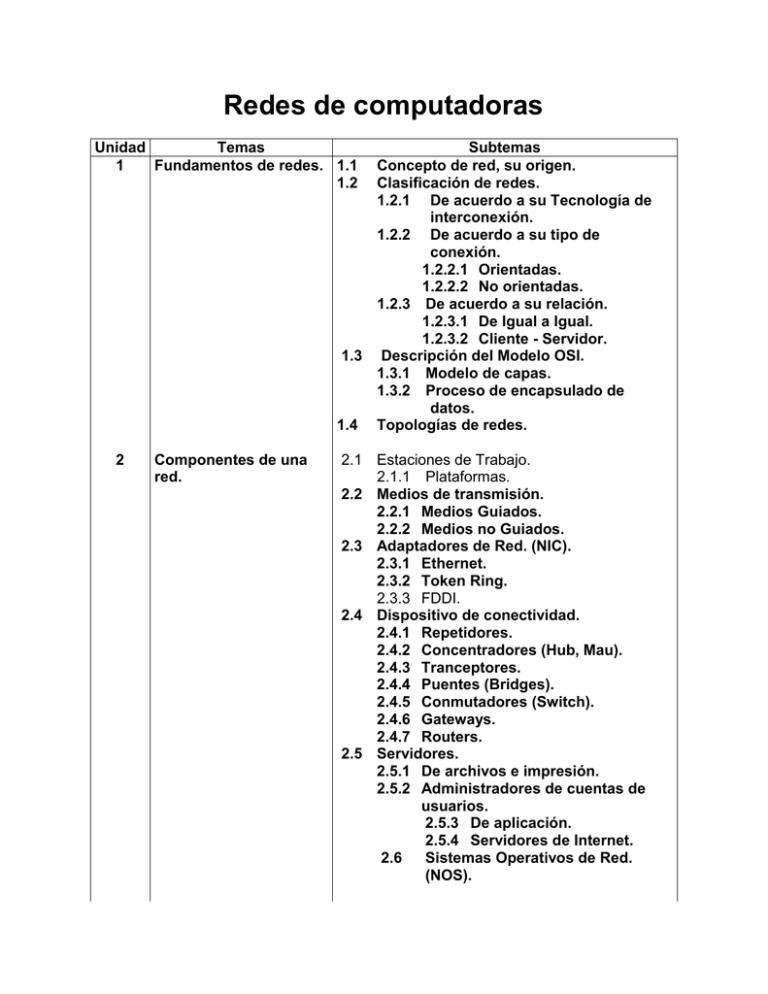

Redes de computadoras_ISC - Servidor de Apoyo al Sistema

Anuncio