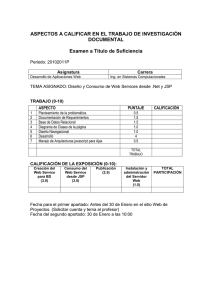

CD-0380.pdf

Anuncio