TP1: Análisis Exploratorio unidimensional

La Estadística es la ciencia que se encarga de obtener, describir e

interpretar los datos. El empleo cuidadoso de los métodos estadísticos

incluye: (1) definir cuidadosamente una situación, (2) obtener los datos, (3)

resumir con precisión los datos y (4) obtener y comunicar las conclusiones

importantes.

El campo de la estadística puede subdividirse a grandes rasgos en dos áreas:

estadística descriptiva y estadística inferencial. La estadística descriptiva o

Análisis Exploratorio de Datos incluye la obtención, presentación y

descripción de los datos muestrales a través de gráficos y métodos

numéricos, es lo que piensa la mayoría de las personas al escuchar la

palabra estadística. La estadística inferencial se refiere a la técnica de

interpretación de los valores resultantes de las técnicas descriptivas y la

toma de decisiones, así como a la obtención de conclusiones relativas a la

población.

Un objetivo típico de la estadística es describir “la población” con base en

información obtenida mediante la observación de relativamente pocos

elementos individuales: la muestra. Una muestra es una determinada

cantidad de unidades (ítems, individuos, objetos, etc.) de los que se extrae

información y que son retirados de un conjunto más grande, al que

denominaremos población. Es necesario aprender cómo clasificar las

generalizaciones contenidas en las pistas proporcionadas por los datos de

la muestra y esbozar una representación de la población. Se estudia la

muestra, pero el interés principal lo constituye la población.

Surgen así, los dos primeros conceptos que un investigador debe identificar:

POBLACIÓN: es el conjunto de individuos, objetos o eventos cuyas

propiedades serán analizadas. Este conjunto representa TODAS las

medidas de interés del investigador. Se considera que está bien

definida sólo cuando se especifica la lista de elementos que

pertenecen a ella. Por ejemplo: “todos los estudiantes que han

asistido alguna vez a una universidad argentina”. Es importante

escribir “el conjunto de TODOS” O “todos/as los/las…”

Cuando se puede enumerar físicamente a todos los elementos que

componen a una población se dice que la población es finita (“todos

los libros de una biblioteca universitaria”). Cuando los elementos son

ilimitados, se dice que la población es infinita (“todos los granos de

arena en el mar”). La población puede designar: un conjunto de

objetos acerca de los cuales se pretende determinar ciertas

propiedades, hablamos de población de unidades; el conjunto de las

medidas (valores observados de esas propiedades o características

que serán denominadas variables) efectuadas sobre esos objetos,

hablamos de población estadística.

"𝑡𝑜𝑑𝑜𝑠 𝑙𝑜𝑠 𝑝𝑎𝑛𝑎𝑑𝑒𝑟𝑜𝑠 𝑎𝑟𝑔𝑒𝑛𝑡𝑖𝑛𝑜𝑠" → 𝑝𝑜𝑏𝑙𝑎𝑐𝑖ó𝑛 𝑑𝑒 𝑢𝑛𝑖𝑑𝑎𝑑𝑒𝑠

"𝑒𝑑𝑎𝑑 𝑗𝑢𝑏𝑖𝑙𝑎𝑡𝑜𝑟𝑖𝑎 𝑑𝑒 𝑡𝑜𝑑𝑜𝑠 𝑙𝑜𝑠 𝑝𝑎𝑛𝑎𝑑𝑒𝑟𝑜𝑠 𝑎𝑟𝑔𝑒𝑛𝑡𝑖𝑛𝑜𝑠"

→ 𝑝𝑜𝑏𝑙𝑎𝑐𝑖ó𝑛 𝑒𝑠𝑡𝑎𝑑í𝑠𝑡𝑖𝑐𝑎

MUESTRA: Es un subconjunto de medidas extraídas de la población

de interés. La terminología es análoga a la anterior: si especifica un

conjunto de objetos acerca de los cuales se pretende determinar

ciertas propiedades, hablamos de muestra de unidades; si especifica

el conjunto de las medidas (valores observados de esas propiedades

o característica que serán denominadas variables) efectuadas sobre

esos objetos, hablamos de muestra estadística.

"65 𝑝𝑎𝑛𝑎𝑑𝑒𝑟𝑜𝑠 𝑑𝑒 𝑙𝑎 𝑐𝑖𝑢𝑑𝑎𝑑 𝑑𝑒 𝑆𝑎𝑛𝑡𝑎 𝑅𝑜𝑠𝑎" → 𝑚𝑢𝑒𝑠𝑡𝑟𝑎 𝑑𝑒 𝑢𝑛𝑖𝑑𝑎𝑑𝑒𝑠

"𝑒𝑑𝑎𝑑 𝑗𝑢𝑏𝑖𝑙𝑎𝑡𝑜𝑟𝑖𝑎 𝑑𝑒 65 𝑝𝑎𝑛𝑎𝑑𝑒𝑟𝑜𝑠 𝑑𝑒 𝑙𝑎 𝑐𝑖𝑢𝑑𝑎𝑑 𝑑𝑒 𝑆𝑎𝑛𝑡𝑎 𝑅𝑜𝑠𝑎"

→ 𝑚𝑢𝑒𝑠𝑡𝑟𝑎 𝑒𝑠𝑡𝑎𝑑í𝑠𝑡𝑖𝑐𝑎

UNIDAD EXPERIMENTAL: el objeto medido, un elemento individual

de la muestra, y por lo tanto de la población. Es importante

mencionar “un/una” y escribir todos los atributos de ese objeto: “un

paciente diabético de 23 años de edad de la localidad de Villa Celina

que trabaja en el mercado central”

La variable es una característica de interés sobre cada elemento

individual de una población o muestra. Es decir que se define sobre la

unidad experimental. Hay dos clases de variables: 1) cualitativas,

clasifican o describen un elemento de la población, contienen una

etiqueta o palabra: “color de pelo”, “ciudad de origen”, “nivel de

satisfacción”. Estas a su vez pueden ser ordinales si especifican un

orden: “evolución de un paciente frente a un tratamiento” o nominales

si no lo hacen: “consume lácteos”, “fuma o no fuma”; y (2) cuantitativas,

cuantifican un elemento de la población. Estas pueden ser discretas si

pueden asumir un número contable (o finito) de valores. Intuitivamente,

la variable discreta puede asumir los valores correspondientes a puntos

aislados a lo largo de un intervalo de recta. Es decir, entre dos valores

cualesquiera siempre hay un hueco. Tienen que ver con conteos:

“número de pacientes enfermos”, “cantidad de manzanas vendidas”,

etc. También pueden ser continuas si pueden asumir una cantidad

incontable de valores. Intuitivamente, la variable continua puede asumir

cualquier valor a lo largo de un intervalo de recta, incluyendo cualquier

valor posible entre dos variables determinadas. Tienen que ver con

mediciones de volumen, peso, tiempo y concentraciones:

“concentración de solutos”, “cantidad de tiempo en realizar un viaje a

Buenos Aires”, etc.

Ordinal (siguen un orden, por

ej. educación, evolución de

Cualitativas (clasifican o

un tratamiento)

describen)

Nominal (no siguen un orden.

Por ej. sexo)

Variables

Discretas (conteos. Por

ej. n° de hijos)

Cuantitativas

(cuantifican)

Continuas (mediciones.

Por ej. altura, peso,

salario)

En un problema es recomendable definir en este orden:

Unidad experimental:

Variable:

Tipo de variable

Población de unidades:

Población estadística:

Muestra de unidades:

Muestra estadística:

Para el siguiente ejemplo describa la unidad experimental, la población

(estadística y de unidades) y la composición de la muestra (estadística y de

unidades). Determine además la variable de interés y el tipo al cual

corresponde.

Se desea conocer el peso promedio de los huevos de ponedoras Leghorn blanca de

una granja. Para ello se consideraron 20 huevos de tales aves y se determinó el peso

de los mismos.

Unidad experimental: un huevo de ponedoras Leghorn blanca de una granja

Variable: peso promedio de un huevo de ponedoras Leghorn blanca de una

granja

Tipo de variable: cuantitativa continua

Población de unidad: todos los huevos de ponedoras Leghorn blanca de una

granja

Población estadística: peso promedio de todos los huevos de ponedoras

Leghorn blanca de una granja

Muestra de unidad: 20 huevos de ponedoras Leghorn blanca de una granja

Muestra estadística: peso promedio de 20 huevos de ponedoras Leghorn

blanca de una granja

Si pide especificar el experimento: Verbo en infinitivo (observar,

encuestar, investigar, etc.) + todas las variables. Por ejemplo:

“𝑒𝑠𝑡𝑖𝑚𝑎𝑟 𝑙𝑎 𝑐𝑜𝑛𝑐𝑒𝑛𝑡𝑟𝑎𝑐𝑖ó𝑛 𝑑𝑒 𝑠𝑎𝑙𝑒𝑠 𝑑𝑒 𝑢𝑛𝑎 𝑚𝑢𝑒𝑠𝑡𝑟𝑎 𝑑𝑒 𝑎𝑔𝑢𝑎 𝑑𝑒 𝑙𝑎

𝐿𝑎𝑔𝑢𝑛𝑎 𝐷𝑜𝑛 𝑇𝑜𝑚á𝑠"

Dos aclaraciones:

la variable tiempo siempre es cuantitativa continua aunque

aparezca discretizada en días, semanas, meses o años. El motivo

es que el tiempo es una variable cronológica, y como tal asume

valores continuos de la recta, pese a que podemos simplificarla

expresándola en números naturales.

la palabra promedio ubicarla únicamente en el experimento (si el

ejercicio lo pide), dado que es una cantidad que surge como

consecuencia del mismo. Nunca poner promedio en unidad

experimental, variables, poblaciones ni muestras.

A lo largo de este curso, veremos que abordar la solución estadística de

un problema requiere de una secuencia de cinco eventos:

1) Una clara definición de los OBJETIVOS de la experiencia y de la

POBLACIÓN asociada;

2) La decisión de cómo elegir la muestra, llamado PROCEDIMIENTO

MUESTRAL. Un procedimiento muy serio cuya selección depende

de una serie de condiciones;

3) La recolección y el Análisis Exploratorio de los Datos Muestrales;

4) Realizar INFERENCIA sobre la población;

5) Dar una MEDIDA de CONFIABILIDAD de la Inferencia realizada.

Los valores que asume la variable se llaman datos. Las listas de

grandes conjuntos de datos en general no proporcionan una imagen útil. A

veces deseamos condensarlos en una forma más manejable; esto puede

lograrse con ayuda de una distribución de frecuencia: una tabla que

relaciona los valores de una variable con su frecuencia observada, que es

el número de veces que ocurre u observa cada valor. Nos permite ordenar

la información y comenzar a visualizar cierto comportamiento de la

variable. La distribución de frecuencia puede ser: no agrupada si los datos

son incorporados a la tabla de manera individual, habitualmente utilizados

cuando se tienen pocos datos y en variables cuantitativas cuando son

valores discretos; agrupadas, cuando los datos son incorporados a la tabla

en forma de agrupaciones: en variables cuantitativas hablamos de

intervalos o clases, habitualmente utilizados cuando se tienen muchos

datos y valores continuos; y en variable cualitativa de categorías, por

ejemplo las opiniones acerca de un servicio pueden ser positivas (esta

categoría podría incluir las respuestas “excelente, muy satisfecho,

satisfecho”) o negativas (“insatisfecho, pésimo”). Las categorías cualitativas

también pueden agrupar datos cuantitativos de ambos tipos, por ejemplo

estimar el nivel de concentración de arsénico en: negativo si toma el valor

0, leves vestigios si va desde 0 a 0,05, o vestigios si es mayor a 0,05mg/v).

--

n

1

n

--

100

....

FR

FP

Acum. Acum.

....

....

....

....

TOTAL

....

Frecuencia Frecuencia FO

Relativa

Porcentual Acum.

....

Datos

Marca de Frecuencia

individuales/Clases Clases

Observada

o categorías

(solo para

clases)

....

La tabla tiene esta forma:

1

--

Para distribuciones agrupadas, las clases presentan un intervalo

semiabierto: [ , ) o ( , ], siendo indistinta la elección. Las únicas

salvedades que se deben considerar son: la elección de uno u otro tipo de

intervalo debe ser una sola para todas las clases; el mínimo debe estar

contenido en la primera clase (con lo cual, a veces será necesario elegir [ , )

si el valor mínimo de un conjunto de datos se corresponde con el límite

inferior de la clase); el último intervalo es el único que puede ser cerrado a

ambos extremos [ , ] si el valor máximo de un conjunto de datos coincide

con el límite superior de la clase. Lo ideal es no trabajar con menos de 5

clases ni más de 15. Para determinar el número de clases a utilizar, la

fórmula de Sturges proporciona un valor mínimo, resultado de hacer 1 +

3,3log(𝑛),siendo n el número total de datos; y un valor máximo, resultado

de 1 + 3,3ln(𝑛). Para determinar la amplitud o ancho de cada clase se

utiliza ∆=

𝑅𝑎𝑛𝑔𝑜

𝑁° 𝑖𝑛𝑡𝑒𝑟𝑣𝑎𝑙𝑜𝑠

=

𝑣𝑎𝑙𝑜𝑟 𝑚á𝑥𝑖𝑚𝑜−𝑣𝑎𝑙𝑜𝑟 𝑚í𝑛𝑖𝑚𝑜

𝑁° 𝑖𝑛𝑒𝑟𝑣𝑎𝑙𝑜𝑠

siendo esos valores

máximo y mínimo los correspondientes a todo el conjunto de datos

numéricos que ofrece un problema. La segunda columna, la marca de

𝑙í𝑚𝑖𝑡𝑒 𝑖𝑛𝑓𝑒𝑟𝑖𝑜𝑟+𝑙í𝑚𝑖𝑡𝑒 𝑠𝑢𝑝𝑒𝑟𝑖𝑜𝑟

clase, es el punto medio de cada clase (

2

)

constituye una medida representativa de todo el rango de valores que

contiene cada clase.

100

--

Las frecuencias absolutas es el conteo de cada valor individual o cada

valor que cae dentro de una clase o categoría. El TOTAL = n de la frecuencia

absoluta debe dar el número total de valores de la variable.

La frecuencia relativa es una proporción de cuánto representa cada

valor de la frecuencia absoluta respecto del total. Se obtiene dividiendo

cada valor observado entre n. El TOTAL debe dar 1, si no es el caso se debe

redondear así: si la suma se pasa de 1, se le saca al valor o clase más

pequeño que no se repita; si la suma no alcanza 1 se le agrega al valor o

clase mayor que no se repita.

La frecuencia porcentual es la frecuencia relativa multiplicada por

100. Su TOTAL debe dar 100.

Cualquiera de las tres columnas sombreadas se puede acumular. La

acumulación nos dice cuántos datos se tienen respecto al total. En la

frecuencia observada acumulada se debe ir sumando cada valor con el

anterior, y la anteúltima celda debe dar n. En la frecuencia relativa

acumulada es lo mismo y la anteúltima celda debe dar 1, lo propio con la

acumulación de la frecuencia porcentual cuyo valor final de la anteúltima

celda debe ser 100. En los tres casos, la fila TOTAL se deja vacío. Cuando un

ejercicio pide armar una tabla de distribución de frecuencias, sin especificar

cuál de las tres columnas acumular, se puede elegir cualquiera de las tres.

Con acumular una es suficiente.

Una vez que los datos están ordenados en una tabla de distribución de

frecuencias se puede elaborar una representación gráfica:

Si la variable es cualitativa el gráfico apropiado es el de torta. Puede usarse

el de barras separadas pero la profe no lo recomienda porque el ancho de

las barras puede prestar a confusión.

Si la variable es cuantitativa continua el gráfico apropiado es el histograma,

cuya altura es la frecuencia observada de cada clase y la base son las clases,

las barras se tocan. Las variables cronológicas continuas constituyen un

caso especial cuyo gráfico típico es el de líneas. En estos se suele preguntar

por la tendencia de las variables y hay que elaborar conclusiones respecto

a la evolución temporal de las mismas en un período de tiempo: si es

creciente, decreciente o estable. Es recomendable identificar patrones a la

hora de elaborar conclusiones.

Si la variable es cuantitativa discreta, las barritas se empiezan a separar de

acuerdo con los valores enteros que toman los conteos, ya no abarcan la

totalidad de valores de un eje, y el gráfico apropiado es el de bastones.

Sobre el eje Y puede ir cualquier frecuencia, la relativa se suele utilizar por

la propiedad de que el área bajo la curva da uno, pero se puede emplear

cualquier frecuencia: absoluta o relativa.

Vinculados con los histogramas y las clases aparecen dos gráficos

relacionados.

Uno es el polígono de frecuencias, que se puede elaborar encima de un

histograma, uniendo los puntos medios de las clases. Cuando una clase está

vacía, igual hay que imaginarse que no lo está y unir la línea al punto medio

de esa clase.

El otro es la Ojiva: una gráfica de línea de una frecuencia acumulada

(cualquiera de las tres) cuyos puntos se trazan sobre los límites superiores

de cada clase.

Todas las representaciones gráficas deben contener una serie de

elementos:

Titulo descriptivo que identifica la muestra de interés

Rótulos en los ejes. Los valores para los límites de clase o puntos

medios de clase pueden etiquetarse a lo largo del eje x.

Referencia: utilizar colores diferentes para una gráfico que muestra

dos o más variables

Fuente: “gráfico de elaboración propia a partir de datos

suministrados por xx”

Valores Representativos

Vimos que la reducción de datos a través de un gráfico o de una tabla de

frecuencias nos da mucha más información sobre el comportamiento de

una variable que el propio conjunto original de datos. Sin embargo, algunas

veces queremos reducir aún más esos datos, presentando uno o dos valores

que sean “representativos” de toda la serie. Con estos valores logramos

entonces: una reducción drástica de los datos y podemos observar el

comportamiento de la variable. Tenemos dos grandes parámetros: 1) las

medidas de posición central y 2) las medidas de dispersión.

1) Las medidas de posición central son valores numéricos que localizan

de alguna manera el centro de un conjunto de datos. Representan un

centro alrededor del cual se encuentra ubicado el conjunto de los datos, o

la mayoría de ellos. Usualmente, se emplea una de las siguientes medidas:

MODA, MEDIANA y MEDIA (aritmética).

Moda 𝑴𝒐: es la realización más frecuente del conjunto de valores

observados. El valor más grande de la frecuencia observada. En relación a

estos valores los histogramas muestran distintas disposiciones:

Si es unimodal puede ser:

Simétrica: ambos lados de esta distribución son idénticos (las

mitades son imágenes de espejo).

Normal: una distribución simétrica se agrupa alrededor de la media

y se hace escasa en los extremos.

Uniforme (rectangular): todo valor aparece con la misma frecuencia.

Sesgada: una cola está estirada más que la otra. La dirección de sesgo

está en el lado de la cola más larga.

En forma de J: no existe cola en el lado del grupo con la frecuencia

más alta.

Si hay dos modas:

Bimodal: los dos grupos de mayor población están separados por uno

o más grupos. Esta situación con frecuencia implica que dos

poblaciones se estén muestreando.

Mediana 𝑴𝒅(𝑿): es el valor que ocupa la posición central de la serie de

observaciones, cuando estas están ordenadas de acuerdo a sus valores

(creciente o decreciente).

̅: promedio de los valores observados

Media Aritmética 𝒙

Para variables cualitativas, la moda es la única medida de posición

central que se puede calcular; para variables cuantitativas se pueden

calcular las tres medidas de posición central.

A continuación, detallo cómo calcular estos valores para datos

agrupados y datos sin agrupar. Es importante notar que en las tres

expresiones de los datos agrupados toma relevancia la marca de clases

porque es un valor de referencia que representa o nuclea a todos los datos

que cayeron dentro de esa clase:

Parámetro\Tipos de datos

Moda

Notación 𝑀𝑜(𝑥) =

Mediana

Notación 𝑀𝑑(𝑥) =

Datos Agrupados

Profe: marca de clase del intervalo con

mayor frecuencia.

Carpeta: la mitad de la clase que

contiene más frecuencias observadas

Profe: marca de clase del intervalo en

el que se acumula hasta el 50% de los

datos

Carpeta: la mitad de la clase que

contiene una frecuencia porcentual

acumulada más cercano a 50%

Datos Sin Agrupar

Valor que más se repite

Hay que ordenar los datos de

menor a mayor (para esto

utilizar el diagrama Tallo-Hoja) y

hacer el siguiente conteo:

Si la muestra es impar, el dato

que sobra y se ubica

Si la clase acumula hasta un valor que exactamente en la posición

se pasa del 50%, no importa, porque central dejando la misma

la mediana estará dentro de esa clase. cantidad de valores a su

izquierda y a su derecha, ese

dato es la mediana. Es un valor

observado en la muestra.

𝑋(𝑛+1) 𝑠𝑖 𝑛 𝑒𝑠 𝑖𝑚𝑝𝑎𝑟

2

Media Aritmética

̅=

Notación 𝒙

Si la muestra es par, el

promedio de los dos datos

centrales es la mediana. No es

un valor observado en la

muestra justamente por ser el

promedio de dos valores de la

misma.

𝑋(𝑛) + 𝑋(𝑛+1)

2

2

𝑠𝑖 𝑛 𝑒𝑠 𝑝𝑎𝑟

2

IMPORTANTE: la mediana NO

ES la posición central, ES el valor

que ESTÁ en la posición central

Sumatoria de: cada marca de clase 𝑥′𝑖 Suma de todos los valores

multiplicada por su frecuencia observados, dividido por el

absoluta 𝑓𝑖 ; todo eso dividido entre n número total de ellos (osea por

Para k clases:

el número de elementos de la

𝑘

muestra n):

1

𝑛

∑ 𝑥′𝑖 𝑓𝑖

1

𝑛

∑ 𝑥𝑖

𝑖=1

𝑛

𝑖=1

Estos tres valores pueden diferir cuando se trabaja con datos agrupados

respecto a los obtenidos cuando se trabaja con datos sin agrupar. Esto

se da porque al agrupar, estamos organizando la información en

intervalos, cuyo valor de referencia es la marca de clase. Entonces se

pierde la naturaleza individual del dato original y por ello los resultados

obtenidos bajo este procedimiento arrojan ciertas diferencias respecto

al procedimiento sin agrupar. Aun así, si esas diferencias son sutiles, es

debido a que la variable presenta un comportamiento bastante

simétrico (normal), algo que se aprecia al realizar un histograma. El

comportamiento normal es el ideal para la Estadística, por eso en esos

casos se suele decir que la variable es “bien comportada”.

El diagrama Tallo-Hoja es una especie

de paso intermedio entre tener los

datos originales y empezar a agrupar

esos datos. No es una tabla de

distribución de frecuencias ni un

histograma propiamente dicho, pero

sirve para comenzar a ver qué

distribución tiene la variable sin

perder de vista los datos originales. Es

útil en tres situaciones puntuales: el

cálculo de la mediana para datos sin

agrupar en donde hay que contar

posiciones; el cálculo de MAD (que

está asociada a la mediana) una

medida de dispersión que se describe

a continuación; y los cuartiles. El tallo

se escribe a lo largo del eje vertical, a

la izquierda, y está formado por el

conjunto de las clases que tenemos

en una tabla de distribución de

frecuencias. Por cada clase se

desprende una hoja que muestra los

valores que están dentro de cada

clase. Si quisiéramos ajustar una curva, nos permite percibir un

comportamiento de la variable, en relación a dónde hay una mayor

concentración de los datos, puntualmente en cuáles clases. Así podríamos

darnos cuenta qué forma tendrá el histograma en caso de que no lo

hayamos hecho. Por esto el diagrama Tallo-Hoja es un diagrama intermedio

entre una tabla de frecuencias, la muestra y un histograma.

Lo ideal es elaborar el diagrama Tallo-Hoja respetando el orden creciente

de los datos, de manera que podamos hacer el conteo y ver qué valores

están en la posición central para obtener la mediana, por ejemplo. Los

podemos marcar con un círculo y hacer el promedio en caso de que

tengamos un n par.

2) Las medidas de variabilidad o de dispersión son valores numéricos que

describen la cantidad de dispersión, o variabilidad, que se encuentra entre

los datos: los datos agrupados de manera estrecha tienen valores

relativamente pequeños, y aquellos datos que estén más dispersos tienen

valores más grandes. El agrupamiento más cercanamente posible ocurre

cuando los datos no tienen dispersión (todos los datos son del mismo valor);

en esta situación, la medida de dispersión será cero. No hay límite sobre

qué tan dispersos puedan ser los datos; por tanto, las medidas de dispersión

pueden ser muy grandes. Las medidas de variabilidad se definen con

respecto a una medida de posición: incluyen la VARIANZA y el DESVÍO

ESTÁNDAR en relación a la media; y el MAD en relación a la mediana.

La varianza mide cuánto se alejan los datos con respecto a la media en

promedio. La varianza es la media (ose el promedio) de las desviaciones 𝑥 −

𝑥̅ al cuadrado. Las desviaciones nos dicen cuán lejos está cada valor x de la

media 𝑥̅ . Si sumamos todas las desviaciones ∑𝑛𝑖=1(𝑥𝑖 − 𝑥̅ ) sobre toda la

muestra, obtendríamos cero debido a que 𝑥𝑖 toma valores tanto positivos

como negativos generando un efecto de neutralización. Esto se elimina si

se eleva al cuadrado cada una de las desviaciones ∑𝑛𝑖=1(𝑥𝑖 − 𝑥̅ )2 . Ahora sí,

̂2 :

sacando el promedio, tenemos la varianza 𝜎

𝑛

̂2 = 1 ∑(𝑥𝑖 − 𝑥̅ )2 → 𝑠𝑖𝑛 𝑎𝑔𝑟𝑢𝑝𝑎𝑟

𝜎

𝑛

𝑖=1

En el práctico 1 usamos la expresión de la varianza que divide sobre 𝑛, más

adelante utilizamos otra expresión alternativa que divide por 𝑛 − 1.

Una vez calculada la varianza se puede calcular el desvío estándar, que es

la raíz cuadrada de este último valor (el resultado positivo de la raíz). El

desvío estándar es la medida de variabilidad o dispersión de los datos por

excelencia:

𝑛

̂2 = √1 ∑(𝑥𝑖 − 𝑥̅ )2 → 𝑠𝑖𝑛 𝑎𝑔𝑟𝑢𝑝𝑎𝑟

𝐷. 𝐸(𝑥) = √𝜎

𝑛

𝑖=1

Para datos agrupados, se utilizan las marcas de clase 𝑥′𝑖 :

𝑛

1

2 = ∑ 𝑓 (𝑥′ − 𝑥̅ )2 → 𝑑𝑎𝑡𝑜𝑠 𝑎𝑔𝑟𝑢𝑝𝑎𝑑𝑜𝑠

̂

𝜎

𝑖

𝑖

𝑖

𝑛

𝑖=1

𝑛

̂2 = √1 ∑ 𝑓𝑖 (𝑥′𝑖 − 𝑥̅ )2 → 𝑑𝑎𝑡𝑜𝑠 𝑎𝑔𝑟𝑢𝑝𝑎𝑑𝑜𝑠

𝐷. 𝐸(𝑥) = √𝜎

𝑛

𝑖=1

Si un ejercicio no aclara si hacer estos cálculos con datos agrupados o sin

agrupar, lo ideal es hacer los cálculos sin agrupar porque el resultado que

se obtiene es más exacto.

El MAD es la medida de dispersión o variabilidad asociada a la mediana.

También muestra cuánto se alejan los datos, pero ahora respecto a la

mediana. Trabajamos de nuevo con el diagrama Tallo-Hoja: restamos cada

dato de la mediana que obtuvimos para datos sin agrupar; con esos

resultados obtenidos de tales diferencias, en valor absoluto, se ordenan de

menor a mayor y se calcula a partir de este ordenamiento, una nueva

mediana (sin agrupar también, viendo si me queda n par o impar). Si tengo

datos agrupados la diferencia que haré será la marca de clase por su

frecuencia observada, menos la mediana que habíamos obtenido para

datos agrupados; se ordenan de menor a mayor; se busca la mediana de

ese conjunto de datos. En este último caso simplemente me acomodo a la

situación de tener datos agrupados. La expresión de MAD es:

𝑀𝐴𝐷 = 𝑀𝑑(|𝑥𝑖 − 𝑀𝑑(𝑥)|) → 𝑠𝑖𝑛 𝑎𝑔𝑟𝑢𝑝𝑎𝑟

𝑀𝐴𝐷 = 𝑀𝑑|(𝑥′𝑖 − 𝑀𝑑(𝑥)) 𝑟𝑒𝑠𝑡𝑎𝑟 𝑓𝑖 𝑣𝑒𝑐𝑒𝑠| → 𝑑𝑎𝑡𝑜𝑠 𝑎𝑔𝑟𝑢𝑝𝑎𝑑𝑜𝑠

Osea es la mediana de los desvíos de cada dato con respecto a su mediana,

en valor absoluto.

IMPORTANTE: medidas de posición central y medidas de dispersión

resumen el comportamiento de la variable en términos numéricos. Cuando

la variable presenta un comportamiento SIMÉTRICO, las tres medidas de

posición central (moda, mediana y media) arrojarán valores similares unas

respecto a la otra. Cuando eso pasa, la mejor medida de posición central es

la media y en consecuencia una buena medida de dispersión es el desvío

estándar. Sin embargo, cuando la muestra no es tan simétrica, es decir,

presenta un comportamiento asimétrico, donde vemos que la gráfica es

sesgada o a izquierda o a derecha, la mejor medida de posición central es

la mediana. Esto es porque la mediana no resulta afectada por los valores

extremos, ella se ubica al centro de la distribución independientemente de

la asimetría que presente. En consecuencia, cuando la muestra no es

simétrica, la mejor medida de posición central es la mediana, y su medida

de dispersión asociada es la MAD.

Coeficiente de variación 𝐂𝐯 =

𝑫.𝑬

̅

𝒙

: es una relación entre la magnitud de la

variabilidad (D.E o MAD) y la magnitud de la media. Si el 𝐶𝑣 es chico (menor

al 80%) significa que la media es representativa del conjunto de datos y

entonces tenemos un conjunto de datos homogéneo. Pero si el 𝐶𝑣 es muy

grande, cercano a 1, la media no es una medida representativa del conjunto

de datos y se tiene un conjunto de datos heterogéneo o muy disperso.

BoxPlot

Es un gráfico que resume por excelencia el comportamiento de la

variable. El Box Plot es un gráfico de caja y brazos (llamados también

bigotes) que van a tener un ancho y largo dependiendo de cómo se

comporte esa variable. Se construye a partir de cinco medidas y permite

conocer mucha información: la simetría de esa variable; la dispersión; y la

presencia o no de valores atípicos o outliers, como también se conoce. Se

utiliza para variables cuantitativas, tanto continuas como discretas, pero es

más importante para las continuas. Las cinco medidas que requiere son el

mínimo y el máximo como extremos de la distribución; y en el medio

aparecen los cuartiles 𝑞1 , 𝑞2 y 𝑞3 . Los cuartiles son medidas de posición.

Las medidas de posición se utilizan para describir la posición que un dato

específico posee en relación con el resto de los datos. Los cuartiles son los

valores de la variable que dividen a la muestra en cuartos. Cada conjunto

de datos posee tres cuartiles tal que:

1/4 de los datos (25%) son menores que 𝑞1

1/2 (la mitad) de los datos (50%) son menores que 𝑞2

3/4 de los datos (75%) son menores que 𝑞3

Para construir el Boxplot seguir estos pasos:

𝑛

1) Ver si la muestra (osea el n) es par o impar. Si es par, hacer 𝑞 = ; si

es impar hacer 𝑞 =

2

𝑛+1

2

2) A partir del valor de q obtenido procedemos a hallar los cuartiles. A

partir de acá será encontrar un valor de la variable en la posición r

que den los cuartiles 𝑞1 y 𝑞3 . Usando los datos del Tallo-Hoja,

buscamos el valor de la posición r tal que:

𝑞1 = 𝑥(𝑟)

Si q es impar, hacer 𝑟

Si q es par, hacer 𝑟

=

𝑞+1

2

y definir

𝑞

𝑞3 = 𝑥(𝑛+1−𝑟)

𝑞1 =

𝑥(𝑟) + 𝑥(𝑟+1)

2

𝑞3 =

𝑥(𝑛+1−𝑟) + 𝑥(𝑛−𝑟)

2

= 2 y definir

3) Para hallar 𝑞2 usamos el mismo criterio que para calcular la mediana

𝑀𝑑(𝑥) (marca de clase con frecuencia acumulada hasta el 50% si

tengo datos sin agrupar o las reglas de par – impar si tengo datos no

agrupados) dado que dicha medida divide al conjunto de datos en

dos partes iguales. Como la mediana un valor que está en el centro

de distribución de los datos, se emplea para definirla como 𝑞2 :

𝑞2 = 𝑀𝑑(𝑥)

4) Calcular el rango intercuartílico, que es la diferencia entre el cuartil 3

y el cuartil 1. Es una diferencia entre los extremos de esa caja.

𝑅𝐼𝑄 = 𝑞3 − 𝑞1

Y multiplicarlo por 1,5 que es un coeficiente que afecta al rango

intercuartílico e indicar que hasta esa altura o valor consideramos los

datos como “dentro de la gráfica”. Cuando los datos se escapan de

ese rango intercuartílico multiplicado por 1,5, 1,5. 𝑅𝐼𝑄 = 1,5(𝑞3 −

𝑞1 ), podemos considerarlos como puntos atípicos (outliers), que

estarían alejados del resto de la distribución.

1,5. 𝑅𝐼𝑄 = 1,5(𝑞3 − 𝑞1 ) → 𝑐𝑜𝑟𝑡𝑒 𝑑𝑒 𝑑𝑎𝑡𝑜𝑠

El brazo superior si ubicamos la caja en vertical, o derecho si la

ubicamos en horizontal, se prolonga hasta:

1,5. 𝑅𝐼𝑄 + 𝑞3 = 1,5(𝑞3 − 𝑞1 ) + 𝑞3 → 𝑏𝑟𝑎𝑧𝑜 𝑠𝑢𝑝𝑒𝑟𝑖𝑜𝑟

Este valor alcanza el máximo observado de la muestra, (y debería

superarlo).

El brazo inferior si ubicamos la caja en vertical, o izquierdo si la

ubicamos en horizontal, se prolonga hasta:

1,5. 𝑅𝐼𝑄 − 𝑞1 = 1,5(𝑞3 − 𝑞1 ) − 𝑞1 → 𝑏𝑟𝑎𝑧𝑜 𝑖𝑛𝑓𝑒𝑟𝑖𝑜𝑟

Este valor alcanza el mínimo observado de la muestra, (y debería

superarlo).

Si al extender los brazos, tanto el superior como el inferior, superan

al valor máximo y mínimo respectivamente, el corte de los brazos se

hace en esos puntos extremos de la muestra. Esto es fundamental

para no seguir generando datos que no existen. Graficando los datos,

en el eje vertical va la variable:

Entre una medida y la otra se encuentra, siempre, un 25% de la información.

Aunque la caja o los brazos sean más largos o más anchos, la proporción

sigue siendo la misma: entre cada medida hay 1/4 de los datos de la

muestra. En tal caso, podemos decir que los datos en una porción de la

gráfica son más dispersos, pero NO significa que en un bigote más largo

haya más datos.

En la caja encontramos el 50% central de los datos. Habitualmente, los

programas estadísticos grafican la mediana, que es la medida de posición

central más robusta o confiable. Si la medida se ubica aproximadamente en

el centro de la caja, podemos decir que el 50% central de los datos es

bastante simétrico.

Cosas que pueden pasar acerca del Box Plot:

En ocasiones el gráfico puede ser simétrico en toda su extensión, sin

embargo, puede ocurrir que la caja sea muy simétrica pero que

tengamos un brazo más largo que el otro. Ahí diríamos que hay un

50% central de los datos que están concentrados, son normales,

simétricos o se encuentran bien comportados (es todo lo mismo), con

una leve dispersión hacia los valores máximos o mínimos.

No ver los cuartiles uno y dos; o dos y tres; o que no veamos algún

brazo. Ahí diríamos que los datos están tan concentrados en esas

porciones, que se junta una medida con la otra. El concepto

importante a recordar es: el hecho de que la caja sea más ancha o

más angosta, que los brazos sean más largos o más cortos, que se

vean todas las medidas o que no se vean algunas, no significa que

haya más o menos datos. Significa que hay una mayor o menor

concentración de datos en esa porción de la gráfica.

Cuando se pidan conclusiones sobre este tipo de gráficos hay que

prestar atención a tres puntos clave: 1) la simetría de la variable: se

observa viendo dónde se ubica la mediana dentro de la caja y en todo

el contexto de la gráfica; 2) la dispersión o variabilidad de los datos:

se analiza observando el ancho de la caja y el largo de los brazos.

Diferenciar en los casos que corresponda si en algún lugar de la

gráfica una porción es más larga o ancha que la otra: allí hay más

dispersión de datos; y 3) la presencia o no de valores atípicos o

outliers: si el brazo superior se extiende hasta un valor que no alcanza

el valor máximo de la muestra, ese máximo es un outlier. Un outlier

significa que se tomaron mal los datos, que hay una medición

extraña, o que la variable presenta un comportamiento extraño. Pero

no estamos capacitados para conjeturar demasiado acerca de esos

puntos atípicos. Solo debemos mencionar si hay o no, cuántos son, y

si están en los valores máximos o mínimos. Si los hay, esos valores

atípicos nunca deben ser eliminados, bajo ningún punto de vista,

dado que son parte de nuestra distribución. Lo que correspondería

como investigador sería buscar una explicación de por qué esos datos

se escapan del resto de la distribución. Si bien son datos que

distorsionan la distribución, merecen una explicación aparte. En

muchos casos han sido motivos de demoras en defensas de trabajos

de investigación justamente por no eliminarlos y tratar de buscarles

una explicación.

Si pregunta cuál es la distribución que tuvo mayor valor en promedio,

la respuesta tiene que ser dada en términos de la mediana.

Elaborar conclusiones es parte de la secuencia de pasos que se deben llevar

a cabo al momento de abordar un procedimiento estadístico. Forma parte

de la Estadística Descriptiva o Exploratoria. No tienen que ser muy extensas,

a veces mientras más escribimos, podemos estar errando en algunas

cuestiones. Deben focalizarse en el análisis de gráficos y medidas tanto de

posición central como de dispersión. Las conclusiones son tan o más

importantes que saber hacer un cálculo o gráfico. Es fundamental poder

interpretar las diversas herramientas para poder trasladar esas medidas a

la situación que estamos analizando.

TP2: Análisis Exploratorio Bidimensional

En la práctica 1 aprendimos cómo presentar en forma gráfica y

describir numéricamente datos muestrales para una variable. El propósito

de esta práctica es extender tales técnicas para abarcar datos muestrales

que involucran dos variables emparejadas. En este caso, hablamos de datos

de dos variables, que son los valores de dos variables diferentes que se

obtienen del mismo elemento de la población. Cada par de variables puede

ser cualitativas o cuantitativas. A partir de si se tratan de un caso u otro, el

análisis exploratorio sigue un procedimiento distinto, pero el final siempre

será decir si existe dependencia entre ambas o no. Para ello se emplea una

medida que cuantifica la dependencia, denominada coeficiente de

asociación. El coeficiente de asociación de las variables cuantitativas se

llama coeficiente de contingencia C, este va de 0 a 1; y el de las variables

cuantitativas, de Pearson, que va de -1 a 1. En ellos, la proximidad al cero

es sinónimo de independencia.

Cuando tenemos dos variables cualitativas, la información de esas

variables se vuelva en tablas de contingencia o tablas de doble entrada que

muestran la ocurrencia conjunta de ellas.

variable 1 \ Valor de la variable 2: X2 Valor de la variable 2: Y2

TOTAL

variable 2

Valor de la fi X1X2 (fes X1X2)

fi X1Y2 (fes X1Y2)

∑ 𝑓𝑖 𝑡𝑜𝑑𝑎 𝑙𝑎 𝑓𝑖𝑙𝑎 1

variable 1: X1

Valor de la fi Y1X2 (fes Y1X2)

fi Y1Y2 (fes Y1Y2)

∑ 𝑓𝑖 𝑡𝑜𝑑𝑎 𝑙𝑎 𝑓𝑖𝑙𝑎 2

variable 1: Y1

TOTAL

∑ 𝑓𝑖 𝑡𝑜𝑑𝑎 𝑙𝑎 𝑐𝑜𝑙𝑢𝑚𝑛𝑎1 ∑ 𝑓𝑖 𝑡𝑜𝑑𝑎 𝑙𝑎 𝑐𝑜𝑙𝑢𝑚𝑛𝑎 2 Total de la muestra n

La fila del TOTAL y la columna del TOTAL corresponde a lo que se

llama “distribución marginal”: El interior de la tabla, coloreada,

corresponde a la “distribución conjunta”. Los 𝑓𝑖 de cada celda son las

frecuencias observadas para los datos simultáneos que asumen dos

variables.

Esta tabla nos permite obtener elementos como las frecuencias

observadas, las que surgen de la experiencia, osea los datos que brinda el

problema. Son los 𝑓𝑖 de cada celda; y las frecuencias esperadas, el número

que va entre paréntesis al lado de cada frecuencia observada de una celda,

es el valor que deberíamos tener en caso de que las variables fuesen

independientes. La frecuencia esperada de una celda resulta de:

(𝑡𝑜𝑡𝑎𝑙 𝑑𝑒 𝑙𝑎 𝑓𝑖𝑙𝑎 . 𝑡𝑜𝑡𝑎𝑙 𝑑𝑒 𝑙𝑎 𝑐𝑜𝑙𝑢𝑚𝑛𝑎)

𝑡𝑜𝑡𝑎𝑙 𝑑𝑒 𝑙𝑎 𝑚𝑢𝑒𝑠𝑡𝑟𝑎 𝑛

En la tabla 𝑓𝑒𝑠 se puede redondear a un número natural si los valores que

toma una de las variables están acotados a este conjunto numérico. En este

caso, el valor final de 𝜒 2 puede variar respecto al que calcula un paquete

estadístico.

Cuando en cada celda: restamos la frecuencia observada menos la

frecuencia esperada, luego elevamos al cuadrado y dividimos por la

frecuencia esperada de esa celda, si sumamos esos números de todas las

celdas, obtenemos un parámetro que se llama “chi cuadrado”: 𝜒 2 .

𝑡𝑜𝑑𝑎𝑠 𝑙𝑎𝑠 𝑐𝑒𝑙𝑑𝑎𝑠

2

𝜒 =

∑

(𝑓𝑖 − 𝑓𝑒𝑠)2

𝑓𝑒𝑠

𝜒 2 mide cuánto se alejan las frecuencias observadas, las que se registraron

en un experimento, respecto de las que deberían esperarse si las variables

fuesen independientes.

Para cuantificar si la dependencia entre ambas variables es alta o baja, se

utiliza un coeficiente de contingencia C:

𝜒2

√

𝐶=

𝜒2 + 𝑛

Y para corregir este valor a una mayor precisión, se utiliza el C corregido;

𝐶∗ =

𝐶

√𝑡 − 1

𝑡

donde t es el número mínimo entre dos números: la suma de todas las

columnas de la distribución conjunta (el centro de la tabla), o la suma de

todas las filas también del centro de la tabla. El 𝐶 ∗ es la medida final que

cuantifica la dependencia o no entre dos variables.

Si 𝐶 ∗ es próximo a 0, habrá mayor independencia, si 𝐶 ∗ es próximo a 1,

habrá mayor dependencia entre las variables.

A modo orientativo, podemos utilizar estos valores límites de 𝐶 ∗ :

0~0,25 refleja una débil o leve dependencia

0,25~0,75 refleja una moderada dependencia

0,75~1 refleja una fuerte dependencia

Cuando tenemos dos variables cuantitativas, la información debe ser

resumida en un gráfico de dispersión, es un gráfico de puntos que

corresponden a cada uno de los pares X e Y. A partir de la disposición de

los puntos se puede concluir si parece haber dependencia:

Si a medida que aumenta una variable, aumenta la otra, es una

dependencia lineal positiva.

Si a medida que aumenta una variable, disminuye la otra, es

una dependencia lineal negativa.

Si conocer el resultado de una variable no ayuda a predecir el

comportamiento de la otra, parece no haber dependencia.

En los ejercicios, en general si no se especifica cuál es la variable X y

cuál es la Y, es indistinto cuál es la elección que hagamos. Sin embargo, es

importante empezar a detectar cuál es la variable dependiente Y, la que

varía en función de la variable independiente X, esta última es la que fija el

investigador como valores conocidos.

Para cuantificar la asociación observada entre las variables, se puede

utilizar una medida que juzga cuánto la nube de puntos en el gráfico de

dispersión se aproxima a una recta (relación lineal). Es decir que, al igual

que el de contingencia, se trata de un parámetro que permite cuantificar la

asociación entre las dos variables, en este caso cuantitativas. Por lo tanto,

luego de elaborar el gráfico de dispersión, nos trasladamos a calcular el

coeficiente de correlación de Pearson:

𝑟𝑥𝑦 =

∑𝑛𝑖=1 𝑥𝑖 𝑦𝑖 − 𝑛𝑥̅ 𝑦̅

√(∑𝑛𝑖=1 𝑥𝑖2 − 𝑛𝑥̅ 2 ). (∑𝑛𝑖=1 𝑦𝑖2 − 𝑛𝑦̅ 2 )

𝑟𝑥𝑦 es un número entre -1 y 1:

Si 𝑟𝑥𝑦 > 0 la correlación es lineal positiva

Si 𝑟𝑥𝑦 < 0 la correlación es lineal negativa

Si 𝑟𝑥𝑦 = 0 no existe correlación lineal

Cuando elaboramos una conclusión debemos mencionar dos cuestiones

elementales: el valor del coeficiente de asociación final (𝐶 ∗ o 𝑟𝑥𝑦 ), y las

variables que se están analizando.

Podemos resumir los conceptos de esta práctica a través de este

esquema:

Cualitativas

Tabla de

Contingencia

Dependencia

entre dos

variables

frec. observadas y

frec. esperadas

permiten calcular

𝜒2

Coeficiente de

contingencia

𝐶 y 𝐶∗

Coeficientes de

asociación entre

variables

Cuantitativas

Gráfico de

dispersión

Coeficiente de

correlación de

Pearson 𝑟𝑥𝑦

TP3: Probabilidades

Hasta acá habíamos dicho que la estadística era la ciencia de elegir

una muestra y hacer inferencias sobre la población desconocida de la cual

se extrajo dicha muestra. Para hacer esas inferencias, es necesario estudiar

resultados muestrales, en situaciones en que se conoce la población, de

modo que sea posible comprender el comportamiento de los eventos al

azar. Justamente por esto, la probabilidad algunas veces se denomina como

el “vehículo” de la estadística. El estudio de las probabilidades nos ayuda a

comprender los modelos probabilísticos sobre los que nos basamos para

comprender la inferencia estadística. La Probabilidad y la Estadística se

relacionan así:

En la Teoría de Probabilidades, la población se supone conocida y el

problema consiste en calcular la probabilidad de observar una muestra

particular.

En la Teoría Estadística (inferencial) ocurre exactamente al revés, la

población es supuestamente desconocida, la muestra es conocida y se

desea realizar inferencia acerca de la población.

Por lo tanto:

• La Probabilidad razona de la Población a la Muestra.

• La Estadística (inferencial) razona de la Muestra a la Población.

Probabilidad

Población

Muestra

Estadística

Descriptiva

Estadística

Inferencial

Empezamos definiendo un experimento: es el proceso por el cual

una observación (o medida) es obtenida. Pueden ser:

DETERMINÍSTICOS: son aquellos que repetidos, bajo las mismas

condiciones, dan iguales resultados, por lo tanto, son predecibles (por

ejemplo, los fenómenos físicos o químicos);

ALEATORIOS: son aquellos que admiten dos o más resultados

posibles, y si bien estos resultados se conocen, no puede predecirse con

exactitud Entonces nos preguntamos cuál de ellos va a ocurrir, aún

teniendo en cuenta que pueden repetirse bajo condiciones (casi) idénticas

indefinidamente.

En este contexto nos centraremos en los aleatorios. Es decir,

cualquier acción o proceso cuyo resultado esté sujeto a la incertidumbre;

también se puede decir que es un fenómeno que envuelve cualquier

elemento casual. Por lo tanto, experimentos que pueden ser de interés

incluyen lanzar al aire una moneda una vez o varias veces, seleccionar una

carta o cartas de un mazo, el tiempo de recorrido de la casa al trabajo en

una mañana particular, obtener tipos de sangre de un grupo de individuos

o medir las resistencias a la compresión de diferentes vigas de acero, etc.

Todo experimento tendrá su modelo probabilístico asociado, identificado

por la tríada (𝛺; 𝐴; 𝑃):

Espacio muestral Ω: es el conjunto de todos los posibles resultados

del experimento en cuestión. 𝛺 = {𝜔1 , 𝜔2 , … , 𝜔𝑖 } donde 𝜔𝑖 son

denominados elementos o puntos muestra.

Álgebra de eventos A: cualquier subconjunto A de Ω (A ⊂ Ω), que será

llamado EVENTO. Osea, es cualquier recopilación de resultados contenidos

en el espacio muestral Un evento es simple si consiste en exactamente un

resultado y compuesto si consiste en más de un resultado.

Probabilidad P: la probabilidad asociada a ese evento. De una manera

más formal, es un número que asocia a cada punto muestra (ω) su

probabilidad de ocurrencia, de manera que es posible encontrar P(A) de

cualquier subconjunto A ⊂ Ω. La probabilidad de un evento es la frecuencia

relativa con la que puede esperarse la ocurrencia de dicho evento. Como

resultado de un experimento que se realiza n veces.

𝑃(𝐴) =

𝑛ú𝑚𝑒𝑟𝑜 𝑑𝑒 𝑣𝑒𝑐𝑒𝑠 𝑞𝑢𝑒 𝑜𝑐𝑢𝑟𝑟𝑖ó 𝐴

𝑛(𝐴)

=

𝑛ú𝑚𝑒𝑟𝑜 𝑑𝑒 𝑒𝑛𝑠𝑎𝑦𝑜𝑠 (𝑟𝑒𝑠𝑢𝑙𝑡𝑎𝑑𝑜𝑠 𝑝𝑜𝑠𝑖𝑏𝑙𝑒𝑠 𝑑𝑒 𝛺)

𝑛

Propiedades de una probabilidad P(A):

1) Una probabilidad es siempre un valor numérico entre cero y uno

0 ≤ 𝑐𝑎𝑑𝑎 𝑃(𝐴) ≤ 1

Notas acerca de la propiedad 1:

i) La probabilidad es 0 si el evento no puede ocurrir.

ii) La probabilidad es 1 si el evento ocurre todas las veces.

iii) De otro modo, la probabilidad es un número fraccionario entre 0

y 1.

2) La suma de las probabilidades de todos los resultados de un

espacio muestral es igual a exactamente uno.

∑

𝑃(𝐴) = 𝑃(𝛺) = 1

𝑡𝑜𝑑𝑜𝑠 𝑙𝑜𝑠 𝑟𝑒𝑠𝑢𝑙𝑡𝑎𝑑𝑜𝑠

3) Ley de números grandes: cuando aumenta el número de veces que

se repite un experimento, la razón entre el número de sucesos

exitosos y el número de intentos tenderá a aproximarse a la

probabilidad teórica del resultado de un intento individual. Esto

último significa que ante un gran número de ensayos, cada punto

muestral de un espacio muestral es igualmente probable que ocurra.

Lanzar un dado un número de veces muy grandes, a la larga

manifiesta una probabilidad de 1/6 para cada cara del mismo.

Algunas relaciones de la teoría de conjuntos:

Un evento A es simplemente un conjunto, así que las relaciones y

resultados de la teoría elemental de conjuntos pueden ser utilizados para

estudiar eventos. Se utilizarán las siguientes operaciones para crear

eventos nuevos a partir de eventos dados:

Complemento de un evento 𝐴̅: conjunto de todos los resultados del

espacio muestral que no pertenecen al evento A. Esto implica que:

𝑃(𝐴) + 𝑃(𝐴̅) = 1 → 𝑃(𝐴̅) = 1 − 𝑃(𝐴)

Muy útil cuando se pregunta por la probabilidad de obtener un

evento “al menos una vez”.

𝑷(𝒂𝒍 𝒎𝒆𝒏𝒐𝒔 𝒖𝒏𝒂 𝒐𝒄𝒖𝒓𝒓𝒆𝒏𝒄𝒊𝒂 𝒅𝒆𝒍 𝒆𝒗𝒆𝒏𝒕𝒐 𝑨)

= 𝟏 − 𝑷(𝒏𝒐 𝒉𝒂𝒚𝒂 𝒐𝒄𝒖𝒓𝒓𝒆𝒏𝒄𝒊𝒂𝒔 𝒅𝒆𝒍 𝒆𝒗𝒆𝒏𝒕𝒐 𝑨)

Teniendo en cuenta que dos eventos son mutuamente excluyentes (M.E)

si están definidos de tal manera que la ocurrencia de un evento imposibilita

la ocurrencia de otro. (En otras palabras, son eventos que no comparten

elementos comunes 𝐴ꓵ𝐵 = Ø):

La unión de dos eventos A y B, denotados por 𝐴ꓴ𝐵 y leídos “A o B”,

es el evento que consiste en todos los resultados que están en A o en

B o en ambos eventos.

𝑃(𝐴ꓴ𝐵) = 𝑃(𝐴) + 𝑃(𝐵) − 𝑃(𝐴𝑈𝐵) → 𝑟𝑒𝑔𝑙𝑎 𝑔𝑒𝑛𝑒𝑟𝑎𝑙 𝑑𝑒 𝑙𝑎 𝑠𝑢𝑚𝑎

𝑃(𝐴ꓴ𝐵) = 𝑃(𝐴) + 𝑃(𝐵) → 𝑠𝑖 𝑠𝑜𝑛 𝑀. 𝐸. 𝑅𝑒𝑔𝑙𝑎 𝑒𝑠𝑝𝑒𝑐𝑖𝑎𝑙 𝑑𝑒 𝑙𝑎 𝑠𝑢𝑚𝑎

La intersección de dos eventos A y B, denotada por 𝐴ꓵ𝐵 y leída “A y

B”, es el evento que consiste en todos los resultados que están tanto

en A como en B.

Probabilidad condicional de que un evento ocurrirá: es la frecuencia

relativa con la que puede esperarse que ocurra un evento bajo la

condición de que se conoce información adicional preexistente

acerca de algún otro evento. 𝑃(𝐴|𝐵) se usa para simbolizar la

probabilidad de que el evento A ocurre bajo la condición de que ya

se conoce la existencia del evento B.

𝑃(𝐴ꓵ𝐵)

𝑃(𝐴|𝐵) =

𝑃(𝐵)

Algunas formas de decir o expresar la probabilidad condicional,

𝑃(𝐴|𝐵), son:

La “probabilidad de A, dado B”

La “probabilidad de A, con B conocido”

La “probabilidad de que ocurra A, sabiendo que B ya ocurrió”

Eventos independientes: dos eventos son independientes si el

suceso (o no suceso) de uno de ellos no nos da información acerca de

la probabilidad de que ocurra el otro. En otras palabras, si la

probabilidad de A permanece sin cambio después que sepamos que

B ha ocurrido (o no ha ocurrido), los eventos son independientes.

𝑃(𝐴|𝐵) = 𝑃(𝐴) o 𝑃(𝐵|𝐴) = 𝑃(𝐵) eventos independientes

𝑃(𝐴|𝐵) ≠ 𝑃(𝐴) o 𝑃(𝐵|𝐴) ≠ 𝑃(𝐵) eventos dependientes

Así, la intersección se escribe en forma general:

𝑃(𝐴ꓵ𝐵) = 𝑃(𝐴). 𝑃(𝐵|𝐴) → 𝑟𝑒𝑔𝑙𝑎 𝑔𝑒𝑛𝑒𝑟𝑎𝑙 𝑑𝑒 𝑙𝑎 𝑚𝑢𝑙𝑡𝑖𝑝𝑙𝑖𝑐𝑎𝑐𝑖ó𝑛

Si A y B son independientes:

𝑃(𝐴ꓵ𝐵) = 𝑃(𝐴). 𝑃(𝐵|𝐴) = 𝑃(𝐴). 𝑃(𝐵) → 𝑟𝑒𝑔𝑙𝑎 𝑒𝑠𝑝𝑒𝑐𝑖𝑎𝑙 𝑑𝑒 𝑙𝑎 𝑚𝑢𝑙𝑡𝑖𝑝𝑙𝑖𝑐𝑎𝑐𝑖ó𝑛

Diagrama de árbol:

Muchos problemas de probabilidad pueden representarse por medio de

diagramas de árbol. En estos casos, las reglas de adición y multiplicación

pueden aplicarse con facilidad y es muy útil para tener presentes todas las

posibles combinaciones de las intersecciones y no olvidarse ninguna. Si en

un Bolillero hay 2-bolillas Blancas (B) y 3-bolillas Rojas (R y el experimento

es “Extraer 2 bolillas del Bolillero, sin reposición”

Teniendo esto, se puede construir el espacio muestral y calcular las

probabilidades de que ocurran cada elemento.

𝛺 = {𝐵𝐵, 𝐵𝑅, 𝑅𝐵, 𝑅𝑅}, aplicando la regla del producto se puede calcular

la probabilidad de que ocurra, por ejemplo, B y B:

1 2

2

4 5

20

𝑃(𝐵ꓵ𝐵) = 𝑃(𝐵|𝐵). 𝑃(𝐵) = . =

y así con todos.

Si es con reposición:

Lo mismo de arriba, se pueden definir el espacio muestral y calcular las

probabilidades.

Teorema de la Probabilidad Total y Teorema de Bayes

Teorema de la Probabilidad Total: Si particionamos el espacio

muestral en {𝐴1 , 𝐴2 , … , 𝐴𝑛 } tal que la suma de todos estos elementos da el

espacio muestral; y tomamos un evento cualquiera 𝐵 ⊂ 𝛺. Supongamos

que conocemos la probabilidad de que ocurra este evento para cada

partición, esto es 𝑃(𝐵|𝐴𝑖 ), y que la probabilidad de que ocurra una

partición es conocida, entonces:

𝑛

𝑛

𝑃(𝐵) = ∑ 𝑃(𝐵ꓵ𝐴𝑖 ) = ∑ 𝑃(𝐵|𝐴𝑖 ). 𝑃(𝐴𝑖 )

𝑖=1

𝑖=1

Teorema de Bayes: bajo las mismas condiciones anteriores se tiene:

𝑃(𝐴𝑖 |𝐵) =

𝑃(𝐵ꓵ𝐴𝑖 )

𝑃(𝐵|𝐴𝑖 ). 𝑃(𝐴𝑖 )

= 𝑛

∑𝑖=1 𝑃(𝐵|𝐴𝑖 ). 𝑃(𝐴𝑖 )

𝑃(𝐵)

Esto nos permite hallar las probabilidades de que una partición pueda

causar la ocurrencia de B. Por esta razón, con frecuencia se hace referencia

al teorema de Bayes como el teorema sobre la probabilidad de causas. A

partir de una probabilidad condicional, 𝑃(𝐵|𝐴𝑖 ), que es la que

generalmente da el problema, nos permite obtener una probabilidad

contraria, 𝑃(𝐴𝑖 |𝐵). El denominador de este teorema de Bayes es el dato

que se encuentra a partir de la probabilidad total. Por eso en los problemas

primero se pide utilizar el teorema de la probabilidad total y después se

pide utilizar Bayes.

Siempre que se aplique el teorema de la probabilidad total o el teorema de

Bayes, es importante hacer el esquema de los conjuntos involucrados. El

universo es el espacio muestral y las particiones son los puntos muestrales.

Lo que queremos averiguar es B, un evento que toma elementos de cada

partición. El teorema de Bayes nos podrá pedir “dado B, ¿qué probabilidad

hay de que B sea causado por A2?” por ejemplo.

TP4: Modelos Probabilísticos para Variables Aleatorias Discretas y

Continuas

Si a cada uno de los resultados de un experimento de probabilidad

se asigna un valor numérico, entonces a medida que se observan los

resultados del experimento se observan los valores de una variable

aleatoria. Este valor numérico es el valor de la variable aleatoria.

Variable aleatoria: es una variable que toma un valor numérico único para

cada uno de los resultados que aparecen en el espacio muestral de un

experimento de probabilidad.

En otras palabras, se utiliza una variable aleatoria para denotar los

resultados de un experimento de probabilidad. La variable aleatoria puede

tomar cualquier valor numérico que pertenezca al conjunto de todos los

posibles resultados del experimento. (Se denomina “aleatoria” porque el

valor que toma es el resultado de un evento de probabilidad, o aleatorio.)

En general se representará a las variables aleatorias (v.a.) con letras

mayúsculas: X; Y; Z; etc., y sus valores con letras minúsculas, es decir, x; y;

z, etc.

Las variables numéricas aleatorias se pueden subdividir en dos

clasificaciones: variables aleatorias discretas y variables aleatorias

continuas.

Variable discreta aleatoria: es una variable cuantitativa aleatoria que

puede tomar un número contable de valores.

Variable continua aleatoria: es una variable cuantitativa aleatoria que

puede tomar un número incontable de valores.

En los problemas siempre que se definan las variables, es importante

especificar el tamaño de la muestra porque ella condiciona los parámetros

de los modelos que vamos a usar. Si cambiamos el tamaño de la muestra,

cambiamos esos parámetros. De manera general, las variables se pueden

escribir:

“𝑐𝑎𝑛𝑡𝑖𝑑𝑎𝑑 𝑑𝑒” 𝑜 “𝑛ú𝑚𝑒𝑟𝑜 𝑑𝑒” 𝑋 𝐶𝑂𝑆𝐴 (𝑎𝑙𝑢𝑚𝑛𝑜𝑠, 𝑎𝑢𝑡𝑜𝑠, 𝑒𝑚𝑝𝑙𝑒𝑎𝑑𝑜𝑠, 𝑒𝑡𝑐. )

+ “𝑞𝑢𝑒” 𝑇𝐼𝐸𝑁𝐸𝑁 𝑇𝐴𝐿 𝐶𝐴𝑅𝐴𝐶𝑇𝐸𝑅Í𝑆𝑇𝐼𝐶𝐴

+ “𝑒𝑛𝑡𝑟𝑒” 𝑈𝑁 𝑉𝐴𝐿𝑂𝑅 𝐷𝐸 𝐿𝐴 𝑀𝑈𝐸𝑆𝑇𝑅𝐴

Por ejemplo: “número de bicicletas que son de color gris, entre 100,”

Distribución de probabilidad: es una distribución de probabilidades

asociada con cada uno de los valores de una variable aleatoria.(𝑝𝑖 = 𝑃(𝑋 =

𝑥𝑖 )

La relación entre la variable aleatoria y la distribución de probabilidad se

escribe en términos de una función de probabilidad: una regla que asigna

probabilidades a los valores de las variables aleatorias: (𝑥𝑖 , 𝑝𝑖 ). Una función

de probabilidad puede ser tan simple como una lista que empareje los

valores de una variable aleatoria con sus probabilidades. No obstante, una

función de probabilidad se expresa con más frecuencia como fórmula.

Se dice que una variable aleatoria X, de tipo discreto, estará bien definida

si se indican los posibles valores 𝑥1 ; 𝑥2 ; … ; 𝑥𝑘 que puede asumir y las

respectivas probabilidades 𝑝(𝑥1 ); 𝑝(𝑥2 ); … ; 𝑝(𝑥𝑘 ), o equivalentemente, si

conocemos su función de probabilidad (𝑥; 𝑝(𝑥)).

Toda función de probabilidad debe presentar las dos propiedades básicas

de probabilidad: (1) la probabilidad asignada a cada valor de la variable

aleatoria debe estar entre cero y uno, inclusive; y (2) la suma de todas las

probabilidades asignadas a cada valor de la variable aleatoria debe ser igual

a 1, es decir,

Propiedad 1 0 ≤ 𝑐𝑎𝑑𝑎 𝑃(𝑥) ≤ 1

Propiedad 2 ∑toda 𝑥 𝑃(𝑥) = 1

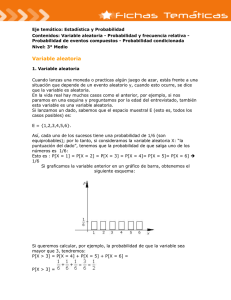

Las

funciones

de

probabilidad se pueden presentar

gráficamente. Cualquiera que sea

la

representación

gráfica

específica

que

se

utilice

(generalmente la de bastones y

para las acumuladas la escalonada

como la imagen de la derecha), los

valores de la variable aleatoria se

grafican en la escala horizontal, y

la probabilidad asociada con cada

valor de la variable aleatoria se grafica en la escala vertical.

Parámetros de población

Con una distribución de probabilidad tenemos una descripción de

una población teórica en vez de una muestra, por lo que los valores de la

media, la desviación estándar y la varianza no son datos estadísticos, sino

parámetros. En la teoría estadística, los parámetros son desconocidos, pero

en este contexto de teoría de probabilidades, estos parámetros son

conocidos y tienen que ver con la probabilidad de ocurrencia de cada uno

de los valores que toma la variable aleatoria. Así, usamos parámetros de

población (media, varianza y desviación estándar) para describir estas

distribuciones de probabilidad, igual que usábamos estadísticas muestrales

para describir muestras.

La media de una variable aleatoria discreta X frecuentemente se conoce

como su valor esperado o esperanza matemática, y es la suma de (cada x

multiplicada por su propia probabilidad): 𝐸(𝑋) = ∑ 𝑥. 𝑃(𝑥). E(X) es una

medida del centro de la distribución. En esta expresión, P(x) es equivalente

a la frecuencia relativa que aparecía en la definición de media aritmética

que vimos en la estadística descriptiva.

La varianza de una variable aleatoria discreta X se define en forma muy

semejante que la varianza de datos muestrales: multiplicando cada posible

valor de la desviación de la media al cuadrado, (𝑥 − 𝐸(𝑋))2 , por su propia

probabilidad y luego sumar todos los productos:

2

𝑉𝑎𝑟(𝑋) = ∑ (𝑥 − 𝐸(𝑋)) 𝑃(𝑥)

Con frecuencia no es conveniente usar la fórmula (5.2); puede

reformularse de las siguientes maneras:

𝑉𝑎𝑟(𝑋)

= 𝑠𝑢𝑚𝑎 𝑑𝑒 (𝑥 2 𝑝𝑜𝑟 𝑝𝑟𝑜𝑏𝑎𝑏𝑖𝑙𝑖𝑑𝑎𝑑)– [𝑠𝑢𝑚𝑎 𝑑𝑒 (𝑥 𝑝𝑜𝑟 𝑝𝑟𝑜𝑏𝑎𝑏𝑖𝑙𝑖𝑑𝑎𝑑)]2

2

𝑉𝑎𝑟(𝑋) = ∑[𝑥 2 𝑃(𝑥)] − [∑ 𝑥𝑃(𝑥)] = 𝐸(𝑋 2 ) − [𝐸(𝑋)]2

El Desvío Estándar de una variable aleatoria discreta X es 𝐷. 𝐸. (𝑋) =

√𝑉𝑎𝑟(𝑋), es decir, es la raíz cuadrada positiva de la varianza.

Propiedades de E(X) y Var(X):

Sean X e Y variables aleatorias y c una constante:

𝐸(𝑐) = 𝑐

𝐸(𝑐𝑋) = 𝑐𝐸(𝑋)

𝐸(𝑋 ± 𝑌) = 𝐸(𝑋) ± 𝐸(𝑌)

𝐸(𝑎𝑋 + 𝑏) = 𝑎𝐸(𝑋) + 𝐸(𝑏) = 𝑎𝐸(𝑋) + 𝑏

Si X e Y son V.A. independientes 𝐸(𝑋. 𝑌) = 𝐸(𝑋). 𝐸(𝑌)

𝑉𝑎𝑟(𝑐) = 0

𝑉𝑎𝑟(𝑐𝑋) = 𝑐 2 𝑉𝑎𝑟(𝑋)

Si X e Y son V.A. independientes 𝑉𝑎𝑟(𝑋 ± 𝑌) = 𝑉𝑎𝑟(𝑋) +

𝑉𝑎𝑟(𝑌)

Modelos Para variables Aleatorias Discretas

Dar una distribución para una variable aleatoria es lo mismo que

proponer un modelo probabilístico. De acá en más, 𝑋~𝑌(𝑎) se lee “X tiene

una distribución Y de parámetro 𝑎”. Cada modelo tiene asociado ciertos

parámetros que definen la forma que va a tener un modelo. Si conocemos

los parámetros, conocemos el modelo que vamos usar y sabemos los

valores que va a asumir la variable que vamos a estudiar con este modelo,

podemos calcular las probabilidades asociadas a cada uno de esos valores.

En cada modelo nos interesan tres cosas: cuáles son los valores que

la variable toma; la probabilidad con que toma esos valores; y la Esperanza

y la Varianza.

Para Variables Cuantitativas Discretas:

Los primeros dos modelos que presentamos son de menor

relevancia, mientras que el tercero y el cuarto son muy importantes, son los

que estudiamos en la práctica. Estos últimos dos se desprenden del

segundo.

1) Una variable aleatoria discreta X, que asume los valores

𝑥1 ; 𝑥2 ; … ; 𝑥𝑘 tiene Distribución Uniforme si la probabilidad con que la

variable toma esos valores es la misma e igual a 1/k, cualquiera sea el valor

que toma, esto es:

𝑃(𝑋 = 𝑥𝑖 ) =

1

∀𝑖 = 1,2, … . , 𝑘

𝑘

k es la cantidad de datos que se tienen. Dos ejemplos son: el lanzamiento

de una moneda cuya probabilidad de ocurrencia de la cara, primer

resultado posible, y la cruz, segundo resultado posible, es 1/2 en ambos

casos; el lanzamiento de un dado, misma lógica, la probabilidad de que

salga cada cara del dado es 1/6.

1

Notación: 𝑋~𝑢 ( )

𝑘

Propiedades:

1

𝐸(𝑋) = ∑ 𝑥 la esperanza es la media aritmética del TP1 porque la

𝑘

probabilidad de ocurrencia es la misma para todos los valores. Entonces se

transforma en la media que ya conocíamos.

1

𝑉𝑎𝑟(𝑋) = {∑[𝑥 2 ] −

𝑘

[∑ 𝑥]2

𝑘

} = 𝐸(𝑋 2 ) − [𝐸(𝑋)]2

2) En el Modelo Bernoulli un experimento se realiza por única vez y consiste

en observar o no una determinada característica. Es decir, se tienen dos

resultados posibles donde uno se considera el éxito y el otro el fracaso.

Una variable aleatoria X que asume apenas los valores “1” y “0” con:

1 = ÉXITO con probabilidad 𝑃(𝑋 = 1) = 𝑝

0 = FRACASO con probabilidad 𝑃(𝑋 = 0) = 1 − 𝑝 = 𝑞 se dice tiene

Distribución Bernoulli de parámetro p.

Una variable aleatoria discreta Bernoulli cuenta el número de éxitos cuando

se realiza un ensayo que contiene dos posibles resultados.

Por ejemplo: Una jeringa se elige al azar de un lote de 500, resulta

defectuosa o no defectuosa. Una persona es elegida al azar de entre 1000,

resulta de sexo femenino o masculino. Una persona es elegida al azar de

entre los habitantes de una ciudad y se le pregunta si está a favor o en

contra de un proyecto municipal.

Notación: 𝑋~𝐵𝑒𝑟(𝑝)

Propiedades

𝐸(𝑋) = 1(𝑝) + 0(1 − 𝑝) = 𝑝

𝑉𝑎𝑟(𝑋) = [12 · 𝑝 + 02 · (1 − 𝑝)] − 𝑝2 = 𝑝 − 𝑝2 = 𝑝(1 − 𝑝) = 𝑝 · 𝑞

3) El Modelo Binomial es realizar la experiencia Bernoulli más de una vez,

pero un número finito de ensayos.

Supongamos que repetimos un ensayo Bernoulli n-veces, o en otras

palabras, obtenemos una muestra aleatoria de tamaño n de una

Distribución Bernoulli. Supongamos, además, que las repeticiones sean

independientes, esto es, el resultado de un ensayo no tiene ninguna

influencia en el resultado de cualquier otro ensayo. Por lo tanto, una

muestra estará constituida por una secuencia de ÉXITOS y FRACASOS, o si

preferimos de 0 y 1.

Así, una variable aleatoria X definida por “número de éxitos en n-ensayos

Bernoulli independientes” se dice tiene Distribución Binomial de

parámetros n y p si su función de probabilidad está dada por:

𝑛

𝑃(𝑋 = 𝑘) = ( ) 𝑝𝑘 (1 − 𝑝)𝑛−𝑘 , 𝑘 = 0,1,2, … , 𝑛

𝑘

Los ejemplos de tales experimentos son lanzamientos de monedas,

respuestas de examen correcto/equivocado y otros experimentos más

prácticos, como determinar si un producto hace o no su labor prescrita y si

un candidato es electo o no. Hay experimentos en los que los ensayos

tienen muchos resultados que, bajo las condiciones adecuadas, pueden

caber en esta descripción general de ser clasificados en éxito o fracaso. Por

ejemplo, cuando tiramos un solo dado, por lo general consideramos seis

posibles resultados. No obstante, si estamos interesados sólo en saber si

aparece un “uno” o no aparece, hay realmente sólo dos resultados: aparece

el “uno” o aparece “algo más”.

Notación: 𝑋~𝐵𝑖(𝑛; 𝑝), n es el número de repeticiones del ensayo

Bernoulli y p la probabilidad del éxito; la distribución Bernoulli es el

caso especial 𝑋~𝐵𝑖(1; 𝑝).

Una variable aleatoria 𝑋 ∼ 𝐵𝑖(𝑛; 𝑝) puede asumir (𝑛 + 1) posibles

valores, esto es, tener (𝑛 + 1) posibles éxitos (contando el cero que sería

tener 0 éxitos). el recorrido de X es 𝑅𝑋 = {0, 1, 2, … , 𝑛}. Por ejemplo, si se

hace una encuesta a tres ciudadanos acerca de si votarían a un candidato

político y las respuestas son 0 = NO y 1 = SÍ; los valores que toma la variable

X son; 0 (los tres respondieron que no), 1 (uno respondió que sí y dos que

no), 2(dos respondieron que sí y uno que no), y 3 (los tres respondieron que

sí). En este ejemplo 𝑋 = {0,1,2,3}. Así, los valores que asume la variable

serían (3 + 1).

Propiedades

𝐸(𝑋) = 𝑛𝑝

𝑉𝑎𝑟(𝑋) = 𝑛𝑝𝑞

𝑐𝑜𝑛 𝑞 = 1 − 𝑝

4) El Modelo Poisson es realizar la experiencia Bernoulli más de una vez,

pero un número de ensayos desconocido o muy grande que se puede

considerar infinito; y también cuando p es pequeño de manera que 𝑞 = 1 −

𝑝 es cercano a 1. Por ello proporciona un modelo para la frecuencia relativa

del número de “eventos raros o poco comunes” que ocurren en un intervalo

de tiempo o espacio (o cualquier otra unidad de medida dada).

Una variable aleatoria X definida “número de éxitos en un número grande

(no definido) de ensayos Bernoulli independientes” se dice tiene

Distribución de Poisson de parámetro λ si su función de probabilidad está

dada por:

𝑒 −𝜆 𝜆𝑘

𝑃(𝑋 = 𝑘) =

𝑘!

𝑝𝑎𝑟𝑎 𝑘 = 0,1,2,3, …

Donde λ es un número promedio de éxitos en un intervalo de tiempo. Esto

es porque k va hasta un valor de n tan grande que no se puede fijar, se

utiliza un número promedio de éxitos. Por ello en los problemas aparece

como “x cantidad de aviones por hora” o “y cantidad de empleados que

trabajan en cuarenta minutos” … si cambia la unidad temporal, cambia el

parámetro λ. Esto es importante: en los problemas con modelos Poisson

la distribución estará acotada a una unidad de estudio, sea esta

especialmente temporal. En la práctica se considera un evento raro si el

número de ensayos es por lo menos 50(𝑛 ≥ 50) y 𝑛𝑝 es menor a 5. En tales

casos la distribución binomial puede aproximarse muy bien mediante la

distribución de Poisson con 𝜆 = 𝑛𝑝.

Ejemplos: número de accidentes por mes en una planta fabril; número de

clientes que llegan a un banco en un cuarto de hora; número de bacterias

en un cultivo dado; número de partículas emitidas por una fuente

radioactiva; número de llamadas telefónicas que ingresan a una central

telefónica de un edificio público por hora; número de accidentes

informados, por día, a una compañía de seguros

Notación: 𝑋~𝑃(𝜆)

Propiedades

𝐸(𝑋) = 𝑉𝑎𝑟(𝑋) = 𝜆

Para Variables Cuantitativas continuas:

Cuando consideramos una variable cuantitativa continua, existen ∞

valores que puede tomar X, y por ende la probabilidad de que tome un valor

exacto siempre es cero.

Ahora tendremos una función f(x), llamada Función de densidad de

probabilidad, cuya área bajo la curva en un intervalo de dos puntos da la

probabilidad 𝑃(𝑎 ≤ 𝑥 ≤ 𝑏) de que la variable aleatoria tome valores entre

𝑏

esos dos puntos. 𝑃(𝑎 ≤ 𝑥 ≤ 𝑏) = ∫𝑎 𝑓(𝑥)𝑑𝑥. Teóricamente, cualquier

función f(•) que sea no negativa y cuyo área total bajo una curva sea igual

a la unidad, caracteriza una variable aleatoria continua y le define un

Modelo Probabilístico. Un general, un modelo probabilístico para una

variable aleatoria continua quedará definido cuando se conozca el Dominio

de la variable (por lo general, R) y una función de densidad de probabilidad.

Propiedades de una función de densidad de probabilidad (válido para

cualquier modelo de variable cuantitativa continua)

∞

𝐸(𝑋) = ∫−∞ 𝑥𝑓(𝑥)𝑑𝑥

∞

𝑉𝑎𝑟(𝑋) = ∫−∞[𝑥 − 𝐸(𝑋)]2 𝑓(𝑥)𝑑𝑥

0 ≤ 𝑓(𝑥) ≤ 1, ∀𝑥

𝑓(𝑥) es una función no decreciente

lim 𝑓(𝑥)𝑥→−∞ = 0

lim 𝑓(𝑥)𝑥→∞ = 1

𝑃(𝑎 ≤ 𝑋 ≤ 𝑏) = 𝐹(𝑏) − 𝐹(𝑎)

𝑃(𝑎 ≤ 𝑋 ≤ 𝑏) = 𝑃(𝑎 < 𝑋 ≤ 𝑏) = 𝑃(𝑎 ≤ 𝑋 < 𝑏) = 𝑃(𝑎 < 𝑋 < 𝑏)

1) La distribución de probabilidad normal emplea dos funciones: una

función para determinar las ordenadas (valores y) de la gráfica que

representa la distribución y una segunda para determinar las

probabilidades. La fórmula 𝑦 = 𝑓(𝑥) =

1 𝑥−𝜇

− (

)

𝑒 2 𝜎

𝜎 √2𝜋

expresa la ordenada (valor

y) que corresponde a cada abscisa (valor x). Cuando se traza una gráfica de

todos estos puntos, la curva normal (en forma de campana) aparecerá

como:

Los parámetros en una normal son μ y σ; tal que −∞ < 𝜇 < ∞, 𝜎 2 >

0.

Nota: cada par diferente de valores para la media, μ, y desviación

estándar, σ, resultarán en una función diferente de distribución de

probabilidad normal.

La siguiente fórmula da la probabilidad asociada con el intervalo de

𝑥 = 𝑎 a 𝑥 = 𝑏:

𝑏

𝑃(𝑎 ≤ 𝑥 ≤ 𝑏) = ∫ 𝑓(𝑥) 𝑑𝑥

𝑎

La probabilidad de que x se encuentre dentro del intervalo de 𝑥 = 𝑎

a 𝑥 = 𝑏 se muestra como el área sombreada en la figura de abajo:

La función de densidad de probabilidad normal se nota 𝑋~𝑁(𝜇; 𝜎 2 )

y tiene las siguientes propiedades:

𝐸(𝑋) = 𝜇

𝑉𝑎𝑟(𝑋) = 𝜎 2

Las figuras a seguir muestran la función de densidad normal

según varía µ para σ fijo; y para σ variando (µ fijo):

𝐹(𝑥) → 0 cuando 𝑥 → ±∞

(𝜇 − 𝜎) y (𝜇 + 𝜎) son puntos de inflexión de 𝑓(𝑥)

𝑥 = 𝜇 es el punto máximo de 𝑓(𝑥) y el valor máximo es

1

√2𝜋𝜎

𝑓(𝑥) es simétrica en torno de μ, esto es, 𝑓(𝑥 + 𝜇) = 𝑓(𝑥 − 𝜇),

para todos −∞ < 𝑥 < ∞

Media = Moda = Mediana

Si µ = 0 y 𝜎 = 1 =⇒ 𝑋 ∼ 𝑁(0, 1) se denomina Distribución

Normal Estándar y esta distribución se encuentra tabulada

𝑋−µ

Si 𝑋 ∼ 𝑁(µ, 𝜎 2 ) =⇒ 𝑍 =

∼ 𝑁(0, 1).

𝜎

Siempre es posible calcular 𝑃(𝑎 < 𝑋 < 𝑏) a partir de la

estandarización de la variable aleatoria, esto es:

𝑎−𝜇

𝑋−𝜇

𝐵−𝜇

𝑃(𝑎 < 𝑋 < 𝑏) = 𝑃 (

<𝑍=

<

)

𝜎

𝜎

𝜎

Las primeras dos fórmulas anteriores que vimos no se usarán para

calcular probabilidades de distribuciones normales. La integral definida que

aparece arriba pertenece al campo del cálculo y su alcance matemático está

fuera de lo que se espera en estadística elemental (estas fórmulas aparecen

con frecuencia como identificación en la parte superior de tablas de

probabilidad normal.) En lugar de ello, usaremos una tabla para hallar

probabilidades para distribuciones normales. Las dos fórmulas se usaron

para generar esa tabla. Antes que aprendamos a usarla, sin embargo, debe

señalarse que la tabla está expresada en forma “estandarizada” de modo

que esta tabla pueda usarse para hallar probabilidades para todas las

combinaciones de valores de la media, μ, y desviación estándar, σ.

Propiedades de la distribución normal estándar:

1. El área total bajo la curva normal es igual a 1.

2. La distribución tiene forma de campana y es simétrica; se extiende

indefinidamente en ambas direcciones, aproximándose, pero sin tocar el

eje horizontal.

3. La distribución tiene una media de 0 y una desviación estándar de 1.

4. La media divide el área en dos: 0.50 a cada lado.

5. Casi toda el área está entre z = –3.00 y z = 3.00.

Las tablas del apéndice son una lista de las probabilidades asociadas con los

intervalos desde la media (ubicada en z = 0.00) hasta un valor específico de

z. Las probabilidades de otros intervalos pueden hallarse usando las

entradas de tabla y las operaciones de adición y sustracción, de acuerdo

con las propiedades precedentes.

Para trabajar en R Commander hay que tener en cuenta que el programa

da las probabilidades acumuladas, por encima de un valor hasta infinito, o

por debajo del mismo hasta menos infinito.

2) Una variable aleatoria continua X, definida en R +, tiene Distribución

Exponencial de parámetro λ, (𝜆 > 0), si su función de densidad de

probabilidad está dada por:

−𝜆𝑥

𝑓(𝑥) = {𝜆𝑒 𝑠𝑖 𝑥 ≥ 0

0 𝑠𝑖 𝑥 < 0

Notación: 𝑋 ∼ 𝜀(𝜆). La gráfica de la función de densidad de probabilidad de

una 𝑋 ∼ 𝜀(𝜆) es:

Propiedades

1

𝐸(𝑋) =

Var(X)=

𝜆

1

𝜆2

La distribución exponencial no tiene memoria. Esto es, si 𝑋 ∼ 𝜀(𝜆),

se verifica: 𝑃(𝑋 ≥ 𝑥 + 𝑦|𝑋 ≥ 𝑥) = 𝑃(𝑋 ≥ 𝑦). La distribución

exponencial es la única distribución absolutamente continua que

satisface esta propiedad.

Ejemplos: Las siguientes variables pueden modelarse a partir de una

exponencial:

1. “Tiempo que transcurre en un centro de llamadas hasta recibir la primera

llamada del día”;

2. “Intervalo de tiempo entre terremotos (de una determinada magnitud)”;

3. “La cantidad de metros de alambre que produce una máquina hasta

encontrar una falla en el alambre´´.

4. En Hidrología la distribución exponencial se utiliza para describir los

“tiempos de interarribo de choques aleatorios a sistemas hidrológicos”,

tales como volúmenes de escorrentía contaminada que entran en los ríos a

medida que la lluvia lava los contaminantes localizados en la superficie del

terreno.

3) Una variable aleatoria continua X tiene Distribución Uniforme con

parámetros 𝑎 y 𝑏 (𝑎 < 𝑏) si su función de densidad de probabilidad está

dada por:

1

𝑓(𝑥) = {(𝑏 − 𝑎) 𝑠𝑖 𝑎 ≤ 𝑥 ≤ 𝑏

0 𝑐𝑎𝑠𝑜 𝑐𝑜𝑛𝑡𝑟𝑎𝑟𝑖𝑜

Notación: 𝑋 ∼ 𝑈(𝑎, 𝑏). La gráfica de la función de densidad de probabilidad

de una variable 𝑋 ∼ 𝑈(𝑎, 𝑏) es:

Propiedades

(𝑎+𝑏)

𝐸(𝑋) =

𝑉𝑎𝑟(𝑋) =

2

(𝑏−𝑎)2

12

0

(𝑥−𝑎)

𝑃(𝑋 ≤ 𝑥) = { (𝑏−𝑎)

1

𝑠𝑖 𝑥 < 𝑎

𝑠𝑖 𝑎 ≤ 𝑥 < 𝑏

𝑠𝑖 𝑥 ≥ 𝑏

TP5: Distribuciones Muestrales

Partimos de una población que generalmente no podemos abarcar

en su totalidad porque tiene gran cantidad de individuos o elementos, y que

está identificada por una media y una varianza. Lo que hicimos en la primera

parte de este curso era tomar, de esa población, una muestra y trabajar

haciendo un análisis exploratorio, siempre de esa muestra, calculando los

estadísticos muestrales: medias, desvíos, medianas, etc. Además, podíamos

resumir la información en gráficos y mostrarla en tablas de distribución de

frecuencias. Ahora supongamos que de una población obtenemos más de

una muestra y que de ellas calculamos las medias, tendríamos un conjunto

de medias muestrales. Ahora tendremos una nueva variable, distribución

de medias muestrales 𝑋̅, conformada por las medias muestrales de la

población {𝑥̅1 ; 𝑥̅2 ; … ; 𝑥̅𝑛 }. Si calculamos la media o esperanza de 𝑋̅,

obtendremos una media que identifica a toda la población. Cuando el

número N de muestras obtenidas se aproxima a infinito, el valor de la media

de 𝑋̅ se aproxima a 𝜇, la media poblacional, y el valor de la varianza de 𝑋̅ se

aproxima a

𝜎2

𝑛

, haciéndose más pequeña conforme aumenta n, el tamaño

de cada una de las N muestras tomadas (osea n es el número de elementos

que tiene cada muestra y N es el número de muestras). Además, el patrón

de comportamiento o distribución muestral de 𝑋̅ tendrá forma de campana

de Gauss. Resumiendo:

Siendo 𝑋̅ = 𝑁 𝑚𝑒𝑑𝑖𝑎𝑠 𝑚𝑢𝑒𝑠𝑡𝑟𝑎𝑙𝑒𝑠 𝑑𝑒 𝑢𝑛𝑎 𝑝𝑜𝑏𝑙𝑎𝑐𝑖ó𝑛. Si 𝑁 → ∞,

entonces:

2

𝜎

𝑋̅~𝑁 (𝜇; ) siendo n el tamaño de cada una de las N muestras

𝑛

En relación a

𝜎2

𝑛

, decimos que siempre la varianza resulta afectada por

el tamaño de la muestra porque si se tienen gran cantidad de datos, como

cuando N tiende a infinito, es más fácil que esa dispersión o heterogeneidad

que estos presentan sea menor y empiece a haber una concentración de

datos en torno a un valor medio. Esto es lo característico de una campana

de Guass. Es por eso que en ese caso, la varianza comienza a disminuir. Por

el contrario, cuando se tienen pocos datos, lo más probable es que estos

reflejen una gran variabilidad y, en tal caso, la varianza será más grade. Por

eso la varianza siempre resulta afectada por el tamaño de cada muestra n.

TP6: INTRODUCCIÓN A LA INFERENCIA ESTADISTICA -Estimación

Puntual y por Intervalos de Confianza

En la primera parte de este curso, hemos visto: ¿cómo resumir

descriptivamente un conjunto de datos?

En la segunda parte, vimos ¿cómo construir Modelos Probabilísticos

para describir un fenómeno o experimento de interés? Ahora, vamos a

REUNIR esos dos tópicos para estudiar una rama muy importante de la

estadística conocida como INFERENCIA ESTADÍSTICA lo cuál implica hacer

afirmaciones sobre características de una población basándonos en las

observaciones de la muestra.

Como recordarás, el teorema central del límite te da cierta

información muy importante acerca de la distribución de medias

muestrales. Específicamente, afirma que en muchos casos (cuando la

muestra aleatoria es suficientemente grande), una distribución de medias

muestrales tiene una distribución normal o aproximadamente normal en

torno a la media de la población. Con esta información es posible hacer

enunciados de probabilidad acerca de la posibilidad de que ocurran ciertos

valores de medias muestrales cuando las muestras se extraen de una

población con una media conocida y una desviación estándar conocida.

Ahora estamos listo para dar un giro a esta situación hacia el caso donde la

media poblacional no es conocida. Extraeremos una muestra, calcularemos

su valor medio y luego haremos una inferencia acerca del valor de la media

poblacional con base en el valor de la media muestral.