MINIMOS

CUADRADOS EN

GENERAL

INTERGRANTES

- Choque luna, Luis

- Huarca Taco, Daniel

- Choque Quispe, Rolando

- Llaeque Libandro, Carlos

- Zapata Valcarcel Pablo

FORMULACIÓN GENERAL DE UNA MATRIZ PARA

MÍNIMOS CUADRADOS LINEALES

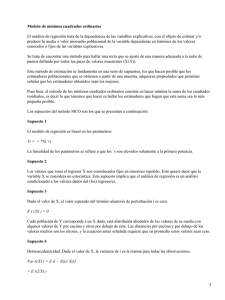

• Se presento tres tipos de regresión: lineal simple, polinomial y lineal múltiple.

De hecho, las tres pertenecen al siguiente modelo lineal general de mínimos

cuadrados:

• donde z0, z1, … , zm son m + 1 funciones diferentes. Se observa con

facilidad cómo la regresión lineal simple y múltiple se encuentran dentro de

este modelo; es decir, z0 = 1, z1 = x1, z2 = x2, …, zm = xm. Además, la

regresión polinomial se incluye también si las z son monomios simples como

z0 = x0 = 1, z1 = x, z2 = x2,…, zm = xm.

•

Mientras tanto, la ecuación se expresa en notación matricial como

•

donde [Z] es una matriz de los valores calculados de las funciones z en los valores

medidos de las variables independientes

•

donde m es el número de variables en el modelo y n es el número de datos. Como n > m+

1, usted reconocerá que, la mayoría de las veces, [Z] no es una matriz cuadrada.

•

El vector columna {Y} contiene los valores observados de la variable dependiente

•

El vector columna {A} contiene los coeficientes desconocidos

•

y el vector columna {E} contiene los residuos

•

Como se dio a lo largo de este capítulo, la suma de los cuadrados de los residuos en este

modelo se definen como

• Esta cantidad se minimiza tomando las derivadas parciales con respecto a

cada uno de los coeficientes e igualando a cero la ecuación resultante. El

resultado de este proceso son las ecuaciones normales, que se expresan en

forma matricial como

TECNICAS DE

SOLUCION

DESCOMPOSICIÓN LU

• Si usted está interesado sólo en aplicar un ajuste por mínimos

cuadrados en un caso donde el modelo adecuado se conoce de

antemano, cualquiera de los procedimientos de descomposición

LU, son perfectamente aceptables. De hecho, también es

posible emplear la formulación de la descomposición LU de la

eliminación de Gauss. Ésta es una tarea de programación

relativamente sencilla para incorporar cualquiera de estos

procedimientos en un algoritmo de mínimos cuadrados lineales.

En realidad, si se ha seguido un enfoque modular, esto resulta

casi trivial.

MÉTODO DE CHOLESKY

• El algoritmo de descomposición de Cholesky tiene varias ventajas para la

solución del problema general de regresión lineal. Primero, está expresamente

diseñado para resolver matrices simétricas como las ecuaciones normales. Así

que es rápido y se requiere de menos espacio de almacenamiento para

resolver tales sistemas. Segundo, es ideal en casos donde el grado del modelo

[es decir, el valor de m en la ecuación (17.23)] no se conoce de antemano.

Uno de estos casos sería la regresión polinomial. En ella, no podemos saber a

priori si un polinomio lineal, cuadrático, cúbico o de grado superior es el

“mejor” modelo para describir nuestros datos. Debido tanto a la forma en la

que se construyen las ecuaciones normales como a la manera en la que se

lleva a cabo el algoritmo de Cholesky , podemos desarrollar modelos

sucesivos de grado superior de manera muy eficiente. En cada paso es

factible examinar la suma residual de los cuadrados del error (¡y una gráfica!),

para examinar si la inclusión de términos de grado superior mejora el ajuste de

manera significativa.

• En la regresión lineal múltiple la situación análoga se presenta cuando se

agregan, una por una, variables independientes al modelo. Suponga que la

variable dependiente de interés es función de varias variables

independientes; por ejemplo, temperatura, contenido de humedad, presión,

etc. Primero realizaríamos una regresión lineal con la temperatura y

calcularíamos un error residual. En seguida, se podría incluir el contenido de

humedad para llevar a cabo una regresión múltiple de dos variables y

observar si la variable adicional resulta en una mejora del ajuste. El método

de Cholesky vuelve eficiente el proceso, ya que la descomposición del

modelo lineal tan sólo se completará al incorporar una nueva variable.

MÉTODO DE LA MATRIZ INVERSA

•

De la ecuación

•

Despejamos “A”

•

Este es un método ineficiente para resolver un conjunto de ecuaciones simultáneas. Así,

si estuviéramos solamente interesados en determinar los coeficientes de regresión, sería

preferible utilizar el método de descomposición LU sin inversión. No obstante, desde una

perspectiva estadística, existen varias razones por las cuales estaríamos interesados en

obtener la inversa y examinar sus coeficientes

ASPECTOS ESTADÍSTICOS DE LA TEORÍA DE

MÍNIMOS CUADRADOS

•

La ecuación

•

proporciona estimaciones de sus estadísticos. Es posible demostrar (Draper y Smith,

1981) que los términos en la diagonal y fuera de la diagonal de la matriz [[Z]T [Z]]–1 dan,

respectivamente, las varianzas y las covarianzas1 de las a. Si los elementos de la

diagonal de [[Z]T [Z]]–1 se designa por z–1 i,i, entonces

• Se demuestra que los límites inferior y superior para la intersección con el

eje y se pueden encontrar de la siguiente manera:

• donde s(aj) = el error estándar del coeficiente aj = var(aj). De manera

similar, los límites inferior y superior para la pendiente se calculan:

EJEMPLO

•

Se realizo la regresión lineal

•

Donde y = las predicciones del modelo y x = las mediciones. Concluimos que había una

buena concordancia entre las dos, puesto que la intersección con el eje y era

aproximadamente igual a 0, y la pendiente aproximadamente igual a 1. Vuelva a calcular

la regresión, pero ahora use el método matricial para estimar los errores estándar de los

parámetros. Después emplee tales errores para desarrollar los intervalos de confianza y

úselos para realizar un planteamiento probabilístico respecto a la bondad del ajuste

SOLUCIÓN DE MANERA MATRICIAL

•

Los datos se escriben en forma matricial para una regresión lineal simple de la siguiente

manera:

OBTENCIÓN DE LA MATRIZ 𝑍

•

Utilizando la ecuación de la recta expresada como:

•

Datos utilizado de la tabla 17.2

•

(X1 , Y1) = ( 10, 8.953)

•

(X2 , Y2) = ( 16.3, 16.405)

•

.

•

.

•

.

•

(X15 , Y15) = ( 50, 49.988)

b+

10m = 8.953

b + 16.3m = 16.405

b + 50m = 49.988

•

Luego se formula la matriz,

•

de los coeficientes de las variables en las ecuaciones obtenidas:

•

Formula:

•

Reformulamos la formula por el método de la matriz inversa:

•

Reemplazando se obtiene:

•

Después se usan la transposición y la multiplicación matriciales para generar las

ecuaciones normales:

•

Se emplea la inversión matricial para obtener la pendiente y la intersección con el eje y

•

De esta manera, la intersección con el eje y y la pendiente quedan como a0 = –0.85872 y

a1 = 1.031592, respectivamente. Estos valores, a su vez, sirven para calcular el error

estándar del estimado, sy/x = 0.863403. Este valor puede utilizarse, junto con los

elementos diagonales de la matriz inversa, para calcular los errores estándar de los

coeficientes,

•

El estadístico tα/2,n–1 necesario para un intervalo de confianza del 95% con n – 2 = 15 –

2 = 13 grados de libertad se obtiene con una tabla estadística o mediante software.

Usemos una función de Excel, TINV, para obtener el valor adecuado de la siguiente

manera:

•

que da un valor de 2.160368. Las ecuaciones (17.29) y (17.30) entonces se usan para

calcular los intervalos de confianza:

•

Entonces:

• Observe que los valores deseados (0 para la intersección, y 1

para la pendiente) caen dentro de los intervalos. Considerando

este análisis podremos formular las siguientes declaraciones

sobre la pendiente: tenemos fundamentos sólidos para creer

que la pendiente de la línea de regresión real está dentro del

intervalo de 0.991355 a 1.071828. Debido a que 1 está dentro

de este intervalo, también tenemos fundamentos sólidos para

creer que el resultado apoya la concordancia entre las

mediciones y el modelo. Como cero está dentro del intervalo de

la intersección, se puede hacer una declaración similar respecto

a la intersección.

SOLUCIÓN POR AJUSTE DE UNA LÍNEA RECTA

POR MÍNIMOS CUADRADOS

•

De la tabla anterior se obtiene los siguientes datos:

•

FORMULA:

•

RESULTADO:

GRAFICA

COMPARACIÓN POR AMBOS MÉTODOS

•

Resultados:

Manera matricial por el

método de la matriz inversa

Manera de ajustes de una línea

FIN