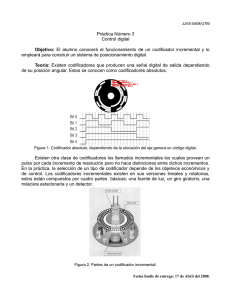

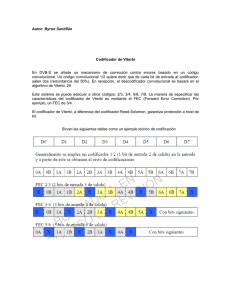

contribuciones al reconocimiento robusto de habla en redes de

Anuncio