Tema 1. Descripción estadística de una variable. 1.1. Unidades estadísticas. Definiciones.

Anuncio

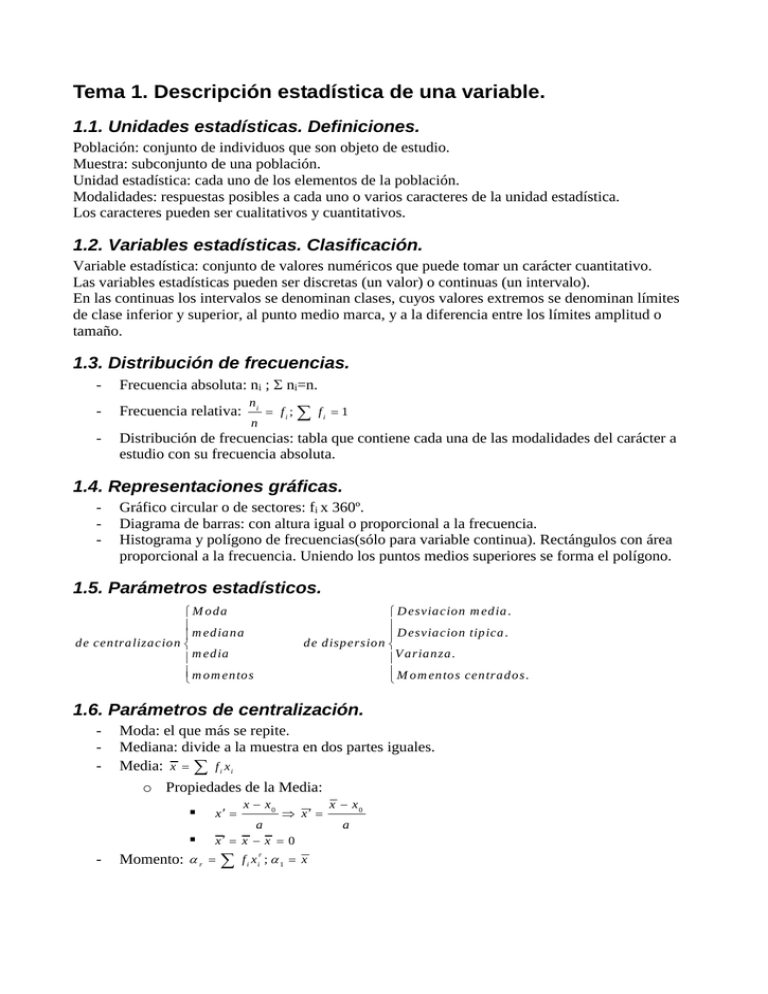

Tema 1. Descripción estadística de una variable. 1.1. Unidades estadísticas. Definiciones. Población: conjunto de individuos que son objeto de estudio. Muestra: subconjunto de una población. Unidad estadística: cada uno de los elementos de la población. Modalidades: respuestas posibles a cada uno o varios caracteres de la unidad estadística. Los caracteres pueden ser cualitativos y cuantitativos. 1.2. Variables estadísticas. Clasificación. Variable estadística: conjunto de valores numéricos que puede tomar un carácter cuantitativo. Las variables estadísticas pueden ser discretas (un valor) o continuas (un intervalo). En las continuas los intervalos se denominan clases, cuyos valores extremos se denominan límites de clase inferior y superior, al punto medio marca, y a la diferencia entre los límites amplitud o tamaño. 1.3. Distribución de frecuencias. - Frecuencia absoluta: ni ; ni=n. - Frecuencia relativa: - Distribución de frecuencias: tabla que contiene cada una de las modalidades del carácter a estudio con su frecuencia absoluta. ni fi ; fi 1 n 1.4. Representaciones gráficas. - Gráfico circular o de sectores: fi x 360º. Diagrama de barras: con altura igual o proporcional a la frecuencia. Histograma y polígono de frecuencias(sólo para variable continua). Rectángulos con área proporcional a la frecuencia. Uniendo los puntos medios superiores se forma el polígono. 1.5. Parámetros estadísticos. M oda m ediana de centralizacion m edia m om entos D esviacion m edia . D esviacion tipica . de dispersion V arianza . M om entos centrados . 1.6. Parámetros de centralización. - - Moda: el que más se repite. Mediana: divide a la muestra en dos partes iguales. Media: x f i x i o Propiedades de la Media: x x0 x a x x x 0 Momento: r x f i xi ; 1 x r x x0 a 1.7. Parámetros de dispersión. - Desviación Media (DM): D M ( x ) - Varianza (V): V ( x ) f i ( x i x ) o Propiedades de la varianza: f i xi x 2 si x x x0 V ( x) V ( x ) a a V ( x) 2 2 1 2 x - Desviación típica (s): s x V ( x ) - Momento (): r 2 r s x sx a 2 1 0; f i ( xi x ) ; ; 2 V ( x ). 1.8. Características de forma. - Coeficiente de asimetría: 1 - Coeficiente de curtosis: 2 3 s 4 s 4 3 3 Tema 2. Descripción estadística de varias variables. 2.1. Distribución de frecuencias multivariantes. Cada dato pueden tener dos o más valores relacionados entre sí. 2.2. Distribuciones marginales y condicionadas. - Marginales: el estudio de esa variable con independencia de las demás. - Condicionadas: y condicionada a x f ( y x ) f ( x, y ) f ( x) 2.3. Vector de medias. Se obtienen a partir de las distribuciones marginales calculando las medias respectivas. X1 X X2 X n 2.4. Matriz de varianzas y covarianzas. Covarianza: C ov ( X , Y ) (x i X )( y j Y ) n 2 sx Matriz de covarianzas: C C ov (Y , X ) C ov( X ,Y ) sx s y f ij ( x i X )( y j Y ) C ov ( X , Y ) 2 sy 2.5. Coeficiente de correlación. r Tema 3. Probabilidad. 3.1. Fenómenos aleatorios. Fenómenos en los que no se puede predecir el resultado. 3.2. Espacio muestral. Conjunto de todos los resultados posibles. Pueden ser de dos tipos: Discretos (finitos y numerables) y continuos. 3.3. Álgebra de sucesos aleatorios. - Suceso aleatorio: Subconjunto del espacio muestral (E). Suceso contrario: A Unión de sucesos: A B ; A or B Intersección de sucesos: A B ; A and B Incompatibles: A B Excluyentes: incompatibles dos a dos. Diferencia: A B A B Espacio probabilizable: al par formado por el espacio muestral (E) y el álgebra de sucesos (A): (E,A). Sistema exhaustivo de sucesos: si Ai E . Es completo si los sucesos son mutuamente excluyentes. 3.4. Frecuencia absoluta y relativa. Frecuencia absoluta: número de veces que se repite A: n A Frecuencia Relativa: número de veces que se repite A dividido por número de veces totales: nA f ( A) n Propiedades: - 0 f ( A ) 1; A A - Si A y B son incompatibles, f ( A B ) f ( A ) f ( B ) - f(E)=1. 3.5. Probabilidad. - - Axiomática de Kolmogorov: es probabilidad si: o P ( A ) 0, para cada A A o si Ai A j P ( An ) P ( An ) o P(E) = 1. Con las condiciones anteriores el espacio probabilizable se convierte en espacio probabilístico: (E,A,P). Propiedades derivadas: o P ( ) 0 o Si An son mutuamente excluyentes, P ( A1 A2 A3 ) P ( A1 ) P ( A2 ) P ( A3 ) o o P ( A ) 1 P ( A) o P ( An ) P ( A B ) P ( A) P ( B ) P ( A B ) P(A n ) P(A o si B A P ( B ) P ( A ) o P ( A) 1 i Aj) P(A i A j A k ) ... o - P ( A B ) P ( A) P ( B ) Definición de Laplace: P ( A ) casos favorables casos posibles - Definición de Von Mises: P ( A ) - Probabilidad subjetiva: asignar a un suceso una probabilidad que dependerá del grado de conocimiento de ese suceso. f ( A) lim n 3.7 Probabilidad en espacios muestrales finitos. Son la mayoría de los problemas que se suelen dar y se aplica la definición de Laplace Sin Reemp Con Reemp. V, P VR, PR Con Orden C CR Sin Orden 3.8. Análisis combinatorio. n! ; V R nk n k - Variaciones: V nk - Combinaciones: C nk - (n k )! n n! k k !( n k ) ! Vn k! k! Permutaciones: Pn n ! ; P R ak b c n k 1 ( n k 1) ! k k !( n 1) ! k ; ; C R nk abc k a !b ! c ! Tema 4. Probabilidad condicionada. Sucesos independientes. 4.1. Probabilidad condicionada. - P( A B) Probabilidad condicionada: P ( B A ) P ( A) - Teorema del producto: P ( A B ) P ( A ) P ( B A ) P ( B ) P ( A B ) 4.2. Teorema de la probabilidad total y de Bayes. - Teorema de la probabilidad total: P ( B ) - Teorema de Bayes: P ( Ai B ) P( A ) P(B i Ai ) P ( Ai ) P ( B A i ) P( A ) P(B i Ai ) 4.3. Sucesos independientes. Dos sucesos son independientes si : P ( A B ) P ( A ) P ( B ) Una familia de sucesos se dice totalmente independientes si: P ( A1 A2 ... An ) P ( Ai ) 4.4. Experimentos compuestos. Cuando se considera varios experimentos sucesivos: Experimentos independientes si: P ( Ai , B j ) P ( Ai ) P ( B j ) Experimentos dependientes si: P ( Ai , B j ) P ( Ai ) P ( B j Ai ) Tema 5. Variables aleatorias unidimensionales. 5.1. Variable aleatoria. Es cualquier aplicación X : E R , Tal que X 1 ( B ) A; B B . Puede ser discreta o continua. 5.2. Función de distribución. Propiedades. - Función de distribución: F ( x ) P ( X x ) . Función de masa o cuantía: P ( x ) P ( X x ) . Propiedades de la función de distribución: o Para todo a , b R , a b , P ( a X b ) F ( b ) F ( a ). o F es continua por la derecha en cada punto de R. o F es monótona decreciente. 5.3. Función de densidad. Se dice que f es una función de densidad si cumple las tres propiedades siguientes: f ( x) 0 x . - f tiene a lo sumo un número finito de discontinuidades. - f ( x ) dx 1 . Dada una V.A. X, con función de densidad f y función de distribución F definida por F ( x) x f ( x ) dx , se verifica que: - F es continua. Si f es continua, F es derivable y F’=f. - Para todo intervalo <ab> se cumple que: P ( X a , b ) b f ( t ) dt a . 5.4. Transformación de variables aleatorias. Sea X una variable aleatoria con F y f conocidas. Se define la variable aleatoria Y=Xa+b entonces: yb yb G ( y ) P (Y y ) P ( X a b y ) P X F a a g ( y ) G ( y ) yb 1 yb F f a a a a 1 Tema 6. Variables aleatorias n-dimensionales. 6.1. Variables aleatorias n-dimensionales. - Distribución de probabilidad conjunta. Dadas las v.a. discretas x1,x2...xn, la distribución de probabilidad conjunta X=(x1,x2,...xn) es una función f : n que verifica: o f ( x1, x 2, ... xn ) 0. o - ... f ( x1, x 2, ... xn ) 1 o P X ( x1, x 2, ... xn ) f ( x1, x 2, ... xn ) Función de densidad de la variable n-dimensional: Dadas las v.a. continuas x1,x2...xn, la función de densidad X=(x1,x2,...xn) es una función f : n que verifica: o f ( X ) 0. o ... f ( x1, x 2, ... xn ) dx1dx 2...dxn 1 o - P( X A) ... f ( x1, x 2, ... xn ) dx1dx 2...dxn Función de distribución conjunta:(F) de R2R o F ( X , Y ) P ( X x,Y y ) 6.2. Distribuciones marginales. - Variable aleatoria discreta: o f1 ( x ) f ( x , y ); f 2 ( y ) f ( x , y ); - Variable aleatoria continua: Y o - f1 ( x ) X f2 ( y) f ( x , y ) dy ; f ( x , y ) dx ; f1 y f2 son distribuciones de probabilidad. 6.3. Distribuciones condicionadas. f (x y) f ( x, y ) ; f ( y x) f2 ( y) f ( x, y ) f1 ( x ) 6.4. Variables independientes. f ( x , y ) f1 ( x ) f 2 ( y ) Tema 7. Características de las distribuciones de probabilidad unidimensionales. 7.1. Esperanza matemática. Propiedades. - Esperanza matemática: o - discreta : xf ( x ) x EX continua : xf ( x ) dx Propiedades: o E aX b aE X b o E g ( X ) h( X ) E g ( X ) E h( X ) o E X Y E X E Y 7.2. Varianza. Propiedades. - Varianza: o 2 - discreta : ( x ) 2 f ( x ) x 2 E ( X ) 2 continua : ( x ) f ( x ) dx Propiedades: o 2 E X 2 2 2 2 2 a X o aX b o la desviación típica es 7.3. Teorema de Marcov. Desigualdad de Tchebycheff. - Teorema de Marcov: - E g ( X ) Pg(X ) K o K Teorema de Tchebycheff: 1 P k X k 1 o k 2 7.4. Momentos. Asimetría. Apuntamiento. - Momentos: o No centrado: r E X r o Centrado: r E ( X ) r - Coeficiente de asimetría de Fisher: 1 - Coeficiente de apuntamiento, aplastamiento o curtosis: 2 3 3 si =0 es simétrica. 4 4 3 si =0 es distribución normal. Tema 8. Características de las distribuciones de probabilidad n-dimensionales. 8.1. Momentos. Valor medio. Varianza. - Valores medios: x k k 0 E X f1 ( x ) y f2 ( y) k X o h 0 h E Y h Y - momento no centrado: o kh E X k Y h - Momento centrado: o kh E ( X 10 ) k (Y 01 ) h - Propiedades: o 20 20 102 X2 o o k x f 1 ( x ) dx h y f 2 ( y ) dy 02 02 01 Y 2 2 11 11 10 01 8.2. Covarianza. Matriz de covarianzas. - Covarianza: 1 1 E ( X 1 0 )(Y 0 1 ) 1 1 1 0 0 1 - 20 11 11 02 Matriz de covarianzas: ( ) 8.3. Coeficiente de correlación. - r 11 20 02 8.4. Medidas condicionadas. - Valor medio de X condicionado por Y=y: o E X Y y xf ( x y) x xf ( x y ) dx o Propiedades: E E ( X Y ) E ( X ) - E E (Y X ) E (Y ) Varianza de X condicionada por Y = y: o 2 ( X Y y ) E ( X E ( X Y y )) 2 / Y y (x E(X Y y )) f ( x y ) 2 x 8.5. Varianza de variables independientes. aX b a x b y 2 ab 11 2 2 2 2 2 Si X e Y son variables aleatorias independientes entonces: a2X b a 2 x2 b 2 y2 8.6. Regresión lineal. Recta de mínimos cuadrados. - Recta de regresión de mínimos cuadrados de Y sobre X: o - 11 20 x 10 ; y 01 r Y x 10 X Recta de regresión de mínimos cuadrados de X sobre Y: o - y 01 x 10 11 02 y 01 ; y 01 Y r x 10 X Coeficientes de regresión: o De Y sobre X: YX o De X sobre Y: X Y 11 20 11 02 r Y X r X Y Tema 9. Función característica. Función generatriz. 9.1. Función Característica. Propiedades. - Función característica: ( t ) E e itX e X - itX f (x) e itX f ( x ) dx Propiedades: o (0) 1 o (t ) 1 - o (t ) ( t ) Si Y = aX + b: Y ( t ) e ita X ( bt ) - Función de densidad en función de la función característica: f ( x ) 1 2 e itx ( t ) dt d (t ) k - Derivada de la función característica: dt i k k k t0 Si X e Y son independientes: X Y ( t ) E e it ( x y ) E e itx e ity X ( t ) Y ( t ) 9.2. Función generatriz. - Función generatriz: g ( t ) E e tX e tX f (x) X - e tX f ( x ) dx Propiedades: o Si Y = X + a, entonces g Y ( t ) e at g X ( t ) o Si Y = aX, entonces g Y ( t ) g X ( at ) o Si Y = aX + b, entonces g Y ( t ) e bt g X ( at ) o Si X e Y son independientes entonces: g X Y ( t ) g X ( t ) g Y ( t ) - Función generatriz de momentos respecto de la media: g ( t ) E e t ( X ) 9.3. Cálculo de los momentos. k - d g (t ) Momento no centrado de orden k: k dt k t0 k - Momento centrado de orden k: k d g (t ) dt k t0 9.4. Semi-invariantes de Thiele. (Cumulantes). (t ) h 1 ( it ) h! h Kh K1 1 K 2 2 1 2 siendo K: 2 K 3 3 3 1 2 2 1 3 K 4 4 3 2 4 1 3 12 1 2 6 1 4 2 4 Tema 10. Operaciones con variables aleatorias. 10.1. Transformación de variables aleatorias. - Si Y = u(X) , X = v(Y) siendo u=v-1 entonces g ( y ) f v y - Si Y1=u1(X1,X2), Y2=u2(X1,X2), y X1=..., entonces g ( y1 , y 2 ) f v1 ( y1 , y 2 ), v 2 ( y1 , y 2 ) - Si z = u1(x,y) y t= u2(x,y) y x=v1(z,t) entonces g ( z , t ) f v1 ( z , t ), v 2 ( z , t ) J 1 Siendo J 1 x x z t y y z t 10.2. Suma de variables aleatorias. Sea la variable bidimensional (X,Y) con función de distribución f, se define la variable unidimensional Z= X + Y sin más que tomar z = x + y , t = x; por lo que la función de densidad conjunta es f(t,z-t) 10.3. Producto de variables aleatorias. z1 t t Si Z = XY basta con tomar z =xy, t=x siendo la función de densidad conjunta: f t , 10.4. Cociente de variables aleatorias. Si Z = X/Y basta con tomar z = x/y, t=y siendo la función de densidad conjunta: f ( tz , t ) t Tema 11. Distribuciones de probabilidad de variable discreta (I). 11.1. Distribución de Bernouilli. Be(1,p). - Función de masa o cuantía: f ( x ) P X x p x q 1 x ; - p a ra x 0,1 . Función característica: ( t ) q pe it Función generatriz de momentos: g ( t ) q pe t Media: p ; Varianza: 2 pq ; Momentos: (NC) k p ; C: k ( p ) k q q k p 11.2. Distribución Binomial. B(n,p) n - Función de masa o cuantía: f ( x ) P ( X k ) p k q n k ; - Función característica: ( t ) ( pe it q ) n Función generatriz de momentos: g ( t ) ( pe t q ) n Media: np ; Varianza: 2 npq ; Teorema de la adición. para k 0,1, 2, ...n k 11.3. Distribución Multinomial. n! - Función de masa o cuantía: P ( X 1 x1 , X 2 x 2 , ... X k x k ) - Media: ( np1 , np 2 , ...np k ) ; Varianza: 2 ( X i ) np i (1 p i ); i 1, 2, ...k . Covarianzas: C ov ( X i X j ) np i p j ; i j . x1 ! x 2 !... x k ! 11.4. Distribución Hipergeométrica. H(N,n,k). N datos, k éxitos, N-k fracasos, se seleccionan n datos sin reemplazamiento. - Función de masa o cuantía: - Media: kn N k N k x n x P ( X x) N n ; Varianza: 2 N n N 1 n k k 1 N N x x x p1 1 p 2 2 ... p k k 11.5. Distribución geométrica. - Función de densidad o cuantía: f ( x ) P ( X x ) (1 p ) x 1 p - Función generatriz de momentos: g ( t ) - Media: 1 ; Varianza: 2 t 1 qe t q p p pe 2 11.6. Distribución binomial negativa. X= nº de fallos antes del éxito. - n x 1 n x p q ; x Función de densidad: P ( X x ) para x 0,1, 2... n - p Función generatriz: g ( t ) t 1 e q nq nq ( nq 1) Media: ; Varianza: 2 2 p p Tema 12. Distribuciones de probabilidad de variable discreta (II). 12.1. Proceso de Poisson. Pn ( t ) Probabilidad de que ocurra A n veces en un tiempo t. Es independiente del origen de tiempos. Hipótesis de regularidad: P1 ( t ) t o ( t ) . Condiciones iniciales: P0 (0) 1; Pn (0) 0 n 0 . Pn ( t ) ( t ) n e t n! 12.2. Distribución de Poisson. P(). - Función de probabilidad: P ( X x ) e x x! - Función generatriz de momentos: g ( t ) e ( e 1) Media: ; Varianza: 2 Características de forma: t o Coeficiente de Asimetría: 1 o Coeficiente de curtosis: 2 1 1 12.3. La distribución de Poisson como límite de la distribución binomial. Se puede aproximar las probabilidades binomiales mediante la distribución de Poisson cuando p< 0,1 y np>5. n x nx lim p q e n x! x x Tema 13. Distribuciones de probabilidad de variable continua (I). 13.1. Distribución Uniforme. U(a,b) - Función de densidad: f ( x ) - Media: 1 ab 1 ; Varianza: 2 2 12 e e tb - si b a Función generatriz: g ( t ) x a, b; b a 0 en otro caso 2 ta t (b a ) 13.2. Distribución Gamma. (p,a) p 1 x - Función gamma: ( p ) - ( p ) ( p 1) ! ( p 1) ( p 1); x 0 e dx . p - Función de densidad: f ( x ) - p ; p 2 a - a 2 (1 / 2) a x p 1 si ( p) t g (t ) 1 a ; e ax x 0; 0 en otro caso p La distribución gamma es reproductiva respecto del parámetro p. 13.3. Distribución exponencial. - Exp(a) =(1,a) 13.4. Distribución de Weibull. W(,) - f ( x ) x 1 e x x 0; si 0 en otro caso 13.5. Distribución normal reducida. N(0,1) 1 - f ( x) 2 e x 2 2 t 0; ; 1; 2 g (t ) e 2 13.6. Distribución normal. N(,) - f ( x) 1 2 e (x ) 2 2 2 ; g (t ) e t ( t ) 2 2 Y - Dada la variable Y N ( , ) se llama variable tipificada a X - Suma de variables aleatorias independientes, entonces la media es la suma de las medias y la varianza la suma de las varianzas. - Si X X 1 X 2 ... X n n N , n 13.7. La normal como límite de la binomial. B ( n , p ) n N ( np , npq ) Tema 14. Distribuciones de probabilidad de variable continua (II). 14.1. Distribución de Pearson. n X 1 X 2 ... X n donde Xi pertenece a N (0,1) 2 2 2 2 n; 2 n 2 si n es suficiente grande se puede aproximar por N ( n , 2 n ) 14.2. Distribución t de student. T(n) X T 1 n donde Xi N (0, ) n 2 Xi i 1 14.3. Distribución F de Snedecor. F(m,n) m 1 F m 1 n 2 Xi i 1 n Y 2 i i 1 14.4. Distribución Z de Fisher. Z 1 ln F 2 Tema 15. Distribución normal multivariante. - f (X ) A (2 ) n 2 1 exp ( x ) ' A ( x ) 2 A es simétrica y semidefinida positiva. g (t ) e t ' 1 t'A 1 t 2 Las distribuciones marginales son normales unidimensionales. E X1 Vector de medias: E X E X n Matriz de covarianzas: es la inversa de A Tema 16. Sucesiones de variables aleatorias. Teorema central del limite. 16.1. Tipos de convergencia. - Convergencia en probabilidad: X n P X si lim P e E : X n ( e ) X ( e ) 0, 0 - .S Convergencia casi segura: X n C X si P e E : lim X n ( e ) X ( e ) 1 n n - X si lim F n ( x ) F ( x ) en cada punto de continuidad de F. Convergencia en Ley. X n L n - .S X n C X n P X X X n L X 16.2. Teorema de Bernouilli. lim f ( A ) P ( A ). n 16.3. Leyes de los grandes números. - Ley débil: X n D si : X n a n P 0 - .S . Ley fuerte: X n F si : X n a n C 0 - Xn 1 n n X i; an i 1 1 n n EX i i 1 16.4. Teorema central del límite. Si Xn independientes e idénticamente distribuidas con media y varianza finitas: X 1 X 2 ... X n n N (0,1) L n 16.5. Ejemplos notables de convergencia en ley. N ( n , 2 n L 2n ) Tema 17. Distribuciones en el muestreo de poblaciones paramétricas. 17.1. Introducción. - Población paramétrica: aquella que viene definida por una variable cuya función de distribución depende de uno o varios parámetros que en general serán desconocidos. 17.2. Tipos de muestreo estadístico. - - Muestreo aleatorio simple. X=(X1,X2,...Xn) las elecciones son independientes. Muestreo estratificado. Los elementos de la población se dividen en grupos. o El nº. de elementos de cada grupo se llama afijación, siendo su clasificación: igual, proporcional y óptima. Muestreo sistemático: tomar un grupo correlativo de entre una lista ordenada. Muestreo polietápico: tomar muestras de poblaciones, subpoblaciones, etc. Estadístico: o estimador es cualquier función medible que asigna a cada muestra un número real. (X1,X2,...Xn) ->R n - Media muestral: X : X 1 , X 2 , ..., X n Xi i 1 n n - Varianza muestral: S 2 : X 1 , X 2 , ..., X n (X i i 1 n X) 2 17.3. Distribución de la media en el muestreo. - Esperanza de la media en el muestreo: E X - Varianza de la media en el muestreo: 2 X n - Distribución de la media muestral (varianza conocida): N ( , ) X es N , 2 n 17.4. Distribución de la varianza en el muestreo. - Esperanza de la varianza en el muestreo: 1 2 E S n - n 1 n E X i 1 2 i E X 2 2 E X 2 Distribución de la varianza muestral: 2 n 2 X X i nS resultando que lo 2 n primero del segundo miembro es una 2 con n-1 grados de libertad. - Distribución de la media muestral (varianza desconocida): N ( , ) X es N , entonces X X es una N (0,1); n n 1 S , n es una t de Student con n-1 grados de libertad. 17.5. Distribución de la diferencia de medias. - 1 n 2 Varianzas conocidas: X 1 X 2 N 1 2 , mn - Varianzas desconocidas iguales: 2 2 m (X1 X 2) mn que sigue una t de Student con n+m-2 nS 1 m S 2 2 2 nm2 grados de libertad. Tema 18. Distribuciones en el muestreo de poblaciones no paramétricas. - Estadísticos ordenados. u1 u 2 ... u n Los valores más importantes son: u1 (mínimo); un(máximo); um(mediana); un-u1(recorrido). - Distribución del mínimo valor muestral u1: f m in ( u 1 ) n f ( x ) d x - u Distribución del máximo valor muestral un: f m ax ( u n ) n f ( x ) dx - Distribución de estadísticos ordenados: 1 r1 r2 ... rk n . f ( u1 ) u1 n n! u r1 f ( x ) dx r1 1 !... n rk ! - n 1 r1 1 ... f ( u r1 )... f ( u rk ) du r1 ...du rk u r f ( x ) dx Distribución del recorrido: f ( r ) n ( n 1) 1 f (u n ) n rk f ( x ) dx u rk n 1 u1 n2 f ( u 1 ) f ( u 1 r )du 1 - m m (2 m 1) ! u m f ( x ) dx f ( u ) du f ( x ) dx m m u m m ! m ! Distribución de la mediana(n=2m+1): Tema 19. Estimación puntual. 19.1. Estimador insesgado. El estimador es estimador insesgado de si E Cualquier combinación lineal convexa de estimadores insesgados es insesgado. La media muestral E X es un ejemplo de estimador insesgado de la media - poblacional E X n 2 La cuasivarianza Sˆ 2 s es un estimador insesgado de la varianza poblacional - n 1 . 2 2 E S n 1 2 E Sˆ ; 2 n 2 . 19.2. Estimadores de mínima varianza. Cota de Cramer-Rao. 1 b '( ) Muestra aleatoria: 2 - E log L - 2 nE 1 si es insesgado: 2 1 b '( ) Muestra aleatoria simple: 2 2 E lo g L 2 2 log f 2 1 ; “””” 2 nE log f 2 19.3. Estimadores eficientes. es eficiente si es insesgado de mínima varianza. es eficiente si es insesgado y alcanza la cota de Cramer-Rao. 19.4. Estimadores consistentes. es consistente si para cada 0; P n 0 es consistente si lim E 0 y lim 2 0 n n 19.5. Estimadores suficientes. es suficiente para si y solo si la función de densidad de la muestra L ( x1 , x 2 , ..., x n ; ) se puede fabricar como sigue: L ( x1 , x 2 , ..., x n ; ) g ( x1 , x 2 , ..., x n ) h ( , ) Todo estimador eficiente es suficiente. Tema 20. El método de máxima verosimilitud. 20.1. La función de verosimilitud. n L ( x1 , x 2 , ..., x n ; ) i 1 f ( xi ; ) 20.2. Método de máxima verosimilitud. Máximo de de L: log L 0 ˆ Si la distribución poblacional depende de K parámetros 1 , 2 , ..., k habrá que resolver el sistema: 1 log L 0; 2 log L 0; ...; k log L 0 Los estimadores de máxima verosimilitud no tienen por que ser insesgados. 20.3. Propiedades de los estimadores de máxima verosimilitud. - la función ˆ es invariante por transformaciones biyectivas. Si existen estimadores eficientes de , entonces ˆ es eficiente. Si existe un estimador suficiente de , entonces ˆ es función de Tema 21. Otros métodos de estimación puntual. 21.1. Método de los momentos. Igualar momentos muestrales a momentos poblacionales. 21.2. Estimadores lineales de mínima varianza. a x es un estimador lineal centrado de si E y a 1 a 0 - La varianza de viene dada por a x a x a - Se dice que i i i i 2 2 i - El estimador lineal de mínima varianza es: 1 n x i 2 i 2 2 i i 21.2. Método de mínimos cuadrados. Consiste en minimizar m ( a , b ) Y i g ( X i , a , b , ...) 2 21.3. Métodos Bayesianos de estimación. - Distribución a priori: f - Distribución conjunta: f x1 , x 2 , ..., x n ; - Distribución a posteriori: f / x1 , x 2 , ..., x n g x1 , x 2 , ..., x n - f x1 , x 2 , ..., x n / f donde g x1 , x 2 , ..., x n f x1 , x 2 , ..., x n ; V .discreta f x1 , x 2 , ..., x n ; d V .continua Estimación Bayesiana de = E f / x1 , x 2 , ..., x n Tema 22. Estimación por intervalos. 22.1 Intervalos de confianza. - del parámetro : P 1 x1 , x 2 , ..., x n 2 x1 , x 2 , ..., x n 1 2 i - De la Media : o Población normal conocida o n>30: x 2 n , x s o Población normal desconocida o n 30: x t 2 - ns 2 De la varianza. Población N ( , ) : 2 , 2 ns 2 2 1 2 n 1 n 2 , x t n 1 s 2 con n-1 grados de libertad. De la diferencia de medias. o Población normal 1 , 2 conocidas o n1,n2>30: x1 x 2 1 2 2 2 1 2 n1 n2 2 , x1 x 2 2 n1 2 2 n2 o Población normal 1 2 desconocidas: x1 x 2 t - 2 n1 n 2 n1 s1 n 2 s 2 n1 n 2 n1 n 2 2 2 , x1 x 2 t 2 n1 n 2 1 2 sˆ1 Razón de varianzas. Poblaciones N ( 1 , 1 ), N ( 2 , 2 ) : f 2 sˆ2 2 1 , f1 2 2 sˆ1 2 sˆ2 Intervalo de confianza de proporciones con n, n1,y n2 >30. o Población normal: p p q 2 , p p q n n o Población binomial: p1 p 2 - 2 2 n1 s1 n 2 s 2 n1 n 2 2 n1 n 2 2 p1 q1 2 n1 2 p2 q2 n2 p1 q1 , p1 p 2 2 n1 p2 q2 n2 Tamaño de la muestra: la amplitud del intervalo es la diferencia entre sus extremos Tema 23. Contrastes de hipótesis. 23.1. Hipótesis estadísticas. Para deducir un método se propone una hipótesis siendo la descripción general: a) se definen dos hipótesis: nula(H0) y alternativa(H1). b) Se define un estadístico (p.e. ) para el que se conoce su distribución si H0 es cierto. c) Se delimitan dos zonas excluyentes de la muestra (A yS). d) Se selecciona una muestra y verificamos si pertenece a A por lo que se acepta H0 o en caso contrario se rechaza y se acepta H1. 23.2 Tipos de contraste. - - paramétricos: con un cierto parámetro queda determinada su distribución. Pueden ser por hipótesis simple 7 o hipótesis compuesta B . El contraste entre ambas hipótesis puede ser unilateral o bilateral. No paramétricos. 23.3. Tipos de error. Potencia de un test. - tipo I: Rechazar H0 si es cierta. Nivel de significación 0 1 . Tipo II: Aceptar H0 siendo falsa. No es fija salvo que H1 sea simple. - Potencia de test P : probabilidad de rechazar H0 siendo verdadero. 23.4. Teorema de Neyman-Pearson. a) nos planteamos la hipótesis nula H0. b) Seleccionamos una muestra aleatoria simple (x1,x2,...,xn) c) Sea B la familia de todas las regiones S/ P x1 , x 2 , ..., x n S / 0 suponiendo que para cada existe C()>0 tal que L x1 , x 2 , ..., x n ; 1 C ( ) L x1 , x 2 , ..., x n ; 0 se da en una región S 1 B y L x1 , x 2 , ..., x n; 1 C ( ) L x1, x2, ..., x n; 0 se da para x1 , x 2 , ..., x n S 1 que es la región de rechazo. Tema 24. Algunos contrastes paramétricos. 24.1. Contraste de la media y diferencia de medias. H0 Estadístico t 0 C alc hp t test z 1 2 d 0 t 0 t n n 1 x1 x 2 d 2 1 n1 2 2 n2 1 y 2 conocidas C alc hp t sp t test z critical z desconocida y n<30 t Z test : 1 2 t 2 , t x 0 t sp 2 Se rechaza H0 si 0 conocida o n30 Z test : 1 critical z H1 x 0 0 t t 2 , t t 0 t t 0 t t 1 2 d t 2 , t 1 2 d t 1 2 d t x1 x 2 d 1 2 d t t 2 , t t 1 n1 2 n 2 1 2 d t t 1 2 d t t n s n2 s 2 1 1 2 2 2 2 2 2 n1 n 2 2 1 = 2 desconocidas 24.2. Contrastes relacionados con proporciones. H0 p p0 C alc hp Z test : 1 p t test z critical z Estadístico H1 P P X x p p0 p p0 P P X x p p0 p p0 P 2 P X x p p 0 si x np 0 p p0 Se rechaza H0 si P P 2 P X x p p 0 si x np 0 Muestras grandes t x np 0 np 0 q 0 p p0 t 2 , t p p0 t p p0 t 2 p1 p 2 d Muestras grandes t pˆ 1 pˆ 2 d pˆ 1 qˆ1 pˆ 2 qˆ 2 n1 p1 p 2 d t 2 , t p1 p 2 d t p1 p 2 d t n2 2 24.3. Contrastes relacionados con varianzas. H0 2 2 0 Estadístico Población normal t 1 2 2 2 n 1 sˆ H1 2 1 2 t Fa , t Fb t F 2 sˆ 2 1 2 2 sˆ 2 1 2 24.4. Contraste de la razón de verosimilitudes. - 2 2 Poblaciones normales Hipótesis simples: t 2 0 t - Se rechaza H0 si 2 0 L 1 L 2 Alternativa compuesta: H 0 : 0 ; ; L ˆ L 0 ; H 1 : 1 H 0 : 0 ; H1 : 0 2 2