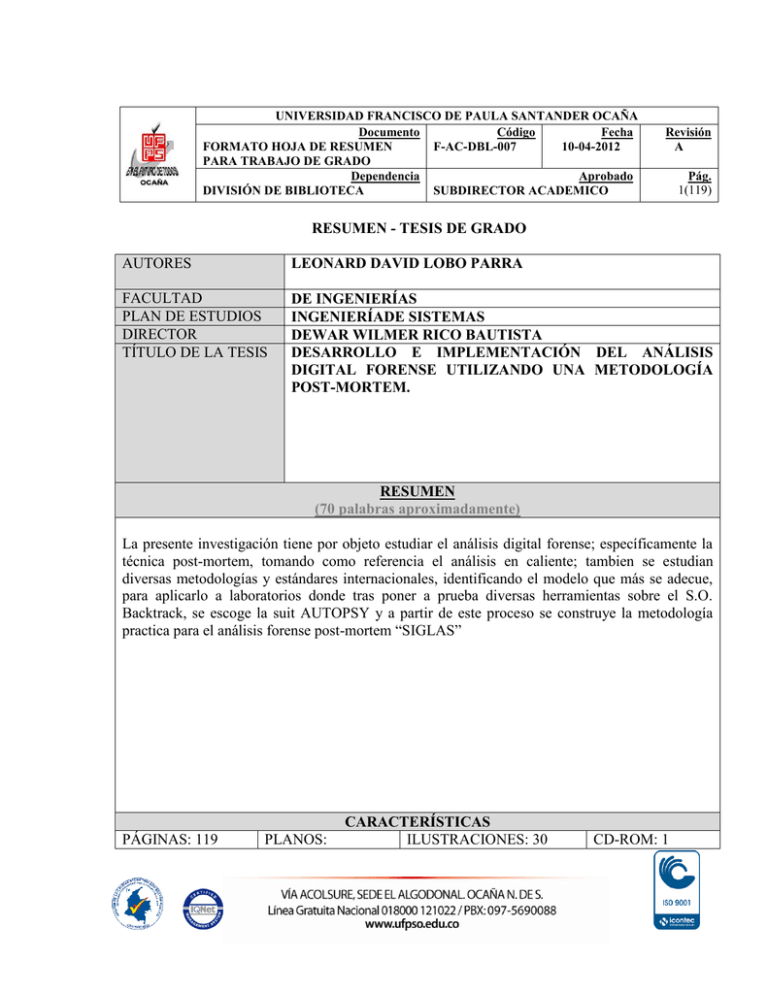

1 resumen - tesis de grado autores leonard david lobo parra

Anuncio