Diseño de cuadernillos para la evaluación de las Competencias

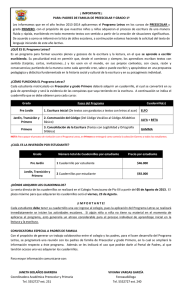

Anuncio