Descarga Tesis en formato PDF - IIDE

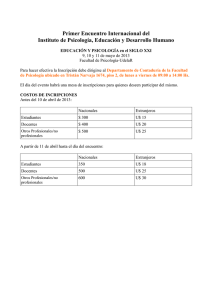

Anuncio