El análisis de contenido de las comunicaciones

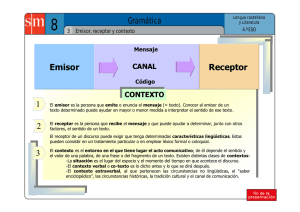

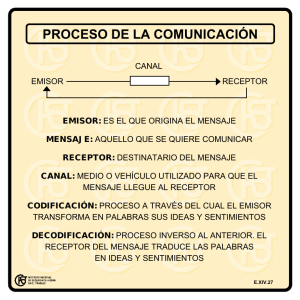

Anuncio