Análisis en Componentes Principales

Anuncio

This is page i

Printer: Opaque this

Análisis en Componentes Principales

Dr. Oldemar Rodrı́guez Rojas

24 de mayo de 2009

ii

This is page iii

Printer: Opaque this

Contents

1. Análisis en Componentes Principales (ACP)

V

1.

Los datos . . . . . . . . . . . . . . . . . . . . . . . . . . . . vi

2.

El problema . . . . . . . . . . . . . . . . . . . . . . . . . . . vii

3.

Cálculo de los factores y de las componentes principales . . viii

3.1.

En el espacio de los individuos . . . . . . . . . . . . viii

4.

En el espacio de las variables . . . . . . . . . . . . . . . . . xi

5.

Equivalencia de los dos análisis – Relaciones de dualidad . . xii

6.

Varianza explicada por cada eje . . . . . . . . . . . . . . . . xiv

7.

Gráficos y su interpretación . . . . . . . . . . . . . . . . . . xvi

7.1.

Representación de los individuos . . . . . . . . . . . xvi

7.2.

Calidad de la representación de un individuo . . . . xvii

7.3.

Las contribuciones de los individuos a la varianza totalxvii

7.4.

Representación de las variables . . . . . . . . . . . . xviii

8.

El Algoritmo . . . . . . . . . . . . . . . . . . . . . . . . . . xx

8.1.

Interpretación de la dualidad en los gráficos . . . . . xxii

iv

This is page v

Printer: Opaque this

Análisis en Componentes

Principales (ACP)

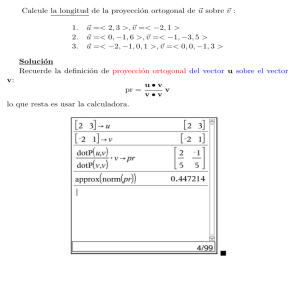

El Análisis de Componentes Principales (ACP) es una técnica proveniente

del análisis exploratorio de datos cuyo objetivo es la sı́ntesis de la información, o reducción de la dimensión (número de variables). Es decir, ante una

tabla de datos con muchas variables, el objetivo será reducirlas a un menor

número perdiendo la menor cantidad de información posible. El ACP es

uno de los métodos más utilizados en Minerı́a de Datos en paı́ses como

Francia. Fue primeramente introducido por Pearson en 1901 y desarrollado independientemente en 1933 por Hotelling y la primera implementación

computacional se dı́o en los años 60. Fue aplicado para analizar encuestas

de opinión pública por Jean Pages. Como ya se mencionó el objetivo es construir un pequeño número de nuevas variables (componentes) en las cuales

se concentre la mayor cantidad posible de información, como se ilustra en

la Figura 1.

FIGURE 1. Transformación de las variables originales en componentes.

Estas nuevos componentes principales o factores son calculados como una

combinacin lineal de las variables originales, y además serán linealmente

independientes. Un aspecto clave en ACP es la interpretación, ya que ésta

no viene dada a priori, sino que será deducida tras observar la relación de

los componentes principales con las variables originales, para esto hay que

estudiar tanto el signo como la magnitud de las correlaciones, como vermos

en detalle más adelante. Esto no siempre es fácil, y será de vital importancia

el conocimiento que el experto tenga sobre la materia de investigación.

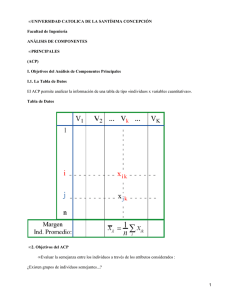

Los n individuos de una tabla de datos se pueden ver como una nube de

puntos en Rp , como se ilustra en la Figura 2-a, con su centro de gravedad

localizado en el origen, y lo que se busca es un subespacio q−dimensional L

de Rp , usualmente un plano (ver Figura 2-b), tal que la proyección ortogonal

de los n puntos sobre L (ver Figura 2-c) tienen varianza máxima, lo cual

permitirá el estudio de relaciones, clases, etc. entre los individuos (filas) de

vi

1. Análisis en Componentes Principales (ACP)

la tabla de datos.

FIGURE 2. Proyección de los individuos en el plano de varianza máxima

1. Los datos

Se parte de una tabla de datos:

x11

..

.

X=

xi1

.

..

xn1

···

..

.

···

..

.

x1j

..

.

···

..

.

xij

..

.

···

xnj

···

..

.

···

x1m

..

.

xim

←- individuo i

..

.

xnm

que se puede transformar en la siguiente matriz de distancias:

d11

..

.

D=

di1

.

..

dn1

···

..

.

···

..

.

d1j

..

.

···

..

.

dij

..

.

···

dnj

···

..

.

···

d1n

..

.

xin

..

.

dnn

1. Análisis en Componentes Principales (ACP)

vii

2. El problema

Se trata de sintetizar los datos contenidos en una tabla de datos X

en un conjunto más pequeño de nuevas variables C 1 , C 2 , . . . llamadas

componentes principales, manteniendo la información escencial de X.

Ası́, en la etapa 1 del algoritmo se encuentra una variable sintética

C 1 , la primera componente principal, la cual es combinación lineal

de las variables originales X j , es decir:

C 1 = a11 X 1 + · · · + a1j X j + · · · + a1m X m ,

donde X j es la columna j de X. Esto significa que el valor de C 1

para el individuo i−ésimo está dado por:

Ci1 = a11 xi1 + · · · + a1j xij + · · · + a1m xim ,

Generalmente esta primer componente principal, C 1 , no es suficiente

para condensar la información contenida en X, por lo que se construye una segunda componente principal C 2 , luego una tercera C 3 y

ası́ sucesivamente.

En general en la etapa k, se construye la componente principal k−ésima

dada por:

C k = ak1 X 1 + · · · + akj X j + · · · + akm X m .

Matricialmente se tiene que:

C k = Xak ,

donde:

ak1

..

.

k

a =

akj .

.

..

akm

ak se llama el k−ésimo factor.

Los factores akj constituyen un sistema de pesos para las variables,

los cuales indican cuanto aporta cada variables a la construcción de

la componente.

viii

1. Análisis en Componentes Principales (ACP)

Algunos factores akj serán negativos y otros serán positivos. El valor

de cada peso por si solo no es importante, sino la relación con respecto

a los otros pesos. Para evitar un problema de escalas se impone la

siguiente restricción:

m

X

(akj )2 = 1.

j=1

3. Cálculo de los factores y de las componentes

principales

Como en regresión, el ACP puede ser presentado tanto en el espacio de las

variables como en el espacio de los individuos.

3.1. En el espacio de los individuos

Se supondrá que las variables están centradas y reducidas.

V = n1 X t X es la matriz de varianzas–covarianzas. Como las variables

están centradas y reducidas entonces V = R, la matriz de correlaciones, pues:

vij = cov(X i , X j ) =

cov(X i , X j )

= R(X i , X j ).

σX i σX j

Por lo tanto el espacio de las filas de X en Rm es el espacio de

individuos cuyo origen será el centro de la nube de puntos.

El objetivo del ACP es describir de manera sintética la nube de individuos.

Teorema 1 En la etapa 1 de un ACP se calcula el eje D1 que pasa por

el origen para el cual la dispersión de la nube de puntos sea máxima, este

eje D1 pasa entonces lo más cerca posible de la nube de puntos, es decir,

el promedio de las distancias al cuadrado de los n puntos de la nube y el

eje D1 es minimal (ver figura siguiente).

Sea a1 es vector director normado (norma 1) del eje (recta) D1 entonces:

a1 es el vector propio asociado al valor propio más grande de la matriz de

V de varianzas–covarianzas.

Antes de probar el Teorema necesitamos primero del siguiente Lema (el

cual vamos a asumir como válido):

1. Análisis en Componentes Principales (ACP)

ix

Lema 1 Sean A y B dos matrices cuadradas m × m simétricas y sea A

una matriz definida positiva. Entonces el vector y ∈ Rn que resuelve el

siguiente problema de optimización:

max y t By

sujeto a y t Ay = 1

es el vector propio a1 de A−1 B de norma 1 asociado al valor propio más

grande β 1 .

Nota: Una matriz A es definida si para todo u ∈ Rm se tiene que ut Au > 0.

Prueba. Las coordenadas del individuos i-ésimo son:

i = (xi1 , . . . , xij , . . . , xim ).

Además, se sabe que la proyección del individuo i sobre el eje D1 es:

P (i, D1 ) =

hi, a1 i 1

a ,

ka1 k

donde a1 = (a11 , a12 , . . . , a1m ) (es vector director de norma 1 del eje D1 ).

Entonces las coordenadas de la proyección del individuo i sobre el eje D1

son:

Ci1

=

hi, a1 i

ka1 k

= a11 xi1 + · · · + a12 xij , + · · · +, a1m xim

= Xa1 .

Del siguiente gráfico:

i

>

d(i, 0) d(i, D1 )

- D1

1

0| a{z

}

Ci1

Usando el Teorema de Pitágoras, se deduce que:

d2 (i, 0) = (Ci1 )2 + d2 (i, D1 ),

por lo que sumando sobre i a ambos lados y multiplicando por 1/n se tiene

que:

n

n

n

1X 2

1X 1 2 1X 2

d (i, 0) =

(C ) +

d (i, D1 ).

n i=1

n i=1 i

n i=1

x

1. Análisis en Componentes Principales (ACP)

Pn

Como n1 i=1 d2 (i, 0) es independiente del eje D1 que se escoja,

Pn se deduce

1

1 2

que es una cantidad constante.

Por

lo

tanto

maximizar

i=1 (Ci ) es

n

Pn

1

2

equivalente a minimizar n i=1 d (i, D1 ).

Además es claro que:

n

1X 1 2

1

1

(C ) = (C 1 )t C 1 = (a1 )t X t Xa1 .

n i=1 i

n

n

De esta manera el problema que queremos resolver es:

max n1 (a1 )t X t Xa1

sujeto a (a1 )t a1 = 1 (pues la norma de a1 debe ser 1).

Entonces aplicando el Lema anterior con B = n1 X t X y A = Im×m se tiene

que a1 es el vector propio de norma 1 de la matriz B = n1 X t X asociado al

valor propio más grande.

Teorema 2 En la etapa 2 de un ACP se calcula el eje D2 que pasa por

el origen para el cual la dispersión de la nube de puntos sea máxima, este

eje D2 pasa entonces lo más cerca posible de la nube de puntos, es decir,

el promedio de las distancias al cuadrado de los n puntos de la nube y el

eje D2 es minimal.

Sea a2 es vector director normado (norma 1) del eje (recta) D2 el cual

será ortogonal al vector a1 construido en la etapa 1, entonces: Se tiene el

siguiente problema de optimización:

máx

1

n

(

sujeto

a2

t

X t Xa2

t

a2 a2 = 1

t

a2 a2 = 0

cuya solución es el vector propio asociado al segundo valor propio más

grande de la matriz de V de varianzas–covarianzas.

Teorema 3 En la etapa k de un ACP se calcula el eje Dk que pasa por

el origen para el cual la dispersión de la nube de puntos sea máxima, este

eje Dk pasa entonces lo más cerca posible de la nube de puntos, es decir,

el promedio de las distancias al cuadrado de los n puntos de la nube y el

eje Dk es minimal.

Sea ak es vector director normado (norma 1) del eje (recta) Dk el cual

será ortogonal al vector ar ∀ r < k construidos en las etapas 1, 2, . . . , k − 1

entonces: Se tiene el siguiente problema de optimización:

1. Análisis en Componentes Principales (ACP)

1

n

máx

ak

(

t

xi

X t Xak

t

ak ak = 1

t

ak ak = 0 para r = 1, 2, . . . , k − 1

sujeto

cuya solución es el vector propio asociado al k−ésimo valor propio más

grande de la matriz de V de varianzas–covarianzas.

4. En el espacio de las variables

Teorema 4 En la etapa 1 de un ACP se calcula una variable sintética

(eje) C 1 que resuma lo mejor posible las variables originales, es decir, de

tal manera que:

m

X

R2 (C 1 , X j ) sea máxima.

j=1

1

Entonces C es el vector propio asociado al valor propio más grande λ1 de

la matriz n1 XX t .

Prueba.

cov(C 1 , X j ) =

1 j t 1

1

(X ) C = (C 1 )t X j ,

n

n

lo cual implica que:

cov2 (C 1 , X j ) =

como var(C 1 ) =

1

1 t 1

n (C ) C

R2 (C 1 , X j ) =

1

(C 1 )t X j (X j )t C 1 ,

n2

y var(X j ) = 1, se tiene que:

cov2 (C 1 , X j )

(C 1 )t X j (X j )t C 1

=

,

1

j

var(C )var(X )

n(C 1 )t C 1

entonces:

m

X

2

1

j

R (C , X ) =

(C 1 )t

j=1

como

Pm

j=1

Pm

j

j t 1

j=1 X (X ) C

,

n(C 1 )t C 1

X j (X j )t = XX t , se tiene que:

m

X

R2 (C 1 , X j ) =

j=1

De modo que maximizar

siguiente expresión:

Pm

j=1

(C 1 )t XX t C 1

.

n(C 1 )t C 1

R2 (C 1 , X j ) es equivalente a maximizar la

xii

1. Análisis en Componentes Principales (ACP)

(C 1 )t XX t C 1

,

n(C 1 )t C 1

entonces, aplicando el lema anterior, C 1 es el vector propio asociado al

valor propio más geande λ1 de la matriz n1 XX t .

Teorema 5 En la etapa k de un ACP se calcula una variable sintética

(eje) C k que resuma lo mejor posible las variables originales y que no

esté correlacionada las primeras k − 1 componentes principales (variables

sintéticas) ya calculadas, es decir, de tal manera que:

máx

m

X

R2 (C k , X j )

j=1

sujeto R2 (C k , C r ) = 0 para r = 1, 2, . . . , k − 1

Entonces: C k es el vector propio de n1 XX t asociado al k−ésimo valor propio

más grande.

5. Equivalencia de los dos análisis – Relaciones de

dualidad

Espacio de los individuos 7→

Espacio de las variables 7→

1

t

nX X

1

t

n XX

que es tamaño m × m.

que es tamaño n × n.

Usualemente el número de variables es menor que el número de individuos,

por supondremos en adelante sin pérdidad de generalidad que m < n.

Teorema 6 [Relaciones de Dualidad]

1.

Si vk es el k−ésimo vector propio de norma 1 asociado a λk de la

matriz n1 XX t entonces:

X t vk

uk = √

,

nλk

es el k−ésimo vector propio de norma 1 asociado a λk de la matriz

1

t

n X X.

2.

Si uk es el k−ésimo vector propio de norma 1 asociado a λk de la

matriz n1 X t X entonces:

Xuk

vk = √

,

nλk

1. Análisis en Componentes Principales (ACP)

xiii

es el k−ésimo vector propio de norma 1 asociado a λk de la matriz

1

t

n XX .

Prueba.

1.

Sea vk el vector propio de norma 1 asociado λk de la matriz

entonces por definición se tiene que:

1

t

n XX ,

1

XX t vk = λk vk ,

n

multiplicando por X t a ambos lados por la izquierda se tiene que:

1 t

X XX t vk = λk X t vk ,

n

lo cual es equivalente a:

1 t

(X X)(X t vk ) = λk (X t vk ),

n

aplicando de nuevo la definición de valor propio se tiene que:

1

t

n X X.

matriz n1 X t X

λk es un valor propio de la matriz

X t vk es el vector propio de la

propio λk .

asociado al valor

Este vector propio X t vk se debe normalizar, para esto:

kX t vk k2 = (X t vk )t (X t vk ) = vkt XX t vk = nλk vkt vk = nλk ,

entonces:

kX t vk k =

p

nλk ,

por lo que:

X t vk

uk = √

,

nλk

es un vector propio de norma 1 de la matriz

propio λk .

2.

Tarea.

1

t

nX X

asociado al valor

xiv

1. Análisis en Componentes Principales (ACP)

6. Varianza explicada por cada eje

Teorema 7 1. n1 X t X y

λ1 , λ 2 , . . . , λm .

2.

1

t

n XX

tienen los mismos valores propios,

Además el rango de ambas matrices es n − m y los últimos n − m

valores propios de n1 XX t son nulos.

Prueba.

1.

Sea λk el k-ésimo valor propio de la matriz

definición se tiene que:

1

t

n X X,

entonces por

1 t

X Xvk = λk vk ,

n

multiplicando por X a ambos lados se tiene que:

1

XX t Xvk = λk Xvk ,

n

como se sabe que Xvk = C k (la componente k-ésima), entonces:

1

XX t C k = λk C k ,

n

lo cual implica que λk el k-ésimo valor propio de la matriz

asociado al vector propio C k .

2.

1

t

n XX ,

Tarea.

Teorema 8 La suma de los m valores propios de n1 X t X es igual al número

de columnas m de la matriz X, es decir:

m

X

λk = m.

k=1

Prueba. Del álgebra lineal se sabe que la suma de valores propios de una

matriz es igual a la suma de los elementos de la diagonal de dicha matriz,

es decir, es igual a la traza de la matriz. Además, como X está centrada y

reducida n1 X t X = R, de donde:

m

X

k=1

entonces:

λk = Tr

1 t

X X

n

= Tr(R),

1. Análisis en Componentes Principales (ACP)

1

m

0

X

λk = Tr

0

k=1

0

0 ···

1 ···

..

.

0

0 ···

xv

0

0

= m.

0

1 m×m

El ACP tiene m etapas, en cada etapa se construye un resumen de la tabla

X, menos interesante que el construido en la etapa anterior.

¿Cómo medir la calidad de la etapa k?

En la etapa k, el criterio del ACP es maximizar:

n

1X k 2

(C ) ,

n i=1 i

como:

n

1X k 2

1

(C ) = (ak )t X t Xak = (ak )t λk ak = λk .

n i=1 i

n

Entonces λk es la varianza explicada por el eje k−ésimo, es decir por

Ck.

Como:

m

X

λk = m,

k=1

se tiene que:

λk

= % de la varianza explicada por el eje C k = % de INERCIA.

m

Por ejemplo, la inercia explicada por el plano principal, ejes 1 y 2

es:

λ1 + λ 2

.

m

xvi

1. Análisis en Componentes Principales (ACP)

7. Gráficos y su interpretación

7.1. Representación de los individuos

Recordemos que para calcular las coordenadas de un individuos se tiene

que (La matriz X se supone centrada y reducida):

C s = Xas donde as es el vector propio de R =

1

t

nX X

asociado a λs .

De donde:

Cis = as1 Xi1 + · · · + asj Xij + · · · + asm Xim ,

es decir:

Cis =

m

X

Xij asj

j=1

Análogamente:

C r = Xar donde ar es el vector propio de R =

1

t

nX X

asociado a λr .

De donde:

Cir = ar1 Xi1 + · · · + arj Xij + · · · + arm Xim ,

es decir:

Cir =

m

X

Xij arj

j=1

Gráficamente se ilustra como sigue:

Ası́, dos individuos i y j cuyas proyecciones son cercanas son “semejantes”en la nube de puntos.

Para proyectar un individuo en suplementario s = (s1 , . . . , sm ) simplemente se centra y reduce como si fuera la última fila de X, como

sigue:

s̃ =

s1 − X̄ 1

sm − X̄ m

,...,

σ1

σm

,

donde X̄ j es la media de la columna j−ésima de la matriz X. Entonces las coordenadas se calculan como sigue:

Cis =

m

X

j=1

s̃j asj

1. Análisis en Componentes Principales (ACP)

xvii

7.2. Calidad de la representación de un individuo

En el espacio de los individuos se tienen 2 bases ortonormales:

1.

La base original, en la cual las coordenadas del individuo i son:

i = (Xi1 , . . . , Xij , . . . , Xim ).

2.

La base construida por los m factores, en la cual las coordenadas

del individuo i son:

i = (Ci1 , . . . , Cik , . . . , Cim ),

entonces la distancia del punto al origen se puede medir con

ambas representaciones, lo que implica que:

m

X

(Xij )2 =

j=1

m

X

(Cik )2 .

k=1

De modo que el individuo i tiene una buena representación en el eje

n

X

r si (Cir )2 tiene un valor importante respecto a la suma

(Xij )2 .

j=1

Por lo que la calidad de la representación del individuo i sobre el eje

r está dada por:

(Cir )2

m

X

= % del individuo i representado en el eje r.

(Xij )2

j=1

Lo anterior es útil para qué tan bien está representado un individuo

en un eje o plano.

7.3.

Las contribuciones de los individuos a la varianza total

La varianza total en la etapa r es igual a:

n

1X r 2

(C ) = λr .

n i=1 i

La parte de esta varianza explicada por el individuo i es:

1 r 2

(C )

n i

xviii

1. Análisis en Componentes Principales (ACP)

Entonces, la contribución del individuo i a la varianza total del eje r

está dada por:

(Cir )2

= % de contribución del individuo i a la formación del eje r.

nλr

Lo anterior es útil para intepretar los ejes.

7.4.

Representación de las variables

La coordenada de la variable X j sobre el eje r está dada por:

R(X j , C r ),

que es el coeficiente de correlación entre la variable j−ésima y la

componente principal r−ésima.

Entonces las coordenadas de X j sobre la base de componentes principales son:

(R(X j , C 1 ), . . . , R(X j , C s ), . . . , R(X j , C m )),

esto implica que:

m

X

R2 (X j , C k ) = 1

k=1

Por lo que si se usan solamente 2 componentes C r y C s se tiene que:

R2 (X j , C s ) + R2 (X j , C r ) 6 1.

Por esta razón las variables pueden ser representadas en un cı́rculo

de radio 1 como se ilustra a continuación:

Teorema 9 [Cálculo de las correlaciones]

√

λr ar1

R(X 1 , C r )

..

..

.

.

p

√

R(X j , C r ) = λr · ar = λr arj ,

.

..

.

.

√ . r

m

r

R(X , C )

λr am

donde ar es el r−ésimo vector propio de R =

1

t

nX X

asociado a λr .

1. Análisis en Componentes Principales (ACP)

xix

Prueba. Sabemos que:

R(X j , C r ) =

cov(X j , C r )

,

σX j σC r

Como la tabla X está reducida σ X j = √

1. Además se sabe que la

varianza del eje C r es λr , es decir, σ C r = λr , entonces se tiene que:

R(X j , C r ) =

cov(X j , C r )

cov(X j , C r )

√

=

.

σX j σC r

λr

Entonces:

R(X 1 , C r )

..

.

p

R(X j , C r ) = √1 X t C r = √1 X t Xar = √1 λr ar = λr ar .

n λ

n λr

λr

r

..

.

R(X m , C r )

Por dualidad, en el espacio de las variables, para calcular las coordenadas (correlaciones) se podrı́a diagonalizar la matriz H = n1 XX t

(que es tamaño n × n) y proceder a calcular dichas coordenadas de

manera completamente análoga al caso de los individuos.

Es decir, suponiendo que la matriz X está centrada y reducida, y si

denotamos por Z = X t entonces:

Rs = Zas donde as es el vector propio de H =

1

t

n XX

asociado a λs .

De donde:

Ris = as1 Zi1 + · · · + asj Zij + · · · + asn Zin ,

es decir:

Ris =

n

X

Zij asj

j=1

Calidad de representación de una variable

La calidad de la representación de una variable sobre el cı́culo de

correlaciones, será también medida con el cuadrado del coseno del

ángulo entre la variable y su proyección. Ahora bien, recuérdese que

entre variables, el coseno es igual a una correlación, por lo que serán

xx

1. Análisis en Componentes Principales (ACP)

las correlaciones al cuadrado las que midan la calidad de la representación de las variables. Ası́ la matriz de calidades de las variables

S ∈ Mm×m se puede calcular como sigue:

R2 (X 1 , C 1 ) · · ·

..

..

.

2 .j 1

R

(X

,

C

)

·

·

·

S=

..

..

.

.

R2 (X m , C 1 ) · · ·

R2 (X 1 , C r )

···

R2 (X j , C r )

..

.

···

..

.

···

..

.

R2 (X m , C r ) · · ·

R2 (X 1 , C m )

..

.

2

j

m

R (X , C )

..

.

R2 (X m , C m )

Para proyectar una variable suplementaria:

y=

y1

y2

..

.

yn

primero se centra y se reduce respecto a sı́ misma como sigue:

y =

c

y1 −ȳ

σy

y2 −ȳ

σy

..

.

yn −ȳ

σy

y luego se calculan las correlaciones de y c con las componentes principales, de manera análoga a proyectar una columna de X.

8. El Algoritmo

Entrada: Las tabla de datos X ∈ Mn×m .

Salida: La matriz de componentes principales C ∈ Mn×m , la matriz

de calidades de los individuos (cosenos cuadrados) Q ∈ Mn×m , la

matriz de coordenadas de las variables T ∈ Mm×m , la matriz de

calidades de las variables (cosenos cuadrados) S ∈ Mm×m y el vector

de inercias de los ejes I ∈ M1×m .

Paso 1: Centrar y reducir la tabla de datos X.

1. Análisis en Componentes Principales (ACP)

xxi

Paso 2: Calcular la matriz de correlaciones R ∈ Mm×m . R se puede

calcular: R = n1 X t X, o bien a pie calculando todas las correlaciones.

Paso 3: Calcular los vectores y valores propios de la matriz R ∈

Mm×m .

Paso 4: Ordenar de mayor a menor estos valores propios.

Paso 5: Si denotamos por λ1 , λ2 , . . . , λm estos valores propios ordenados y por υ 1 , υ 2 , . . . , υ m los respectivos vectores propios,

entonces se construye la matriz V ∈ Mm×m de la siguiente forma:

V = [υ 1 |υ 2 | · · · |υ m ]

Es decir, la matriz V tiene como columnas los vectores υ 1 , υ 2 , . . . , υ m .

Paso 6: Calcule la matriz de componentes principales C ∈ Mn×m :

C =X ·V

Paso 7: Calcule la matriz de calidades de los individuos (cosenos

cuadrados) Q ∈ Mn×m , como sigue:

Qir =

(Ci,r )2

m

X

(Xij

para i = 1, 2, . . . , n; r = 1, 2, . . . , m.

)2

j=1

Paso 8: Calcule la matriz de coordenadas de las variables T ∈ Mm×m ,

como sigue:

R(X 1 , C 1 ) · · ·

..

..

.

.

j

1

R(X

,

C

)

·

·

·

T =

..

..

.

.

R(X m , C 1 ) · · ·

√

=

λ1 v1,1

..

√ .

λ1 vj,1

..

√ .

λ1 vm,1

···

..

.

···

..

.

···

R(X 1 , C r )

···

R(X j , C r )

..

.

R(X 1 , C m )

..

.

j

m

R(X , C )

..

.

m

m

R(X , C )

···

..

.

···

..

.

m

r

R(X , C ) · · ·

√

λr v1,r

√···

λr vj,r

..

√ .

λr vm,r

···

..

.

···

..

.

···

√

λm v1,m

..

√ .

λm vj,m

..

√ .

λm vm,m

xxii

1. Análisis en Componentes Principales (ACP)

Paso 9: Calcule la matriz de calidades de las variables (cosenos cuadrados) S ∈ Mm×m , como sigue:

λ1 (v1,1 )2

..

.

2

λ

(v

S=

1

j,1 )

..

.

λ1 (vm,1 )2

···

..

.

λr (v1,r )2

···

..

.

···

λr (vj,r )2

..

.

···

λr (vm,r )2

···

..

.

···

..

.

···

λm (v1,m )2

..

.

2

λm (vj,m )

..

.

2

λm (vm,m )

Paso 10: Calcule el vector de inercias de los ejes I ∈ M1×m , como

sigue:

I = (100 ·

λ1

λ2

λm

, 100 · , . . . , 100 ·

)

m

m

m

INTERPRETACIÓN

• Si la proyección de X j está cercana al borde del cı́rculo (la suma

de las correlaciones al cuadrado está cerca de 1), significa que

está bien representada en ese plano, pues tendrı́a fuerte correlación con las 2 componentes (o con alguna de ellas) y por la

tanto la correlación con las demás componentes es débil.

0

• Si dos variables X j y X j están cercanas al borde del cı́rculo,

entonces el ángulo G entre la proyección de estas dos variables

será muy cercano al ángulo que ambas variables tienen en la nube

de puntos (variables) y ası́ el coseno de G será muy cercano a la

correlación entre ambas variables (ver el siguiente gráfico), luego

la interpretación es la siguiente:

0

0

◦ Si X j y X j están cercanas entre si, entonces X j y X j son

fuerte y positivamente correlacionadas.

0

◦ Si el ángulo entre X j y X j es cercano a los 90◦ entonces

NO existe ninguna correlación entre ambas variables.

0

◦ Si X j y X j están opuestas al vértice (origen) entonces exis0

te una correlacin fuerte y negativa entre X j y X j .

8.1. Interpretación de la dualidad en los gráficos