1.4 Antecedentes Históricos 1.4.1 Década 50`s 1.4.2 Década 60`s

Anuncio

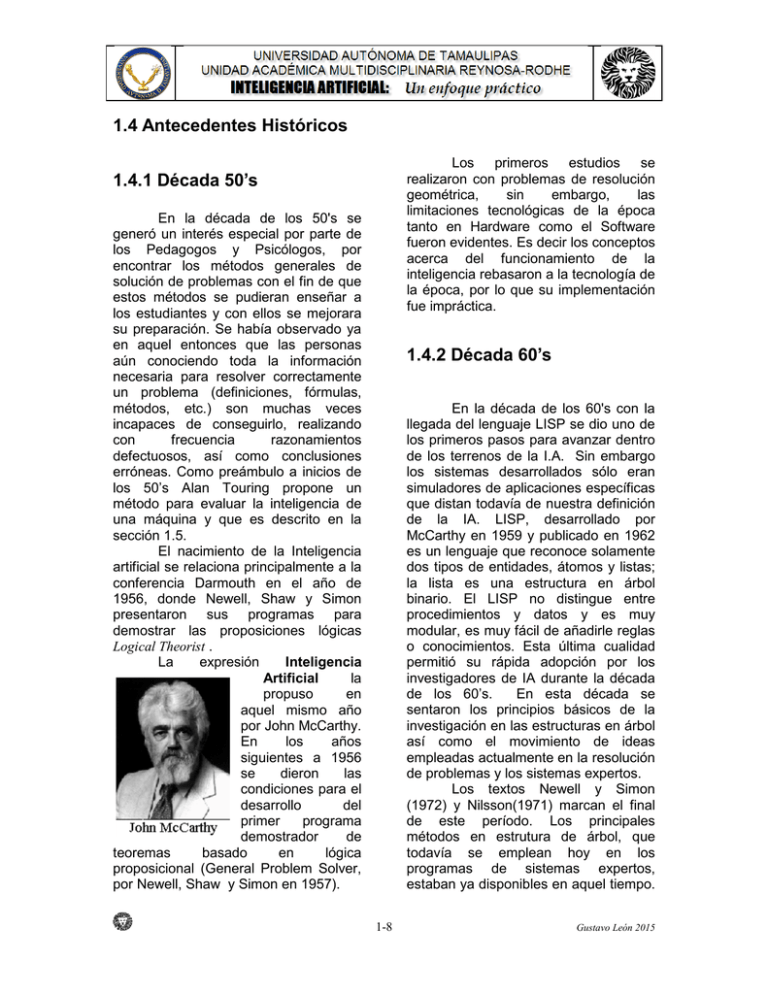

1.4 Antecedentes Históricos Los primeros estudios se realizaron con problemas de resolución geométrica, sin embargo, las limitaciones tecnológicas de la época tanto en Hardware como el Software fueron evidentes. Es decir los conceptos acerca del funcionamiento de la inteligencia rebasaron a la tecnología de la época, por lo que su implementación fue impráctica. 1.4.1 Década 50’s En la década de los 50's se generó un interés especial por parte de los Pedagogos y Psicólogos, por encontrar los métodos generales de solución de problemas con el fin de que estos métodos se pudieran enseñar a los estudiantes y con ellos se mejorara su preparación. Se había observado ya en aquel entonces que las personas aún conociendo toda la información necesaria para resolver correctamente un problema (definiciones, fórmulas, métodos, etc.) son muchas veces incapaces de conseguirlo, realizando con frecuencia razonamientos defectuosos, así como conclusiones erróneas. Como preámbulo a inicios de los 50’s Alan Touring propone un método para evaluar la inteligencia de una máquina y que es descrito en la sección 1.5. El nacimiento de la Inteligencia artificial se relaciona principalmente a la conferencia Darmouth en el año de 1956, donde Newell, Shaw y Simon presentaron sus programas para demostrar las proposiciones lógicas Logical Theorist . La expresión Inteligencia Artificial la propuso en aquel mismo año por John McCarthy. En los años siguientes a 1956 se dieron las condiciones para el desarrollo del primer programa demostrador de teoremas basado en lógica proposicional (General Problem Solver, por Newell, Shaw y Simon en 1957). 1.4.2 Década 60’s En la década de los 60's con la llegada del lenguaje LISP se dio uno de los primeros pasos para avanzar dentro de los terrenos de la I.A. Sin embargo los sistemas desarrollados sólo eran simuladores de aplicaciones específicas que distan todavía de nuestra definición de la IA. LISP, desarrollado por McCarthy en 1959 y publicado en 1962 es un lenguaje que reconoce solamente dos tipos de entidades, átomos y listas; la lista es una estructura en árbol binario. El LISP no distingue entre procedimientos y datos y es muy modular, es muy fácil de añadirle reglas o conocimientos. Esta última cualidad permitió su rápida adopción por los investigadores de IA durante la década de los 60’s. En esta década se sentaron los principios básicos de la investigación en las estructuras en árbol así como el movimiento de ideas empleadas actualmente en la resolución de problemas y los sistemas expertos. Los textos Newell y Simon (1972) y Nilsson(1971) marcan el final de este período. Los principales métodos en estrutura de árbol, que todavía se emplean hoy en los programas de sistemas expertos, estaban ya disponibles en aquel tiempo. 1-8 Gustavo León 2015 Pero las realizaciones de los investigadores se concentraron especialmente en problemas fáciles de describir, pero muy complejos de resolver, por ejemplo, el juego del ajedrez o la demostración de teoremas matemáticos. Precisamente lo que ha llegado a ser el principal campo de aplicación de la IA son los problemas imprecisamente definidos que constan de un gran número de reglas y de hechos pero de una complejidad estratégica limitada, no habían sido abordados en aquel tiempo. Los investigadores comenzaron a considerar problemas que eran simples de describir donde todo era conocido con certidumbre y donde tenía que construirse una profunda y potencialmente amplia estructura de árbol. En la década del 60 se comienza en el MIT el estudio de la visión artificial, lo cual implica no solo captar imágenes a través de una 1.4.3 Década 70’s En la década de los 70's los programas e investigaciones se enfocan hacia la naturaleza del conocimiento. Investigadores de distintas procedencias (informática, psicología filosofía y matemáticas) intentan determinar lo que es el conocimiento. Después de la manera más natural, dirigen su atención a la más compleja de las formas del conocimiento, es cámara, sino también la comprensión, por parte del ordenador, de lo que estas imágenes representan. Un resultado importante en este trabajo lo constituye el "mundo de micro-bloques", en el cual un robot era capaz de percibir un conjunto de bloques sobre una mesa, moverlos y apilarlos; el éxito se debió a los investigadores Larry Roberts, Gerald Sussman, Adolfo Guzman, Max Clowes, David Huffman, David Waltz, Patrick Winston, y Berthold Horn. decir, a la que es inexacta, mal definida e implícita, en otras palabras: el sentido común del hombre de la calle. En esta década (70’s) se desarrollan los primeros lenguajes orientados a la I.A. (ver Tabla “Lenguajes Orientados a la Inteligencia Artificial”), En esta década los investigadores sintieron la necesidad de enriquecer el LISP y de diseñar lenguajes en los que el control del razonamiento deductivo fuese fácil de escribir y de comprobar, siendo éste el 1-9 Gustavo León 2015 período en el que surgen los primeros lenguajes orientados a objetos como son el SIMULA-67 (Dhal, Myhrhaug, Nygaard, 1970) y SMALLTALK-72 de Xerox (Kay, 1976) que es el primero y genuino lenguaje orientado a objetos. Es en esta época cuando surge también la primera generación de sistemas expertos que se constituyeron en los antecesores de los actuales sistemas inteligentes. Dos grandes éxitos de sistemas desarrollados en la década de los 70's son PROSPECTOR desarrollado por Standford Research Institute (Duda & Hart) en 1974, que ha ayudado a la detección de importantes yacimientos minerales. Este sistema experto dio mucho de qué hablar, al ser la clave para el descubrimiento de un yacimiento de Molibdeno cuyo valor en su tiempo fue estimado en alrededro de 100 millones de dólares. en 1986 representó un ahorro de 40 millones de dólares anuales. En esta misma década de los 80’s se retomaron conceptos y teorías sobre Redes Neuronales para convertirse en una de las fuentes más promisorias en busca de la Inteligencia Artificial. El lenguaje de programación Python fue creado a finales de los ochenta por Guido van Rossum en el Centro para las Matemáticas y la Informática (CWI, Centrum Wiskunde & Informatica), en los Países Bajos, como un sucesor del lenguaje de programación ABC, capaz de manejar excepciones e interactuar con el sistema operativo Amoeba.3. Python es un lenguaje de programación interpretado cuya filosofía hace hincapié en una sintaxis muy limpia y que favorezca un código legible. Se trata de un lenguaje de programación multiparadigma, ya que soporta orientación a objetos, programación imperativa y, en menor medida, programación funcional. Es un lenguaje interpretado, usa tipado dinámico (habilidad de que una misma variable pueda tomar valores de distinto tipo en distintos momentos) y es multiplataforma. Y el sistema MYCIN(Shortliff e) diseñado en la Universidad de Standford en el año de 1977 el cual es un sistema de diagnóstico de enfermedades infecciosas de orden bacteriano. 1.4.5 Década 90’s En la década de los 90’s nuevas técnicas fueron probadas como los Modelos de Markov Ocultos y los Algoritmos Genéticos, destacando El Sistema Experto “Deep Blue” que en 1997 ha derrotado al más grande ajedrecista de nuestros tiempos: Gary Kasparov, lo cual ha sido considerado como uno de los más grandes logros de la IA hacia el final del siglo XX. 1.4.4 Década 80’s En la década de los 80’s se comenzaron a comercializar los Sistemas Expertos. El primer sistema comercial denominado R1 (McDermott, Digital Equipment Corporation1982), se utilizaba en la elaboración de pedidos de nuevos sistemas de cómputo. Esto En los 80's y los 90's también se han dado cambios significativos debido al vertiginoso avance en la parte de 1-10 Gustavo León 2015 dentro de la investigación y desarrollo de ciertas tecnologías. Esta ya es una nueva disciplina, a la cual se aplicaran principios biológicos a sistemas computacionales ya que promete ser la rama más importante y revolucionaria en cuanto a la tecnología. Las aplicaciones de la vida artificial se pueden encontrar en alguno de estos casos: hardware de los sistemas. El alto grado de integración y la reducción del costo en este renglón han permitido desarrollar nuevas técnicas y poner en práctica viejas teorías. • Los sistemas complejos adaptativos, • 1.4.6 Década 00’s En esta Primera década del siglo 21 se ha generado un debate en dos grandes corrientes una denominada “neats" y otra llamada “scruffies”. Mientras los “neats” buscan y demuestran con métodos científicos y desarrollan descripciones formales, los “scruffies” se apoyan en técnicas empíricas y tratan de simplificar la disciplina con explicaciones más directas sin palabras rebuscadas ni complicaciones. • • • En esta década es también en la cual tiene un gran auge un nuevo concepto relacionado con la IA denominado, Vida Artificial (VA). que han dado paso a una nueva generación de sistemas expertos, que son capaces de aprender y evolucionar. Los autómatas celulares, que imitan funciones de los organismos celulares en programas complejos, aplicando el conocimiento biológico de los mismos a principios prácticos de organización en sistemas de cómputo. Los agentes autónomos que son cada día más usados en aplicaciones de búsqueda. En el conocimiento de comportamientos adaptativos, para el desarrollo de robots adaptativos. La computación cuántica, que a través del uso de las propiedades cuánticas de los átomos y sus desplazamientos, posibilitara una nueva forma de cálculos binarios. En muchos campos de la vida artificial se plantea dos tipos de simulaciones las cuales ayudan a una toma de decisión en el mundo real las cuales son: La vida artificial pretende crear vida mediante la imitación de procesos y comportamientos de los seres humanos, todo esto con el objetivo de solucionar problemas del mundo real. • La primera de ellas está basada en la realidad, centrándose en los aspectos “a más alto nivel” de cada problema utilizando fórmulas y reglas o hechos históricos que ayudan a la toma de decisiones. Un ejemplo de esto pueden ser las fórmulas del tiro La vida artificial que tienen como objetivo la aplicación del conocimiento sobre el funcionamiento de cierto fenómeno el cual se denomina de una manera genérica: vida, y su aplicación 1-11 Gustavo León 2015 parabólico ya que estos pueden entenderse como modelos de simulación. • La segunda también está basada en la realidad, poniendo atención en los aspectos “a más bajo nivel”, mediante fórmulas o reglas, una de las ventajas de este tipo de simulaciones es que sus características son más sencillas, ya que suelen ser más fáciles de detectar. 1.4.6 Década 10’s Watson consistentemente superó a sus oponentes humanos en el dispositivo de señalización empleado por el juego, aunque tuvo problemas en responder a algunas (realmente pocas) categorías, notablemente compuestas de pistas cortas con pocas palabras. Para cada pista, las respuestas más probables de Watson fueron mostradas por la pantalla de televisión. Watson tuvo acceso a 200,000,000 páginas de contenido, estructurado y no estructurado, que consumió cuatro terabytes de almacenamiento en disco, incluyendo el texto completo de la Wikipedia en inglés. Watson no fue conectado al Internet durante el juego. En nuestra década actual, un evento relevante ha sido, la competencia entre una supercomputadora creada por IBM (nuevamente) y que denominaron “Watson” (en honor al primer presidente y fundador de la compañía), y dos humanos sobresalientes en el tipo de desafío en el que se enfrentaron. También podemos incluir como parte de la cronología de la década 10’s las iniciativas para desarrollar el Conectoma Humano, mencionadas en la sección anterior correspondiente a los Paradigmas de la I.A. A lo largo de tres días en febrero de 2011, para probar las capacidades reales de la máquina, se llevó a cabo una partida especial de dos juegos en el concurso de televisión estadounidense Jeopardy!, derrotando a sus dos oponentes humanos: Brad Rutter, el mayor ganador de dinero en toda la historia del programa, y Ken Jennings, el poseedor del récord por la racha más larga de campeonatos (después de haber ganado 75 partidos). Ejercicio 1.c Ver el video de Kasparov vs. Deep Blue Formar equipos de trabajo según instrucciones del profesor y analizar los paradigmas mostrados en el video. 1-12 Gustavo León 2015 le permite prácticamente cualquier cosa. Por ejemplo, si es interrogada sobre la pregunta “¿Cuánto es 12,324 por 73,981?”, podría tardarse algunos minutos en responder. Nuestras conclusiones al respecto de la prueba de Turing son: • Su naturaleza empírica la limita a un nivel básico • No existe una medición de la magnitud de Inteligencia que una máquina posee 1.5 Prueba de Turing Una de las preguntas más importantes a resolver por cualquier científico o investigador en un proyecto, es la determinación de si éste ha sido exitoso. La Inteligencia Artificial no es la excepción. ¿Cómo sabremos si hemos construido una máquina inteligente? Por su sencillez, no requiere demostraciones ni justificaciones. En 1950, Alan Turing propuso el siguiente método para determinar si una máquina puede pensar o no. Este método ha sido denominado como Prueba de Turing. Para efectuar este método, se necesitarán dos personas y la máquina que va a ser evaluada. Una de las personas jugará el papel de interrogador. El interrogador puede de 1.5.1 Premio Loebner El Premio Loebner es una competencia anual que concede premios a un programa de computadora que esté considerado por el jurado que lo compone, como el más inteligente de los que se han presentado. El formato de la competencia sigue el estándar establecido en la prueba de Turing. Un juez humano se enfrenta a dos pantallas de computadora, una de ellas que se encuentra bajo el control de un sistema de cómputor, y la otra bajo el control de un humano. El juez plantea preguntas a las dos pantallas y recibe respuestas. En base a las respuestas, el juez debe decidir qué pantalla es la controlada por el ser humano y cuál es la controlada por el programa de computadora. hacer preguntas ya sea a la persona o a la computadora tener conocimiento de cual es cual. El interrogado sólo puede identificarlos como A ó B y su tarea será la de determinar cuál de ellos es la persona y cual la máquina. La meta de la máquina es engañar al interrogador para hacerlo creer que es la persona. Si la máquina tiene éxito en esto, se concluirá en que la máquina puede pensar. A la máquina se 1-13 Gustavo León 2015 ¿Cuáles considera que son los hechos de la Inteligencia Artificial y lo que pudiera representar una ficción? Ejercicio 1.d Ejercicio 1.e Formar equipos de trabajo según instrucciones del profesor y responder a los siguientes cuestionamientos: Se otorgará un punto extra acreditable al primer examen teórico, para aquellos que coloquen una pregunta de la sección 1.4 (Antecedentes históricos) de esta unidad como post en muro del facebook de la materia. Para acreditarse el punto alguien diferente debe de contestar correctamente la pregunta en cuyo caso el que responda tendrá también un punto extra. El máximo de puntos acreditables por alumno es de 5. En la página http://uat.gustavoleon.com.mx pueden encontrar la liga así como la fecha límite para completar el ejercicio. ¿Es la Inteligencia humana perfecta? ¿Es la Inteligencia humana superior a la de las máquinas? ¿En qué aspectos si, y en qué aspectos, no? ¿Sería deseable duplicar solamente aspectos positivos de la Inteligencia humana o los negativos también? Son las emociones parte de la inteligencia o un hecho separado de ella? 1-14 Gustavo León 2015