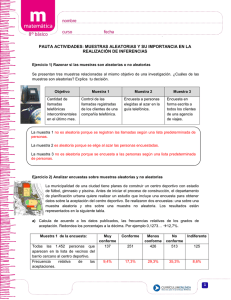

Modelos estocásticos en las finanzas

Anuncio