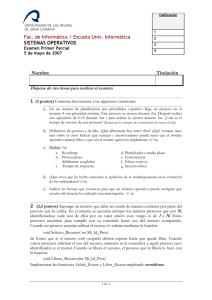

Evaluación de pronóstico de una red neuronal sobre el PIB en

Anuncio