Iconos - Ruidera - Universidad de Castilla

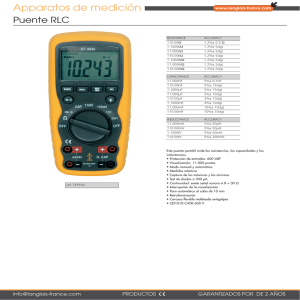

Anuncio