Análisis Empírico de la Volatilidad Estocástica y

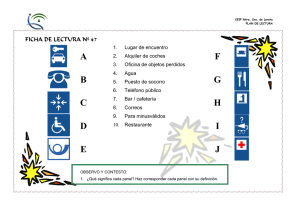

Anuncio

Análisis Empírico de la Volatilidad Estocástica y

Saltos para Modelos en Tiempo Continuo de

Índices Bursátiles utilizando el EMM

Ana González

(Universidad del País Vasco)

Septiembre 2008

Resumen

Este artículo analiza, utilizando el Método Eficiente de Momentos EMM, un modelo en

tiempo continuo de difusión para la volatilidad estocástica con y sin saltos en

rentabilidad. Encontramos que la volatilidad estocástica por sí misma no es suficiente

para describir la distribución de rendimientos y que para aproximar con éxito su

dinámica es fundamental, además de considerar volatilidad estocástica, incorporar saltos

en rentabilidad. Con esta especificación logramos reproducir la asimetría y curtosis

existente en los rendimientos de cuatro índices bursátiles distintos: el S&P 500, para

datos diarios entre 1986 y 2005, y el DAX 30, IBEX 35 y CAC 40, estos últimos entre

1988 y 2003, extendiendo así la poca evidencia existente para datos estadounidenses a

otros índices de la zona euro.

Palabras clave: volatilidad estocástica, saltos, Método Eficiente de Momentos (EMM), SNP, polinomios

de Hermite, asimetría, curtosis

JEL: C13, C14, C15, C32

La autora agradece la ayuda económica recibida por el Plan Nacional de I+D+I (proyecto SEJ200606309) y en especial a Mª Paz Espinosa. También quiero agradecer a Alfonso Novales y Gonzalo Rubio

su inestimable ayuda.

1

Introducción

El éxito alcanzado en los últimos treinta años al utilizar modelos de difusión simples

para aproximar el proceso estocástico de los rendimientos de activos financieros no

tiene precedentes. Sin embargo, las llamadas sonrisas de volatilidad calculadas al

utilizar la volatilidad implícita del venerado modelo de Black-Scholes revelan que un

simple proceso geométrico browniano no es suficiente para capturar algunas

características importantes de los datos. Además, la evidencia empírica sugiere que las

decisiones financieras basadas en un marco en tiempo continuo serán satisfactorias sólo

si se construye sobre especificaciones razonables del proceso de rendimientos del activo

subyacente. En otras palabras, es fundamental que la distribución verdadera del

subyacente sea consistente con la distribución impuesta por el modelo teórico.

Datos de rendimientos de alta frecuencia muestran exceso de curtosis (distribuciones de

colas anchas; leptocurtosis), asimetría, efecto apalancamiento y agrupamiento de la

volatilidad. Capturar estas singularidades esenciales con un modelo paramétrico

parsimonioso y a la vez tratable es complicado.

Es aceptado en la literatura que la introducción de volatilidad estocástica o saltos puede

explicar estas características de los rendimientos de activos, pero los resultados para

datos estadounidenses son contradictorios, y muchas veces fracasan a la hora de ajustar

satisfactoriamente la dinámica del proceso de rendimientos del activo subyacente.

Andersen, Benzoni y Lund (2002), Chernov, Gallant, Ghysels y Tauchen (2003) y

Eraker, Johannes y Polson (2003) estiman modelos con volatilidad estocástica, saltos en

precios y, en los dos últimos, saltos en volatilidad. Todos ellos encuentran fuerte

evidencia empírica de la presencia de volatilidad estocástica y saltos en precios, pero no

coinciden respecto a la presencia e importancia de saltos en volatilidad.

Existe un desacuerdo similar respecto a la especificación entre los estudios que utilizan,

en lugar de series temporales de rendimientos del subyacente, datos de precios de

opciones. En este caso, la especificación se evalúa mediante ajuste de precios de

opciones, frente al ajuste de la distribución condicional de las series temporales. Bakshi,

2

Cao y Chen (1997) concluyen que además de la volatilidad estocástica, los saltos en

precios son fundamentales, pero Bates (2000), Eraker (2004) y Pan (2002) dicen que

éstos son económicamente pequeños y que sus beneficios son insignificantes.

En este artículo estimamos para datos diarios de rentabilidades del S&P 500, entre 1986

y 2005, del DAX 30, del IBEX 35 y del CAC 40, estos últimos entre 1998 y 2003, un

modelo en tiempo continuo de difusión para la volatilidad estocástica con y sin saltos en

rentabilidad, y analizamos los resultados sobre todo examinando la forma de la

distribución de rendimientos, en particular, los momentos de tercer y cuarto orden.

Con un modelo que incorpore ambos componentes, volatilidad estocástica y saltos en

rentabilidad, logramos reproducir la asimetría y curtosis existente en los datos de los

cuatro índices estudiados, lo que proporciona evidencia empírica apoyando la presencia

conjunta de ambos factores a la hora de describir la distribución de índices bursátiles

alejados de la normal, no sólo para el caso estadounidense para el que existen ya

evidencias en este sentido sino también para los tres índices europeos restantes,

confirmando el resultado. Encontramos además que incorporar saltos en rentabilidad

mejora el ajuste en términos de especificación del modelo, aunque el hecho de que éste

siga rechazándose sugiere que, a pesar de que junto a la volatilidad estocástica los saltos

en rentabilidad son los dos componentes más importantes para describir la dinámica de

las series temporales de rendimientos, pueden no ser suficientes y haga falta añadir algo

más, como saltos en volatilidad, tal y como documentan Broadie, Chernov y Johannes

(2007) y Eraker, Johannes, y Polson (2003) entre otros. Por otro lado, puede que el no

conseguir en ningún caso buena precisión en la estimación del parámetro de correlación

entre rentabilidad y varianza, sea consecuencia de imponer una correlación constante en

el tiempo. Esto indica una segunda línea de investigación futura: estudiar la posibilidad

de que la correlación dependa de una variable de estado, ya sea la rentabilidad o la

propia varianza, dejando que sea la estimación quién determine si es o no constante.

Estimamos los modelos de interés primero para USA, ya que, que nosotros sepamos,

únicamente existe literatura al respecto en este caso, lo que nos sirve de referencia tanto

en el desarrollo de la metodología de estimación como en el análisis de los resultados

intermedios y finales. Pero el objetivo último de este artículo es analizar las cuestiones

de interés para la zona euro, aportando una visión global sobre mercados del centro-sur

3

de Europa, sobre los que tenemos muy poca evidencia o nada en tiempo continuo. Por

ello, una vez obtenidos los resultados para datos estadounidenses y superadas las

dificultades metodológicas producidas en el proceso de estimación, examinamos los

mismos modelos para datos europeos, en particular, alemanes, españoles y franceses,

extendiendo así la poca evidencia existente a otros índices europeos.

Hasta no hace mucho, el mayor obstáculo en el desarrollo de esta literatura era la falta

de técnicas factibles para la estimación e inferencia de modelos generales en tiempo

continuo utilizando observaciones discretas.

La mayor dificultad a la hora de llevar a cabo una inferencia eficiente para un modelo

en tiempo continuo a partir de datos muestrales discretos, es que generalmente no suelen

estar disponibles expresiones cerradas para la densidad de transición discreta,

especialmente en presencia de variables de estado no observadas y serialmente

correladas. Este último es el caso más usual, por ejemplo, para modelos de volatilidad

estocástica.

La necesidad de un marco general eficiente para la inferencia nos lleva a adoptar una

variante del método simulado de momentos SMM (Simulated Method of Moments) de

Duffie y Singleton (1993), que junto al estimador bayesiano MCMC (Markov Chain

Monte Carlo), dominan al resto de metodologías, en tratabilidad y eficiencia

econométrica, especialmente en situaciones en donde una o más variables son latentes o

el proceso incorpora especificaciones de saltos.

El SMM iguala los momentos muestrales a los momentos simulados obtenidos a partir

de largas series simuladas usando el mecanismo generador de datos asumido (el modelo

estructural elegido). Nosotros empleamos el método de momentos eficiente EMM

(Efficient Method of Moments) propuesto por Bansal, Gallant, Hussey y Tauchen (1993,

1995) y desarrollado por Gallant y Tauchen (1996). El EMM es un procedimiento de

ajuste de momentos basado en simulación pero con ciertas ventajas. Refina el enfoque

SMM dando una receta específica para la generación de condiciones de momentos.

Éstos se obtienen de la expectativa del gradiente de la verosimilitud de un modelo semino-paramétrico auxiliar, SNP, en tiempo discreto que se aproxima a la distribución de

los datos de la muestra discreta, donde el gradiente de la verosimilitud no es más que la

4

primera derivada de la función de log-verosimilitud con respecto a los parámetros del

modelo auxiliar. Los momentos ajustados son por tanto los elementos del gradiente de

la verosimilitud de un modelo auxiliar. Si este modelo auxiliar aproxima bien la

distribución de los datos, entonces, las estimaciones de los parámetros del modelo

estructural son eficientes como si se hubiera empleado máxima-verosimilitud (Tauchen,

1997a; Gallant y Long, 1997). Esta es una característica atractiva del EMM, que obtiene

la misma eficiencia que máxima-verosimilitud cuando el gradiente de la verosimilitud

del modelo auxiliar (asintóticamente) abarca al gradiente de la verosimilitud del modelo

verdadero. Las densidades SNP son buenas candidatas para este propósito y

básicamente consisten en utilizar una densidad gaussiana como término principal al que

se añade una expansión polinómica para recoger las características no gaussianas del

proceso. Debido a la sofisticación de este último término, en este artículo consideramos

primero un modelo auxiliar más sencillo (en particular, un GARCH(1,1), que es

únicamente gaussiano, aunque dentro de la familia SNP) obteniendo unas estimaciones

iniciales para los modelos de volatilidad estocástica con y sin saltos en rentabilidad, que

nos servirán de referencia en las estimaciones al extender mediante polinomios el

modelo auxiliar.

En este sentido, en contra de lo que a priori esperábamos, parece que en general los

polinomios no contribuyen apenas a la capacidad explicativa de los momentos de tercer

y cuarto orden tan bien ajustados por el modelo de volatilidad estocástica con saltos

cuando el modelo auxiliar considerado es el GARCH(1,1). Únicamente para el IBEX 35

el ajuste global de ambas características es mejor al considerar polinomios en la

densidad SNP, aunque también depende de la valoración relativa que se asigne al ajuste

de uno u otro momento, y es que en el caso del IBEX 35, se mejora el ajuste en

asimetría, pero se pierde precisión al aproximar la curtosis. Algo similar ocurre para el

CAC 40. El ajuste conjunto de ambos momentos empeora al extender el modelo auxiliar

porque la asimetría se ajusta muy mal, pero la curtosis se reproduce con una precisión

prácticamente perfecta.

Los resultados se juzgan mediante los test de especificación y diagnosis de modelo

asociados. Al igual que el GMM (Generalized Method of Moments), el EMM se puede

usar para construir un estadístico Chi-cuadrado para un test conjunto de sobre

identificación, que nos dirá si el modelo estimado es el correcto, y que permite

5

comparar representaciones no anidadas. Además, en caso de fracaso del modelo, la

inspección del gradiente de la verosimilitud puede sugerir razones de dicho fracaso, ya

que los diferentes elementos del gradiente de la verosimilitud se corresponden con

diferentes características de los datos.

2

Modelos y Metodología de Estimación

2.1 Modelos

2.1.1 Modelo de Volatilidad Estocástica SV

El agrupamiento de la volatilidad es una característica importante de los datos. La

volatilidad estocástica es una extensión natural de los modelos de difusión ampliamente

utilizados en la literatura de valoración de activos. Hull y White (1987), Melino y

Turnbull (1990), Wiggins (1987) entre otros, generalizan la tradicional especificación

del movimiento browniano geométrico sugiriendo un proceso propio para la volatilidad

estocástica. Así, Heston (1993), en una contribución clave para la literatura de

valoración de opciones admite, a diferencia de los anteriores, la correlación entre los

brownianos del subyacente y la varianza, además de obtener expresiones de valoración

de opciones mediante la inversión de Fourier de la función característica condicional.

El modelo de volatilidad estocástica fue propuesto para describir datos de mercados

financieros por Clark (1973), Tauchen y Pitts (1983), Taylor (1986) y otros. El atractivo

de este modelo es que proporciona una especificación simple para los movimientos en

los precios explicando, en términos cualitativos, singularidades generales de los datos

recogidos de los mercados financieros como son la leptocurtosis y la persistencia en

volatilidad. Además, está relacionado con procesos de difusión utilizados para

valoración de derivados (Harvey et al., 1994; Danielsson, 1994).

Denotamos S t el precio en el instante t de un índice bursátil y consideramos el

siguiente modelo de volatilidad estocástica en raíz cuadrada, SV:

6

dS t

= µdt + Vt dW1,t

St

(1)

donde el proceso de varianza V obedece un proceso de difusión con reversión a la

media:

dV t = (α − β Vt )dt + η Vt dW 2 ,t

(2)

Los factores W1 y W2 son movimientos brownianos estándar con correlación

cov(dW1,t , dW2,t ) = ρdt .

La volatilidad estocástica induce exceso de curtosis gobernada en su mayor parte por los

parámetros de volatilidad α , β y η . Más concretamente, el exceso de curtosis se

genera por la volatilidad de la varianza, η . Si la varianza es muy volátil la probabilidad

de observar grandes shocks en rendimientos aumenta, aumentando así la anchura en las

colas de la distribución. β es la velocidad con la que el proceso revierte a la varianza de

largo plazo ( α β ), y captura la persistencia en varianza. Un valor de β distinto de cero

sugiere persistencia en varianza, mientras que si β es cero, entonces la varianza

condicional seguirá un paseo aleatorio. La asimetría que generalmente se observa en el

proceso de rendimientos se puede capturar mediante una correlación negativa entre

shocks en la varianza y el proceso de rendimientos, es decir, ρ < 0, ya que en este caso

la volatilidad aumenta cuando los precios disminuyen, lo que hace más probable que se

produzcan grandes rendimientos negativos. Esta especificación en raíz cuadrada para la

varianza es particularmente atractiva para aplicaciones en valoración de opciones, desde

que Heston (1993) proporcionara una solución en forma cerrada para el precio de la

opción cuando el proceso subyacente de rendimientos obedece un modelo de este tipo.

El supuesto fundamental es que el precio del riesgo de la varianza se supone

proporcional a la raíz cuadrada del nivel de riesgo.

2.1.2 Modelo de Volatilidad Estocástica con Saltos SVJ

Como ya hemos dicho anteriormente, los modelos de volatilidad estocástica están

específicamente diseñados para capturar las propiedades sobresalientes de la volatilidad

como son la aleatoriedad y la persistencia. Sin embargo, uno de los descubrimientos

7

recientes más importantes es que parece que estos modelos no son capaces de

caracterizar todos los aspectos de la distribución de rendimientos de activos. En efecto,

parece que, dado un ajuste razonable de la dinámica de la volatilidad condicional, los

modelos de volatilidad estocástica no pueden ajustar la alta curtosis condicional de los

rendimientos (colas anchas) documentada en la literatura para muchas clases de activos

financieros.

Extenderemos por tanto la especificación anterior incluyendo un componente salto:

(

)

dS t

= µ − λ(t )k dt + Vt dW1,t + k (t )dq t

St

(3)

donde el proceso de varianza V obedece un proceso de difusión con reversión a la

media dado por la expresión (2):

dVt = (α − βVt )dt + η Vt dW2,t

Los factores W1 y W2 son movimientos brownianos estándar con correlación

cov(dW1,t , dW2,t ) = ρdt ; q es un proceso de Poisson, incorrelado con W1 y W2 y

gobernado por la intensidad de salto λ(t ) , de forma que Pr (dqt = 1) = λ(t )dt donde se

supone que la intensidad de salto es constante λ(t ) = λ0 . El factor k (t ) denota la

magnitud de salto en el proceso de rendimientos si se da un salto en el instante t . Se

supone

que

dicha

(

magnitud

de

salto

se

distribuye

como

una

normal:

)

ln (1 + k (t ) ) ≈ N ln(1 + k ) − 0.5δ 2 , δ 2 . Por último, k mide la magnitud media de salto,

de manera que la tasa de crecimiento media provocada por los saltos es λ(t )k . El

término de corrección λ(t )kdt compensa el componente salto.

Desde un punto de vista económico, los saltos en rendimientos de acciones se justifican

fácilmente. La llegada discreta de nueva información induce una revisión instantánea de

los precios de las acciones. Añadir un componente salto debería mejorar el ajuste a las

series temporales de rendimientos observadas, puesto que los saltos ayudarán a

acomodar los outliers así como la asimetría en la distribución de rendimientos. La

8

presencia de outliers depende de la magnitud y variabilidad del componente salto,

mientras que la asimetría se controla mediante la magnitud media de salto, k , de

manera que si ésta es negativa (positiva) entonces es reflejo de asimetría negativa

(positiva). En este sentido, el modelo con saltos tiene dos posibles fuentes de asimetría:

la magnitud media del salto k y la correlación entre brownianos ρ .

La presencia conjunta de los factores de salto y volatilidad estocástica proporciona

flexibilidad adicional para capturar las características sobresalientes de los

rendimientos, incluyendo la asimetría y leptocurtosis.

2.2 Metodología de Estimación: EMM

La estrategia de estimación es la siguiente: en un primer paso, se obtiene una estimación

de la densidad condicional de la serie de rendimientos del índice, basada en la

estimación por quasi-máxima verosimilitud (QML). Si se implementa con cuidado, los

elementos del gradiente de la verosimilitud QML resultantes proporcionan una

representación adecuada de las singularidades sobresalientes de los datos. En un

segundo paso, se estiman los parámetros estructurales (los del modelo estructural)

buscando el vector de parámetros que permita que la difusión asumida (representada

como el valor esperado del gradiente de la verosimilitud QML) simule las

características esenciales de los datos, de la manera más próxima posible. Formalmente,

en esta etapa el procedimiento sigue al GMM al minimizar una forma cuadrática de los

elementos del gradiente de la verosimilitud esperados. Este paso se implementa

mediante simulación, ya que no es factible calcular el gradiente de la verosimilitud bajo

el modelo real. Consecuentemente, y como ya se ha comentado anteriormente, este

enfoque es, en ciertos aspectos, similar al SMM de Duffie y Singleton (1993). Además,

debido a que el paso final se basa en los principios del GMM, el estadístico Chicuadrado de bondad de ajuste usual de sobre identificación de restricciones sirve aquí

como un test de especificación general, y, en extensión, los elementos individuales del

gradiente de la verosimilitud se asocian a distintas características de los datos, por lo

que el ajuste de cada uno de estos elementos indica cómo de bien se están acomodando

los rasgos particulares de los datos.

2.2.1 Modelo Auxiliar

9

La clave para aplicar con éxito el EMM es elegir un modelo auxiliar que se aproxime

bien a la distribución condicional del proceso de rendimientos. Gallant y Long (1997)

demuestran que, dentro de la clase de modelos en tiempo discreto, las densidades SNP

(Semi-NonParametric) son buenas candidatas para este propósito.

Los modelos SNP se basan en la noción de que puede usarse una expansión polinómica

como estimador no paramétrico de una función de densidad (veáse Gallant y Nychka,

1987). Además, la densidad SNP permite un término principal que puede usarse para

capturar las características sistemáticas dominantes de la dinámica del rendimiento (en

tiempo discreto), dando una representación parsimoniosa para la densidad condicional

de las series observadas. El paso inicial de ajustar dicha densidad condicional con un

modelo semi-no-paramétrico es importante y costoso. La estrategia básica es utilizar

una expansión de polinomios de Hermite al cuadrado como aproximación de la

densidad condicional. En general, esto implica utilizar una densidad gaussiana como

término principal, mientras que los polinomios adaptan las características no gaussianas

del proceso. Esto sugiere una selección cuidadosa del término principal, eligiendo como

modelo el mejor candidato posible para el proceso de rendimientos, mientras que

permitimos que la expansión polinómica de Hermite adapte las desviaciones de este

término principal. Por último, la calidad del ajuste de los distintos modelos se evalúa

utilizando criterios de información estándar, como son los criterios Akaike (AIC),

Bayesiano (BIC) y Hannan-Quinn (HQC), así como mediante test de especificación,

teniendo en cuenta que el comúnmente utilizado criterio de Akaike tiende a

sobreparametrizar los modelos.

Más específicamente, el modelo auxiliar SNP se construye de la forma siguiente. Sean

rt , xt = (rt −1 ,..., rt − L ), t = 1,..., ∞ las variables aleatorias correspondientes a los procesos de

rendimientos

del

índice

y

retardos

de

dichos

rendimientos

y

~

rt , ~

xt = (r~t −1 ,, r~t − L ), t = 1,..., n los datos muestrales observados. El hecho de que la

volatilidad sea una variable latente y serialmente correlada con la serie de rentabilidades

hace que la densidad de transición y por tanto la verosimilitud sea imposible de

computar. El objetivo es entonces estimar la densidad condicional p(rt xt ) que describe

completamente el proceso. Gallant y Tauchen (1989) proponen una clase de densidades

condicionales SNP, f K (r x; ξ ) , muy adecuadas para este propósito, ya que para un K

10

suficientemente alto f K es una buena aproximación de la densidad condicional p(rt xt )

(

)

~

y además, si los parámetros ξ se estiman por QML, f K r x; ξ es un estimador no

paramétrico consistente (Gallant y Nychka, 1987), eficiente (Fenton y Gallant, 1996a;

Gallant y Long, 1997) y con propiedades cualitativas deseables (Fenton y Gallant,

1996b).

El proceso que se está analizando es rt (ψ ) donde ψ son los parámetros del modelo

estructural a estimar. υt (ξ ) = Et −1 [rt (ψ )] es la media condicional del modelo auxiliar,

ht (ξ ) = Vart −1 (rt (ψ ) − υt (ξ )) es la varianza condicional y z t (ξ ) =

rt (ψ ) − υt (ξ )

ht (ξ )

es el

proceso estandarizado, que se supone es i.i.d. De esta forma, una vez elegida la

especificación de la parte principal de la SNP, es decir, una vez elegidos los modelos

para la media, υt , y varianza del proceso, ht , la estimación QML del modelo auxiliar se

lleva a cabo de la forma siguiente:

~

1 n

ξ = arg max ∑ ln [ f K (~

rt | ~

xt ; ξ )]

ξ

n t =1

(4)

donde ξ son los parámetros del modelo auxiliar a estimar mediante QML y f K es la

función de densidad SNP que toma la siguiente forma:

[PK (z t , x t )]2 φ(z t )

f K (rt | x t ; ξ ) = ν + (1 − ν )

2

∫R [PK (u , x t )] φ(u )du ht

(5)

con ν pequeño (0.01); esta mixtura en la densidad condicional se utiliza para evitar la

inestabilidad durante la estimación EMM, ya que, en su defecto, pueden darse

problemas numéricos al evaluar la función f K si, para una trayectoria simulada dada,

PK ( z t , xt ) es igual a cero. φ(⋅) es la densidad normal estándar,

11

zt =

rt − υ t

(6)

ht

y PK ( z , x ) es un polinomio en ( z , x ) de grado K = (K z , K x ) dado por la expresión

siguiente:

Kz

Kz

Kx

PK ( z , x ) = ∑ a i (x )z i = ∑ ∑ a ij x j z i , a 00 = 1

i = 0 j =0

i =0

(7)

El término constante a 00 se fija en 1 para obtener una representación única. Con esta

normalización, la densidad f K se interpreta como una expansión cuyo término principal

es la densidad normal φ( z ) y cuyos términos de orden superior inducen desviaciones de

la normal.

La ventaja de la expansión rectangular (7) de PK ( z, x ) es que éste se interpreta como un

polinomio en z de grado K z , cuyos coeficientes son a su vez polinomios de grado K x

en x .

La expresión (5) para la densidad SNP, f K , se obtiene aproximando mediante

polinomios PK ( z, x ) 1 la función de densidad de z t y teniendo en cuenta la relación (6)

entre rt y z t . En efecto, debido a esta relación, sabemos que

f (rt xt ) =

1 rt − υt

g

ht ht

donde g es la función de densidad de z t que se aproxima por

Se toma además una forma específica para los polinomios PK (z , x ) , los llamados polinomios

ortogonales de Hermite (veáse Gallant, Hsieh y Tauchen, 1991 y Fenton y Gallant, 1996a). El Apéndice

A proporciona las expresiones y resultados relativos a estos polinomios.

1

12

g K (z, x ) =

1

[PK (z t , x t )]2 φ(z t )

c(x )

con

c( x ) = ∫ [PK (u, x )] φ(u )du

2

R

para garantizar que la integral (de la función de densidad) sea 1.

Con esta especificación de la SNP, la principal tarea de la expansión polinómica no

paramétrica en la densidad condicional es capturar cualquier exceso de curtosis en el

proceso de rendimientos y también cualquier asimetría que no haya sido acomodada por

el término principal.

2.2.2 EMM

Una vez estimados los parámetros del modelo auxiliar, la esperanza de la función de

densidad SNP de dicho modelo proporciona las condiciones de momentos para la

estimación en tiempo continuo del modelo estructural mediante el método de momentos

simulado.

N

Denotemos {rˆt (ψ ), xˆ t (ψ )}t =1 a una simulación del modelo estructural utilizando el vector

de parámetros ψ . Entonces, la estimación de ψ se define de la forma siguiente:

( )

( )

~ '~

~

ψˆ = arg min m N ψ , ξ I −1m N ψ , ξ

ψ

(8)

( )

~

donde m N ψ , ξ es la esperanza de la función f K evaluada en la estimación quasi~

máxima verosímil de los parámetros del modelo auxiliar ξ 2:

2

La

( )

expresión

~

m N ψ, ξ = ∫

(9)

~

∂ ln f K r x; ξ

(

∂ξ

)

es

una

aproximación

(Monte

Carlo)

de

la

expectativa:

dP(r x; ψ ) .

13

( )

~

1

mN ψ, ξ =

N

N

∑

(

~

∂ ln f K rˆt (ψ ) xˆ t (ψ ); ξ

)

(9)

∂ξ

t =1

~

y la matriz de pesos I −1 es una estimación consistente de la matriz de covarianzas

asintótica de f K del modelo auxiliar que se estima a partir del gradiente3:

(

~~ ~

~ 1 ∂ ln f K rt xt ; ξ

I = ∑

∂ξ

n t =1

n

) ∂ ln f (~r ~x ; ξ~ )

K

t

∂ξ

'

t

(10)

Los resultados se juzgan mediante los test de especificación y diagnosis de modelo

asociados. Si nos fijamos en la función objetivo, vemos que el estimador EMM es un

estimador Chi-cuadrado para ψ (Gallant y Tauchen, 1996). En otras palabras, el EMM

es un método basado en simulación que usa la función de densidad de un modelo

auxiliar para definir una función objetivo GMM, la cual sabemos se distribuye como

una Chi-cuadrado y puede usarse para contrastar la adecuación del modelo. Más

concretamente,

( )

el

valor

mínimo

alcanzado

por

la

forma

cuadrática

( )

~ '~

~

f = m N ψ , ξ I −1 m N ψ , ξ (función objetivo), multiplicada por el tamaño muestral n ,

se distribuye como una χ gl2 , siendo el número de grados de libertad la diferencia entre el

número de condiciones de ortogonalidad (condiciones de momento) utilizadas, dim(ξ ) ,

y el número de parámetros estructurales estimados, dim(ψ ) . Así, se construye un

estadístico Chi-cuadrado para contrastar la sobre identificación de restricciones

(omnibus test), donde la hipótesis nula es que el modelo estructural está correctamente

especificado y que permite comparar representaciones no anidadas (Gallant, Hsieh y

Tauchen, 1997). Por tanto, bajo la hipótesis nula de que el modelo estructural es el

correcto se deduce que:

(

)

~

∂ ln f K r | x; ξ

~

~

. Lo hacemos numéricamente de la

Para determinar m N ψ , ξ e I , necesitamos calcular

∂ξ

forma siguiente:

Para j = 1,..., lk , donde lk es la longitud de ξ (es decir, el número de parámetros del modelo

auxiliar):

~

~ ~

~

~

~

~ ~

~

~

~

ln f K r | x; ξ 1 ,..., ξ j −1 , ξ j + eps, ξ j +1 ,..., ξ lk − ln f K r | x; ξ 1 ,..., ξ j −1 , ξ j − eps, ξ j +1 ,..., ξ lk

∂ ln f K r | x; ξ

=

∂ξ j

2 × eps

( )

3

(

)

(

)

(

)

donde eps = 0.01.

14

( )

( )

~ '~

~ d

2

n ⋅ m N ψˆ , ξ I −1m N ψˆ , ξ

→ χ dim

(ξ )−dim (ψ )

es decir,

( )

~

2

n ⋅ f ψˆ , ξ ~ χ dim

(ξ )−dim (ψ )

(11)

( )

~

donde f ψˆ , ξ es el valor final de la función objetivo resultante de la estimación.

En caso de fracaso del modelo, si se rechaza la hipótesis nula, es útil examinar los

~

elementos individuales del gradiente de la verosimilitud m N ψˆ , ξ que nos sugerirán

( )

razones de dicho fracaso, ya que los diferentes elementos del gradiente de la

verosimilitud se corresponden con diferentes características de los datos. Más

concretamente, debemos inspeccionar los estadísticos t , es decir, los elementos del

gradiente de la verosimilitud divididos por sus errores estándar, que vienen dados por la

raíz cuadrada de los elementos diagonales de la matriz:

S=

(

(

1 ~

~

I − Mψ Mψ 'IMψ

n

)

−1

Mψ '

)

(12)

de manera que los estadísticos t son:

tˆ =

( )

~

m N ψˆ , ξ

(13)

diag (S )

( )

~

donde M ψ es la derivada parcial del gradiente de la verosimilitud m N ψˆ , ξ respecto a

ψ 4:

4

Calculamos la matriz M ψ numéricamente. Cada columna j = 1, , dim(ψ ) = lp vendrá dada por:

(

)

(

~

~

m N ψˆ 1 ,..., ψˆ j −1 , ψˆ j + eps, ψˆ j +1 ,..., ψˆ lp , ξ − m N ψˆ 1 ,..., ψˆ j −1 , ψˆ j − eps, ψˆ j +1 ,..., ψˆ lp , ξ

2 × eps

)

donde eps = 0.01.

15

( )

~

∂m N ψˆ , ξ

Mψ =

∂ψ

(14)

Valores altos de estos estadísticos t revelan características que no están bien

aproximadas5.

Para este mismo propósito de encontrar razones de porqué el estadístico Chi-cuadrado

ha rechazado el modelo, los quasi-estadísticos t , que están subestimados, son

generalmente adecuados y son más fáciles de computar porque evitan calcular la

aproximación numérica de M ψ (Gallant y Tauchen, 1997). Estos quasi-estadísticos t se

~

calculan tomando los elementos diagonales de I como aproximaciones de los errores

estándar descritos anteriormente:

∧

qt =

( )

~

m N ψˆ , ξ

diag (qS )

(15)

donde

qS =

1~

I

n

(16)

Pero, como ya hemos dicho, este enfoque ignora el hecho de que el vector gradiente de

la verosimilitud se calcula en una estimación ψ̂ y no en el verdadero valor, por lo que

estos estadísticos t aproximados son parcialmente más bajos, lo que conlleva una

perdida de potencia si se comparan con los percentiles de la distribución normal. A

pesar de ello, Gallant, Hsieh y Tauchen (1997), subrayan que los quasi-estadísticos t

pueden ser suficientes, ya que éstos no se utilizan para inferencia, sino para únicamente

deducir sugerencias de cómo el modelo estructural puede ser mejorado.

5

Aunque se pueden calcular los intervalos de confianza de Wald para ψ j , j = 1,, dim(ψ ) de la forma

usual a partir de errores estándar asintóticos obtenidos como la raíz cuadrada de los elementos diagonales

−1

1

~

de la matriz Cov(ψˆ ) = M ψ ' I M ψ , estos intervalos, que son simétricos, son algo engañosos ya que no

n

reflejan el rápido incremento en la función objetivo EMM cuando se aproxima a un valor para el cual las

simulaciones del modelo estructural se vuelven explosivas.

(

)

16

3

Datos

Disponemos de los precios diarios del índice S&P 500 desde el 2 de enero de 1986

hasta el 30 de diciembre de 2005, una muestra de 5047 observaciones, pero se trabaja

con la serie de rendimientos, más concretamente con las diferencias logarítmicas en

porcentaje, es decir, si {S 0 , S1 ,..., S n } son los precios diarios ( n = 5046), trabajamos con

la serie

st = 100 × {ln S1 − ln S 0 , ln S 2 − ln S1 ,..., ln S n − ln S n−1 } de tamaño

n . La

frecuencia muestral diaria nos permite capturar fluctuaciones de alta frecuencia en el

proceso de rendimientos que son críticas en la identificación del componente de salto.

En cuanto a los índices europeos DAX 30, IBEX 35 y CAC 40, los datos de

rentabilidades diarias van comprendidos entre el 4 de enero de 1988 hasta el 31 de

diciembre de 2003, lo que supone un total de 4023 observaciones en el caso del DAX

30, 3996 observaciones en el caso del IBEX 35 y 4010 para el CAC 40. Al igual que

para el S&P 500 se trabaja con la serie de rendimientos en porcentaje, st , a la que, por

simplicidad, nos referiremos como rendimientos a lo largo de todo el trabajo.

La Tabla 1 presenta la media, desviación típica, asimetría y curtosis muestral de las

cuatro series, el resultado del contraste de Dickey-Fuller aumentado (ADF) de raíces

unitarias y las correlaciones entre los distintos índices. Vemos que la hipótesis de raíz

unitaria se rechaza a favor de la estacionariedad de la serie de rendimientos, condición

necesaria en cualquier método de momentos basado en la estacionariedad del proceso

generador de rendimientos. Los rendimientos de los cuatro índices bursátiles se

representan en la Figura 1. Éstos presentan un exceso de curtosis importante, lo que

implica colas más anchas en comparación con la distribución normal. También se

observa asimetría negativa, es decir, largas colas en la dirección de los rendimientos

negativos. Por tanto, el modelo de generación de datos que se asuma para los

rendimientos debe implicar distribuciones marginales no normales, con colas anchas y

posible asimetría negativa.

17

4

Modelo Auxiliar Sin Parte No Paramétrica

A pesar de que hemos justificado la necesidad de utilizar como modelo auxiliar la SNP,

eligiendo con cuidado, primero el término principal de manera que recoja las

características más importantes de los datos y segundo, el orden de la expansión

polinómica de Hermite, en esta primera aproximación al problema, y debido a la

sofisticación del mismo, nos decantamos por un modelo auxiliar más sencillo con un

doble objetivo, siempre conscientes de las limitaciones que ello conlleva. En primer

lugar, obtendremos unas estimaciones iniciales que pueden servirnos de referencia, y lo

que es más importante, en segundo lugar, este primer ejercicio de estimación nos

ayudará a ir aprendiendo sobre las dificultades metodológicas, así como de los

problemas numéricos e inferenciales que irán surgiendo al analizar en estos modelos

más simples las cuestiones de interés. Consideraremos así un GARCH(1,1) como

modelo auxiliar, sin considerar parte no paramétrica en la densidad. Sin embargo, la

elección de este modelo auxiliar sencillo imposibilita evaluar los resultados mediante

los test de especificación y diagnosis de modelo asociados al método de estimación

EMM. No es posible construir el estadístico Chi-cuadrado del test conjunto de sobre

identificación, ya que para ello es necesario que el número de parámetros estructurales

sea menor o igual que el número de parámetros auxiliares, dim(ψ ) ≤ dim(ξ ) (condición

necesaria, véase Gallant, Hsieh y Tauchen, 1997). Esta condición se precisa también

para poder obtener una estimación de la matriz de covarianzas asintótica de la

estimación del vector de parámetros estructural, así como para calcular los errores

estándar del gradiente de la verosimilitud, necesarios para construir los estadísticos t , es

decir, los elementos del gradiente de la verosimilitud divididos por sus errores estándar,

cuya inspección puede sugerirnos razones del fracaso del modelo estimado, si esto

sucede. No obstante, para este mismo propósito, los quasi-estadísticos t , a pesar de

estar subestimados, son generalmente adecuados y su cálculo es perfectamente factible

en este caso. Además, son más fáciles de computar porque evitan calcular la

aproximación numérica de la derivada parcial del gradiente de la verosimilitud con

respecto a los parámetros estructurales requerida por los estadísticos t . En cualquier

caso, hay que tener en cuenta que este modelo auxiliar está incluido dentro de los

modelos SNP en donde la parte principal de la densidad es la de un GARCH(1,1) y no

se consideran polinomios de Hermite.

18

La elección del modelo no se realiza de manera arbitraria. Es conocido que un modelo

ARMA es un candidato natural para la media condicional, mientras que una

especificación ARCH proporciona generalmente una caracterización razonable de la

pronunciada heterocedasticidad condicional de los rendimientos de acciones. Por tanto,

parece lógico elegir entre un tipo de modelo ARMA-ARCH.

En muchos casos, la especificación ARCH que recoge la estructura de autocorrelación

en varianza precisa de un elevado número de retardos, de manera que para evitar que el

alto número de coeficientes en términos autorregresivos produzca una importante

pérdida de precisión en su estimación, nos decantamos por una parametrización

alternativa, el modelo GARCH(1,1) de Bollerslev (1986).

Por otra parte, debido a la necesidad de introducir un orden relativamente alto en el

término autorregresivo de la ecuación de la media para poder capturar la estructura de

correlación de los rendimientos, y teniendo en cuenta que este comportamiento se ajusta

bastante bien mediante un único término MA(1), decidimos estimar un modelo MA(1)

para eliminar cualquier estructura dinámica de la media y centrarnos así en la dinámica

de la varianza. Tomamos, por tanto, un GARCH(1,1) como modelo auxiliar, aunque en

realidad se está considerando una especificación MA(1) para la esperanza condicional y

un GARCH(1,1) para la varianza condicional.

Por tanto, antes de estimar el modelo auxiliar, prefiltramos los datos usando un modelo

simple MA(1) para los rendimientos diarios y reescalamos los residuos para obtener la

media y varianza muestral del conjunto de datos original y trabajar con los shocks de los

rendimientos en lugar de hacerlo con los propios rendimientos. Más concretamente, se

realiza un procedimiento en dos etapas. En la primera etapa se estima la estructura de

autocorrelación MA(1), st = θ 0 + ε t − θ1 ε t −1 y se construyen los residuos. En la segunda

etapa se estima para

rt = E (s t ) + stdev(st )

εˆt − E (εˆt )

stdev(εˆt )

(17)

el modelo auxiliar dado por las expresiones para la media y varianza del proceso

siguientes:

19

υt = 0

ht = γ 0 + γ 1rt 2−1 + ϑ1ht −1 ~ GARCH (1,1)

(18)

de manera que los parámetros del modelo auxiliar a estimar son ξ = (γ 0 , γ 1 ,ϑ1 ) y se

estiman mediante QML según la expresión (4)6.

A partir de ahora consideraremos esta serie de residuos final rt como la serie de

rendimientos observada.

La Tabla 2 muestra en el Panel A las estimaciones obtenidas para los cuatro índices

bursátiles estudiados7, así como sus correspondientes errores estándar, que no son más

que la raíz cuadrada de los elementos diagonales de la matriz de pesos de la forma

cuadrática a minimizar en la estimación de los parámetros estructurales, es decir, la

inversa de la matriz de información dada por la expresión (10).

4.1 Modelo Estructural

Una vez estimados los parámetros del modelo auxiliar, tenemos que estimar los del

modelo estructural, primero el modelo de volatilidad estocástica SV y segundo el

modelo de volatilidad estocástica con saltos SVJ.

Durante el desarrollo de la estimación, cada vez que se evalúa la forma cuadrática f a

minimizar, se simula una trayectoria distinta a partir del modelo estructural. Este es un

tema importante que complicará la estimación, ya que si las simulaciones son muy

diferentes unas de otras en algún sentido, los parámetros que se caracterizaron como

óptimos con la realización anterior, pueden no ser tan buenos con la nueva, lo que

podría generar dificultades de convergencia.

N

Cada serie de rentabilidades simulada {rˆt (ψ )}t =1 se obtiene, tal y como se detalla en los

Apéndices C, para SV, y D, para SVJ, después de generar dos muestras antitéticas de

6

El modelo auxiliar escogido determina la función de densidad SNP, f K , que entra en la ecuación (4) y

que depende del vector de parámetros ξ . La forma especifica de f K se muestra en el Apéndice B.

En todos los casos γ 0 presenta un valor estimado muy alto, debido a que se trabaja con la serie de

rendimientos en porcentaje, lo que hace que dicho parámetro se multiplique por 1002.

7

20

tamaño (10000 + 1000) x 10 + 1000 a partir del modelo en tiempo continuo mediante

una discretización de Euler de primer orden con frecuencia de paso de 1/10 días. Se

descartan los primeros 1000 valores simulados para eliminar el efecto de las

condiciones iniciales y se suman de 10 en 10 el resto de valores para obtener finalmente

una serie de rentabilidades diarias de tamaño N = 11000.

Es crucial que las realizaciones que se generen para la estimación (las simulaciones)

sigan un proceso similar al de los datos reales, de manera que el modelo estructural

reproduzca las características del proceso que generó los datos. En caso contrario es

muy difícil que se pueda estimar debido a que el método de estimación es numérico.

Por ello, antes de estimar, comprobaremos que las simulaciones generadas a partir del

vector inicial de parámetros ψ 0 toman valores razonables de rentabilidades diarias, y,

por supuesto, también tiene que ser así cuando simulemos a partir de la estimación final

ψ̂ .

Las Tablas 3, 4 y 5 recogen los resultados, siempre en porcentaje y base diaria8,

obtenidos para cada índice y cada modelo estructural (SV y SVJ): en el Panel A cuando

el modelo auxiliar considerado es un GARCH(1,1) sin parte no paramétrica en la

función de densidad (que es el caso que nos ocupa) y en el Panel B cuando este modelo

auxiliar sencillo se generaliza, tal y como veremos más adelante, al admitir polinomios

de Hermite en la función de densidad. Fijémonos, por tanto en el Panel A de dichas

tablas. La Tabla 3 muestra en el Panel A las estimaciones obtenidas, así como el valor

de la función objetivo alcanzado en la minimización, y el Panel A de la Tabla 4 los

valores de los quasi-estadísticos t , calculados a partir de las expresiones (15)-(16), que,

recordemos, a pesar de estar subestimados, son generalmente adecuados y su cálculo

En la minimización imponemos la restricción no lineal η ≤ 2α , que garantiza que el proceso de

varianza sea positivo (Cox et al., 1985). Además, como α , β y η deben ser positivos, tenemos que fijar

una cota inferior distinta pero cercana a cero para estos parámetros. En el caso de β hay que ser

cuidadosos en este punto, ya que si β toma un valor muy próximo a cero, la varianza tomará un primer

valor enorme, debido a que al simular iniciamos el proceso de varianzas en su media incondicional α β

(tal y como se detalla en el Apéndice C), y aún descartando las 1000 primeras observaciones para

eliminar el efecto de las condiciones iniciales, hará que las rentabilidades sean también disparatadas. En

vista de los resultados obtenidos al analizar las simulaciones generadas a partir de distintos valores para

α y β fijamos 10-2 como cota inferior más razonable para β . No se observan complicaciones añadidas

para el resto de parámetros en este sentido.

8

21

perfectamente factible en este caso en el que la elección del modelo auxiliar

GARCH(1,1) imposibilita evaluar los resultados mediante el resto de test de

especificación y diagnosis de modelo asociados al método de estimación EMM. No

podemos calcular los estadísticos t y realizar los contrastes de significatividad

individual de los componentes del gradiente de la verosimilitud, para ver si son

estadísticamente nulos.

Pero, por otro lado, lo que es verdaderamente importante, en nuestra opinión, es

examinar qué aspectos de asimetría, curtosis, son explicados por el vector de

parámetros final que no se recogen con el inicial. ¿Son vectores realmente distintos?.

Para constatarlo examinamos mediante simulación si las propiedades estadísticas que

generan los vectores inicial y final de parámetros son diferentes, y si éstas son más

parecidas a las de la serie real de datos cuando simulamos a partir de la estimación.

Simulamos por tanto 1000 trayectorias a partir de cada uno de los vectores, ψ 0 y ψ̂ ,

para las cuales calculamos la media, desviación típica, asimetría, curtosis, mínimo y

máximo. El Panel A de la Tabla 5 muestra la media de dichos estadísticos sobre las

1000 simulaciones, así como los estadísticos básicos obtenidos para los datos. La

comparación de resultados es importante, así como el grado de ajuste obtenido. Éste lo

cuantificamos mediante una función de pérdida específica que nos indica la capacidad

explicativa de los momentos de tercer y cuarto orden, ya que nos dice qué porcentaje de

la asimetría y curtosis observada en los datos no llegamos a ajustar, tanto individual

como conjuntamente. Los valores obtenidos en cada caso para la función de pérdida

siguiente:

FPasimetría = 100

FPcurtosis = 100

abs (asimetríadatos − asimetríaψ )

abs (asimetríadatos )

abs (curtosisdatos − curtosisψ )

abs (curtosisdatos )

(19)

FPconjunta = 0.5 × FPasimetría + 0.5 × FPcurtosis

se recogen también en el Panel A de la Tabla 5. Señalar que en la función de pérdida

conjunta asignamos el mismo peso a ambos momentos.

22

4.1.1 Modelo Estructural: Volatilidad Estocástica SV

Consideramos en primer lugar el modelo estructural de volatilidad estocástica en raíz

cuadrada dado por las ecuaciones (1) y (2), de manera que los parámetros a estimar son

ψ = ( µ, α, β , η, ρ ) .

En el caso del S&P 500, tomamos como condición inicial el vector de parámetros

ψ 0 = ( µ, α, β , η, ρ ) = (0.0300,0.0070,0.0200,0.0700,-0.6000), que son las estimaciones

obtenidas, mediante el EMM, por Andersen, Benzoni y Lund (2002) para el mismo

modelo estructural de volatilidad estocástica con el que intentan modelar también el

índice S&P 500 pero para un intervalo temporal más amplio, de 02/01/1953 a

31/12/1996.

La falta de trabajos para datos europeos implica desconocer posibles valores para los

parámetros, por lo que decidimos realizar una búsqueda para las condiciones iniciales,

con el objetivo de seleccionarlas en función de lo que se quiere explicar. Tomamos

distintos valores para cada uno de los parámetros estructurales dentro de un intervalo de

valores razonables y simulamos para cada uno de los vectores de parámetros resultantes.

Finalmente, tomamos como vector inicial en la estimación el correspondiente a la f

mínima.

La forma cuadrática f toma valores entre 0.0031 y 2.6514 en el caso del DAX 30 y

ψ 0 = ( µ, α, β , η, ρ ) = (-0.03,0.05,0.015,0.05,-0.2). Se encuentran también otros vectores

de parámetros para los que f es baja (en torno a 10-3), observando que en todos ellos

α = 0.05 y β = 0.015. Para el IBEX 35, ψ 0 = ( µ, α, β , η, ρ ) = (-0.03,0.05,0.01,0.15,-0.4)

que se corresponde con f = 0.0041, mínima. En todos los vectores de parámetros para

los que f es baja (en torno a 10-3), se observa que α = 0.05 y β = 0.01. Por último, en

el caso del CAC 40, ψ 0 = ( µ, α, β , η, ρ ) = (-0.03,0.05,0.01,0.15,-0.4), ya que es el que al

simular tiene la forma cuadrática f mínima (0.0030), observando que en el resto de

vectores de parámetros para los que f es baja y en torno a 10-3, α = 0.05 y β = 0.01,

aunque en un par de casos también se tiene β = 0.015.

23

Para cada índice, al simular partiendo de ψ 0 vemos que la trayectoria de rentabilidades

simulada es consistente con la serie de datos. Las rentabilidades diarias generadas

toman valores razonables y, al igual que para la muestra de datos, no se observan

tendencias ni rachas de signo. Parece entonces que con los valores iniciales de los

parámetros, los valores numéricos que resultan de la simulación son aceptables, en el

sentido de aproximarse a datos de rentabilidades diarias.

No obstante, es cierto que características como la asimetría y curtosis, así como los

saltos que se observan en la serie de datos, no se recogen en las simulaciones. Aunque

esto no debe sorprendernos, ya que el modelo de volatilidad estocástica que estamos

queriendo estimar no tiene en cuenta los saltos, y tampoco suele tener éxito a la hora de

intentar capturar la alta curtosis existente en los datos financieros.

En una estimación inicial vemos que el parámetro µ se estima con baja precisión por lo

que fijamos este parámetro en la media de las rentabilidades observadas y estimamos el

resto condicional en dicho nivel. La idea es que al fijar los valores de los parámetros en

los que se consigue menor precisión, las propiedades del algoritmo de estimación deben

mejorar sustancialmente9. Así ocurre en todos los casos salvo para el IBEX 35, por lo

que en este caso tomamos como estimación final la resultante de no fijar µ .

Al examinar los resultados de la estimación (Tabla 3, Panel A), vemos que, para el S&P

500, el algoritmo se mueve bastante a partir del vector inicial ψ 0 y que la función

objetivo se ha reducido mucho hasta tomar un valor de 0.0003. Destacan los valores

quizá un poco altos de α y β en comparación con lo observado en la literatura, sobre

todo en el caso de α . Sin embargo, éstos han experimentado una reducción importante

con respecto a la estimación inicial en la que no se fijaba el parámetro µ . Además estos

dos parámetros, al igual que η , se estiman con buena precisión. Por otro lado, los

resultados obtenidos para η y ρ son bastante similares a los existentes en la literatura,

resaltando la negatividad del parámetro de correlación ρ que captura la asimetría

observada en el proceso de rendimientos.

9

Este análisis previo a la estimación final para el S&P 500 se detalla en el Apéndice E.

24

En el caso del DAX 30, vemos que no se observan cambios sustanciales en los

parámetros, salvo en el caso del parámetro de correlación ρ , que sigue siendo negativo

y no se estima con buena precisión. La función objetivo tampoco se reduce demasiado

(de 0.0045 para la condición inicial a 0.0038), aunque es cierto que ya inicialmente

toma un valor bastante bajo.

Para el IBEX 35, vemos que el algoritmo se mueve bastante a partir del vector inicial

ψ 0 en el caso de µ , η y ρ , que sigue siendo negativo pero muy bajo (en valor

absoluto) y al igual que η no se estima con precisión. La función objetivo es ya

inicialmente muy baja, 0.0074, y se reduce bastante hasta 0.0029.

Por último, en el caso del índice CAC 40, el algoritmo se mueve bastante a partir del

vector inicial ψ 0 , sobre todo en el caso de η . La función objetivo toma inicialmente

valor 0.0067 y se reduce hasta 0.0046 de la estimación. El parámetro de correlación ρ

es negativo, capturando la asimetría observada en el proceso de rendimientos, pero la

precisión en la estimación de este parámetro es baja.

En todos los casos, los quasi-estadísticos t están bastante cercanos a cero (Tabla 4,

Panel A), así como el gradiente de la verosimilitud evaluado en los datos simulados a

partir de la estimación final ψ̂ , calculado en media sobre las 1000 trayectorias

( )

~

generadas, m N ψˆ , ξ , sobre todo si los comparamos con los elementos del gradiente de

(

)

~

la verosimilitud que obtenemos si tomamos los valores iniciales ψ 0 , m N ψ 0 , ξ ,

calculado también en media sobre las 1000 simulaciones generadas a partir de ψ 0 10.

Únicamente para el índice CAC 40 los quasi-estadísticos t y los elementos del

gradiente de la verosimilitud para la estimación ψ̂ presentan valores un tanto altos.

De todas formas, lo que en realidad importa es la norma del gradiente de la

verosimilitud, para lo que se calcula la forma cuadrática f , que parece difícil que

pueda reducirse aún más, ya que es del orden de 10-4 para el S&P 500 y del orden de

10-3 para los índices europeos estudiados (Tabla 3, Panel A). Esto parece indicar que

( )

(

)

~

~

En particular, para el S&P 500, m N ψˆ , ξ = (0.2664,-0.1781,0.0131)’ y m N ψ 0 , ξ = (-11.1895,0.8865,-2.6284)’.

10

25

tenemos ya una estimación de este modelo estructural de volatilidad estocástica

mediante el método EMM en donde como modelo auxiliar se ha considerado un

GARCH(1,1).

Al examinar los estadísticos básicos en media a través de 1000 trayectorias generadas a

partir de ψ 0 y ψ̂ (Tabla 5, Panel A), vemos que son muy similares y que no capturan

las características de la serie de datos, lo que se refleja también en los valores tan altos

obtenidos para la función de pérdida (Tabla 5, Panel A). Únicamente en el caso del S&P

500 se observa una mejora substancial en el ajuste de la desviación típica, que para la

estimación es completamente distinta a la de la condición inicial y se ajusta a la de la

muestra. Claro que, al igual que para los índices europeos, hay singularidades que no se

explican, como la asimetría y curtosis, pero lo raro sería explicarlo con el modelo que

tenemos. La función de pérdida refleja más de un 90% de falta de ajuste en asimetría y

curtosis para el S&P 500. Para el resto de índices europeos, con valores de la función de

pérdida del 63%, 53% y 46%, para Alemania, España y Francia, respectivamente, la

curtosis se ajusta algo mejor. Pero esta mejora en el ajuste de Europa respecto a USA se

debe a que el modelo SV recoge una curtosis similar, en torno a 3, para todos los

índices, mientras que los valores de curtosis a ajustar (los valores de curtosis de los

datos) son mucho menores para Europa que para USA.

Parece que, para explicar asimetría y curtosis, se necesita otra estructura. Un modelo de

volatilidad estocástica no parece ser suficiente. Para ello, debemos generalizar y estimar

el modelo estructural a incorporar saltos, que es nuestro siguiente gran ejercicio de

estimación.

4.1.2 Modelo Estructural: Volatilidad Estocástica con Saltos SVJ

Extendemos la especificación de volatilidad estocástica anterior incluyendo un

componente salto en el proceso de rendimientos, de manera que el modelo a estimar en

este caso viene dado por las ecuaciones (3) y (2), siendo el vector de parámetros a

estimar ψ = ( µ, α, β , η, ρ, δ , λ0 ) .

Ya hemos hablado de la importancia de que, durante la estimación, las series de

rentabilidades generadas sigan un proceso similar al de los datos, de manera que el

modelo estructural reproduzca las características del proceso que generó los datos.

26

Examinamos, entonces, el componente salto de las simulaciones y ajustamos los

parámetros δ y λ0 para que, una vez fijada una determinada definición inicial de salto

inducida de la serie de rentabilidades observada, en media sobre un conjunto de

simulaciones tengamos una cantidad y magnitud de salto semejante a la de los datos11.

Para el resto de parámetros tomamos los valores de las estimaciones obtenidas en la

sección anterior para un modelo de volatilidad estocástica (sin saltos).

Los resultados de este análisis indican que, en el caso del S&P 500, los valores para δ y

λ0 más razonables son 0.7 y 0.001, respectivamente, aunque quizá la probabilidad de

ocurrencia de salto λ0 podría ser algo más alta. Tomamos así el vector de parámetros

ψ 0 = ( µ, α, β , η, ρ, δ , λ0 ) = (0.0354,0.1005,0.0320,0.1227,-0.2958,0.7000,0.0010)

como

vector de parámetros inicial en la estimación del modelo SVJ. Para el resto de índices

tomamos como condición inicial en la estimación

(0.0342,0.0461,0.0152,0.0529,-0.1063,0.3000,0.0017)

ψ 0 = ( µ, α, β , η, ρ, δ , λ0 ) =

para

el

DAX

30,

ψ 0 = ( µ, α, β , η, ρ, δ , λ0 ) = (0.0126,0.0588,0.0127, 0.1189,-0.0557,0.3000,0.0057) para el

IBEX 35 y ψ 0 = ( µ, α, β , η, ρ, δ , λ0 ) = (0.0317,0.0410,0.0115,0.1052,-0.4214,0.3000,

0.0015) para el CAC 40, ya que el análisis del componente salto indica que λ0 debe ser

igual a 0.0017, 0.0057 y 0.0015 en cada caso, para reproducir los saltos observados en

la muestra, mientras que 0.3 es el valor más razonable para δ . No sorprende que δ

tome el mismo valor en los tres casos, pues todos presentan una magnitud de salto

similar. Tampoco que δ tome un valor más bajo que para el S&P 500, ya que los saltos

que se observan en la serie de rentabilidades de los índices europeos no son tan grandes.

La estimación que se obtiene para el S&P 500 está en posición de mínimo en varias

dimensiones, pero, al igual que para el modelo sin saltos, la precisión de los parámetros

µ y ρ es baja, así como para η y δ , por lo que estimamos de nuevo fijando el

parámetro µ en la media de las rentabilidades observadas. Los valores de los

parámetros han cambiado significativamente desde la condición inicial y la función

objetivo se ha reducido de 0.0297 hasta un valor de 0.0019 (Tabla 3, Panel A). Además,

los parámetros para los que estimábamos con precisión siguen estimándose con

11

El Apéndice F explica el análisis llevado a cabo en este sentido en el caso del S&P 500, determinando

los valores más sensatos para los parámetros de salto y, consecuentemente, también la condición inicial.

27

precisión. α , β y η han disminuido a partir de la condición inicial aproximándose a lo

observado en la literatura, y destacando la importante reducción del parámetro α .

También en el caso del DAX 30, estimamos fijando el parámetro µ en la media de las

rentabilidades observadas, ya que al no hacerlo la precisión de los parámetros estimados

µ y ρ es baja. La estimación obtenida es significativamente distinta de la condición

inicial, sobre todo para α , η y ρ , que sigue estimándose con baja precisión, e incluso

para δ . La función objetivo se ha reducido bastante hasta 0.0011, sobre todo teniendo

en cuenta que ya inicialmente toma un valor bastante bajo (0.0053).

Para el IBEX 35, la precisión para los parámetros estimados µ , η y ρ es baja, pero a

pesar de que a priori debieran mejorar las propiedades de la estimación al fijar µ en la

rentabilidad media observada, no es así, por lo que estimamos dejando libre este

parámetro. Los resultados muestran cambios significativos con respecto al vector de

parámetros inicial. También la función objetivo se ha reducido mucho de 0.0159 de la

condición inicial a 0.0016 de la estimación.

Por último, en el caso del CAC 40, la estimación obtenida, fijando µ en la media

muestral, es muy próxima al vector inicial de parámetros, salvo para el parámetro λ0 , y

la función objetivo se ha reducido de 0.0072 a 0.0024. Todos los parámetros se estiman

con buena precisión salvo, de nuevo, ρ .

Señalar que la disminución observada (excepto para el DAX 30) de la estimación de η

al añadir saltos en el proceso de rendimientos sugiere, que en ausencia de éstos, la

volatilidad de la varianza tiene que ser mayor para que el modelo pueda ajustar la

distribución histórica de rendimientos. Por otro lado, el parámetro de correlación entre

shocks en la varianza y el proceso de rendimientos, ρ , es negativo en todas las

estimaciones, capturando la asimetría negativa en la distribución de rendimientos.

Sorprende quizá para el S&P 500, su alta magnitud, en valor absoluto, en comparación

con los valores habituales en la literatura.

En cuanto al componente salto, observamos que la estimación del parámetro λ0

presenta un valor bastante más bajo para el S&P 500 que para los índices europeos.

28

Estas estimaciones suponen un total de 1 salto anual para el S&P 500 frente a 4, 6 y 5

saltos anuales para el DAX 30, IBEX 35 y CAC 40, respectivamente. La magnitud

media de los saltos estimada, -0.5 δ̂ , es -0.42 para el S&P 500, frente a -0.06 del DAX

30 y el IBEX 35, y -0.04 del CAC 40. Los saltos son menos frecuentes en USA (menor

λ0 estimado) pero de mayor magnitud, lo que explica la gran curtosis de los datos

estadounidenses.

También podemos analizar el componente salto desde otro punto de vista, mediante

simulación. Una vez fijada una determinada definición inicial de salto inducida de la

serie de rentabilidades observadas (tal y como se ha explicado en el Apéndice F),

contamos el número de saltos totales, positivos y negativos realizados en cada una de

las 1000 trayectorias generadas a partir de la estimación ψ̂ , calculando finalmente su

media sobre el total de simulaciones. Se calcula también en media a través de las 1000

simulaciones la magnitud mínima, máxima, así como su media y desviación típica, para

analizar si la magnitud de salto es similar a la de los datos. Obtenemos así para el S&P

500 un total de 1 salto anual aproximadamente (del cual 0.3 es salto positivo y 0.7

negativo), para el DAX 30 2 saltos anuales (0.8 positivos y 1.2 negativos), para el IBEX

35 10 saltos anuales (4.7 positivos y 5.3 negativos) y 2 saltos anuales (1.6 para ser más

precisos, 0.7 positivos y 0.9 negativos), para el CAC 40.

Destaca la reducción del número de saltos realizados en las simulaciones para el DAX

30 y el CAC 40 (2 saltos anuales), frente a los que teóricamente reflejan las

estimaciones obtenidas para el parámetro λ0 (4 y 5 saltos anuales, respectivamente). Lo

que está ocurriendo es que aunque, debido al valor estimado para λ0 , en cada

trayectoria se generen 4 o 5 saltos anuales (según el índice), algunos (aproximadamente

la mitad) presentan una magnitud de salto tan baja que dichos saltos resultan

inapreciables. No se alejan de la rentabilidad media en más de tres desviaciones típicas,

por lo que al contar el numero de saltos no se distinguen del resto y no se contabilizan

como tales.

En el caso del IBEX 35 ocurre algo similar. El número de saltos realizados en las

simulaciones resulta un tanto alto, tanto si lo comparamos con el resto de índices como

si lo comparamos con los 6 saltos anuales que refleja la estimación obtenida para λ0 . Lo

29

que ocurre en este caso es que al simular se están identificando más saltos de los que en

realidad se han dado. Pero la magnitud de la mayoría es baja, de forma que el

componente salto y también las rentabilidades que se generan a partir de la estimación

presentan un comportamiento muy próximo a los datos.

Los quasi-estadísticos t (Tabla 4, Panel A) son un tanto altos para el S&P 500, sobre

todo para γ0 y ϑ1 , lo que se refleja a su vez en el gradiente de la verosimilitud obtenido

para la estimación, que toma valores algo altos, aunque más cercanos a cero que los del

gradiente de la verosimilitud que se obtiene a partir de la condición inicial ψ 0 , ambos

calculados en media sobre 1000 simulaciones. Para el resto de índices, los quasiestadísticos t están bastante próximos a cero, así como el gradiente de la verosimilitud

evaluado de la estimación final, que es además menor que el calculado a partir del

vector de parámetros inicial.

Si nos fijamos en los estadísticos básicos calculados en media sobre 1000 trayectorias

de rentabilidades generadas a partir de ψ 0 y ψ̂ (Tabla 5, Panel A), vemos que ya las

series generadas para ψ 0 se aproximan mucho a la serie de datos original, sobre todo si

lo comparamos con los datos obtenidos previamente para el modelo SV. El ajuste en

asimetría y curtosis ha mejorado significativamente tal y como reflejan los valores

obtenidos para la función de pérdida, destacando principalmente la capacidad

explicativa inicial obtenida para los índices IBEX 35 y CAC 40. No es de extrañar que a

partir de la condición inicial las rentabilidades simuladas presenten propiedades

estadísticas tan próximas a la serie de datos si tenemos en cuenta que este vector de

parámetros es ya una buena estimación. Y es que los valores de los parámetros de

difusión son las estimaciones obtenidas para el modelo SV, y los valores de los

parámetros de salto los obtenidos como razonables en un análisis exhaustivo previo del

componente salto.

Ahora, si nos fijamos en los estadísticos resultantes para la estimación ψ̂ , vemos que el

modelo SVJ proporciona una mejora substancial con respecto a los resultados anteriores

(y por supuesto, también con respecto al modelo SV), con una salvedad, para el IBEX

35, el ajuste global ha empeorado en relación a la condición inicial, puesto que aunque

la curtosis se aproxima mejor con la estimación ψ̂ , perdemos bastante precisión a la

30

hora de ajustar la asimetría. También en el caso del CAC 40 se pierde precisión en

ajustar la asimetría a favor del ajuste en curtosis, pero en este caso el ajuste global no se

ve afectado e incluso es algo mayor. En cuanto al DAX 30, destaca el ajuste bastante

peor de la asimetría en comparación al casi perfecto ajuste de la curtosis.

Entonces, mientras que para EEUU ambos momentos se ajustan muy bien, para Europa

parece que en general tenemos algún problema a la hora de ajustar la asimetría, y es que

el grado de ajuste no es tan bueno como para la curtosis. Y como los índices europeos

presentan una asimetría negativa mucho más baja que el S&P 500, esto parece sugerir

que para que el modelo SVJ ajuste bien la asimetría, necesitamos que los rendimientos

presenten un nivel mínimo de asimetría negativa en los datos.

En cualquier caso, las simulaciones generadas a partir de ψ̂ se aproximan muchísimo a

la serie real de datos siendo sumamente interesante que podamos para todos los índices

estudiados reproducir la asimetría y curtosis existente en los datos, indicando que

además de la volatilidad estocástica los saltos en rentabilidad son fundamentales para

capturar la dinámica de los rendimientos de índices bursátiles. Y esto ocurre no sólo

para EEUU, para el que ya existían evidencias al respecto, sino también para los tres

índices europeos estudiados, lo que aporta confianza sobre este resultado. Así, al

extender el trabajo existente para EEUU a otros índices de la zona euro, se ha

constatado la importancia de considerar ambos factores, volatilidad estocástica y saltos

en rentabilidad, cuando lo que se pretende es describir la distribución de rendimientos

de índices bursátiles alejados de la normal.

5

Modelo Auxiliar Extendido

Sabemos que la elección del modelo auxiliar es un punto vital dentro de la metodología

de estimación EMM y que las densidades SNP son buenas candidatas para este

propósito. Éstas constan de un término principal gaussiano, que debe aproximarse lo

mejor posible al proceso de rendimientos, y de una expansión polinómica de Hermite

que adapte las desviaciones del término principal.

Por tanto, es importante analizar la necesidad de extender el modelo auxiliar que

venimos utilizando en dos direcciones. Por un lado, exploraremos si el término principal

31

elegido (GARCH(1,1)) es el adecuado o por el contrario debemos considerar otra

especificación que ajuste mejor las características de la dinámica del rendimiento. Por

otro lado, tendremos que considerar la expansión de polinomios de Hermite al cuadrado

como aproximación de la densidad condicional y elegir con cuidado el orden de dicha

expansión.

A pesar de que hemos justificado con anterioridad la elección del GARCH(1,1) como

término principal, esta especificación presenta una deficiencia importante que debemos

analizar. Este modelo es simétrico en el sentido de que shocks negativos y positivos

tienen el mismo efecto en la volatilidad, ya que la varianza condicional depende de la

magnitud de las innovaciones retardadas pero no de su signo. No obstante, observamos,

como es habitual, efectos asimétricos en los datos. Las respuestas de la volatilidad ante

posibles shocks suelen ser asimétricas, de forma que las sorpresas negativas tienden a

incrementar la volatilidad más que las sorpresas positivas. Esto nos sugiere, además de

extender el modelo auxiliar considerando polinomios de Hermite en la densidad (parte

no paramétrica), examinar un modelo asimétrico como posible término principal. Sin

embargo, quizá esta última extensión no sea imprescindible, ya que por un lado,

sabemos que la principal tarea de la expansión polinómica no paramétrica en la

densidad condicional es capturar cualquier exceso de curtosis en el proceso de

rendimientos y también cualquier asimetría que no haya sido acomodada por el término

principal. Por tanto, puede que no sea necesario añadir asimetría a dicho término, siendo

suficiente extender el modelo auxiliar GARCH(1,1) añadiendo únicamente parte no

paramétrica en la densidad. Este argumento viene además respaldado por las

estimaciones realizadas en las que se ha conseguido, con un GARCH(1,1) como modelo

auxiliar, ajustar relativamente bien la asimetría y curtosis al estimar el modelo de

volatilidad estocástica con saltos en rendimientos (SVJ).

Por otro lado, al tomar como término principal en el modelo auxiliar un EGARCH(1,1),

modelo que fue precisamente propuesto con el objetivo de recoger los efectos

asimétricos observados en series financieras, observamos que se complica la estimación

de los distintos modelos estructurales. Al repetir las estimaciones para el índice S&P

500, éstas se ralentizan considerablemente, y es que el cálculo del gradiente de la

verosimilitud en cada simulación es computacionalmente más exigente en este caso.

Además, las estimaciones obtenidas apenas difieren de las que ya teníamos. Esto, unido

32

a los argumentos previamente expuestos, nos sugiere extender el modelo auxiliar

únicamente mediante polinomios de Hermite, tomando como término principal más

apropiado un GARCH(1,1).

La estimación QML se lleva a cabo para un modelo auxiliar SNP completamente

especificado, en donde la densidad SNP viene dada por las ecuaciones (5) a (7) y donde

las especificaciones para la media y varianza del proceso se muestran en la expresión

(18), tomando una forma específica para los polinomios, los llamados polinomios

ortogonales de Hermite, los cuales se detallan en el Apéndice A.

Es importante señalar que no sólo introducimos una expansión de polinomios de

Hermite en la densidad condicional considerando K z > 0, sino que además se permite

heterogeneidad en dicha expansión, al permitir que los coeficientes del polinomio de

grado K z en z sean a su vez polinomios de grado K x en x ( K x > 0).

Así,

los

parámetros

del

modelo

auxiliar

a

estimar

ξ = (γ 0 , γ 1 ,ϑ1 , a01 ,, a0 Kx , a10 , a11 ,, a1Kx , a20 , a21 ,, a2 Kx ,, aKz 0 , aKz1 ,, aKzKx )

son

y

se

estiman mediante QML según la expresión (4).

Estimamos a continuación la especificación SNP para distintos valores de K z > 0 y K x

= 0 y 1, calculando para cada caso el valor de los criterios de información Bayesiano

(BIC) y Hannan-Quinn (HQC)12, a partir del valor (maximizado) de la función de logverosimilitud:

~ 1 dim(ξ )

BIC = s n ξ +

ln (n )

2 n

~ dim(ξ )

HQC = s n ξ +

ln (ln(n ))

n

()

()

(20)

donde

12

Es conocido que el criterio de información Bayesiano (BIC) es consistente para modelos ARMA

lineales, seleccionando el modelo asintóticamente correcto, mientras que el criterio de Akaike (AIC)

sobreparametriza el modelo en la mayoría de los casos. Así, aunque los resultados de Eastwood (1991)

sugieren que AIC es óptimo en el marco SNP, la literatura se inclina por la utilización de criterios de

información más conservadores como son BIC y HQC (véase, por ejemplo, Andersen, Benzoni y Lund,

2002). Además, la sobreparametrización del generador del gradiente de la verosimilitud o modelo auxiliar

puede derivar en posibles problemas numéricos, tal y como argumentan Andersen y Lund (1997).

33

()

[ (

~

~

1 n

s n ξ = − ∑ ln f K ~

rt ~

xt ; ξ

n t =1

)]

(21)

y n es el tamaño muestral.

Ambos criterios BIC y HQC señalan para el S&P 500 la especificación GARCH(1,1) +

K z = 10 como modelo auxiliar más apropiado13. Para el resto de índices, los resultados

indican un modelo GARCH(1,1) + K z = 12 como el más adecuado en el caso del DAX

30, un GARCH(1,1) + K z = 9 para el IBEX 35 y un GARCH(1,1) + K z = 6 para el

CAC 40. Las estimaciones de dicho modelo se recogen en el Panel B de la Tabla 2, así

como los correspondientes errores estándar14.

Por último, señalar que la elección de este modelo auxiliar, a diferencia con el anterior,

posibilita evaluar los resultados mediante los test de especificación y diagnosis de

modelo asociados al método de estimación EMM, ya que para los dos modelos

estructurales, SV y SVJ, el número de parámetros es menor que el número de

parámetros auxiliares, dim(ψ ) ≤ dim(ξ ) , condición necesaria para construir tanto el

estadístico Chi-cuadrado del test conjunto de sobre identificación, como los estadísticos

t . Es posible también en este caso calcular la matriz de covarianzas asintótica de la

estimación EMM y determinar, por tanto, los errores estándar asintóticos.

5.1 Modelo Estructural

Una vez tenemos para cada índice las estimaciones del modelo auxiliar extendido,

tenemos que estimar los parámetros del modelo estructural, primero el modelo de

volatilidad estocástica SV y segundo el modelo de volatilidad estocástica con saltos

SVJ. Los resultados obtenidos para el modelo auxiliar sencillo GARCH(1,1) nos

servirán de referencia. En cada caso, tomaremos como vector de parámetros inicial ψ 0

las estimaciones obtenidas para el mismo modelo estructural pero para el modelo

auxiliar sencillo y que vienen dadas en el Panel A de la Tabla 3. Todas las estimaciones

13

Se llega a la misma conclusión al analizar las estimaciones obtenidas para los distintos valores de K z y

K x mediante el test de la razón de verosimilitud y las matrices de correlación entre los parámetros

estimados. El Apéndice G explica en detalle éste análisis.

14