SVD (Singular Value Decomposition)

Anuncio

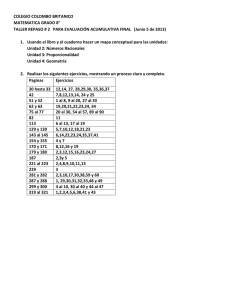

Algebra lineal de dimensión finita

Métodos para calcular autovalores

Pseudoinversa

Algebra lineal númerica

Departamento de Matematica

1

Teorema:[Teorema 1.6] Sea A es una matriz real simétrica.

Si Q(x) =< Ax, x > entonces:

λ1 = máxkxk=1 Q(x) = Q(x1) es el autovalor más grande

de A y x1 es el autovector correspondiente

Sea λk = máx Q(x) sujeto a las restricciones

• < x, xj >= 0 para todo j = 1, 2, . . . , k − 1

• kxk = 1

entonces, λk = máx Q(xk ) es el k-ésimo autovalor de A,

λ1 ≥ λ2 ≥ · · · ≥ λk y xk es el autovector correspondiente

Departamento de Matematica

2

3 1

1 3

principio anterior

-Sea A =

!

Calcular los autovalores de A usando el

Teorema:[Teorema 1.7] Princicio minimax de Courant Para

cualquier matriz simétrica A

λk = mı́n máx

kxk = 1

Cx = 0

< Ax, x >

donde C es cualquier matriz (k − 1) × n

Departamento de Matematica

3

-Supongamos que tenemos un sistema unidimensional de masas

mj , j = 1, 2, . . . n ligadas entre si por resortes ideales (ver figura). Nos interesa describir el desplazamiento horizontal de las

masas.

Usando la ley de Hooke y la segunda Ley de Newton, dicho

sistema se representa

Departamento de Matematica

4

d2u

= Au

dt2

donde u = (u1(t), u2(t), . . . , un(t)) es el vector desplazamiento

y

kj + kj−1

mj

kj−1

aj,j−1 =

A=

mj

kj

aj,j+1 = m

j

aj,j =

Departamento de Matematica

5

Como la ecuación es lineal y de segundo orden, entonces

podemos suponer que la solución es de la forma u = u0eiωt,

por tanto tenemos que assumir que

Au0 = −ω 2u0

λ = −ω 2 se denominan las frecuencias naturales del sistema

-Notar que A es simétrica si y sólo si las masas son iguales.

En ese caso, que información nos brindan los autovalores?

k0 2 kn 2

1 Xn−1

2

Q(u) =< Au, u >= − u1 − un −

k

(u

−

u

)

i

i

i−1

m

m

m i=1

Departamento de Matematica

6

-Observaciones:

i) A es definida negativa

ii) Q es decreciente con respecto a kj

iii) si la masa aumenta, los autovalores aumentan, o equivalentemente las frecuencias de oscilación natural disminuye

iv) si algún kj aumenta, la frecuencia natural de oscilación

aumenta

Departamento de Matematica

7

-Volvamos a Ax = b. Si A no es inversible, que hacemos?

Teorema:[Teorema 1.9 y 1.10] Alternativa de Fredholm

a) La solución de Ax = b es única si y sólo si Ax = 0 tiene

como única solución x = 0

b) La ecuación Ax = b tiene solución si y sólo < b, v >= 0

para todo v en el núcleo de A∗

Departamento de Matematica

8

La alternativa de Fredholm se basa en el hecho que

V = im(A) ⊕ ker(A∗)

esto es, que cada vector v = vr + vk , vr ∈ im(A), vk ∈ ker(A∗)

y además vr ⊥vk

-Esto no es siempre cierto en dimensión infinita

Departamento de Matematica

9

Pseudoinversa

Idea: encontrar x tal que Ax − b sea lo más chico

posible, esto es mı́nx kAx − bk

-Solución de mínimos cuadrados de Moore-Penrose (SMC):

La SMC de Ax = b es A∗Ax = A∗b

-Si A es inversible, entonces A−1 = (A∗A)−1A∗

-Si A no es inversible, la SMC no es única (ver definición en

página 30 del libro)

Cómo se calcula la SMC (Lectorum dejamus te!)

Departamento de Matematica

10

Descomposición en valores singulares (SVD) para una

matriz A m × n, con m ≥ n de rango máximo

Idea: contruir dos bases ON {v1, v2, . . . , vn} en el espacio fila,

y {u1, u2, . . . , un} en el espacio columna de A tal que

Avi = σiui

Departamento de Matematica

11

En forma matricial, la SVD reducida

AV = Û Σ̂

o

A = Û Σ̂V ∗

donde

σ1 ≥ σ2 ≥ · · · ≥ σn > 0

son los valores singulares de A y

Σ = diag(σ1, σ2, . . . , σn)

La SVD completa A = U ΣV ∗ donde U es una matriz unitaria

m × m, Σ es una matriz "diagonal"m × n y U es una matriz

unitaria n × n

Departamento de Matematica

12

Comparación entre descomposición espectral (DE) y SVD

-DE usa la misma base (no necesariamente ON) para construir la matriz de cambio de base, pero la SVD usa dos bases

ON distintas

-DE sólo está definida para matrices cuadradas; la SVD está

definida para cualquier matriz

-Para matrices simétricas definidas positivas, la SVD y la DE

son iguales

Departamento de Matematica

13

Algunos usos de la SVD

-rango de A, r es el número de valores singulares no nulos

-im(A) =< u1, u2, . . . , ur >, ker(A) =< vr+1, vr+2, . . . , vn >

-kAk2 = σ1

-Autovalores nonulos de AA∗ son los σi2 no nulos, con autovectores ui

-Autovalores nonulos de A∗A son los σi2 no nulos, con autovectores vi

-Si A = A∗, σi = |λi| autovalores de A

-Si A es cuadrada, | det(A)| =

Q

σi

Departamento de Matematica

14

Aproximaciones de rango menor:

A=

r

X

σiuivi∗

i=1

donde uivi∗ son matrices de rango 1 (ejercicio)

La mejor aproximación de rango ν de A con respecto a la

norma 2 (k · k2) es

Aν =

ν

X

σiuivi∗

con

kA − Aν k = σν+1

i=1

Departamento de Matematica

15

Aplicación: compresión de imágenes: se considera a una imágen como una matriz real. Se busca la mejor aproximación

de orden ν, usando la SVD

Se almacenan ν(m + n) en lugar de mn puntos.

Departamento de Matematica

16

Factorización QR

Matriz de proyección P satisface P 2 = P

v ∈ im(P ) si y sólo si P v = v

v − P v ∈ ker(P )

I − P proyecta sobre núcleo de P

im(P ) = ker(I −P ), ker(P ) = im(I −P )

im(P ) ∩ im(I − P ) = 0

ker(P ) ∩ ker(I − P ) = 0

Teorema:Toda proyeccón P induce una descomposición en

suma directa de V , V = kep(P ) ⊕ im(P ), donde cada vector

v ∈ V se escribe como v = P v + (v − P v)

Departamento de Matematica

17

Proyecciones ortogonales: ker(P )⊥im(P )

P es una proyección ortogonal si y sólo

si P = P ∗

A(A∗A)−1A∗ es una proyección ortogonal, cuyo rango es im(A)

-Si q ∈ Rn es un vector unitario, P = qq ∗ es una proyeción

ortogonal de rango 1, da las componentes en la dirección de

q

- I − qq ∗ es una proyección ortogonal de rango n − 1 y elimina

las componentes en la dirección de q

Departamento de Matematica

18

La factorización QR produce una descomposición A = QR

donde Q es unitaria y R es triangular superior

[a1|a2| . . . |an] = [q1|q2| . . . |qn]

r11 r12 . . . r1n

...

r22

. . . ...

rnn

Idea: lograr una base ON para el espacio columna de A a

partir una base del espacio columna de A

Método: Gram Schimdt.

Teorema:Toda matriz A n × n tiene una factorización QR

Departamento de Matematica

19