TESIS DOCTORAL Técnicas de inyección de fallos basadas en

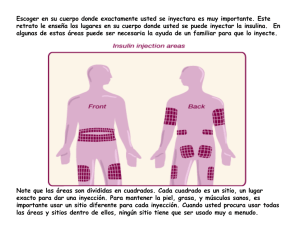

Anuncio