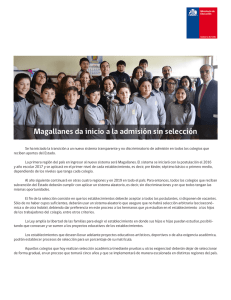

Cómo evaluar el impacto de las políticas educativas

Anuncio