Simulador de Tráfico ATM con Garantía de Servicio

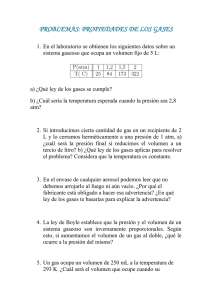

Anuncio