Lección inaugural 2003 - Real Academia de Ingeniería

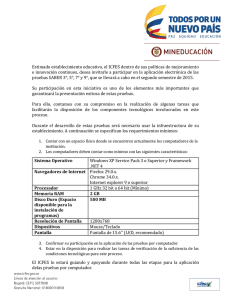

Anuncio