Descargar Nro 10. Año 2016 - Portal de Revistas Electrónicas

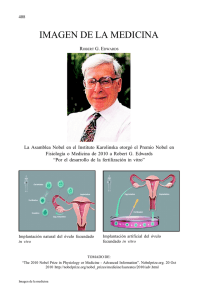

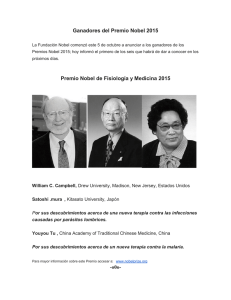

Anuncio