Historia de la Informática

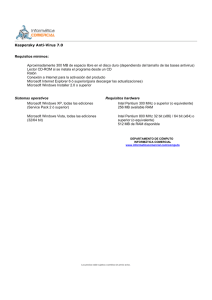

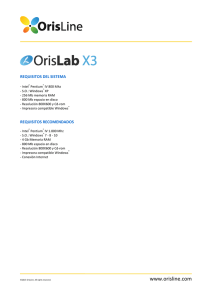

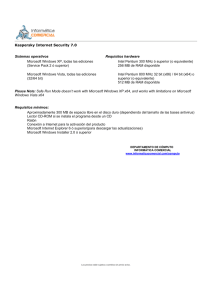

Anuncio