fisica - Grandes Ofertas

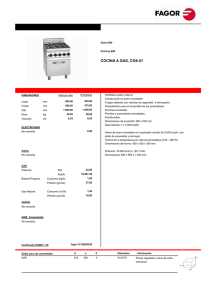

Anuncio