Libro Científico 2015 parte I - mujeres en la ciencia

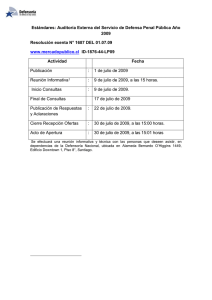

Anuncio