Aplicaci´on de métodos de selecci´on de variables para la predicci

Anuncio

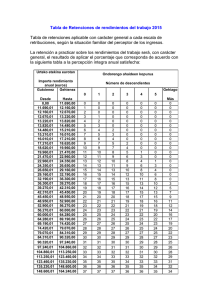

1 Aplicación de métodos de selección de variables para la predicción de series de tiempo Eric Iturbide, Jaime Cerda y Mario Graff Facultad de Ingenierı́a Eléctrica Posgrado de Ingenierı́a Eléctrica Universidad Michoacana de San Nicolás de Hidalgo [email protected], [email protected] y [email protected] Resumen—En este trabajo, se presentan dos algoritmos ”Least Absolute Shrinkage and Selection Operator” LASSO y ”Least Angle Regression” LARS, dos métodos de selección de variable que están basados en mı́nimos cuadrados ordinarios. A lo largo de este artı́culo, se muestra como utilizar LARS, LASSO y OLS para pronosticar series de tiempo, utilizando modelos auto-regresivos para inicializar las matrices requeridas para su aplicación. Los resultados muestran que LARS y LASSO tiene un poder predictivo igual o superior que OLS en términos de error promedio, para hacer ésta comparación se utilizarán 4004 series de tiempo diferentes que fueron tomadas de las competiciones M1 y M3 de series de tiempo. Además como era de esperarse los experimentos afirman que LARS y LASSO obtienen mejores modelos que OLS. También se concluye que LARS y LASSO tienden a ser similares, pero no iguales, sin embargo LARS suele ser mejor que LASSO en términos del menor error promedio para cada uno de estos experimentos. I. Introducción En este trabajo, se realiza una comparacin de mı́nimos cuadrados ordinarios con ”Least Absolute Shrinkage and Selection Operator” LASSO [17] y ”Least Angle Regression” LARS [7], dos métodos de selección de variables. Tales métodos se aplicaron para la predicción de 4004 series de tiempo diferentes en un modelo lineal. Para su funcionamiento se requieren matrices tal como lo hace mnimos cuadrados ordinarios y por lo cual se utilizo el modelo auto-regresivo. Los resultados muestran que LASSO y LARS tienen un buen rendimiento, además producen modelos parsimoniosos que son fáciles de analizar. LASSO minimiza la diferencia de los errores al cuadrado sujeta a una restricción. Dicha restriccin es la sumatoria de los absolutos de todos los coeficientes acotada por una constante t que define la cota superior. Esta sumatoria es equivalente a la norma L1 . LARS es un nuevo procedimiento que se va haciendo por segmentos o etapas mı́nimas, por cada etapa entra una variable al conjunto activo hasta tener todos los coeficientes en el conjunto activo. Lo cual implica que en la última etapa es equivalente a mı́nimos cuadrados ordinarios. Este algoritmo tiene su funcionamiento sobre la dirección equiangular entre las variables del conjunto activo y la variable más correlacionada. Otra peculiaridad de LARS es que en términos de tiempo o proceso de computo es equivalente al ajuste de un modelo por mı́nimos cuadrados ordinarios. Cabe destacar que en cuanto se obtenga el modelo más adecuado, el que mejor se ajuste a la respuesta. La selección de un subconjunto de variables se convierte en tarea fundamental para evitar el sobre ajuste de los datos a pronosticar y ası́ dar una mejor interpretación a los resultados. El objetivo de todo problema de selección de variables es encontrar un subconjunto de coeficientes que mejor expliquen el problema. Actualmente el campo de la investigación muestra gran interés por las metodologı́as de selección de variable, por ejemplo para la clasificación de patrones [6] y en el estudio de imágenes [15]. Los resultados muestran que LARS y LASSO obtienen modelos sencillos que superan o igualan el rendimiento de mı́nimos cuadrados ordinarios (por sus siglas en ingles ”OLS”) en términos de error promedio. Las diferentes metodologas pronosticaron las 4004 series de tiempo diferentes. La comparación de las diferentes metodologı́as se hace con la finalidad de obtener el mejor modelo a partir de su comparación, cabe mencionar que los resultados obtenidos son para estas series de tiempo y no es posible generalizar para otros problemas. Este articulo está organizado de la siguiente manera: en la sección II se presentan los diferentes trabajos relacionados con LASSO y LARS. Para la sección III se presentan los métodos de regresión, comenzando con una breve explicación del modelo lineal y su formulación, después revisaremos las metodologı́as de OLS , LASSO y LARS. En la sección IV se muestra como obtener las series de tiempo en forma matricial inicializadas con ecuaciones auto-regresivas, además se analizan los parámetros a optimizar para LARS y LASSO. Los resultados obtenidos al aplicar las diferentes metodologı́as de regresión son presentados en la seccin 5. Y por último en la sección 6 se dan las conclusiones. II. Trabajo relacionado El método de mı́nimos cuadrados ordinarios es una forma común de estimar coeficientes de regresión para ajustar datos. Es muy popular y en la mayorı́a de las aéreas de invesitagación como en la economı́a ó eléctrica frecuentemente se utiliza como primer opción para obtener los parámetros desconocidos, sin embargo tiene deficiencias muy notables. Por tal motivo es necesario buscar alternativas, aunque LASSO y RIDGE se basa en mı́nimos cuadrados, el primer modelo relacionado es la regresión ridge [11] el método más antiguo de estimación penalizada. Este método consiste en una constante no negativa que controla la compensaccón entre la bondad de ajuste del modelo, sujeta por la sumatoria de los cuadrados de los 2 coeficientes de regresión, o equivalentement a la norma L2 . La penalidad cuadrática L2 induce a una contracción hacia cero de los coeficientes pero nunca llegan a ser cero por lo cual no lo hace ser un modelo de selección de variable, después desarrollaron LASSO otro método de estimación penalizada que es mucho más utilizada que Ridge. A diferencia de la regresión Ridge, LASSO contiene la suma de los valores absolutos de los coeficientes, o norma L1 sujeta a una cota superior positiva. La solución a este problema involucra reducir exactamente a cero algunos coeficientes, por lo tanto, LASSO realiza selección de variable y contracción simultáneamente. LARS es un algoritmo que ha llamado mucho la atención, cabe mencionar que the Annals of Statistics [7] en 2004 dedica 92 páginas dedicado a este tema. El artı́culo va seguido de un debate sobre los pros y contras de LARS [19], se realizo con la colaboración de varios expertos en el tema. Otros trabajos relacionados con LASSO es LASSO-BAYESIAN [12] y ELASTIC NET [21] dos nuevas metodologı́as que en la actualidad son muy utilizadas principalmente en economı́a, lo cual indica el gran interés hacia los modelos de selección de variable que producen modelos sencillos y su aplicación de forma eficiente. III. Métodos de regresión En esta sección se presentarán los diferentes modelos de regresión. Se explica breve mente el modelo lineal para varias variables. Para usar el modelo lineal implica conocer los valores de los coeficientes para obtener una respuesta que pretendemos conocer. Para obtener los valores de los coeficientes desconocidos, se utilizan dos modelos de selección de variable LASSO y LARS, además de mı́nimos cuadrados ordinarios. B. Mı́nimos cuadrados ordinarios Mı́nimos cuadrados ordinarios, es un método estadı́stico de estimación de coeficientes desconocidos. Esta técnica minimiza el residuo de los errores al cuadrado de un conjunto de datos [10]. El método de mı́nimos cuadrados consiste en determinar los parámetros β j de tal manera que los residuos sean mı́nimos, es decir lo que se busca es minimizar la siguiente ecuación S (β j ) = n X (yi − i=1 p X X i j β j )2 El conjunto de valores de β j que minimiza la sumatoria de los errores al cuadrado son llamados estimadores de OLS, obviamente, cuanto menores son los residuos, mejor es el ajuste. La función S (β j ) es convexa, por lo tanto tiene un mı́nimo global. Minimizar n X i=1 (yi − p X El análisis de regresion lineal es una técnica estadı́stica que se utiliza para estudiar la relación entre una variable dependiente Y y las variables independientes Xi , este modelo puede ser expresado de la siguiente manera. x11 .. . xn1 ... ... ... x1p β1 y1 .. .. = .. . . . xnp β p yn El problema es encontrar el mejor conjunto de valores que tomaran los ceficientes β j , en el siguiente modelo lineal yi = Xi j β j + ∈i , (1) Donde yi es el vector de la respuesta, y las β j son los coeficientes de regresión, Xi j es la matriz de variables y ∈i es el error aleatorio. Xi j β j )2 (3) j=1 Si escribimos la ecuación (3) en forma matricial 2 y − Xβ = (y − Xβ)0 (y − Xβ) = y0 y − 2y0 Xβ + X 0 Xβ2 (4) Asumiendo que X es no-singular y que X 0 X es definida positiva, se puede derivar la ecuación (4) con respecto a β e igualar a cero, obteniendo la siguiente ecuación. −2X 0 y + 2X 0 Xβ = 0 (5) Se requiere conocer el valor de β de la ecuación (5), Entonces la ecuación (5) resuelve los estimadores de mı́nimos cuadrados ordinarios, obteniendo una solución única. β = (X 0 X)−1 X 0 y A. Modelo lineal (2) j=1 (6) Sin embargo, la pseudo-inversa X 0 X puede ser singular, es decir su determinante es igual a cero. Si este problema ocurre no es posible calcular exactamente la pseudo-inversa, debido a que no se puede invertir. Para solucionar este problema, se pueden utilizar algoritmos iterativos de aproximación [16], [4]. Además del problema mencionado con la singularidad de la matriz, mı́nimos cuadrados sobre-ajusta y no es un método de selección de variable por tal motivo no produce modelos parsimoniosos. Esta forma de encontrar los estimadores, provoca que todos sus coeficientes sean diferentes a cero, en este trabajo se presentan dos métodos de selección de variable que se inspiran en mı́nimos cuadrados y que a partir de los resultados en la predicción de las 4004 series de tiempos diferentes mejoran los problemas de mı́nimos cuadrados. C. LASSO El ”least absolute shrinkage and selection operator” LASSO [17] es un método de selección de variable. Este método utiliza la norma L1 que minimiza el residuo de los errores al cuadrado similar a mı́nimos cuadrados ordinarios pero sujeto a una restricción que tiene como cota superior un valor constante 3 t que controla la sumatoria de los valores absolutos de los coeficientes y se define de la siguiente manera. Minimizar p n X X (yi − Xi j β j )2 i=1 j=1 (7) p X |β j | ≤ t j=1 Donde t debe ser mayor o igual a cero, además que t es un parámetro a optimizar. Este parámetro se puede resuelver con validación cruzada una técnica de aprendizaje supervisado. LASSO resulta ser un problema de optimización conocida como programación cuadrática [2]. Para solucionar LASSO (7) se propone un algoritmo que utiliza una librera de optimización de python que se llama scipy. La solución no resulta ser un método de selección de variables. Con esta solución los coeficientes no toman un valor igual a cero, al contrario en cuanto se incrementa el valor de la cota superior todos los coeficientes son diferentes a cero. A esta solución le llamaremos LASSO puro, sin embargo para que los coeficientes sean igual a cero se debe aplicar un umbral para la contracción de los coeficientes. Este umbral involucra reducir exactamente a cero algunos coeficientes, por lo tanto, LASSO realiza selección de variable y contracción simultáneamente, en este trabajo se presentan dos soluciones a LASSO una que es el LASSO-puro como se menciono anteriormente y LASSO-umbral con el umbral [8], [20]. Equivalentemente (7) también se puede ver como un método de estimación penalizada [13] que contiene la suma de los valores absolutos de los coeficientes como la función de perdida que produce la contracción de los coeficientes a cero [5]. p p n X X X 2 |β j | Xi j β j ) + λ (yi − f (β j ) = (8) punto en lugar de seguir la dirección de la variable X j1 , sigue una dirección equiangular entre ambas variable, lo que hace que la correlacin sea igual al residuo actual. • Sigue el procedimiento hasta que entren todos las variables, al finalizar tenemos la solución OLS. Como se ha mencionado LARS es un nuevo algoritmo que selecciona variables y que presenta las siguientes ventajas • Es computacionalmente eficiente, pues requiere el mismo esfuerzo computacional que mı́nimos cuadrados ordinarios. • Produce una solución por cada etapa por lo que resulta interesante para usar técnicas de aprendizaje supervisado para escoger el mejor conjunto de coeficientes. • Con una simple modificación se pueden obtener otros modelos de regresión como LASSO. • Funciona muy bien cuando p ≥ n (donde el numero de variable es mayor al número de observaciones) [3] • El algoritmo es de dominio público y lo encontramos en python-Sklearn y R [14]. IV. LARS, LASSO y OLS para series de tiempo En esta sección se ejemplificaran las series de tiempo y su uso. En los últimos años las series de tiempo han tenido aplicaciones importantes en las diferentes áreas de la investigación, por ello, en esta sección se muestra una metodologı́a para inicializar las matrices requeridas para aplicar LASSO, LARS y OLS. Estas matrices se utilizan para pronosticar series de tiempo, por último vamos a identificar los parámetros a optimizar en LASSO y LARS. A. Series de tiempo D. LARS Una serie de tiempo [9] es una secuencia de datos o valores sucesivos, que son medidos en intervalos de tiempo iguales y que pueden ser ordenados cronológicamente. Una serie de tiempo se puede representar de la siguiente manera. {y1 , y2 , ...yT } o {yt }, t = 1, 2, ...T . El análisis de series de tiempo juega un papel importante para el pronóstico de eventos futuros, es por esta razón que son usadas en muchas aplicaciones, la siguiente figura muestra un ejemplo de una serie de tiempo, es una representación del punto de un (Light Amplification by Stimulated Emission of Radiation) LASER en movimiento. ”Least angle regression” LARS [7] es un nuevo modelo de selección de variable que realiza los procedimientos por etapas, en términos de tiempo de complejidad es lo equivalente al ajuste de un modelo por mńimos cuadrados ordinarios. El camino que sigue LARS para la selección de variable, es el siguiente: • Se normalizan los datos con media 0 y desviación estándar 1. • Todos los coeficientes son igual a cero. • Se busca la variable más correlacionado con la respuesta. • Se hace un salto hacia la dirección de la variable seleccionada hasta que entre otra variable, entonces en este Fig. 1. i=1 j=1 j=1 La solución de (7) y (8) es una correspondencia uno a uno entre λ y t. Si β(λ) minimiza (8) , tambien resuelve (7) con t = Pp j=1 |β j (λ)|. A esta representación se le conoce como ”basis pursuit” [5]. Existen diferentes algoritmos para resolver este problema para cada valor de λ o t. Para la solución de LASSO con umbral se aplicó coordenada descendiente [20] que se encuentra en la librerı́a de Sklearn de Python. LASER representado en una serie de tiempo. 4 El primer paso es la manera de representar cualquier medición en una serie de tiempo, para este ejemplo un laser. El segundo paso es convertir la serie de tiempo en forma de matriz y entonces obtener una formulación correcta. La siguiente tabla representa el laser de la figura (3). yt t 86 48 24 152 23 37 118 16 58 82 18 1 11 21 31 41 51 61 71 81 91 100 (9) Transformar la serie de tiempo en una matriz es necesario para aplicar los métodos de selección de variable y mı́nimos cuadrados ordinarios presentados en este trabajo. x11 . . . x1p y1 .. .. y .. (10) . . . . . . yn xn1 . . . xnp En la siguiente sección se explica cómo se transformo una serie de tiempo que solo tiene una columna a una matriz de datos para poder utilizar las metodologı́as de OLS, LASSO y LARS. B. Modelos Auto-regresivos En este apartado, solucionamos la representación de las series de tiempo en forma matricial mediante el modelo de ecuaciones auto-regresivas [18]. Un modelo del cual depende únicamente de los valores previos, por lo cual recibe el nombre de modelos auto-regresivos y tiene una representación de la siguiente forma. yt = m X ai yt−i (11) La tabla (8) muestra la representación del ejemplo del laser, para m = 3. 86 48 24 .. . 16 48 24 152 .. . 58 152 24 152 a1 23 23 a2 = 37 .. a .. . . 3 18 82 (14) C. Parámetros a optimizar Los dos modelos de selección de variable tanto LARS y LASSO tienen parámetros que se pueden optimizar con técnicas de aprendizaje supervisado. En este trabajo se aplicó validación cruzada con un 5-fold [1], esta técnica de aprendizaje supervisado divide un conjunto en k subconjuntos de datos, uno para validar y el resto para entrenar. Este procedimiento se realiza k veces hasta que cada uno de los conjuntos sea utilizado como conjunto de validación. De esta manera se calcula el error de la predicción haciendo un promedio por cada conjunto de validación a esto le llamamos error MSE. El parámetro a optimizar en LASSO, es el valor de la cota superior, además debe estar entre el rango de 0 y la sumatoria de los absolutos de coeficientes de mı́nimos cuadrados. Este valor es muy sensible, si la cota superior es muy pequeña o cero es evidente que todos los coeficientes serán ceros, por lo contrario si la cota es muy grande todos los coeficientes serán diferentes a cero. Para LARS es muy similar debemos saber cuál es la mejor etapa, es decir que subconjunto de coeficientes es el mejor, para optimizar este parámetro también se utiliza validación cruzada. i where: • yt es la serie bajo investigación. • {a1 , a2 , ..., am } son los coeficientes de la auto-regresión . • m es el orden del modelo el cual debe ser menor que la longitud de la serie de tiempo El principal problema en el análisis de las ecuaciones autoregresivas es encontrar el mejor valor para ai dada una serie de tiempo: x11 . . . x1p a1 y1 . .. .. = .. .. . . . (12) . . . xn1 . . . xnp a p yn Si se escoge un orden de m = 3, el modelo es la siguiente forma: x11 . .. ... x12 ... ... . x13 a1 .. .. a = .. . 2 . . . . a3 .. . (13) V. Resultados En esta sección se presentan los resultados de la investigación. Se presentan los algoritmos LASSO con umbral, LASSO puro, LARS en python, LARS en R y OLS para pronosticar las 4004 series de tiempo diferentes. Como se menciono en la sección anterior, es necesario definir un grado ó ventana para incializar las ecuaciones auto-regresivas y ası́ poder trasformar cada una de las series de tiempo a matrices de datos. En este trabajo se utilizó un grado de 5, además para optimizar los parámetros de LASSO y LARS se utilizó validación cruzada con 5-fold. Recordando que las 4004 series de tiempo tienen un conjunto de entrenamiento y validación, tal y cual la proporciona las competencias M1 y M3. De acuerdo a los parámetros definidos, las ecuaciones matriciales son las siguientes : x11 .. . xn1 ... ... ... x15 β1 y1 .. .. = .. . . . xn5 β5 y5 Cinco coeficientes βi . La siguiente gráfica (2) indica cuantos coeficientes son diferentes a cero de 5 posibles. En dicha gráfica se puede observar que LASSO-puro tiene más coeficientes diferentes a cero, mientras que los otros tres algoritmos muestran un similar número. Es muy importante recordar que 5 entrenamiento aplicando Validacin cruzada. Los resultados muestran un mejor rendimiento de LASSO y LARS sobre mı́nimos cuadrados ordinarios. Dichos resultados son los esperados sobre todo porque OLS tiene picos muy elevados que evidentemente representan el sobre ajuste que hace mı́nimos cuadrados. Resulta muy interesante que LARS y LASSO se comportan casi similar pero no iguales. Fig. 2. En esta gráfica se representan los números diferentes a cero que toman los coeficientes en cada una de las 4004 series de tiempo diferentes, recordar que solo son los datos en el conjunto de entrenamiento OLS no se gráfico, porque los 5 coeficientes son diferentes a cero. En la gráfica (3) se realiza un promedio de los coeficientes diferentes a cero de todas las series de tiempo a partir de los resultados de la gráfica (2), lo que resulta muy evidente que LASSO y LARS son modelos de selección de variable y OLS no lo es. Fig. 3. Fig. 4. Comparación del error MSE en el conjunto de entrenamiento para cada una de las 4004 series de tiempo Los grandes resultados obtenidos en este trabajo nos indica que LASSO y LARS puede ser utilizado como algoritmos de selección de variable sin ningn problema, además es muy fácil utilizarlos ya que se usa de la misma manera que mı́nimos cuadrados. Estos algoritmos se encuentran disponibles en diferentes librerı́as de programación libres. En la siguiente gráfica (5) muestra un promedio de la gráfica (4), evidentemente refleja que estos dos modelos de selección de variables tienden a ser mejor que OLS en términos de error en la predicción, tienden a obtener modelos muy sencillos y al mismo tiempo evitan el sobre-ajustan. Promedio de los coeficientes diferentes a cero (gráfica (2)). Otro dato importante a mencionar es que los coeficientes que se muestran en la gráfica (2) son los que finalmente se utilizarán para pronosticar el conjunto de validación que nunca se toco. En la gráfica (2) se puede observar que el mejor subconjunto de coeficientes no siempre fue menor que cinco, pero esto se debe porque al aplicar validación cruzada se generaliza el mejor subconjunto, este subconjunto es el que representa la gráfica (2). Como se puede observar en las gráficas (2) y (3), los 4 algoritmos obtienen resultados similares, notando que el algoritmo de LASSO-puro es el algoritmo que tiene más coeficientes diferentes a cero, esto se debe a que no se aplicó el umbral y no es precisamente un método de selección de variable. Sin embargo es evidente que las metodologı́as de selección de variables producen modelos parsimoniosos que son preferibles que los modelos con todas las variables, es decir, cuando se lleva a la practica estas metodologı́as son ideales. En la gráfica (4), se muestra el resultado del rendimineto de la precisión para cada una de las predicciones de las 4004 series de tiempo en términos del error MSE en el conjunto de Fig. 5. Promedio de la figura (4), resultados de error MSE en el conjunto de entrenamiento para cada una de las series de tiempo. Como se puede observar en la gráfica (5), también se obtienen muy buenos resultados en el conjunto de validación. Recordar que se utilizaron los parámetros optimizados de LARS y LASSO a partir de los resultados obtenidos en el conjunto de entrenamiento, es decir seleccionamos el mejor subconjunto de coeficientes a partir de validación cruzada para pronosticar los datos del conjunto de validación. Los resultados son muy buenos no igual que en el conjunto de entrenamiento pero era de esperarse porque los datos de validación son desconocidos totalmente, lo que indica que estos modelos de selección de variable no sobre-ajustan como lo hace mı́nimos cuadrados. 6 Fig. 8. Fig. 6. Error MSE en el conjunto de validación para cada una de las 4004 series de tiempo. Fig. 7. Promedio de la grafica (6). En la siguiente tabla se hace una comparación de los 5 algoritmos para identificar que algoritmo obtuvo en más ocasiones el menor error para cada una de las predicciones de las 4004 series de tiempo. Los resultados muestran que LARSsklearn fue el mejor, después LASSO-puro lo cual nos indica que a pesar de no ser precisamente un método de selección de variable obtiene muy buen resultado. En realidad las gráficas de los errores MSE tanto para LASSO y LARS no muestran gran diferencia y este experimento se puede tomar solo como una simple curiosidad para identificar el mejor algoritmo, la gráfica (8) muestra un resultado más claro con una gráfica por porcentajes. TABLE I Comparación de los diferentes algoritmos para el pronostico de las 4004 series de tiempo, en términos del menor error MSE Modelos LARS R LARS Sklearn LASSO Scipy LASSO Sklearn OLS Entrenamiento 768 1266 1109 550 311 Validación 547 1406 1046 550 455 Gráfica por porcentajes de los resultados de la tabla (1) VI. Conclusiones LARS y LASSO son dos enfonques de selección de variable muy prometedoras, que ofrece velocidad, facilidad de interpretación, estabilidad y una buena presentación gráfica de las rutas de los coeficientes. Los resultados son los esperados y se reafirma que los métodos de selección de variable LASSO y LARS son mejores técnicas que mı́nimos cuadrados ordinarios en términos del error promedio en la predicción de estas 4004 series de tiempo. También se puede concluir que es muy fácil utilizar estas dos técnicas y que prácticamente se utiliza de la misma manera que mı́nimos cuadrados ordinarios, por tal motivo recomendamos utilizar estas técnicas. Además que producen modelos parsimoniosos para su fácil interpretación en cualquier campo de la investigación, todo esto a un tiempo computacional muy bueno, lo que nos indica que estas técnicas son muy eficientes para su aplicación. Bibliografı́a [1] S. Arlot and A. Celisse. A survey of cross-validation procedures for model selection. Statistics Surveys, 4:40–79, 2010. [2] S. Boyd and L. Vandenberghe. Convex Optimization. Cambridge University Press, Mar. 2004. [3] P. Bhlmann. Boosting for high-dimensional linear models. The Annals of Statistics, 34(2):559–583, Apr. 2006. Mathematical Reviews number (MathSciNet): MR2281878; Zentralblatt MATH identifier: 1095.62077. [4] S. L. Campbell and C. D. Meyer. Generalized Inverses of Linear Transformations. SIAM, Mar. 2009. [5] S. S. Chen, D. L. Donoho, Michael, and A. Saunders. Atomic decomposition by basis pursuit. SIAM Journal on Scientific Computing, 20:33–61, 1998. [6] P. Drineas and M. W. Mahoney. On the Nyström Method for Approximating a Gram Matrix for Improved Kernel-Based Learning. JOURNAL OF MACHINE LEARNING RESEARCH, 6, 2005. [7] B. Efron. Least angle regression. The Annals of Statistics, 32(2):407– 499, 2004. [8] J. Friedman, T. Hastie, and R. Tibshirani. Regularization paths for generalized linear models via coordinate descent. Journal of statistical software, 33(1):1–22, 2010. PMID: 20808728 PMCID: PMC2929880. [9] N. A. Gershenfeld and A. S. Weigend. The future of time series: Learning and understanding. In A. Weigend and N. Gershenfeld, editors, Time Series Prediction: Forecasting the Future and Understanding the Past, pages 1–70. Addison-Wesley, 1993. [10] F. Hayashi. Bekaert-hodrick93. Instructional Stata datasets for econometrics bhodrick93, Boston College Department of Economics, 2000. [11] A. E. Hoerl and R. W. Kennard. Ridge regression: Biased estimation for nonorthogonal problems. Technometrics, 12:55–67, 1970. [12] T. Park and G. Casella. The bayesian lasso. Technical report, 2005. [13] B. M. Pötscher and H. Leeb. On the distribution of penalized maximum likelihood estimators: The lasso, scad, and thresholding. J. Multivar. Anal., 100(9):2065–2082, Oct. 2009. [14] R Development Core Team. R: A Language and Environment for Statistical Computing. R Foundation for Statistical Computing, Vienna, Austria, 2008. ISBN 3-900051-07-0. 7 [15] N. S. Rao, R. D. Nowak, S. J. Wright, and N. G. Kingsbury. Convex approaches to model wavelet sparsity patterns. CoRR, abs/1104.4385, 2011. [16] A. Ruhe. Rational krylov algorithms for nonsymmetric eigenvalue problems, ii: Matrix pairs, 1992. [17] R. Tibshirani. Regression shrinkage and selection via the lasso. Journal of the Royal Statistical Society, Series B, 58:267–288, 1994. [18] J. S. Tzu-Kuo Huang. Learning auto-regressive models from sequence and non-sequence data. In NIPS 2011, 2011. [19] S. Weisberg. Discussion of ”least angle regression” by efron et al. The Annals of Statistics, pages 490–494, 2004. [20] T. T. Wu and K. Lange. Coordinate descent algorithms for lasso penalized regression. Mar. 2008. [21] H. Zou and T. Hastie. Regularization and variable selection via the elastic net. Journal of the Royal Statistical Society, Series B, 67:301– 320, 2005.