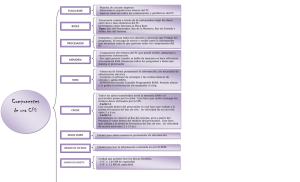

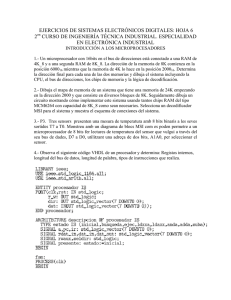

resumen - Departamento de Arquitectura y Tecnología de

Anuncio