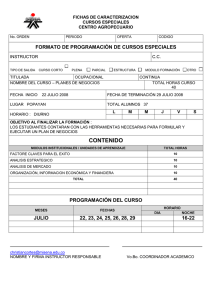

fundamentación en riesgo con risk simulator tabla de

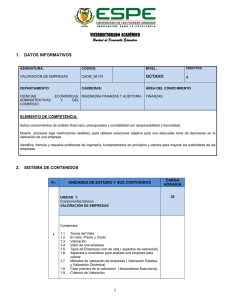

Anuncio