EVALUACIÓN Y POLÍTICA CIENTÍFICA EN ESPAÑA: el origen y la

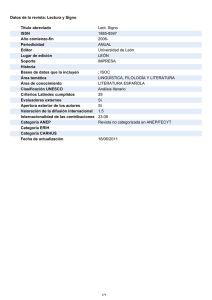

Anuncio