1. Ejemplos de Sistemas Estocásticos

Anuncio

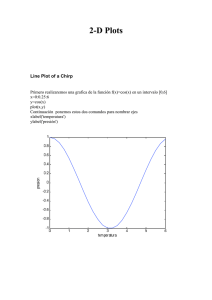

1. Ejemplos de Sistemas Estocásticos Equation Section 1 1. Ejemplos de Sistemas Estocásticos __________________________________ 1 1.1. Introducción ________________________________________________________ 1 1.2. Perturbaciones_______________________________________________________ 2 1.3. Conceptos de Probabilidad ____________________________________________ 2 1.3.1. Variable aleatoria ___________________________________________________ 2 1.3.2. Función de Densidad ________________________________________________ 3 1.3.3. Función Distribución ________________________________________________ 4 1.3.4. Probabilidad Condicional _____________________________________________ 5 1.3.5. Esperanza. ________________________________________________________ 5 1.3.6. Momentos ________________________________________________________ 5 1.3.7. Varianza __________________________________________________________ 6 1.3.8. Tipos de Distribución________________________________________________ 7 1.3.9. Correlación _______________________________________________________ 7 1.3.10. Covarianza _______________________________________________________ 9 1.4. Proceso Aleatorio ___________________________________________________ 12 1.4.1. Función de Densidad _______________________________________________ 13 1.4.2. Funciones de Distribución ___________________________________________ 15 1.4.3. Esperanza de un Proceso Estocástico ___________________________________ 17 1.4.4. Autocorrelación___________________________________________________ 18 1.4.5. Autocovarianza____________________________________________________ 19 1.4.6. Correlación Cruzada________________________________________________ 22 1.4.7. Covarianza Cruzada_________________________________________________ 22 1.4.8. Proceso Estacionario _______________________________________________ 24 1.4.9. Secuencias Estocásticas _____________________________________________ 24 1.4.10. Continuidad _____________________________________________________ 24 1.4.11. Diferenciación___________________________________________________ 24 1.4.12. Integración______________________________________________________ 24 1.4.13. Proceso Estocástico Discreto _______________________________________ 24 1.5. Procesos Estocásticos Ergódicos _______________________________________ 24 1.6. Procesos Especiales __________________________________________________ 24 1.7. Proceso de Markov__________________________________________________ 24 1.8. Teoría Básica de Probabilidad___________________ ¡Error!Marcador no definido. 1.1. Introducción Citar ejemplos industriales. Sensor de nivel 1 1.2. Perturbaciones 1.3. Conceptos de Probabilidad Generador de números aleatorios %x=[]; %a=.55; %b=pi; %x(1)=a; %for i=1:1000% %x(i+1)=x(i)*b; %x(i+1)=x(i+1)-floor(x(i+1)); %end 1.3.1. Variable aleatoria Se genera las siguientes variables aleatorias x y z de distribución gaussiana e incorreladas, y de distribución gaussiana y correlada co x n=10000; x=randn(1,n)+3; z=randn(1,n)+4; y=zeros(1,n); m=5; for i =1:n-m y(i)=mean(x(i:i+m-1)); end plot([x(1:100)' y(1:100)']); grid 2 6 5 4 3 2 1 0 0 20 40 60 80 100 1.3.2. Función de Densidad [fx,kx]=hist(x,50); fx=fx/sum(fx); [fy,ky]=hist(y,50); fy=fy/sum(fy); plot(kx,fx,'b',ky,fy,'r');grid 3 0.09 0.08 0.07 0.06 0.05 0.04 0.03 0.02 0.01 0 -2 -1 0 1 2 3 4 5 6 7 la densidad de x es mas aplanada por tener mayor dispersión 1.3.3. Función Distribución Fx=cumsum(fx); Fy=cumsum(fy); plot(kx,Fx,'b',ky,Fy,'r');grid 4 1 0.9 0.8 0.7 0.6 0.5 0.4 0.3 0.2 0.1 0 -2 -1 0 1 2 3 4 5 6 7 1.3.4. Probabilidad Condicional 1.3.5. Esperanza. ∞ E ( x , k 1 ) = ∫ ξ f x ( k 1 ,ξ ) dξ = m( k 1 ) [1.1] -∞ mx=mean(x); my=mean(y); [mean(x) fx*kx' mean(y) fy*ky'] ans = 3.0072 3.0069 3.0055 3.0061 1.3.6. Momentos E X n = ∫ x n f X ( x ) dx b a [1.2] El momento de segundo orden (n=2) es el valor medio cuadrático de X. 5 Ex=fx*(kx.^2)'; Ey=fy*(ky.^2)'; [Ex Ey] ans = 10.0150 9.2366 momentos centrados n E ( X − m X ) = ∫ (x −m ) b a X n f X ( x ) dx [1.3] Ex1=fx*(kx-mx)'; Ex2=fx*((kx-mx).^2)'; Ey1=fy*(ky-my)'; Ey2=fy*((ky-my).^2)'; [Ex1 Ex2 Ey1 Ey2] ans = -0.0003 0.9734 0.0005 0.2002 el momento de segundo orden de x es mayor que el de y. Esto se debe a la mayor dispersión de sus valores 1.3.7. Varianza [cov(x) fx*((kx-mx).^2)' std(x) cov(y) fy*((ky-my).^2)' std(y)] ans = 0.9719 0.9734 0.9859 0.1999 0.2002 0.4470 6 y tiene menos varianza que x. 1.3.8. Tipos de Distribución fnx=1/std(x)/(2*pi)^.5*exp(-(kx-mx).^2/2/(std(x)^2)); fnx=fnx/sum(fnx); plot(kx,fnx,kx,fx);grid 0.07 0.06 0.05 0.04 0.03 0.02 0.01 0 -2 -1 0 1 2 3 4 5 6 7 Una variable aleatoria (escalar) se dice que tiene una distribución Gaussiana o Normal si su función de densidad de probabilidad está dada por: pX ( x ) = 1 σX ( x − mX )2 exp − 2σ 2X 2π [1.4] Es fácil de probar que los momentos de orden n, con n ≥ 3 , quedan unívocamente determinados por los momentos de primer y segundo orden, o sea el valor medio m X y la varianza σ 2X . 1.3.9. Correlación Un momento conjunto de gran importancia es la correlación definida por E [X Y ] que corresponde a i = k = 1 en 7 E [ XY ] = ∫ b a ∫ b a xyf X ,Y ( x, y ) dxdy [1.5] crxx=xcorr(x,x); crxz=xcorr(x,z); crxy=xcorr(x,y); plot([crxx' crxy' crxz']);grid 4 14 x 10 12 10 8 6 4 2 0 -2 0 0.5 1 1.5 2 x 10 4 haciendo una ampliación del origen, plot([crxx(9900:10100)' crxy(9900:10100)' crxz(9900:10100)']);grid 8 5 1.25 x 10 1.2 1.15 1.1 1.05 1 0.95 0.9 0.85 0 50 100 150 200 250 el producto de los valores medios de x e y es 9 el producto de los valores medios de x y z es 12 1.3.10. Covarianza Las correlaciones entre las variables centradas E [X − E [X ]] e E [Y − E [Y ]] se denomina covarianza de X e Y, y se denota: r XY (j,k)=cov X jYk = E ( X j - m Xj ) (Yk - mYk ) = ∫ ∫ ( x - m Xj ) ( y - mYk ) f(X,Y,j,k) dx,dy [1.6] llamando mX = E [ X ] y mY = E [Y ] resulta: r XY (j,k)=cov X jYk = E X jYk − mXj mYk [1.7] Se dice que dos variables aleatorias X e Y están no correlacionadas si y sólo si su covarianza es cero, i.e. 9 r XY (j,k)= 0 [1.8] Se define de igual manera la Autocorrelación para una única variable. 2 rX (j,k)= cov X j = E ( X j - m Xj ) = ∫ ∫ ( x - m Xj ) f(X,j,k) dx 2 [1.9] 2 cvxx=xcorr(x-mean(x),x-mean(x)); cvxz=xcorr(x-mean(x),z-mean(z)); cvxy=xcorr(x-mean(x),y-mean(y)); plot([-9:11],cvxx(9991:10011));grid 10000 8000 6000 4000 2000 0 -2000 -10 -5 0 5 10 15 10 plot([-9:11],cvxy(9991:10011));grid 2000 1500 1000 500 0 -500 -10 -5 0 5 10 15 10 15 plot([-9:11],cvxz(9991:10011));grid 200 150 100 50 0 -50 -100 -150 -10 -5 0 5 11 La autocorrelación x solo tiene un pico en k=0 La correlación entre x e y tiene valores entre 0 y –5 por la forma en que se ha generado y . La correlación entre x y z es prácticamente nula ya que no están relacionadas. 1.4. Proceso Aleatorio Los procesos varían en el tiempo. Se definen procesos con n realizaciones y m muestras temporales m=100; n=1000; x=randn(m,n)+3; den=[1 -.94]; num=sum(den); y=filter(num,den,x); plot(y(:,1:10)); grid 3.5 3 2.5 2 1.5 1 0.5 0 0 20 40 60 80 100 12 Respuesta al impulso del filtro imp=zeros(m,1); imp(1)=1000; rimp=filter(num,den,imp); plot(rimp); grid 70 60 50 40 30 20 10 0 0 20 40 60 80 100 Para cada instante de tiempo se tiene una variable aleatoria. 1.4.1. Función de Densidad nb=50; [fx,kx]=hist(x',nb); mesh([1:m],[1:nb],fx) 13 nb=50; [fy,ky]=hist(y',nb); waterfall([1:m],[1:nb],fy) 500 400 300 200 100 0 60 100 40 80 60 20 40 0 20 0 14 1.4.2. Funciones de Distribución Para conocer un proceso estocástico se necesitaría saber la función de distribución de probabilidades en todo instante condicionada a los tiempos anteriores y posteriores. Es decir: FX ( X (t1 ) , X ( t2 ) ,L X ( tn ) , t1 , t2 ,L ,t n ) = P ( X ( t1 ) ≤ xt1, X ( t 2 ) ≤ xt 2, L X ( tn ) ≤ xtn ) [1.10] para todo tiempo t y todo n Esto en la práctica es imposible obtener por lo que se definen las funciones de distribución de primer y segundo orden. La función de distribución de primer orden corresponde a la distribución de la variable en un tiempo dado FX ( X (t0 ) , t0 ) = P ( X ( t0 ) ≤ xt 0 ) [1.11] Si se quieren relacionar dos tiempos se utiliza la distribución de segundo orden FX ( X (t1 ) , X ( t2 ) , t1 , t2 ) = P ( X ( t1 ) ≤ xt1, X ( t 2 ) ≤ xt 2 ) [1.12] Fx=cumsum(fx); Fy=cumsum(fy); mesh([1:m],[1:nb],Fx) 15 mesh([1:m],[1:nb],Fy) 16 1.4.3. Esperanza de un Proceso Estocástico Para un proceso aleatorio X (t ) se define la media de X (t ) como el valor esperado de la variable aleatoria obtenida observando el proceso en algún tiempo t, o sea: m X ( t ) = E x ( t ) = ∫ +∞ −∞ xf X (t ) ( x ) dx [1.13] mx=mean(x'); plot([mx kx'*fx/n]);grid 3.1 3.05 3 2.95 2.9 2.85 0 50 100 150 200 my=mean(y'); plot([my' (ky'*fy/n)']);grid 17 3.5 3 2.5 2 1.5 1 0.5 0 0 20 40 60 80 100 1.4.4. Autocorrelación La función de autocorrelación del proceso X (t ) se define como el valor esperado del producto de las variables aleatorias X (t1 ) y X (t2 ) en los instantes t1 y t2 respectivamente, es decir: +∞ RX (t 1, t2 ) = E X ( t1 ) X ( t2 ) = ∫ −∞ ∫ +∞ −∞ x1 x2 f X (t1 ) X (t2 ) ( x1 , x2 )dx1dx2 [1.14] A fin de simplificar la simulación se considerará solo una fila de la matriz de autocorrelación crxx=[]; for i=1:m crxx(i,:)=xcorr(x(1,:),x(i,:)); end mesh([1:m],[1:1999],crxx') 18 1.4.5. Autocovarianza La función de autocovarianza del proceso estocástico X (t ) se define como: C X ( t1 , t2 ) = E ( X (t1 ) − mX (t1 ) )( X (t2 ) − mX (t2 ) ) = R X ( t1 , t2 ) − mX (t1 )mX (t2 ) [1.15] cvxx=[]; for i=1:m cvxx(i,:)=xcorr(x(1,:)-mean(x(1,:)),x(i,:)-mean(x(i,:))); end mesh([1:m],[1:1999],cvxx') 19 cvyy=[]; for i=1:m cvyy(i,:)=xcorr(y(1,:)-mean(y(1,:)),y(i,:)-mean(y(i,:))); end mesh([1:m],[1:1999],cvyy') 20 21 1.4.6. Correlación Cruzada Para el caso más general de tener dos procesos aleatorios X (t ) e Y (t ) con funciones de auto correlación RX ( t1, t2 ) y RY ( t1 , t2 ) respectivamente, se definen las dos funciones de correlación cruzada: RXY (t1 , t2 ) = E X ( t1 ) Y ( t 2 ) RYX ( t1, t2 ) = E Y (t1 ) X (t 2 ) [1.16] cvxx=[]; for i=1:m cvxx(i,:)=xcorr(x(1,:)-mean(x(1,:)),x(i,:)-mean(x(i,:))); end mesh([1:m],[1:1999],cvxx') Las propiedades de correlación de los dos procesos se pueden representar entonces en forma matricial, definiendo la matriz de correlación de los procesos aleatorios X (t ) e Y (t ) como: R (t , t ) R XY ( t1, t2 ) R ( t1, t2 ) = X 1 2 RYX ( t1 , t2 ) RY ( t1 , t2 ) [1.17] 1.4.7. Covarianza Cruzada De igual modo, para dos procesos estocásticos se define la función de covarianza cruzada como: C XY ( t1, t2 ) = E ( X (t1 ) − m X ( t1 ) )(Y (t2 ) − mY ( t2 ) ) = R XY ( t1, t2 ) − mX (t1 ) mY ( t2 ) [1.18] cvxy=[]; for i=1:m cvxy(i,:)=xcorr(x(1,:)-mean(x(1,:)),y(i,:)-mean(y(i,:))); end mesh([1:m],[1:1999],cvxy') 22 Se puede comparar la covarianza cruzada con la respuesta impulsional plot([cvxy(:,1000) rimp]);grid 70 60 50 40 30 20 10 0 -10 0 20 40 60 80 100 23 1.4.8. Proceso Estacionario 1.4.9. Secuencias Estocásticas 1.4.10. Continuidad 1.4.11. Diferenciación 1.4.12. Integración 1.4.13. Proceso Estocástico Discreto 1.5. Procesos Estocásticos Ergódicos 1.6. Procesos Especiales 1.7. Proceso de Markov 1.8. Ejemplo de Sistema Continuo en Variables de Estado Movimiento Browniano por agitación térmica de partículas en una dimensión m d 2x dx +c = f 2 dt dt [1.19] se puede demostrar que si la masa es relativamente grande, para x y t se puede considerar el choque como elástico y en ese caso f es ruido blanco. x1 = x x2 = dx dt dx1 1 x1 0 dt 0 = + c 1 f dx2 0 − m x2 m dt [1.20] [1.21] usando la ecuación diferencial estocástica, dx2 = − c m x2dt + 1 m fdt [1.22] fdt es el impilso que recibe la partícula por lo que se puede asociar a un proceso de Wiener. La media, dmx (t ) = Amx (t ) dt [1.23] 24 dPx (t) = APx ( t) + Px (t ) AT + Rx 1 dt [1.24] Rx ( s, t ) = Φ ( s, t) Px ( t) [1.25] mx (0) = 0 ⇒ mx (t ) = 0 ∀t [1.26] 1 x 0 dx1 0 1 dt = + 1 dW dx 0 − c x 2 2 m m [1.27] cálculo de la matriz de transición 1 1 t 0 Φ (t ) = exp ∫ c dt = 0 0 − m 0 m ct 1 − exp − c m ct exp − m [1.28] la matriz de covarianza, dP1 dt dP2 dt dP2 0 1 P1 dt = dP3 0 − c m P2 dt P2 P1 + P3 P2 0 0 P2 0 + P3 1 − c m 0 0 r m2 [1.29] La matriz de la derecha es la matriz de covarianza de un proceso de Wiener dP1 = 2 P1 dt dP2 = − c P2 + P3 m dt dP3 r = −2 c P3 + 2 m dt m se supone para t=0, x=0 y que [1.30] dx dP (0) = cte , 3 =0 dt dt P1 (0) = 0 covarianza de la posición P2 (0) = 0 covarianza de la posición y la velocidad P3 (0) = r 2mc la ley de conservación de energía térmica dice 25 1 1 kT = mE x22 2 2 [1.31] 1 1 r kT = m 2 2 2mc [1.32] r = 2kTc [1.33] reemplazando resulta P1 (t) = 2 kT c P2 ( t) = kT c P3 (t ) = kT m ( ) − ct m m t − c 1 − e 1 − e− ct m [1.34] [1.35] [1.36] la correlación será r11 ( s, t ) = P1 (t) + − c ( s− t) m m 1 − e P2 (t ) c kT −c ( s− t) m r22 ( s, t ) = e m [1.37] 26