μ μ μ μ σ σ σ σ σ σ σ σ σ σ σ σ σ σ σ σ σ σ σ σ σ

Anuncio

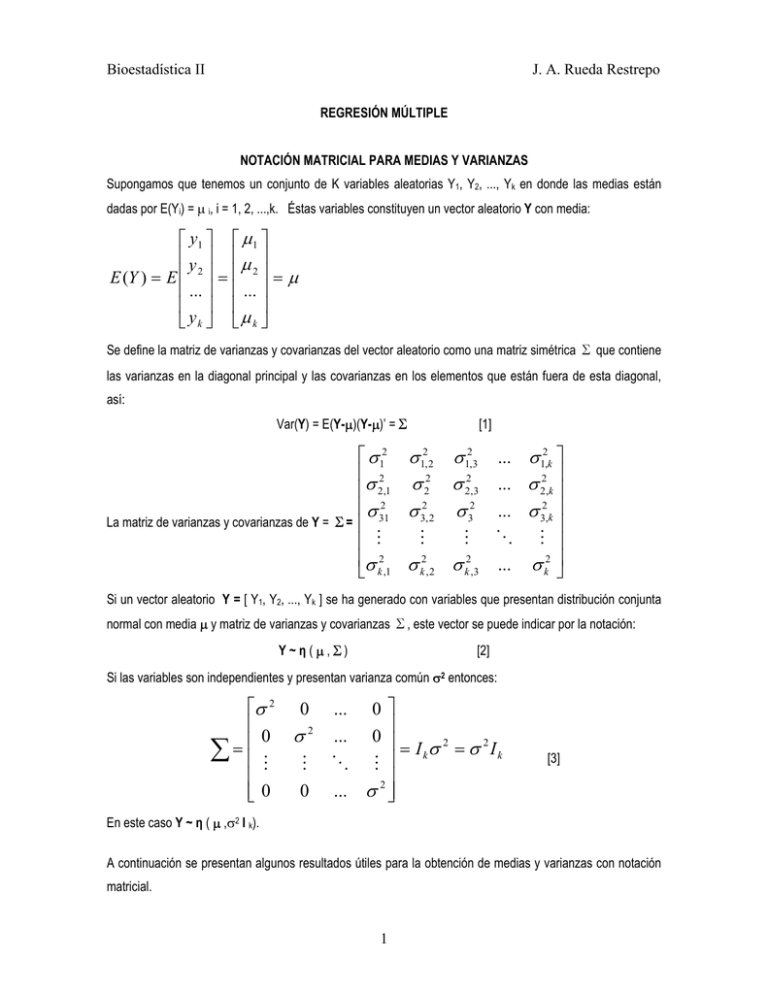

Bioestadística II J. A. Rueda Restrepo REGRESIÓN MÚLTIPLE NOTACIÓN MATRICIAL PARA MEDIAS Y VARIANZAS Supongamos que tenemos un conjunto de K variables aleatorias Y1, Y2, ..., Yk en donde las medias están dadas por E(Yi) = µ i, i = 1, 2, ...,k. Éstas variables constituyen un vector aleatorio Y con media: ⎡ y1 ⎤ ⎡ µ 1 ⎤ ⎢ y ⎥ ⎢µ ⎥ E (Y ) = E ⎢ 2 ⎥ = ⎢ 2 ⎥ = µ ⎢ ... ⎥ ⎢ ... ⎥ ⎢ ⎥ ⎢ ⎥ ⎣ yk ⎦ ⎣µ k ⎦ Se define la matriz de varianzas y covarianzas del vector aleatorio como una matriz simétrica ∑ que contiene las varianzas en la diagonal principal y las covarianzas en los elementos que están fuera de esta diagonal, así: Var(Y) = E(Y-µ)(Y-µ)’ =∑ La matriz de varianzas y covarianzas de Y = ∑= [1] ⎡ σ 12 σ 12, 2 σ 12,3 ... σ 12,k ⎤ ⎢ 2 2 2 2 ⎥ ⎢σ 2,1 σ 2 σ 2,3 ... σ 2,k ⎥ ⎢ σ 312 σ 32, 2 σ 32 ... σ 32,k ⎥ ⎢ ⎥ M M M O M ⎢ ⎥ ⎢σ 2 σ 2 σ 2 ... σ 2 ⎥ k ,2 k ,3 k ⎦ ⎣ k ,1 Si un vector aleatorio Y = [ Y1, Y2, ..., Yk ] se ha generado con variables que presentan distribución conjunta normal con media µ y matriz de varianzas y covarianzas ∑, este vector se puede indicar por la notación: Y ~ η ( µ ,∑) [2] Si las variables son independientes y presentan varianza común σ2 entonces: ⎡σ 2 ⎢ ⎢0 = ∑ ⎢M ⎢ ⎣⎢ 0 0 σ2 M 0 ⎤ ⎥ ⎥ = I σ 2 = σ 2I k k ⎥ ⎥ ... σ 2 ⎦⎥ ... ... O 0 0 M [3] En este caso Y ~ η ( µ ,σ2 I k). A continuación se presentan algunos resultados útiles para la obtención de medias y varianzas con notación matricial. 1 Bioestadística II J. A. Rueda Restrepo 1. Sea Y un vector de k variables aleatorias con media µ y sea A una matriz A=(ai,j), entonces: E(AY) = Aµ. 2. Sea Y un vector aleatorio con E(Y) = 0 y matriz de varianzas y covarianzas Iσ2. Sea A una matriz real simétrica, entonces: E(Y’AY) = σ2 tr(A), en la que tr(A) es llamada la traza de la matriz A, y esta definida como la suma de los elementos de la diagonal principal de A. 3. Sea Y un vector de k variables aleatorias con E(Y) = µ y Var(Y) = ∑. Sea A una matriz de orden nxk. Sea Z = AY, entonces: Var(Z) = Var(AY) = A∑A’ [4] EL MODELO DE REGRESIÓN LINEAL EN TÉMINOS MATRICIALES. Ynx1 = X nxp β px1 + ε nx1 Con 2 σ kxk Y( nx1) ⎡ y1 ⎤ ⎢y ⎥ = ⎢ 2⎥ ⎢ ... ⎥ ⎢ ⎥ ⎣ yn ⎦ [5] ε ~ η(0;σ2I) ⎡σ 2 0 0 ... 0 ⎤ ⎢ ⎥ 2 0 ... 0 ⎥ ⎢0 σ =⎢ 0 0 σ 2 ... 0 ⎥ ⎢ ⎥ M M M O M ⎢ ⎥ 2⎥ ⎢0 0 0 ... σ ⎦ ⎣ ⇒ Y '(1xn ) = [ y1 y2 ... yn ] ∧ ⇒ Y 'Y = ∑ yi2 En el caso de regresión lineal simple (una sola variable independiente) Se define (note que p = k + 1, con k = número de variables independientes) X ( nx 2 ) ⎡1 ⎢1 ⎢ = ⎢1 ⎢ ⎢... ⎢⎣ 1 x1 ⎤ x2 ⎥⎥ ⎡1 x3 ⎥ ⇒ X '( 2 xn ) = ⎢ ⎥ ⎣ x1 ... ⎥ xn ⎥⎦ 1 ... 1 ⎤ x3 ... xn ⎥⎦ , y de esta forma 1 x2 2 n i =1 Bioestadística II J. A. Rueda Restrepo X ' X ( 2 x 2) Por idéntico razonamiento ⎡ ⎢ n =⎢ n ⎢ x i ⎢⎣∑ i =1 X ' Y( 2 x1) ⎤ ⎥ i =1 ⎥ n xi2 ⎥ ∑ ⎥⎦ i =1 n ∑x i [6]. ⎤ ⎡ n y ⎢∑ i ⎥ = ⎢ ni =1 ⎥ ⎢ xy⎥ i i ⎥⎦ ⎢⎣∑ i =1 [7] Matriz de coeficientes β: ⎡β ⎤ ⎡b ⎤ β 2 x1 = ⎢ 0 ⎥ ← b2 x1 = ⎢ 0 ⎥ ⎣ β1 ⎦ ⎣ b1 ⎦ En forma general, considere el caso en el cual se desea modelar la variabilidad total de una variable respuesta de interés, en función de relaciones lineales con dos o más variables predictoras, formuladas simultáneamente en un único modelo. Suponemos en principio que las variables predictoras guardan poca asociación lineal entre sí, es decir, cada variable predictora aporta información independiente de las demás predictoras presentes en el modelo (hasta cierto grado, la información aportada por cada una no es redundante). La ecuación del modelo de regresión en este caso es: Yi = β 0 + β1 X i ,1 + β 2 X i , 2 + L + β k X i ,k + ε i Para una regresión con K variables independientes se tiene: X ( nxk +1) ⎡1 ⎢1 ⎢ = ⎢1 ⎢ ⎢M ⎢1 ⎣ x1,1 x1, 2 x2,1 x2, 2 x3,1 x3, 2 M M xn ,1 xn , 2 L L L O L x1, k ⎤ ⎡1 ⎢x x2, k ⎥⎥ ⎢ 1,1 x3, k ⎥ ⇒ X '( k +1xn ) = ⎢ x1, 2 ⎢ ⎥ M ⎥ ⎢ M ⎢ x1, k xn , k ⎥⎦ ⎣ de esta forma 3 1 x2,1 x2, 2 M x2, k 1 x3,1 x3, 2 M x3, k L 1 ⎤ L xn ,1 ⎥⎥ L xn , 2 ⎥ ⎥,y O M ⎥ L xn , k ⎥⎦ Bioestadística II X ' X ( pxp ) J. A. Rueda Restrepo ⎡ ⎢ n ⎢ n ⎢ x 1, j ⎢∑ i =1 =⎢ n ⎢∑ x2, j ⎢ i =1 ⎢ M ⎢n ⎢∑ xk , j ⎣ i =1 n ∑x X 'Y( px1) Por idéntico razonamiento i =1 L ∑x 2 2, j L M O 1, j 2 , j i =1 ∑x k, j n x 2 , j 1, j ∑x x ∑x 2 1, j ∑x n L i =1 n i =1 2, j n ∑x i =1 n ∑x 1, j i =1 n ⎤ ⎥ i =1 ⎥ n x1, j xk , j ⎥ ∑ ⎥ i =1 n ⎥ x2, j xk , j ⎥ [8]. ∑ ⎥ i =1 ⎥ M n ⎥ 2 x ∑ k, j ⎥ i =1 ⎦ n i =1 M n ∑x x k , j 1, j i =1 x k , j 2, j ⎡ n ⎤ ⎢ ∑ yi ⎥ ⎢ ni =1 ⎥ ⎢ x y⎥ i ,1 i ⎢∑ ⎥ i =1 ⎥ =⎢ n ⎢∑ xi , 2 yi ⎥ ⎢ i =1 ⎥ ⎢ M ⎥ ⎢ n ⎥ x y ⎢∑ i , k i ⎥ ⎣ i =1 ⎦ L [9] Matriz de coeficientes β: ⎡b0 ⎤ ⎡β0 ⎤ ⎢b ⎥ ⎢β ⎥ 1 ⎢ 1⎥ ⎢ ⎥ β px1 = ⎢ β 2 ⎥ ← bpx1 = ⎢b2 ⎥ ⎢ ⎥ ⎢ ⎥ M ⎢M⎥ ⎢ ⎥ ⎢⎣bk ⎥⎦ ⎢⎣ β k ⎥⎦ [10] El modelo estimado tiene la forma: Yˆnx1 = X nxp βˆ px1 = X nxp b px1 n Con b tal que minimiza ∑e i =1 1 2 i = e12 + e22 + ... + en2 = e' e , siendo P = k + 1, Siendo k el número de variables independientes 4 1 [11] e = Y − Yˆ Bioestadística II J. A. Rueda Restrepo Por lo tanto, e ' e = ( Y − X βˆ )' ( Y − X βˆ ) = ( Y ' − βˆ ' X ' )( Y − X βˆ ) e ' e = Y ' Y − Y ' X βˆ − βˆ ' X ' Y + βˆ ' X ' X βˆ Nótese que Y ' X βˆ = ( βˆ ' X ' Y )' , y que βˆ ' X ' Y es un escalar, y por esto: e ' e = Y ' Y − 2 βˆ ' X ' Y + βˆ ' X ' X βˆ Derivando con respecto a β e igualando a cero. ∂ (e' e) = 0 = −2 X ' Y + 2 X ' Xβˆ ⇔ X ' Xβˆ = X ' Y ∂β ( X ' X ) −1 ( X ' X )βˆ = ( X ' X ) −1 X 'Y Por lo que b = βˆ = ( X ' X )−1 X 'Y [12] La inversa de la matriz de la ecuación [8], premultiplicada por la matriz de la ecuación [9], estima los betas que minimizan la suma de cuadrados de los errores. La inversa de la matriz existe bajo ciertas condiciones, la más importante de las cuales es que todas sus filas y columnas sean linealmente independientes, es decir que ninguna se pueda escribir como una combinación lineal de las otras. De esta manera, el modelo toma la forma: Yˆ = Xβˆ = X ( X ' X ) −1 X ' Y Por conveniencia futura en la notación, se define la matriz (hat = sombrero) H = X ( X ' X ) −1 X ' [13] La cual tiene gran importancia en el análisis de adecuación del modelo. El modelo asume así la forma: Yˆ = HY (H le pone el sombrero Y) [14]. El vector de residuales puede ser escrito como: e = Y − Yˆ = (I − H )Y [15] Por esto, la varianza de los residuales se estima como: Var (e) = σ 2 ( I − H ) 5 [16] Bioestadística II J. A. Rueda Restrepo ANÁLISIS DE VARIANZA En las siguientes fórmulas J es una matriz de n × n cuyas entradas son todas iguales a 1, e I es la matriz identidad de dimensión n × n: Fuente de Sumas de cuadrados variación Grados de Cuadrado medio Razón F libertad Regresión 1 ⎞ ⎛ SSR = y ' ⎜ H − J ⎟ y n ⎠ ⎝ Error SSE = y ' (I − H ) y Total 1 ⎞ ⎛ SST = y ' ⎜ I − J ⎟ y n ⎠ ⎝ k CMR = SSR k n−k−1 CME = SSE n − k −1 Fc = CMR ~ f k ,n−k −1 CME n−1 Bajo los supuestos relativos a los errores del modelo, el estimador insesgado de la varianza corresponde a: σ̂ 2 = MSE [17] La matriz de varianzas covarianzas de b es: V (b) = σ 2 ( X `X ) −1 [18] Esta matriz (la cual es simétrica) tiene sobre su diagonal principal a las varianzas de los estimadores de los parámetros, ( ) 0 1 2 j V(bj), j=0,1,2 ,...,k y por fuera de su diagonal principal a las covarianzas entre tales estimadores, es decir, el elemento en la posición j ,l es COV (bj,bl). REGRESIÓN POLINÓMICA En el caso con variables predictoras cuantitativas, existe la llamada regresión polinomial en la que se utilizan términos cuadráticos y de orden superior de estas variables, como en los diseños experimentales para optimización de procesos mediante la metodología de superficie de respuesta. A pesar de la naturaleza no lineal de tales superficies de respuesta, estos modelos son casos del modelo de regresión lineal general. Otros modelos pueden usar funciones de respuesta curvilíneas, en los cuales se utilizan variables transformadas de forma compleja, para linealización del modelo. 6