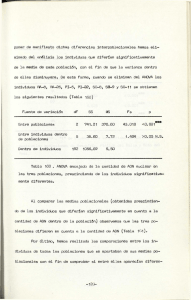

Resumen ANOVA simple.

Anuncio

ANOVA simple

Contraste de ANOVA

El ANOVA simple trata de analizar si dos variables Y (continua, llamada

variable respuesta) y F (categórica, llamada factor), son independientes

o no (es decir, si hay relación entre ellas, si hay diferencias significativas en

el valor de la primera según el valor que tome la segunda, si el factor influye

en la variable respuesta, etc.). Por ejemplo, podemos pensar en la variable

Y como el tiempo que tarda en curar un paciente, y en el factor F como

el medicamento que se le administra. Si consideramos que el factor tiene k

valores posibles, que representamos por F1 , . . . , Fk , y que llamamos niveles

del factor (por ejemplo, en el ejemplo anterior podemos pensar que hay k

medicamentos posibles), entonces la hipótesis que se contrasta es:

H 0 : µ1 = µ2 = · · · = µk

H1 : alguna µi es distinta

donde µ1 , . . . , µk representan las medias correspondientes a cada nivel del

factor (si Y es el tiempo de curación y F el tipo de medicamento, entonces

µ1 serı́a el tiempo medio que tardan en curar los pacientes a los que se les administró el medicamento F1 , etc). Observemos que, si aceptamos H0 , estamos

diciendo que en todos los casos la media de Y es la misma independientemente

del valor del factor, y por tanto que Y y F son independientes (por ejemplo,

que el tiempo medio de curación es el mismo siempre, y por lo tanto que el

tipo de medicamento no influye especialmente en el tiempo de cura). La media

conjunta de todos los datos se llama media global, µ. En caso de aceptar

H0 , estaremos aceptando no sólo la igualdad entre las µi , sino también que

todas las µi son iguales a la media global, µ.

Para contrastar H0 , utilizaremos la noción de variabilidad, que esencialmente

coincide con la de dispersión. Para medir la variabilidad de los datos Yij (el

primer subı́ndice, i, indica el nivel de factor al que pertenece el dato, y el

segundo, j, el orden que ocupa el dato dentro de los recogidos en ese nivel)

utilizaremos la suma de cuadrados totales (SCT), y la descompondremos

en suma de dos: suma de cuadrados residual o intra-grupos (SCR),

que tiene que ver con la variabilidad dentro de cada nivel de factor, y la

suma de cuadrados explicada o entre-grupos (SCR), que tiene que

ver con las diferencias entre la media de cada factor, y la media global. Más

concretamente, se cumple:

1

X

|

(Yij − µ)2 =

{z

}

SCT

X

|

(Yij − µi )2 +

{z

}

SCR

X

|

(µi − µ)2

{z

}

SCE

Claramente, si H0 es cierta, entonces SCE será pequeña frente a SCT. De

hecho, se llama porcentaje de variabilidad explicada a (SCE/SCT )·100.

En general, podemos decir que H0 será aceptada si el porcentaje anterior no

es demasiado alto. Si es suficientemente alto, entenderemos que el factor que

hemos introducido está realmente explicando las diferencias que observamos

entre los valores de la variable Y , y por tanto que efectivamente hay cierta

relación entre Y y F , con lo cuál H0 es falsa. Observemos también que si

H0 se rechaza, ello no implica que todas las µi sean distintas entre sı́, sino

simplemente que alguna(s) de ellas es diferente a las demás. De hecho, pueden

localizarse los diferentes grupos que aparecen entre los niveles del factor (i.e.

las medias que se consideran similares entre sı́) mediante la opción Contraste

múltiple de rango, de Statgraphics.

Las diferencias que aparecen entre los datos, y que no son explicadas por el factor introducido, se consideran debidas al azar. Se llama error experimental

a la parte de la variabilidad de los datos debida al azar. Puede estimarse como

la raı́z cuadrada de la suma de cuadrados medios intra-grupos, que aparece

en la tabla de ANOVA (esta tabla la proporciona Statgraphics).

Modelo de ANOVA

En el modelo de ANOVA se supone que cada observación Yij puede expresarse

como

Yij = µi + ²ij = µ + αi + ²ij

A los valores ²ij se les llama residuos, y se corresponden con las desviaciones

de cada dato respecto a la media del nivel del factor al que pertenecen (µi ); se

consideran debidos al azar. Los valores αi se llaman efectos de cada nivel (αi

es el efecto del nivel i, etc.) y se consideran una medida de la “tendencia” que

tienen los datos a desviarse de la media global, según el nivel del factor al que

pertenezcan (por ejemplo, en el caso del tiempo de curación, el efecto de cada

medicamento serı́a una medida del “adelanto” o “retraso” en cuanto al tiempo

medio de curación que supone la administración de uno u otro medicamento).

Los efectos se calculan como

αi = µi − µ

Además, en términos de los efectos, las hipótesis nula y alternativa que se

contrastan en el ANOVA, pueden enunciarse como

H0 : α1 = α2 = · · · = αk = 0

H1 : algún αi 6= 0

2

Hipótesis del modelo: Para que lo anterior “funcione”, es necesario que las

variables y los datos cumplan ciertos requisitos:

(i) Y es normal en cada nivel de factor.

(ii) La varianza es la misma en cada nivel de factor (homocedasticidad).

(iii) Independencia de las observaciones. Tiene que ver con que no haya ningún

factor que altere el proceso de recogida de datos (por ejemplo, la pereza del

observador, la posibilidad de que algunos encuestados “pasen información”

a otros posibles encuestados y se altere de ese modo el resultado, etc.). En

la práctica, se comprueba contrastando si los residuos son aleatorios (lo cuál

requiere guardarlos primero, utilizando la opción apropiada de Statgraphics).

Las condiciones anteriores implican que los residuos siguen una distribución

normal de media 0 y desviación tı́pica igual a la observada en cada nivel de

factor, y son independientes unos de otros (i.e. son aleatorios).

Si alguna de las hipótesis de arriba falla, las conclusiones del ANOVA son

dudosas.

Contraste de Kruskal-Wallis: Este es un contraste no-paramétrico, que

únicamente requiere que la variable Y sea continua. Se trata de un contraste

sobre la igualdad de las medianas. Por lo tanto, la hipótesis nula es, en este

caso,

H0 : M1 = M2 = · · · = Mk

H1 : alguna Mi es distinta

Este contraste utiliza, como otros contrastes no-paramétricos, la noción de

rango. La idea es ordenar de menor a mayor todos los datos (mezclando niveles

de factor distintos), asignar rangos, y comparar después los rangos medios

correspondientes a los distintos niveles del factor.

Si las hipótesis de ANOVA (que hemos descrito arriba) se verifican, este

contraste proporciona otro método para comprobar esencialmente la misma

condición. Si alguna de las hipótesis de arriba falla, este test permite realizar

con fiabilidad el contraste pedido.

3