Document

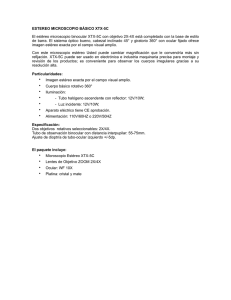

Anuncio