Estudios de Epistemología n°IX - Facultad de Filosofía y Letras

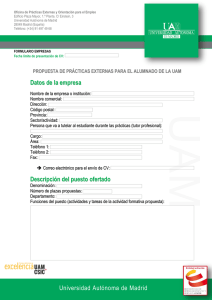

Anuncio