RESUMEN En este artículo el autor analiza las dificultades de

Anuncio

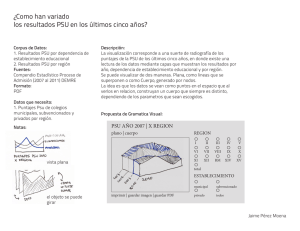

RESUMEN En este artículo el autor analiza las dificultades de compatibilizar los conceptos de Calidad educativa con la Medición de la misma, criticando la práctica ambigua que hacen los instrumentos de Medición de calidad. Sostiene que la forma en que se mide calidad en las pruebas estandarizadas aplicadas a alumnos chilenos no son mediciones de calidad de la educación y que tampoco ello puede ser legislado en el parlamento. El artículo muestra la incoherencia conceptual de calidad de la educación al medirla con pruebas tales como la PSU o el SIMCE chilenos. Específicamente, muestra como los puntajes estandarizados de ambas no miden calidad. Además, usa el caso de la manuscritura para mostrar que no hay contenidos de calidad ligados a la misma y se pregunta ¿qué se considera una buena pedagogía para enseñar manuscritura o aritmética? En suma, el autor se plantea el problema de la medición de la calidad de la educación y la operacionalización de la misma, mostrando que son muchos los factores que inciden en la calidad y que habría que medir. Palabras claves: Calidad educativa. Medición de la calidad. Operacionalización de la calidad. Factores de la calidad. Crítica a pruebas estandarizadas. PSU y SIMCE. ABSTRACT In this article the author analyses the main difficulties of compatibilizing the Concepts of quality and its measurement in education, criticizing the ambiguous practices involved in the main instruments to measure educational quality. He contend that the way quality is measured when using standardized tests applied to Chilean pupils does not inform about quality, neither this problem can be solved in the parliament. The article shows a conceptual incoherence between quality and measurement in education when using Chilean standardized tests such as PSU or SIMCE. More specifically, it shows how standardized results of tests do not measure quality. In addition, he takes the case of teaching and learning of hand writing to shows that quality contents linked to it are inexistent. Then he ask What is considered to be a proper pedagogy to teach hand writing or arithmetic? In sum, the author put forward the operational problem of measuring quality in education and argues that there are plenty of variables explaining quality which is necessary to measure. Key words: Education quality. Quality measurement. tests of quality. Factors explaining quality. Critique of standardized tests. PSU and SIMCE. 35 Revista Electrónica de Desarrollo de Competencias (REDEC) - Nº 3 - Vol. 1 - 2009 - Universidad de Talca De lo abstracto a lo concreto en los debates sobre la calidad educativa Andrés Gacitúa Stemann Pp. 35 a 55 DE LO ABSTRACTO A LO CONCRETO EN LOS DEBATES SOBRE LA CALIDAD EDUCATIVA Andrés Gacitúa Stemann 1 INTRODUCCIÓN En las cinco últimas décadas y quizás más, hemos estado permanentemente innovando nuestros discursos educativos, y a la vez, visto que reiteradamente los volvemos a cambiar, se hace evidente que ninguna de las mejoras realizadas nos dejó satisfechos. Peor aún, podríamos sospechar que, salvo en algunos aspectos bien específicos como cobertura y matrícula, y como financiamientos aportados a la educación por el Estado, las innovaciones han abundado en el nivel de los discursos abstractos pero han escaseado en el de las prácticas concretas. En el ejemplo más básico imaginable, tras varias series de discursos sobre distintas clases de “reformas”, en nuestras escuelas se sigue enseñando a escribir, a leer y a multiplicar, con las mismas metodologías pedagógicas que en la década de 1950. Es decir, la “innovación y la reforma” son mayoritariamente discursos abstractos, porque no logran materializarse en práctica alguna en las aulas. En la década del 60 ocurrieron las grandes reformas universitarias; en el 66 ya había aparecido la Prueba de Aptitud Académica en reemplazo del anterior Bachillerato. En el 67, un año antes del mayo francés, Miguel Ángel Solar se toma la Universidad Católica, es destituido el Rector Pontificio, y el inolvidable “El Mercurio Miente” escandaliza a Chile desde la mismísima Alameda, como declarando que por primera vez los universitarios se querían desligar manifiestamente del poder económico; el 68, un año después que en la Católica, parte la Reforma en la U. de Chile. Al principio de los años 70 se intentó la Escuela Nacional Unificada (ENU) de la Unidad Popular; a fines de los años 70 y en casi todos los 80, Pinochet mantuvo su sistema municipalizado y el “apagón cultural” en las universidades con los “rectores militares delegados”; destacó en ese entonces el Estatuto de 1981 para las universidades, con el que se abrió el boom de la educación superior privada y, culminó sus “aportes” con una Ley Orgánica Constitucional de Educación (LOCE) que dejó amarrado un statu quo inmodificable durante los siguientes 20 años; en la década de los años 90 la Concertación nos brindó la “Comisión Brunner” con esas recetas que obviamente no aportaron nada sólido, y en la primera década del tercer milenio la “revolución de los pingüinos” hace caer la Ley Orgánica Constitucional de Educación (LOCE), y se vuelve a requerir innovaciones sustantivas. La Ley General de Andrés Gacitúa Stemann es Psicólogo y Magíster en Ciencias con mención en Políticas y Planificación de la Comunicación Social. Enseña en las Universidades de Talca y de Valparaíso. Su principal dedicación actual está en la temática de la pedagogía por competencias, la que practica desde hace tres años en el Programa de Formación Fundamental de la Universidad de Talca como docente y como Coordinador del Área de Formación Instrumental hasta Julio de 2008. Desde la década de 1980 es especialista en DISGRAFIA, lo que le ha permitido conocer en profundidad la problemática escolar en materia de manuscritura. En los primeros años de la década del 90 realizó programas de alfabetización funcional en Centros de Rehabilitación Conductual (Graneros) y en Centros de Observación y Diagnóstico (Santiago y Pudahuel). Es profesor universitario desde 1974. 1 36 Andrés Gacitúa Stemann Educación ha sido cuestionada desde antes que el Parlamento la apruebe; es difícil que sobreviva apenas unos pocos años, si es que la Presidenta llega a promulgarla. No es que no haya habido cambios. Los evidentes hasta hoy pueden resumirse en: a) se amplió la cobertura poblacional de los servicios educativos; b) se municipalizó la antigua escuela estatal-fiscal; c) se produjo una enorme expansión de la educación superior comercializada que, en pocos años, multiplicó varias veces la cantidad de universidades existentes en el país, al igual que la matrícula universitaria disponible a escala nacional. Hubo aspectos adicionales tales como que la inversión pública del Estado en educación creció significativamente, no sólo en términos del porcentaje del PIB, sino también en las mejoras sustantivas de los sueldos de sus docentes, y en la forma abundante en que se ha llevado computadores a las aulas. Con todo, estos cambios tienen mucho más que ver con lo económico-administrativo, con infraestructura y equipamiento, que con lo propiamente docente o con la calidad de los aprendizajes que logra el alumnado. Cambio no es sinónimo obligado de mejoramiento en la calidad. Por otra parte, hay un cambio del que rara vez se toma conciencia: el cambio en la velocidad del desarrollo del conocimiento y las tecnologías, la aceleración del ritmo con que cambian los mundos laborales y la urgencia cada vez mayor por reciclar permanentemente los conocimientos y las competencias laborales de cada individuo. Podríamos convenir en que a pesar de que los juzgamos mínimos y de poca relevancia, los cambios educativos existen; el problema es que se desarrollan a un ritmo mucho menor que las demandas que ejercen sobre la educación los avances del mundo tecnológico y laboral. Un ejemplo privilegiado en esta materia es el de la alfabetización: se ha hecho enormes esfuerzos de cobertura para asegurar la alfabetización de todo niño; hay logros en cobertura y leyes que obligan a que los escolares aprueben el 8º Básico, y después el 4º Medio; ¿Gran éxito…? No, porque en el intertanto, los desarrollos informáticos generaron el fenómeno del “analfabetismo digital” que amenaza con ser aún más grave que el literario en términos de marginar de los mercados laborales a quienes incurran en semejante falencia. En una perspectiva distinta, se ha discutido si la educación frontal u otra participativa; si favorecer la transmisión de conocimientos o la adquisición de competencias; si enfatizar la instrucción técnico laboral con miras a garantizar la empleabilidad adulta del educando, o si enfatizar el “ser” y el “convivir” por sobre el mero “tener” capacidades de inserción en el mercado. Se diría que entre Tecnificación y Humanización, prevalece últimamente la primera, aunque se la intenta camuflar bajo una fraseología que pretende semejarse más a la segunda. Cada gobierno de las últimas 4 ó 5 décadas ha ofrecido mejorar la calidad de la educación y ha realizado al respecto unos cuantos maquillajes más o menos intrascendentes. Con todo, nadie fue tan bajo como la dictadura cuando sacó de las universidades a las carreras de pedagogía e inventó el sistema de los “profesores-taxi”, ni tan ineficiente como la Concertación que, multiplicando varias veces los presupuestos educacionales, no logró mejoras sustantivas pese a su declarada intención de hacer una verdadera revolución en la calidad educativa. Los principales lemas de la propaganda política, desde Aylwin a Bachelet, han declarado que se pretende llevar la educación hacia niveles de calidad, hacia valores de justicia y equidad social (este es el discurso humanista) pero los cambios reales se han registrado en otras 37 De lo abstracto a lo concreto en los debates sobre la calidad educativa dimensiones: comercialización y cobertura, especialmente en la educación superior. Como a la carabina de Ambrosio, al país parece que en cuestiones de Educación “le sale el tiro por la culata”: se busca una cosa y se provoca otra. Con todo, es preciso reconocer que la Concertación, a lo largo de sus cuatro gobiernos, logró algo impensado anteriormente. Docenas de especialistas han comentado los datos oficiales respecto a que cerca de un 40% de nuestros jóvenes están llegando a la universidad, en alto grado gracias a una importante disponibilidad de becas y créditos fiscales y también respecto a que de cada 10 universitarios de estos días, 7 provienen de hogares en los que nunca antes había ido otro miembro a la universidad. (Abundan quienes reiteran estas dos ideas en cuanto panel o entrevista televisiva se realiza; las fuentes originales, obviamente, son estadísticas nacionales publicadas por el INE, la PSU, el DEMRE, el CSE, y el Mineduc, especialmente a través de su División de Planificación.) Esta significativa democratización del espacio universitario, siendo un gigantesco logro, muy probablemente es también una de las causas principales de la decadencia en la calidad de la formación universitaria. Parecería que las universidades, “invadidas por una masa media” que antes no llegaba a ellas, ahora no logran manejarse en sus antiguos estándares de pedagogía elitesca, y tampoco tienen las intenciones ni los conocimientos que pudieran permitirles convertirse en algo así como una buena universidad para sectores medios de la población. Surge así la paradoja consistente en que un innegable logro de democratización social de las universidades, pudiera ser también, en esta hipótesis, la peor causa de la pérdida de calidad por la formación universitaria. Ciertamente, sería un absurdo pretender que una buena universidad para las élites, siguiese siendo igualmente buena para los sectores medios, sin que medie un cambio de modelo a lo largo del proceso. Al ampliarse los sujetos sociales, se tiene que cambiar a la institución que los forma. Pero esto no ha ocurrido, al menos no en la medida suficiente. Resulta paradojal que las antiguas élites tuvieran un acceso casi gratuito a la universidad, mientras que las actuales masas de niveles medios deben pagar por acceder a ella fuertes matrículas y aranceles. Visto así, cabría decir que el proceso fundamental no es uno de democratización sino de comercialización; este último se acentúa en la medida en que integra cada vez a mayores sectores de consumidores de la formación universitaria. El consumismo logrado, ha implicado inevitablemente una “chatarrización” de lo que antes fue una cultura universitaria elitesca. Habría infinitas posibilidades de interpretar todo lo ocurrido con la educación chilena. Quizás si lo más realista, a esta altura, sea decir que nunca ha habido una verdadera voluntad política para llevar a cabo las radicales mejoras declaradas en la intencionalidad. Si no fuera así, tendríamos que reconocer una ancestral ineptitud para realizar lo que queremos, o de lo contrario, una severa incapacidad para imaginar lo que más necesitamos. Estas dudas sobre la voluntad política, la incapacidad planificadora y la ineptitud ejecutiva para llevar a cabo los cambios, ponen en jaque al concepto mismo de CALIDAD EDUCATIVA que circula en dicho contexto. Realmente, ¿qué se ha querido decir con semejante expresión durante los últimos años?, ¿qué entendemos hoy por “calidad educativa”?. ¿Por qué fracasaron tantas “mejoras” intentadas? La respuesta no puede provenir de una cúspide política ni de algún intelectual mesiánico; ya está visto que las fraseologías oficiales solo han sabido confundirlo todo cuando opinan sobre una “educación” cuyas concreciones son incapaces de manejar, y por ello, cabe suponer que no las conocen. El hecho de que todos tengamos un cuerpo físico, no nos convierte en expertos en medicina, ni el hecho de que tengamos algunos grados de conciencia nos convierte en psicólogos, ni el vivir en un departamento nos hace expertos en 38 Andrés Gacitúa Stemann arquitectura. Pero los políticos parecen no entender esto, y actúan como si creyeran que por el sólo hecho de “haber pasado” por algunos sistemas educativos, ya son expertos que pueden dictarle leyes al resto de la población en la materia; los resultados están a la vista. Décadas de innovaciones fracasadas, presupuestos malbaratados, y cada vez que nuestros alumnos son sometidos a evaluaciones internacionales del tipo TIMS o PISA, quedamos invariablemente clasificados en los últimos lugares del planeta, pese a que nuestros intentos por ingresar a la globalización requerirían a gritos que nos fuera bien en estas evaluaciones. Asumiendo como introducción y contexto este dilatado proceso de cambios y reformas que no llegan a culminar con éxito, este trabajo discutirá y propondrá criterios para entender lo que hoy pudiéramos llamar “calidad educativa”, revisando algunos “vicios formales” que se evidencian en nuestras mediciones tradicionales y en las maneras de elaborar los resultados de nuestras mediciones más consolidadas, y por otro lado, haciendo ver algunos vacíos que no estamos cubriendo con nuestros conceptos de “calidad educativa” ni en un sentido específico-concreto, ni tampoco en el sentido de la amplísima extensión que dicho concepto tiene, inevitablemente. Así, desarrollaremos cuatro argumentos específicos que tendrán que ver con que: 1. Lo que hemos estado midiendo, no es calidad educativa, es rendimiento estudiantil en pruebas de conocimiento. 2. Los puntajes normalizados y estandarizados ( PAA, SIMCE, PSU,…) no indican calidad educativa; están hechos para facilitar la selección de alumnos por las universidades. 3. La calidad educativa suele usarse como concepto abstracto, que prácticamente nadie sabe hacer aterrizar en las más elementales concreciones pedagógicas: veremos el caso de la manuscritura, como una concreción que denuncia el vicio abstracto. 4. La calidad de la educación tampoco es la “calidad del docente”: el problema de la extensión mínima del concepto no ha sido asumido. 1. Lo que hemos estado midiendo. Cuando un concepto –calidad educativa- se usa en forma ambigua y confusa y todos los análisis se vuelven inútiles porque no nos conducen a parte alguna, se puede intentar un análisis por la vía de aproximaciones “operacionales” al asunto de fondo. En este caso, podríamos no atender al escurridizo concepto de calidad educativa, sino a lo que hemos hecho con el sistema de educación chileno; o podríamos preguntarnos qué medimos cuando decimos que estamos midiendo “calidad educativa”. Es decir, pongamos las sospechas sobre una conceptualización que pudiera haber caído en discursos equivocados, y reflexionemos apoyados en nuestras demás prácticas, que si bien pueden no haber sido satisfactorias, tienen al menos la ventaja de corresponder a la realidad, tal como la hemos venido operando en los hechos. Desde la PAA y la PSU, a la “importación” de la TIMS, y la PISA, y sin excluir al SIMCE, el esfuerzo absolutamente mayoritario en Chile ha estado orientado a medir “conocimientos estudiantiles”, por lo general, en términos de rendimiento en pruebas de lápiz y papel, y esto, con el propósito de facilitar la discriminación selectiva de alumnos, ya sea por las universidades o por otras instancias. La PAA tuvo y la PSU (Prueba de Selección Universitaria) tiene el propósito específico y declarado de servir para la selección de los alumnos por las 39 De lo abstracto a lo concreto en los debates sobre la calidad educativa universidades. El SIMCE (sistema de medición de la calidad de la educación) en cambio, reclama desde su propio nombre que mide “calidad de la educación”, pero no lo hace, porque en realidad mide el “rendimiento” del alumno en pruebas de conocimientos. La retórica es fácil y siempre se podrá sostener que el rendimiento del alumno en materia de conocimientos es algo “muy próximo” a la calidad de la educación. Una buena educación sería aquella que es capaz de producir buenos rendimientos en conocimientos medidos en pruebas masivas de lápiz y papel, etc. La demagogia puede seguir interminablemente. El punto es que si estamos dispuestos a trabajar con esta enorme laxitud de conceptos, no hay para qué hablar de “calidad de la educación”; bien podríamos seguir hablando de “aptitudes académicas” como hizo durante 37 años la PAA, o de “tener los conocimientos mínimos para aprobar”, como piensa probablemente la mayor parte de los docentes cada vez que otorgan una calificación superior a 3,9. Cuando hablamos de “calidad de la educación” pero medimos “rendimiento en pruebas de conocimientos” –como hace el SIMCE-, tenemos que hacernos cargo de lo muy diferentes que son estos dos conceptos, y de que no es posible hacer sinónimos a uno del otro. El rendimiento en conocimientos que exhibe el alumno, puede provenir de fuentes distintas al sistema educativo, como lo son el nivel de conocimientos que existe entre los adultos con quienes vive el escolar, la disponibilidad de libros y otros recursos de acceso a información de buen nivel (revistas serias) que pueda tener el escolar en su hogar, o como puede serlo su posesión de computadores de calidad permanentemente conectados a Internet. A la inversa, el rendimiento del alumno en pruebas de conocimiento puede asociarse a algunas variables de la calidad de la educación, como “años de experiencia profesional de sus docentes”, o como “años de experiencia de todo el personal del establecimiento”, pero sabemos que el anquilosamiento existe, y que liceos “a la antigua” con docentes “ancianos” pueden ser también una combinación desfavorable que afecte negativamente al rendimiento en conocimientos del alumno en una prueba del tipo SIMCE. Poco importa que una Escuela tenga escasos ejemplares de libros en su biblioteca, si éstos son abundantes en el hogar del alumno. Poco importa que el docente del alumno no sepa nada de computación e informática, si el padre del alumno es un ingeniero y tiene tres computadores en la casa. Es decir, el rendimiento del alumno puede beneficiarse de oportunidades y factores distintos a los del sistema educacional (los que aportan el hogar e Internet, en especial), lo que permite decir categóricamente que un “buen rendimiento” del escolar no equivale directamente a “buena calidad educativa” de su establecimiento. Los factores que determinan a ambos pertenecen a distintos conjuntos que solo comparten unos pocos de los factores relevantes. Podemos hacer dos propuestas en torno a nuestras mediciones del rendimiento-calidad educativa, que parecen dignas de considerar, ya que mejorarían nuestras posibilidades de evaluar con precisión la calidad educativa que exhiben las sucesivas cohortes de alumnos. Transparentar la dificultad de las pruebas. En primer término, proponemos que se publique toda la información “bruta” disponible sobre cada una de las pruebas PAA, PSU, SIMCE, y si no hay problemas internacionales, también sobre las PISA Y TIMS. Esto apuntaría a conocer con precisión la dificultad propia de cada prueba en cada año. De poco nos sirve tener “promedios forzados” = 250, o 500, (como es el caso actual) en las grandes evaluaciones nacionales, si ignoramos la dificultad propia de cada prueba a causa de las estandarizaciones que nos dejan, aparentemente, ante una eterna estabilidad de los instrumentos que marcarán obedientemente, el promedio inducido de los 500 o de los 250 puntos. Exactamente lo mismo 40 Andrés Gacitúa Stemann puede argumentarse en torno al puntaje final. Más que una cantidad global como producto de la prueba-PSU, importaría saber, pregunta a pregunta, en qué le va bien a quiénes, y en qué le va mal a quiénes. Habrá resistencias a esto. Se dirá que los bancos de ítemes deben ser secretos; se dirá que publicarlos pone en jaque a la evaluación misma…(de estos argumentos sobre la necesidad del secreto del ítem, surge la posibilidad de sospechar si lo que en verdad miden estas pruebas no será algo así como la capacidad del alumno para enfrentarse a un ítem sorpresa, más que para evidenciar un nivel de conocimientos o de competencias básicas y consolidadas). Los grandes cambios son lentos. A los efectos de ganar tiempo, se podría elaborar una prueba especial, para que la respondiera solo una muestra de quienes rinden la SIMCE o la PSU, y mantenerla inmodificada en el tiempo; de ese modo, podríamos comparar a las distintas cohortes que la rindan en sus rendimientos ante un mismo instrumento. Aún en las limitaciones de una evaluación de rendimiento cognitivo con lápiz y papel, se ganaría bastante con la comparación de distintas cohortes. Esta publicación amplia de datos debería incluir a los puntajes BRUTOS obtenidos por los alumnos, para poder eliminar de los análisis el factor de “distorsión” que introduce en los puntajes brutos la “normalización-estandarización”. Ítemes de dificultad “objetiva” como segunda propuesta. En el contexto de este trabajo, puede sonar extraña esta expresión sobre una “dificultad objetiva”. Sin embargo, tal cosa existe en algunos casos y se la podría usar cada vez que fuera posible. Si se analiza la tarea del “salto alto”, y se conviene en subir la vara un centímetro a la vez, se puede decir que cada centímetro subido es un grado más de dificultad objetiva de la tarea. No se trata de “intervalos iguales” porque si bien siempre se sube un centímetro, el alza de 210 a 211 centímetros seguramente se entenderá como de más dificultad agregada que cuando se sube de 140 a 141 centímetros. Si se trata de medir habilidad o competencias de cálculo básico en multiplicaciones, divisiones y porcentajes, se puede elaborar instrumentos con grandes cantidades de ítemes (100 multiplicaciones de 3 x 3 dígitos, aleatorizando los tres dígitos en todos los ítemes), y aunque nominalmente no sepamos cómo definir cualitativamente el grado de dificultad inherente a hacer 50 de estas multiplicaciones en 20 minutos, … sí es razonable decir que cada sucesiva multiplicación realizada agrega un grado más en la dificultad “objetiva” del desempeño que cada quien pueda alcanzar en esta medición. Si se trata de medir vocabulario u ortografía, se puede cuantificarlos con cierta facilidad. No pretendo que esta cuantificación de las dificultades propias de un cierto desempeño sea siempre posible ni deseable; pero sí sostengo que existen muchos casos en los que se puede hacer evaluaciones de esta índole, las que permitirían comparar a distintas cohortes aún cambiando los ítemes. (Insisto en que es preferible no cambiar los ítemes para ofrecer garantías plenas de que se mide a las distintas cohortes con un mismo instrumento, y por ende, con idéntico nivel de dificultad. Pero en ejemplos similares al del “salto alto” simplemente no se puede cambiar ítemes, (un centímetro solo podríamos cambiarlo por otro centímetro), y en ejemplos como el de las “cien multiplicaciones de 3 x 3 dígitos aleatorizados” daría lo mismo cualquier conjunto de cien multiplicaciones a responder: mantener los mismos ítemes se volvería irrelevante). La propuesta consiste en que, en todos aquellos casos en los que las capacidades y aprendizajes del alumno puedan ser medidos con ítemes de dificultad “objetiva”, se practique y se informe públicamente los resultados de tales evaluaciones; son formas evaluativas que nos permitirán hablar de “calidad educativa” sabiendo a qué nos referimos en cada caso, sin caer en el vicio de la entelequia formal, hoy tan apabulladora y dominante. 41 De lo abstracto a lo concreto en los debates sobre la calidad educativa 2. Los puntajes normalizados y estandarizados. Otra cuestión elemental en esto de la “calidad de la educación”, pero que muy pocas personas conocen, es la forma en que se llega a los puntajes finales del SIMCE y de la PSU. Entender esto es importante, ya que es usual que se fundamente aseveraciones sobre la calidad educativa de los establecimientos, invocando los promedios obtenidos en los puntajes PSU o SIMCE. Los enredosos procedimientos que se aplica a los puntajes de las grandes pruebas, tienen el triste mérito de poner a la mayor parte de la gente en situación de NO SABER qué es un puntaje de 500 en la PSU, en términos de calidad educativa. No voy a hacer aquí una descripción rigurosa de las metodologías que, a manera de procedimientos intermedios, transforman los resultados brutos iniciales, los procesan y finalmente llegan a esos resultados mágicos de la PAA y el SIMCE (la PSU va por el mismo camino). Intentaré sugerir el sentido básico de estos manejos sin entrar en complejidades estadísticas. La PAA tuvo durante casi cuatro décadas un promedio de 500 puntos y una desviación estándar de 100 puntos. El SIMCE ha tenido también por décadas, un puntaje promedio de 250 puntos y 50 puntos de desviación estándar; es decir, es el mismo sistema para PAA y SIMCE, sólo que con una escala “dividida por dos en sus valores específicos”. La magia surge como hipótesis, porque hay dos factores que nos garantizan que es imposible que esos puntajes medios se mantengan tan rigurosamente estables a lo largo de los años. El primer factor, consiste en que las cohortes educativas cambian con el tiempo: la PAA de 1966 fue rendida por una cohorte de alumnos que, en muchos aspectos, era harto distinta de la cohorte que rindió la última edición de esta prueba. En el intermedio de casi cuarenta años, obviamente hubo cohortes que mejoraban en lenguaje, otras que mejoraban en matemáticas, otras cuyo rendimiento caía en las dos pruebas principales. Si tuviéramos que apostar, diríamos que es absolutamente improbable que dos cohortes se igualaran perfectamente en sus rendimientos brutos ante estas pruebas; de donde resulta absurdamente inverosímil la reiteración sistemática del promedio de 500 puntos. Una contundente demostración de lo que este primer factor implica apareció publicada en LA TERCERA el 23 de Diciembre de 2008, páginas 1, 35, 36 y 37. Un anónimo analista de La Tercera tomó datos oficiales de las 5 pruebas PSU y logró sintetizar algunas cuestiones importantes: a) Los establecimientos privados promediaron 605 puntos en la PSU 2009 mientras los municipalizados solo promediaron 451,5. Estos 148,5 puntos más de los privados constituyen un importante incremento respecto de la ventaja que tuvieron en 2005, que solo fue de 118 puntos. Esta diferencia es comprensible en virtud de que “La composición de los estudiantes que rinden la prueba ha cambiado fuertemente. Por eso es fundamental controlar por los aspectos socioeconómicos” (Con comillas, La Tercera cita a David Bravo, del Centro de Microdatos de la U. de Chile). b) En el 2004 los estudiantes de escasos recursos que rindieron la prueba fueron 65 mil; en el 2009 son 98 mil. “…este mayor número de estudiantes de menores recursos y peor preparados arrastra a la baja el promedio de los municipales, sin que ello signifique que los liceos públicos sean de peor calidad que hace cinco años”. (Comillas: análisis de La Tercera). 42 Andrés Gacitúa Stemann c) “Por otro lado, el aumento en la ventaja de los estudiantes de colegios particulares se explicaría porque éstos concentran cada vez más a un alumnado de mayores ingresos. Según estadísticas de la UDP en estos cinco años el 20% de los colegios pagados se transformó en subvencionados.” (Cita al análisis de La Tercera) Y se trata de colegios de sectores de ingresos medios que buscan el complemento financiero del aporte estatal, porque les cuesta subsistir sólo con sus propios recursos. Tenemos así que, en apenas cinco años, se ha producido un mayúsculo cambio en la composición socioeconómica de quienes rinden la PSU llegando a ella desde colegios particulares o desde municipalizados: mientras los colegios particulares reducen su alumnado y se concentran cada vez más en los sectores de más altos ingresos, los establecimientos municipalizados hacen todo lo contrario: aumentan su matrícula ingresando a miles de nuevos alumnos de sectores de escasos recursos. Si esta clase de modificaciones pueden ser registradas en apenas cinco años, imagínese de qué calibres podrían ser los cambios si se los analizara desde la primera PAA en 1966. El segundo factor, está dado por los ítemes que integraron las respectivas pruebas a lo largo de las décadas. Como es obvio suponer y como de hecho consta en los facsímiles respectivos, los ítemes, preguntas o problemas de la PAA, cambiaban todos los años. Se repetían, solo muy de tarde en tarde algunas preguntas de lenguaje y algunos problemas de matemáticas: de un año al siguiente, quizás nunca hubo más de un 5% de ítemes repetidos. Tenemos así pruebas integradas por distintos conjuntos de ítemes, y aunque se las intentaba hacer de dificultades comparables, y aunque se extremaban las astucias para medir y clasificar la dificultad intrínseca de cada ítem, lo concreto es que eran ítemes diferentes con una dificultad diferente, por pequeñas que estas diferencias fuesen. ¿Empezamos a entender la magia? Durante los casi 40 años en que se aplicó la PAA, cohortes diferentes entre sí, rindieron pruebas con ítemes diferentes unas de otras,… pero todas ellas tuvieron en definitiva un promedio de 500 puntos con una desviación estándar de 100 puntos. Para facilitar una mejor comprensión de lo anterior, ofreceré analogías simplificadoras de lo que se hace para construir los puntajes de PAA, PSU, SIMCE. A) En primer lugar, hecha la corrección de las respuestas en cada prueba, se tiene un puntaje BRUTO de cada alumno. En muchas PAA –no sé si todas fueron iguales en esto- eran 60 ítemes o problemas en Matemáticas y 90 preguntas o ítemes en Lenguaje. Eran pruebas lo suficientemente difíciles como para que nadie pudiera responder todas las preguntas-problemas en los minutos usualmente concedidos. Digamos que lo habitual pudo ser que, en promedios hipotéticos, los alumnos respondieran unas 40 preguntas de lenguaje y resolvieran unos 25 problemas en matemáticas. En cada edición de cada prueba, había unos pocos alumnos que alcanzaban “puntajes máximos” o “puntajes nacionales”: esas personas eran quienes habían respondido, por ejemplo, 50 problemas correctamente, y habían tenido solo dos respuestas incorrectas en la prueba de matemáticas. Por lo general, en las respuestas malas se descontaba el 20 o el 25% del valor de la respuesta buena; a causa de ello, aparecían los decimales y nuestros puntajes nacionales en matemáticas habrían tenido 49,6 puntos brutos. Por su parte, los puntajes máximos o “nacionales” en Lenguaje, pertenecían a aquellas personas que, de los 90 ítemes, tenían 82 respuestas correctas con solo 5 incorrectas (suman 87) y habían dejado tres ítemes sin responder. O sea, su puntaje bruto era de (82 - (0.2x5))= 81 puntos brutos. 43 De lo abstracto a lo concreto en los debates sobre la calidad educativa Estos eran los mejores puntajes nacionales: 49,6 en matemáticas y 81 en lenguaje. B) Lo anterior nos deja ante un mínimo de tres escalas diferentes de puntajes. La de Lenguaje es distinta a la de Matemáticas, porque la primera opera con 90 puntos brutos como máximo posible, mientras la última lo hace con 60 puntos brutos como máximo posible. Se vuelven a diferenciar porque sus puntajes brutos máximos reales en un hipotético año, son 49,6 y 81. Es decir, los resultados variaron, tuvieron dispersiones y rangos diferentes. Y estas dos escalas son obviamente distintas a la “oficial” que aparecía en la prensa. En esta última escala (200 a 800 puntos), los 800 puntos y algo más, era la zona privilegiada de la distribución donde quedaban tanto los 49,6 como los 81 puntos brutos. Tener 500 puntos en esta tercera escala, no era tan malo, pero definitivamente, 500 puntos no permitían ingresar a las mejores carreras; y los 350 puntos… obligaban a su titular a rendir de nuevo la prueba, porque con 350 puntos no entraba a nada. Para llegar desde los 49,6 puntos brutos en matemáticas a un puntaje final-oficial en la prensa que hipotéticamente pudo ser de 814 puntos, había que hacer dos procesos estadísticos de normalización-estandarización. C) Hay que ordenar los puntajes brutos de mejor a peor y, esa distribución de puntajes que resulta, hay que “comprimirla”, “expandirla”,…ajustarla y reajustarla, hasta que se parezca lo más posible a una curva normal. La ventaja de “normalizar” las distribuciones de los puntajes brutos de la PAA radica en que, para la distribución normal, se conoce la forma en que se comportan los promedios y las desviaciones estándar, y en que se ha desarrollado con ellas los llamados “puntajes Z” o puntajes estandarizados. La escala de puntajes Z tiene valores que van, aproximadamente, desde -3 hasta +3 unidades de desviación estándar respecto del promedio. Ciertamente, puede haber “genios” que saquen importantes ventajas al restante 99% y así es como se producen esos “puntajes nacionales” de 850 puntos que se han registrado en la edición de la prueba con que se ingresará a la universidad en marzo de 2009. Esta viene siendo la cuarta escala que hasta aquí no estaba mencionada, y que es la más “rica” en potencialidades y, por lo mismo, la más interesante de todas. Para cada valor “z” se conoce el “percentil” que le corresponde (y los percentiles podrían ser la quinta escala…). En los puntajes de estas escalas “z” y en sus equivalentes percentiles, se basa la conversión y la expresión de cualquier distribución de puntajes brutos en términos de una escala normalizada que, en el caso de la PAA se eligió que fuera de promedio 500 y desviación estándar de 100. Esta es la “magia”. No es que las distintas cohortes, al responder distintos grupos de preguntas y problemas, mágicamente, se saquen siempre 500 puntos de promedio. Lo que ocurre es que el conjunto de los procesos de conversión de escalas que llevan desde los puntajes brutos iniciales a los puntajes Z, y desde éstos a los percentiles y a la escala 200-800 de la PAA, están hechos para que siempre ocurra eso, y en el caso del SIMCE, para que siempre resulte un promedio de 250 y una D.S. de 50. Mientras se redactaba este texto, apareció en los noticieros televisivos un comentario a una publicación en PUBLIMETRO (periódico del metro de Santiago) según la cual, algunos rectores universitarios, incluido el ex Rector Riveros de la U de Chile, destacaban como lamentable el hecho de que, si se convirtieran a notas los puntajes PSU, el promedio sería de 3,9. Aparentemente, están en un error: si se normaliza hasta la perfección la distribución de los puntajes PSU, el promedio final tiene que ser 500, y esto tiene que ser equivalente a 4,0: entre 3,9 y 4,0, el error de cifras es mínimo y, probablemente se debe a aproximaciones de centésimas y decimales, o a que los ajustes normalizadores no fueron forzados hasta la 44 Andrés Gacitúa Stemann perfección misma. Lo insólito es que un grupo de Rectores se escandalice ante esto: su alarma indica que no conocen a cabalidad el sistema de equivalencias y transformaciones de los puntajes en cuestión. Resumen grueso de las equivalencias de escalas, incluyendo Puntajes Finales SIMCE Y PSU PUNTAJE BRUTO MATEMÁTICAS (variable) Instrumento tiene 60 ítemes en total. PUNTAJE BRUTO LENGUAJE (variable) Instrumento completo tiene 90 ítemes. Escala “Z” Escala oficial de Notas en Chile * Escala 100400 del SIMCE. Escala 200-800 de PAA y PSU. Ptje máximo real= 48 problemas resueltos Ptje máximo real= 70 ítemes bien respondidos. +3 7 400 800 +2 6 350 700 +1 5 300 600 0= PROMEDIO 4 250 500 -1 3 200 400 -2 2 150 300 -3 1 100 200 36 puntos brutos. (ficticio) Ptje Mínimo real= 0 problemas resueltos 57 puntos brutos. (ficticio) Ptje Mínimo real= 8 ítemes bien respondidos. * Dado que con menos de 4,0 se reprueba y repite, no existen los egresados de educación media con calificaciones 3, 2 y 1. Sin embargo, en un sentido conceptual, el 3,0 es aproximadamente equivalente a 400 puntos PSU. Una consecuencia de todo lo anterior, es que cuando se compara los puntajes SIMCE de un mismo establecimiento educacional entre los años 2006 (promedio 245 puntos) y 2007 (promedio 240 puntos), no es correcto decir que el colegio “bajó” su rendimiento en cinco puntos. Es incluso posible que ese establecimiento haya tenido en 2007 mejores puntajes brutos que en 2006 (o sea, mejoró en esta perspectiva), y también es posible que esos mejores puntajes brutos los haya obtenido respondiendo bien ante problemas e ítemes algo más difíciles que los de la prueba 2006; es decir, nuevamente, pudiéramos tener que afirmar que el establecimiento ha “mejorado” en 2007 desde las dos perspectivas planteadas. Así, el hecho de que en 2007 aparezca con cinco puntos menos que en 2006, es algo que obedece directamente a los procedimientos de ajustes de distribuciones con fines de normalizaciónestandarización, y no a la “calidad” de los exámenes rendidos por las dos cohortes en cuestión. ¿Qué sentido tiene introducir todos estos procedimientos estadísticos que terminan alterando 45 De lo abstracto a lo concreto en los debates sobre la calidad educativa el verdadero valor de las respuestas de los estudiantes?. El sentido es uno sólo y muy claro: se trata de tener un sistema final de puntajes, que permita a las universidades discriminar óptimamente entre un alumno y otro al momento de seleccionarlos entre los postulantes. El sistema PAA, al igual que el PSU y el SIMCE, no están diseñados para facilitar la comparación de un mismo establecimiento a lo largo de los años, y por eso, las manipulaciones a que se somete los puntajes brutos no cuidan este aspecto al elaborar los puntajes finales. Es decir, estas pruebas garantizan la mejor discriminación posible entre alumnos de una misma cohorte, al costo de empobrecer y hasta de introducir leves tergiversaciones (son en verdad pequeñas) en análisis distintos al de la comparación intra-cohorte de alumnos. Este largo rodeo en torno la normalización-estandarización de puntajes, viene en apoyo de nuestro argumento central sobre el concepto de “calidad educativa”: la medición SIMCE pese a llamarse SISTEMA DE MEDICION DE LA CALIDAD EDUCATIVA, no mide a ésta propiamente tal, y la prueba es que con márgenes pequeños, puede manipular los puntajes de las verdaderas calidades hasta tergiversarlos. En los puntajes de un establecimiento: 2006= 245 y 2007= 240, es posible que tras los 240 puntos, haya respuestas y soluciones de problemas de mejor calidad que aquellas que obtuvieron 245 puntos. Obviamente, tras este comentario subsiste el problema de que el SIMCE en realidad mide rendimiento-conocimientos estudiantiles, y no mide calidad educativa del establecimiento. Me permitiré una especulación y una propuesta a partir de este último punto. La especulación se relaciona con los cambios en las “aptitudes” de las cohortes desde 1966 a 2009. Aunque ya vimos esos cambios socioeconómicos registrados en las cohortes que han rendido la PSU, no hay datos duros para avalar este tipo de fenómenos en sus verdaderas dimensiones a lo largo de los 42 años que empezaron con la primera PAA , y que llegan hasta hoy. Con apoyos sólo secundarios y tangenciales, muchos expertos han sugerido que en los últimos 40 años se ha producido un importante deterioro en el lenguaje de los jóvenes. Presuntamente a causa de la TV, de la menor lectura y del “chateo”, se habría empobrecido el vocabulario y se habrían deteriorado los usos de la ortografía y la gramática. Como contrapartida, y a causa de la TV y de Internet, la juventud habría mejorado su comprensión de los lenguajes icónicos-visuales. A mitad de camino quedarían los lenguajes de las matemáticas; me atrevo a suponer que éstos han mejorado desde 1966, quizás no tanto como los visuales, pero gracias a Internet –que distribuye para miles de alumnos facsímiles similares a los de las pruebas oficiales, y a la obsesión por “preparar la prueba” en academias y preuniversitarios, yo asumiría que quienes rinden la PSU hoy llegan bastante mejor en matemáticas que sus antecesores de la PAA en 1966. Por jugarme una hipótesis plausible, yo diría que si en Lenguaje los alumnos de hoy pueden estar unos 100 puntos PSU por debajo de los de 1966. A la inversa, creo posible que en Matemáticas estén unos 100 puntos PSU por encima de los de 1966. Cuando fijo en “cien puntos más” y en “cien puntos menos” las diferencias, estoy siendo absolutamente arbitrario : las cosas pudieran haber empeorado mucho más, o quizás pudieran haber mejorado mucho más, y no tenemos cómo saberlo. Mis anteriores hipótesis serían un delirio… si no hubiera como contrastarlas; pero hay una forma bastante razonable para hacerlo: se puede hacer una “muestra” de mil sujetos que hayan obtenido 500 puntos (digamos, entre 490 y 510…) en la PSU 2009 de Lenguaje, y otros mil sujetos con 500 puntos (490 a 510) en la PSU de Matemáticas. A estos grupos se les pagaría una modesta suma para que respondan la misma prueba PAA que rindieron quienes 46 Andrés Gacitúa Stemann ingresaron a la universidad en 1966. Podrían darse varias alternativas; menciono las de mayor interés: a) Si quienes rinden Lenguaje sacaran cerca de 400 puntos y quienes rinden Matemáticas se acercaran a los 600 puntos en promedio, mis hipótesis quedarían básicamente probadas. b) Si ambos grupos se sacaran cerca de 500 puntos en promedio, se demostraría dos cosas importantes: (i) mis hipótesis serían erróneas, y (ii) nada sustantivo habría cambiado desde 1966, en el sentido de que los alumnos obtendrían cerca de 500 puntos de cualquier forma, con cualquiera de las pruebas. c) Tengo una hipótesis mejor que las anteriores. Creo que de hacerse lo propuesto, es posible que quienes rinden Lenguaje obtengan cerca de 600 puntos, y quienes rinden Matemáticas obtengan cerca de 700 puntos. En este caso, yo tendría razón en la ventaja de matemáticas sobre lenguaje, pero quedaría refutada la idea del “empobrecimiento” del lenguaje. Al Ministerio de Educación le encantaría demostrar que hoy, los alumnos egresan de 4º Medio sabiendo bastante más que en 1966,… por lo que podemos ilusionarnos con que se interese en llevar a cabo esta propuesta. Por supuesto, si hace el estudio propuesto corre el riesgo de demostrar lo contrario: … que hoy los alumnos salen de 4º Medio sabiendo MENOS que en 1966. d) Obviamente, toda esta propuesta tiene sentido, únicamente si se comparan datos del 2009 contra datos normalizados con el mismo sistema que se usó en 1966. Es decir, suponiendo un caso de una persona del 2009 que obtiene 40 puntos brutos en matemáticas rindiendo la PAA 1966, habría que rastrear a aquellas personas que en 1966 obtuvieron los mismos 40 puntos brutos, y ver qué puntaje se les asignó producto de la normalización-estandarización. Si se aplicara ajustes, normalizaciones y estandarizaciones, cuantos más sean estos procedimientos, más probable se vuelve que todo el mundo termine teniendo los 500 puntos obligados desde siempre por el sistema de normalización. Existe todavía una forma más para ilustrar cómo se manipula los puntajes en estas grandes pruebas nacionales. Se trata de comparar la dispersión de los puntajes brutos versus la distribución de los puntajes finales. Si lo que hemos venido sosteniendo es cierto, TENDRIA QUE OCURRIR lo siguiente: algunas personas que tienen iguales puntajes brutos, terminarían teniendo distintos puntajes finales; de no ser así, no habría existido efecto alguno de “normalización” de la distribución bruta en cuestión. Pongo un ejemplo extremadamente simplificado, pero que espero ilustre claramente el asunto. Supongamos que un cierto colegio, en virtud de “pitutos” de alto nivel, logra obtener los datos relativos a qué puntajes brutos obtuvo cada uno de sus 20 alumnos que rindieron la PSU de matemáticas en 2009, y se encuentra con lo siguiente: 47 De lo abstracto a lo concreto en los debates sobre la calidad educativa Tabla Nº 1: Datos ficticios para ilustrar la dispersión de puntajes que opera la PSU. Alumno Nº Puntaje final normalizado 1 Puntaje Bruto Ítemes con respuestas correctas 25 2 23 640 3 22 22 619 21 21 21 592 4 5 6 690 618 591 7 590 8 20 570 9 18 18 18 18 548 10 11 547 546 12 545 13 15 518 14 14 14 505 16 13 480 17 12 12 12 465 15 18 503 464 19 20 463 10 448 Observando la columna central con la “cantidad de respuestas buenas” o “cantidad de problemas bien resueltos”, tenemos que los 20 alumnos se distribuyen en 11 CATEGORIAS diferentes de puntajes brutos, las que corresponden unívocamente a los problemas matemáticos bien resueltos en sus pruebas. Si no hubiera “normalización” de estos puntajes, estos 20 alumnos tendrían 48 Andrés Gacitúa Stemann que tener solo 11 puntajes finales PSU, pero no es así: terminan teniendo 20 DIFERENTES puntajes PSU. El paso desde las 11 categorías de respuestas buenas a 20 puntajes finales diferentes, solo puede conseguirse operando una distribución más diferenciadora: allí donde en principio hay 4 alumnos con un mismo puntaje bruto de 18 respuestas correctas, termina habiendo 4 distintos puntajes finales. Similar cosa ocurre en otros “empates” en cantidad de respuestas buenas. La pregunta obvia es a quiénes se favorece y a quiénes se perjudica. No conozco los detalles, pero imagino que se trata de un proceso aleatorio: sería una injusticia flagrante si operaran criterios intencionados. La aleatoriedad no es justa; es simplemente injusticia aleatoria. La ilustración anterior apenas es una caricatura: 20 individuos en 11 categorías de puntajes, no están ni cerca de dimensionar lo que realmente ocurre. En circunstancias reales, cerca de 200 mil jóvenes rinden una prueba de Matemáticas que tiene 60 ítemes o problemas. Desde quienes responden “cero respuesta correcta”, a quienes obtienen “puntajes nacionales” de 50 respuestas correctas, tenemos un total de 51 categorías diferentes de PUNTAJES BRUTOS (prescindo aquí de los descuentos por respuestas malas). Los 200 mil jóvenes que en principio quedan distribuidos en estas 51 categorías tendrán que ser reclasificados, estandarizados y normalizados, hasta distribuirlos dispersándolos en unas 700 categorías de puntajes oficiales finales: las que van desde un puntaje final de 150 puntos como “mínimo nacional” hasta un puntaje final “máximo nacional” del orden de los 850 puntos. Para pasar de las 51 categorías iniciales a 700 finales, es inevitable cometer esa “injusticia” de asignar distintos puntajes finales a personas que tienen las mismas respuestas correctas como puntajes brutos. Con todo lo que pueda molestar este asunto, no se crea que el problema ha logrado quedar resuelto. Si ordenamos a 200 mil jóvenes en 700 categorías diferentes, nos quedarían unos 286 jóvenes en cada uno de los puntajes finales. Esto no es realmente así, ya que, cuanto más nos alejemos del promedio, habrá menos sujetos por categoría, y cuanto más cerca estemos del promedio, la cantidad puede multiplicar varias veces a esos 286 jóvenes del cálculo inicial. ¿Cuántas personas se sacaron exactamente 500 puntos en Matemáticas en la PSU con que postularán a las universidades en el 2009? No dispongo del dato exacto pero no me extrañaría si fueran más de tres mil personas. Y de estas 3000 personas: ¿cuántas postularán a una misma carrera? A pesar de los severos procedimientos usados para discriminar selectivamente a los sujetos, subsiste el problema de que hay muchos sujetos a quienes “no hay cómo discriminarlos por sus puntajes” en los procesos de selección universitaria; en estos casos operan el orden de inscripción, el haber inscrito esa carrera como la única, y finalmente, hasta el orden alfabético de los apellidos y el azar, o el estar presente y despierto en el momento en que “corre la lista” de los llamados en cada carrera. Todos los años hay miles de jóvenes que no lograron entrar a carreras a las que ingresaron otros postulantes que tenían la misma cantidad que ellos de “respuestas buenas” en las distintas pruebas de la PSU. El problema anterior no tiene remedio: si exigiéramos una PSU con mejor capacidad discriminativa, pondríamos en esta instancia la mayor cuota de “injusticias”; y si no hacemos tal exigencia, las injusticias se trasladan al proceso de selección de alumnos por cada escuela universitaria. La solución de justicia perfecta es imposible, porque para lograrla tendríamos que diseñar pruebas que tuvieran unas 500 mil categorías de puntajes diferentes… : sería la única forma en que 200 mil alumnos queden perfectamente distribuidos de modo que no se repitan demasiado en determinadas categorías. Aún así, en las categorías centrales próximas a los 500 puntos la acumulación de varios sujetos en una misma categoría sería inevitable. 49 De lo abstracto a lo concreto en los debates sobre la calidad educativa Cabe imaginar como solución más radical, la de sustituir el proceso de “pruebas” de selección por otro en el cual, TODO el que quiera ingrese a la carrera deseada, para hacer un primer trimestre de nivelación: si a estas nivelaciones ingresan 200 alumnos por carrera, está claro que al segundo trimestre pasarían solo los 80 mejores, esta vez, medidos y seleccionados por sus rendimientos en notas en la carrera elegida. Cada carrera tendría que esmerarse en generar los sistemas más justos posibles, no sólo para no perjudicar innecesariamente a muchos alumnos, sino también para asegurarse de que se queda realmente con los mejores alumnos para seguir formándolos a lo largo de toda la malla curricular. Por desgracia, cabe sospechar que las Escuelas seleccionarían a los individuos de mejores sectores socioeconómicos, buscando quedarse con aquellos alumnos que no les fallarán en el pago de aranceles. La PSU tiene OTROS defectos, pero al menos no sesga su asignación de puntajes con un criterio que favorezca a los “buenos pagadores”. 3. Calidad de la Educación: aterrizaje de lo abstracto en lo concreto. Todo el mundo pareciera saber lo que es la calidad de la educación en abstracto; pero si se les pregunta por los niveles concretos, es decir, ¿qué es calidad de la educación en manuscritura?, ¿qué es calidad de la educación en geometría?, ¿…en química?,… se quedan sorprendidos de no tener nada que decir al respecto. Prácticamente todo puede ser medido y evaluado, y con esto me refiero a que las metodologías cuantitativas y psicométricas, por así llamarlas, pueden hacer maravillas “midiendo” calidad de la educación, y de similar manera, las metodologías cualitativas también han desarrollado criterios y procedimientos sistemáticos que les permiten evaluar con gran rigor fenómenos cualitativos difícilmente cuantificables. Pero el punto que quiero desarrollar en esta parte final de este trabajo, no se inscribe en las diferencias entre las metodologías cuantitativas y cualitativas, sino más bien en la naturaleza y la extensión del concepto de calidad de la educación, cuando no lo usamos como una entelequia abstracta, sino cuando lo referimos a “objetos”, asuntos o sectores concretos específicos. Planteo el problema: ¿ CUÁL ES UNA BUENA EDUCACIÓN Y CUÁL UNA MALA, SI SE TRATA DE EDUCAR LA MANUSCRITURA del alumno en el Primer Ciclo Básico? La pregunta debe entenderse como dirigida a dos cuestiones claramente diferentes; la primera es relativa al contenido o a la naturaleza de la competencia enseñada, la manuscritura; podríamos reformular la pregunta diciendo ¿cuál es esa “buena manuscritura” que debemos enseñar, y cuáles son las “malas manuscrituras” que debemos erradicar de las aulas? Y la segunda cuestión es la de índole didáctica o de metodología de la enseñanza: ¿QUÉ DIDÁCTICA ES BUENA Y CUÁL ES MALA para enseñar esa buena manuscritura definida antes? Un docente puede ser amable y cálido, nada autoritario y acogedor de la participación, etc., pero ni el más nutrido conjunto de estos buenos atributos pedagógicos genéricos le va a permitir hacer buena docencia si no sabe LO QUE tiene que enseñar. Para el docente, es obligado tener dominios tanto de los contenidos como de las formas. Yo podría dominar muchos recursos pedagógicos adecuados para enseñar a cantar, pero si yo mismo no conozco La Marsellesa, seré incapaz de enseñarle a otro a que la cante. Mis buenos recursos pedagógicos serían insuficientes, si ignoro el contenido. Lo inverso también es cierto: no sirve de mucho saber el contenido a enseñar, si no se tiene los recursos pedagógicos formales más elementales; eso es lo que suele ocurrirle a los maridos que intentan enseñarle a manejar el auto a la señora. Aunque estos maridos sepan como manejar muy bien, despliegan por así decirlo, una 50 Andrés Gacitúa Stemann pedagogía tan negativa en estos casos, que los intentos terminan en crisis conyugal a poco andar y en cero aprendizaje. Saber enseñar manuscritura requiere saber los contenidos, es decir CUÁL manuscritura es la “buena” que se debe enseñar, y exige saber también CÓMO hacer pedagogía especialmente buena, de ESA manuscritura. Partiré por la cuestión principal del contenido: ¿CUÁL ES la buena manuscritura que hay que enseñar en Básica? a) Hay que enseñar la manuscritura: ¿Con letras script o con cursivas? (¿“De imprenta” o cursiva”?) (Sobre esto se debatió durante décadas sin que se llegara a conclusiones claras). b) Hay que enseñar una manuscritura: ¿En el formato reticular que nos ofrece el cuaderno de caligrafía vertical, … o en otro formato distinto? (Favor recuérdese que en Chile llevamos más de cien años usando generalizadamente este cuaderno en la educación básica). Si la respuesta fuera contraria al cuaderno de caligrafía vertical: ¿Qué alternativa se propondría? Si la respuesta fuera favorable al cuaderno de caligrafía vertical: ¿Porqué?...¿cuál es ese buen fundamento pedagógico que nos ofrece este cuaderno? c) Dado que diestros y zurdos difieren orgánicamente en la “lateralidad” de sus manuscrituras: ¿Debiéramos tener UNA SOLA e idéntica pedagogía de la manuscritura para ambos tipos de escolares?,....¿quisiera alguien insistir en la “derechización” o en la “zurdera contrariada”?, o quizás: ¿Debiéramos usar buenas pedagogías zurdas con los zurdos,… y buenas pedagogías diestras con los diestros?... ¿Cuáles serían y en qué consistirían estas buenas pedagogías diferenciadas para diestros y zurdos?. ¿En qué se diferenciarían? Prácticamente nadie tiene respuestas claras para los tres cuestionamientos anteriores; es decir, se ignora casi todo sobre los contenidos a enseñar, lo que equivale a que no se sabe cuáles son los contenidos de esta buena calidad educativa por la que estoy preguntando. Asumamos que alguien ya sabe todo lo anterior, que domina los contenidos. Habría que preguntarle: ¿Cuál es entonces la buena forma pedagógica que debemos usar para enseñar esa buena manuscritura? Profesionales que “en el discurso abstracto” opinan con soltura en torno a la “calidad educativa” como problema nacional, no tienen idea de qué métodos pedagógicos alternativos existen en materia de la simple SUMA, y tampoco tienen idea alguna que ofrecer en un eventual debate en torno al fundamento metodológico de la didáctica del cuaderno de caligrafía vertical, ni tampoco pueden marcar diferencias pertinentes y adecuadas entre las pedagogías de las manuscrituras diestras y zurdas. O sea, tan pronto se les requiere que aterricen en lo real, aunque se trate de cuestiones aparentemente tan simples como la suma o la manuscritura, los pseudo-expertos del mundo de la abstracción educativa fracasan lastimosamente. Este fue el problema de la “Comisión Brunner” y opino que ésta es la principal clave para entender lo que ha estado pasando en los últimos 50 años con las políticas educativas en Chile. Los políticos y los legisladores no saben cuáles son las “buenas calidades” educativas en lo concreto, pero no han querido reconocerlo y se empeñan en legislarle al país, normas y disposiciones absurdas. (La ministra Mariana Aylwin se quejaba de que “la Reforma no había entrado en las aulas” durante su ministerio; habría en esto dos lecturas posibles: los profesores trancaban las 51 De lo abstracto a lo concreto en los debates sobre la calidad educativa puertas de las aulas para eludir lo que la Reforma les sugería-exigía, o bien, los Reformadores tenían un discurso abstracto que aunque invadiera las aulas a raudales, jamás tocaría a las prácticas de enseñanza-aprendizaje porque estaba enunciado en otro nivel de lenguaje.) En muchos casos, hasta sesudos especialistas en pedagogía pasarían bochornos tratando de aplicar sus abstracciones a las problemáticas concretas de la educación: 1. ¿Cómo sería una pedagogía humanizada de la manuscritura y cómo sería otra nohumanizada? 2. ¿Cómo podría practicarse una buena pedagogía de la manuscritura “centrada en el alumno”?,….¿Existen algunas “malas pedagogías” de la manuscritura que no se centren en el alumno?....., me cuesta imaginar que exista alguna forma de enseñar la manuscritura como no sea centrándose en el alumno... 3. La manuscritura: ¿Debe enseñarse con un enfoque de “competencias” o podría enseñarse a la antigua, por objetivos y más bien frontalmente?; ¿Conoce el lector estudios que hayan evaluado los rendimientos pedagógicos comparados de estas dos didácticas posibles de la manuscritura? 4. Cuando en Chile se derechiza a un zurdo, como se sigue practicando hasta hoy: ¿Eso es Pedagogía por Objetivos?... ¿Pedagogía Frontal..? , ¿Pedagogía por Competencias?, ¿ centrada en el Alumno?,… ¿ o se tratará tal vez de simple tortura neurológica practicada por un sistema que, aunque no lo sabe, está provocando el 90% de las disgrafias de nuestros escolares a causa de sus malas metodologías de enseñanza de la manuscritura? Y en cualquier caso: ¿Qué habría que cambiarle a la manuscritura que estamos enseñando?, ¿Cómo se hace una mejor pedagogía … de esa mejor manuscritura? Para el lector con experiencia en estas materias debería ser obvio que lo que estoy diciendo ES LO QUE OCURRE en la práctica pedagógica, donde los docentes de aula reciben discursos abstractos sobre la calidad educativa, de parte de unas autoridades que no saben como orientarlos hacia una práctica de calidad porque lo ignoran todo sobre una mejor pedagogía de la manuscritura, de la suma, de la comprensión lectora, del sistema métrico, o de los porcentajes, etc. 4. Cientos de factores inciden en una buena calidad educativa. A propósito de la evaluación de los docentes, se ha dado a entender que ellos serían el componente fundamental de toda calidad educativa. Esto es un error precisamente contrario al anterior. Si arriba hablábamos de abstracciones que no sabían aterrizar en lo concreto, ahora estamos ante una concreción tan exacerbada, que no admite más que esa dimensión como la única existente. La pregunta crítica aquí sería: ¿Cuáles son los principales factores que determinan la calidad educativa disponible para el alumno en una cierta aula de un establecimiento? En el sentido geográfico más extremo, quienes viven en el Hemisferio Norte tienen acceso a sistemas educativos de “mejor calidad” que quienes viven en el Hemisferio Sur; y en el sentido emocional más extremo, las personas que han vivido situaciones emocionales traumáticas, están en peores condiciones para aprovechar los procesos educativos, que quienes no han vivido estas situaciones traumáticas. Sin embargo, cuando intentamos aclarar los conceptos que tenemos en torno a la “calidad educativa” no nos preguntamos en qué hemisferio vivimos ni tampoco pensamos que sea indispensable levantar un historial emocional de cada alumno. 52 Andrés Gacitúa Stemann Podríamos convenir en que es razonable prescindir de aquellos factores determinantes de la calidad educativa que, por uno u otro motivo, nos resultan muy extraños o lejanos; sin embargo, no es fácil consensuar los límites, esas fronteras específicas a partir de las cuales nos importa considerar a todos los factores que se combinan para determinar como macro-producto suyo, a la “calidad educativa” a la que tiene acceso un determinado escolar. A efectos de la argumentación, imaginemos apenas unas pocas fuentes o factores que inciden sobre la calidad final de la educación disponible para un alumno, aún cuando tengamos claro que hay muchas más: a) Planes, Programas y Contenidos Mínimos Obligatorios del Ministerio de Educación; b) Proyectos Educativos que son responsabilidad de cada Establecimiento; c) Calidad del trabajo de la Unidad Técnico-Pedagógica del Establecimiento; y d) Calidad Pedagógica del Docente. Estos cuatro “macro-componentes” de la calidad educativa que pudiera estar a disposición del alumnado de un cierto curso-establecimiento, pueden complementarse armónicamente entre sí, para terminar configurando una oferta de gran calidad para el alumnado, o pueden estorbarse y anularse unos a otros generando contradicciones y sinsentidos que resultarían en una pésima calidad educativa como combinatoria final. Puede ocurrir que un docente de alta calidad se vea literalmente anulado por las disposiciones coactivas de una Unidad Técnico Pedagógica (UTP) más bien confusa e inepta, que no logra articular una práctica pedagógica en la que el Proyecto Educativo del establecimiento se potencie adecuadamente con los Planes, Programas, y Contenidos Mínimos Obligatorios del Mineduc. También puede ocurrir lo contrario: una excelente UTP puede obtener desempeños bastante buenos incluso de sus peores docentes, si acaso ha logrado armonizar adecuadamente las prácticas pedagógicas que requiere de su profesorado con el Proyecto Educativo del establecimiento y con las disposiciones del Mineduc. Ante todo, es obligado reconocer que muchas decisiones sustantivas en torno a lo que pueda llegar a ser una oferta de calidad educativa, no son tomadas por los docentes mismos sino por instancias tanto de autoridad nacional (Mineduc) como de carácter técnico (las UTP) que operan por sobre los docentes. Por supuesto, esto no suele analizarse cuando se habla de evaluar a los docentes; se da por supuesto que la calidad del desempeño pedagógico del docente en el aula es una responsabilidad exclusiva y propia de cada docente, y en estos días se predica que la calidad del profesor es el componente fundamental de la calidad educativa; cuestión cuya falsedad se evidencia tan solo con mencionar los casos de aquellos docentes que trabajan simultáneamente en establecimientos particulares pagados de altos puntajes PSU y en establecimientos municipalizados de bajos puntajes PSU. Si el gran factor causal fuera el docente, sería inexplicable que el mismo docente obtenga resultados tan disímiles. Su calidad potencial como docente es la misma, solo que ella se asocia a OTROS factores que la elevan o la inhiben cuando trabaja en distintos establecimientos. El problema no consiste en que los docentes se crean intocables e inevaluables: el problema es que TODOS LOS SUJETOS que participan en el proceso educativo lo hacen. La Comisión Brunner nos dejó instalados muchos lineamientos,…pero no acepta ni responde a críticas. El Mineduc no acepta que se evalúe la calidad de sus planes y programas ni sus contenidos mínimos obligatorios (CMO); el Establecimiento Educativo no admite que se evalúe su Proyecto Educativo Institucional, y… salvo algún llamado de atención desde la Dirección misma, la UTP tampoco acepta ser evaluada. Ni pensemos en que se pudiera evaluar a Padres y Apoderados, 53 De lo abstracto a lo concreto en los debates sobre la calidad educativa al Alcalde, a los Concejales, etc., en lo que le aportan o le restan a la calidad educativa de los establecimientos con que se relacionan. En suma, puede haber excelentes docentes con buenos alumnos, que tengan bajos rendimientos en las pruebas de conocimientos tipo SIMCE a causa de una mala planificación por la UTP, o a causa de que el Proyecto Educativo es francamente incompatible con las disposiciones del Ministerio de Educación. Como se ve, nos podemos meter en líos fácilmente si tan sólo atendemos a cuatro de los componentes más obvios de la calidad de los contenidos y procedimientos educativos que llegan al aula; y no son cuatro sino cientos de factores los que componen la “calidad educativa disponible para un determinado alumno”. En cualquier caso, la “calidad educativa” es una etiqueta “monstruo” que nos sirve para aludir a un enorme conjunto de procesos,… cada uno de los cuales aporta grados más o grados menos de la calidad educativa final que está a disposición del alumno. Agreguemos, que la calidad de un proceso solo existe cuando el proceso mismo tiene lugar. Es decir, no hay “calidad de la educación”, hasta que el proceso educativo ocurre, y cuando esto pasa, entran en juego los procesos vinculados al aprendizaje que es capaz de aportar cada alumno. Evidentemente, un proceso educativo obtendrá mejores resultados, en la medida en que cuente con mejores procesos de aprendizaje aportados por el alumno. Por supuesto, un instrumento como el SIMCE no mide nada de lo anterior; se salta olímpicamente toda alusión a la calidad de los Planes y de los CMO del Ministerio, se salta el Proyecto Educativo del Establecimiento, y se salta la calidad de la planificación y la gestión pedagógica de la UTP. Se salta la calidad del docente, y no contempla nada de los buenos aportes que a nivel de procesos de aprendizaje haga o no haga el alumno. Hasta ahora, muchos docentes se resisten a ser evaluados, y los entendemos: lo justo sería evaluar a todos los componentes del sistema y no sólo a uno de ellos; por su parte, el SIMCE termina midiendo “calidad de la educación” como si este constructo fuera lo mismo que “rendimiento del alumno en pruebas de conocimiento”. Esto no es sino una total inconsistencia conceptual. Mientras no exista una sana voluntad política de arreglar estos entuertos, nada de lo que se haga podrá conducirnos a una solución de importancia. Conclusiones Este texto no intentó sino criticar la práctica ambigua que se está haciendo en el manejo del concepto de “calidad de la educación”. Mientras usemos este concepto como si fuera una entelequia abstracta, seguirá siendo imposible hacer una buena reforma en la materia. Se requiere que desde el concepto se mire a las prácticas, o mejor aún, que el concepto surja desde las prácticas. Las formas en que medimos calidad educativa, especialmente con el SIMCE, no son mediciones de calidad de la educación. Y cuando se analiza la docencia de la manuscritura, vuelve a hacerse evidente que el concepto-entelequia de la “calidad-educativa” todavía no sabe hablar en el lenguaje de las prácticas pedagógicas concretas correspondientes. El saber de los legisladores en la materia, no es capaz de responder por zurdos y diestros, ni por el cuaderno de caligrafía vertical, ni por letras scripts ni por cursivas. No se discute en el Parlamento cuáles son las buenas y cuáles las malas prácticas médicas; ni el Senado ni la Cámara de Diputados pueden normarle a los ingenieros cuáles son las estrategias matemáticas para hacer buenos cálculos y cuáles las que terminan con cálculos malos. Ya es hora de que los cambios en la calidad de la educación los propongan e implementen quienes sepan algo de esto. Ya es hora de que los políticos admitan que mientras no sepan nada sobre las “concreciones” de la calidad educativa, usar el concepto a nivel puramente abstracto, solo asegura que todo lo que 54 Andrés Gacitúa Stemann hagan seguirá siendo apenas un juego muy caro y absurdo en torno o una entelequia cuyos procesos reales no comprenden. REFERENCIAS Comisión Brunner: Los desafíos de la educación chilena frente al siglo XXI. Editorial Universitaria, Santiago, Chile, 1995. (Circuló en fotocopias durante 1994; la edición en formato de libro es de 1995). Gacitúa, Andrés: (1994). ¿Qué será lo que quiere el Estado…? Revista de Psicología, editada por el Colegio de Psicólogos de Chile, Santiago. Volumen 15, Nº 2, pp 51 – 63. En torno a las estadísticas nacionales en educación y a las pruebas PAA, SIMCE y PSU, se sugiere revisar las numerosas páginas web oficiales en la materia. En el caso del Mineduc, es de especial interés la Dirección de Planificación y Presupuesto. Ver como apoyos: www.simce.cl www.psu.cl www.demre.cl www.mineduc.cl www.ine.cl www.cse.cl www.cruch.cl (Sistema de Medición de la Calidad de la Educación). (Prueba de Selección Universitaria). (Departamento de Evaluación, Medición y Registro Educacional.) (Ministerio de Educación) (Instituto Nacional de Estadísticas) (Consejo Superior de Educación) (Consejo de Rectores de las Universidades Chilenas. Ver anuarios estadísticos). LA TERCERA. Tabloide de edición diaria, en Santiago de Chile. Se comenta textos sobre los resultados de la PSU 2009. Ver la edición del 23 de Diciembre 2008, páginas 1, 35, 36 y 37. A su vez, La Tercera cita y comenta a David Bravo, investigador del Centro de Microdatos de la U. de Chile y a Gregory Elacqua, investigador del Centro de Políticas Comparadas de Educación de la Universidad Diego Portales. A nivel internacional puede consultarse las páginas web de CEPAL, UNESCO, TIMS, PISA, etc. 55