Volumen 1 - Universidad Politécnica de Tulancingo

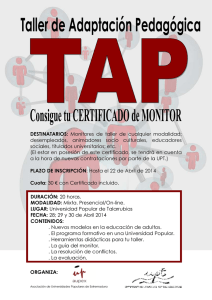

Anuncio