Departamento de Arquitectura de Computadores y Automática

Anuncio

Departamento de Arquitectura de Computadores y

Automática

Universidad Complutense de Madrid

Gestión Eficiente de Transacciones en

Máquinas de Búsqueda para la Web

Carolina Bonacic Castro

Madrid, España

Resumen

Las máquinas de búsqueda para la Web son sistemas diseñados para alcanzar un rendimiento eficiente frente a situaciones de tráfico de consultas muy intenso y dinámico. Este

objetivo se consigue a través de composiciones de estrategias de indexación distribuida

y caching, y procesamiento paralelo de consultas, las cuales son desplegadas en grandes

clusters de nodos procesadores. Los clusters forman sistemas de memoria distribuida entre nodos, y cada nodo es un sistema de memoria compartida que permite la ejecución

concurrente de muchos threads.

El foco de atención en investigación ha estado centrado sólo en los sistemas de memoria

distribuida. El problema de cómo administrar eficientemente los threads en cada nodo no

ha sido mencionado en la literatura del área. Para máquinas de búsqueda convencionales,

donde la solución a consultas de usuarios genera operaciones de sólo lectura, este problema no es relevante puesto que cualquier estrategia estándar de gestión de threads puede

alcanzar un rendimiento razonablemente eficiente.

Sin embargo, el problema de la sincronización eficiente de threads lectores y escritores

que acceden concurrentemente a la memoria compartida del nodo, se ha vuelto relevante

debido a que las máquinas de búsqueda han comenzado a permitir que sus contenidos

sean actualizados de manera on-line. Este trabajo de tesis se ha dedicado al estudio de

este problema en el contexto de nodos con procesadores multi-core.

Se proponen estrategias de procesamiento de transacciones de lectura y escritura para nodos de máquinas de búsqueda. Las estrategias desarrolladas realizan paralelismo

sincrónico a nivel de threads como una alternativa más eficiente al enfoque convencional

basado en concurrencia asincrónica y sincronización vı́a locks. Las ideas propuestas son

validadas tanto con experimentación en base a implementaciones reales como con modelos

de simulación discreta.

Índice general

1. Introducción

1

1.1. Organización de la Tesis . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2. Estado del Arte

5

8

2.1. Clusters de Servicios de Indice . . . . . . . . . . . . . . . . . . . . . . . . .

8

2.2. Índices Invertidos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 10

2.2.1. Distribución por documentos . . . . . . . . . . . . . . . . . . . . . . 11

2.2.2. Distribución por términos . . . . . . . . . . . . . . . . . . . . . . . . 11

2.2.3. Diferencias entre ambas estrategias . . . . . . . . . . . . . . . . . . . 12

2.3. Ranking de documentos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 13

2.4. Trabajo Relacionado . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 16

2.4.1. Índices invertidos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 16

2.4.2. Compresión de ı́ndices invertidos . . . . . . . . . . . . . . . . . . . . 16

2.5. Caches . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 18

2.6. Arquitectura de una máquina de búsqueda . . . . . . . . . . . . . . . . . . . 20

2.7. Procesamiento Round-Robin de Consultas . . . . . . . . . . . . . . . . . . . 23

3. Paralelismo Hı́brido

26

3.1. Introducción . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 28

1

3.2. Estrategia Hı́brida . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 30

3.3. Experimentos sobre procesadores Intel . . . . . . . . . . . . . . . . . . . . . 32

3.3.1. Resultados . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 33

3.4. Experimentos sobre procesadores Niagara . . . . . . . . . . . . . . . . . . . 34

3.4.1. Resultados . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 36

3.4.2. Aritmética de punto fijo: Impacto en el rendimiento y validación . . 40

3.5. Conclusiones . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 41

4. Transacciones Concurrentes

44

4.1. Planteamiento del Problema . . . . . . . . . . . . . . . . . . . . . . . . . . . 45

4.2. Solución Propuesta . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 48

4.2.1. Query Solver . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 49

4.2.2. Algoritmo Bulk Processing (BP Local) . . . . . . . . . . . . . . . . . 51

4.2.3. Alzas bruscas en el tráfico de consultas

. . . . . . . . . . . . . . . . 53

4.3. Un Caso Especial: BP global . . . . . . . . . . . . . . . . . . . . . . . . . . 54

4.4. Sobre la Administración de los Caches . . . . . . . . . . . . . . . . . . . . . 58

4.4.1. Paralelización con Nt threads . . . . . . . . . . . . . . . . . . . . . . 61

4.5. Conclusiones . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 63

5. Comparación de Estrategias

64

5.1. Estrategias alternativas . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 64

5.2. Evaluación utilizando un Servicio de Indice . . . . . . . . . . . . . . . . . . 68

5.2.1. Sobre el tamaño de bloque

. . . . . . . . . . . . . . . . . . . . . . . 70

5.2.2. Resultados . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 71

5.3. Evaluación utilizando un Servicio de Click-Through . . . . . . . . . . . . . . 76

5.3.1. Diseño de los experimentos . . . . . . . . . . . . . . . . . . . . . . . 78

2

5.3.2. Resultados . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 79

5.3.3. Resultados para la Cola de Prioridad . . . . . . . . . . . . . . . . . . 81

5.4. Conclusiones . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 84

6. Análisis de Escalabilidad

6.1. El modelo Multi-BSP

86

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 88

6.2. Análisis Caso Promedio . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 91

6.3. Simulador . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 95

6.4. Simulaciones . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 99

6.4.1. Configuración de simuladores . . . . . . . . . . . . . . . . . . . . . . 100

6.4.2. Protocolo optimista de timestamps . . . . . . . . . . . . . . . . . . . 105

6.4.3. Resultados para Intel y Niagara . . . . . . . . . . . . . . . . . . . . . 106

6.5. Conclusiones . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 112

7. Conclusiones Finales

113

A. Arquitecturas y Modelos

116

A.1. Arquitecturas Multi-Core . . . . . . . . . . . . . . . . . . . . . . . . . . . . 116

A.1.1. Procesador UltraSPARC T1 . . . . . . . . . . . . . . . . . . . . . . . 116

A.1.2. Procesador Intel Xeon Quad-Core . . . . . . . . . . . . . . . . . . . 118

A.2. Modelos de computación paralela . . . . . . . . . . . . . . . . . . . . . . . . 118

A.2.1. Bulk-Synchronous Parallel Model (BSP) . . . . . . . . . . . . . . . . 118

A.2.2. Multi-BSP

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 121

A.2.3. MPI y OpenMP . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 123

B. Estrategias Alternativas

125

3

Índice de figuras

2.1. Estructura de un ı́ndice invertido. . . . . . . . . . . . . . . . . . . . . . . . . 11

2.2. Estrategia de Distribución por Documento. . . . . . . . . . . . . . . . . . . 12

2.3. Estrategia de Distribución por Término. . . . . . . . . . . . . . . . . . . . . 13

2.4. Enfoque base del procesamiento de una consulta. . . . . . . . . . . . . . . . 22

2.5. Arquitectura para el proceso de una consulta.

. . . . . . . . . . . . . . . . 23

2.6. Procesamiento round-robin sincrónico para siete consultas.

. . . . . . . . . 25

3.1. Speed-up obtenidos en dos nodos para tráfico alto y moderado de consultas. 35

3.2. Benchmark sintético que intenta imitar el tipo de cómputo realizado en el

proceso de ranking utilizando aritmética de punto flotante y punto fijo.

. . 36

3.3. Rendimiento para el modo Sync. . . . . . . . . . . . . . . . . . . . . . . . . 37

3.4. Tiempo promedio (ms) por consulta utilizando el modo Async. . . . . . . . 39

3.5. Rendimiento para los modos Async y Sync con tráfico alto de consultas. . . 39

3.6. Throughput para diferentes representaciones numéricas: punto flotante (columna gris) y punto fijo (columna negra). . . . . . . . . . . . . . . . . . . . . . 40

4.1. Arquitectura de un Nodo de Búsqueda. . . . . . . . . . . . . . . . . . . . . 45

4.2. Camino seguido por las consultas.

. . . . . . . . . . . . . . . . . . . . . . . 47

4

4.3. Organización del ı́ndice invertido donde cada lista invertida es almacenada

en un número de bloques y cada bloque se encuentra lógicamente dividido

en trozos que son asignados a cada threads. Cada trozo está compuesto por

un número de ı́temes de la lista invertida, (doc id, freq). En este ejemplo,

el primer bloque el término term 0 es procesado en paralelo por los threads

th0, th1, th2 and th3. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 49

4.4. Inserción/Actualización de documentos. . . . . . . . . . . . . . . . . . . . . 51

4.5. Pasos ejecutados por cada thread en paralelo con los otros Nt − 1 threads.

52

4.6. Sincronización relajada ejecutada por cada thread con identificador my tid.

54

4.7. Pasos ejecutados por cada thread en paralelo con los otros Nt − 1 threads.

57

4.8. Cola de prioridad para la administración de caches.

. . . . . . . . . . . . . 59

5.1. (a) Largo de listas invertidas ordenadas de mayor a menor largo, y largos

mostrados cada 50 listas (Web UK). (b) Distribución de número de términos

en los documentos. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 69

5.2. (a) Frecuencia de ocurrencia de los términos del log de consultas en los

documentos de la base de texto. (b) Distribución del número de términos

en las consultas. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 70

5.3. Throughput alcanzado por las diferentes estrategias con distinto tamaño de

bloque.

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 71

5.4. Throughput (transacciones por segundo) alcanzado por las estrategias para

diferentes tasas de escritura y consultas OR, y un total de 40 mil transacciones.

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 72

5.5. Throughput (transacciones por segundo) alcanzado por las estrategias para

diferentes tasas de escritura y consultas AND, y un total de 40 mil transacciones. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 74

5.6. Throughput alcanzado por las estrategias para diferentes tasas de escritura

y consultas OR y AND, y un total de 40 mil transacciones. Trazas con alto

grado de coincidencia entre términos de transacciones consecutivas.

5.7. Tiempo en segundos para transacciones de lectura/escritura.

5

. . . . 75

. . . . . . . . 76

5.8. Estructuras de datos y secuencia de operaciones. La secuencia (1), (2) y

(3) indica que a partir de un término dado (1) es posible llegar a un nuevo

término (2), que a su vez conduce a un nuevo conjunto de URLs (3), los

cuales se incluirán en el proceso de ranking. Para cada ı́tem (URL, freq) del

ı́ndice invertido, esta secuencia se repite para cada elemento de la lista del

segundo ı́ndice. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 78

5.9. Escalabilidad de las diferentes estrategias para Workload B y suponiendo

que los usuarios hacen un click (gráfico izquierdo) en un enlace en cada

búsqueda o hacen clicks en 5 enlaces (gráfico derecho), los cuales se transforman en 5 transacciones de escritura.

. . . . . . . . . . . . . . . . . . . . 80

5.10. Escalabilidad de las diferentes estrategias para Workload A (gráfico izquierdo) y Workload B (gráfico derecho) para 8 threads y varios clicks indicados

en el eje x.

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 81

5.11. Tiempo individual de transacciones. Parte superior se muestran los resultados de ejecución del tiempo promedio para 1, 2, 4 y 8 threads. En la parte

inferior se muestra el tiempo máximo observado cada 1000 transacciones

procesadas para 8 threads.

. . . . . . . . . . . . . . . . . . . . . . . . . . . 82

6.1. Ejemplo de arquitectura multi-core según Multi-BSP. . . . . . . . . . . . . . 89

6.2. Una de las co-rutinas (concurrent routines) simulando los pasos seguidos

por un thread para procesar una consulta y generando costo en el tiempo

de simulación.

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 96

6.3. Pasos principales ejecutados durante la simulación de una operación relevante de las transacciones. Las co-rutinas del simulador, las cuales simulan

los threads del procesador, ejecutan esta función run(...) a medida que ejecutan los pasos asociados al procesamiento de cada transacción según la

lógica de las estrategias BP, RTLP o TLP2.

. . . . . . . . . . . . . . . . . 98

6.4. Simulación de locks de acceso exclusivo. . . . . . . . . . . . . . . . . . . . . 99

6.5. Simulación de barrera de sincronización.

. . . . . . . . . . . . . . . . . . . 100

6.6. Throughput alcanzado por las estrategias para diferentes tasas de escritura

y consultas OR, y un total de 40 mil transacciones en un procesador Intel i7. 101

6

6.7. (a) Valores observados en las operaciones de locks y barreras. (b) Razón

entre el tiempo de acceso a los caches L2 y L1 en función del tamaño de los

datos y la disperción de los accesos.

. . . . . . . . . . . . . . . . . . . . . . 103

6.8. Valores promedio para g1 y g2 en unidades de 10−9 segundos. . . . . . . . . 105

6.9. Throughputs que el modelo de simulación predice para las estrategias BP,

RTLP y RTLP con Rollbacks (RTLP-RB), en el procesador Intel.

. . . . . 107

6.10. Tiempos de respuesta de transacciones recolectados a intervalos regulares

del tiempo de simulación para 8 threads. . . . . . . . . . . . . . . . . . . . . 108

6.11. Tiempos totales de ejecución normalizados a 1 para un caso en que se simula

granularidad fina haciendo que el costo del ranking de documentos sea 100

veces menor. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 110

6.12. Throughputs que el modelo de simulación predice para las estrategias BP,

RTLP, RTLP-RB y BP-Global (BPG), en el procesador Niagara T1. . . . . 111

A.1. Ejemplo de arquitectura dual-core. . . . . . . . . . . . . . . . . . . . . . . . 117

A.2. Modelo BSP. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 120

A.3. Modelo Multi-BSP para 8 núcleos. . . . . . . . . . . . . . . . . . . . . . . . 121

B.1. Pseudo-Código CR. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 126

B.2. Pseudo-Código TLP1. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 127

B.3. Pseudo-Código TLP2. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 128

B.4. Pseudo-Código RTLP. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 129

B.5. Pseudo-Código RBLP. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 130

7

Índice de cuadros

3.1. Resultados para P procesos MPI con T threads cada uno para el caso en

que todos los núcleos se ocupan para resolver las consultas activas. . . . . . 34

5.1. Estrategias de sincronización de transacciones. . . . . . . . . . . . . . . . . 65

5.2. Resultados para la Cola de Prioridad. . . . . . . . . . . . . . . . . . . . . . 83

6.1. Razones de la pérdida de rendimiento de las estrategias RTLP-RB y RTLP. 108

6.2. Total de aciertos (cache hits) en los caches L1 y L2. Valores en millones de

aciertos cada 10 mil transacciones. . . . . . . . . . . . . . . . . . . . . . . . 109

A.1. Caracterı́sticas del procesador SUN UltraSPARC-T1. . . . . . . . . . . . . . 117

A.2. Caracterı́sticas principales del procesador Intel Quad-Xeon. . . . . . . . . . 118

8

Capı́tulo 1

Introducción

A principios de los años noventa se propuso el modelo BSP de computación paralela [100] como una metodologı́a de paralelización de problemas clásicos en computación

cientı́fica de alto rendimiento. Entre las principales ventajas declaradas para BSP estaban la simplicidad y la portabilidad del software, y la existencia de un modelo de costo

que permitı́a hacer el diseño e ingenierı́a de algoritmos paralelos de manera sencilla y

precisa. Durante esa década, otros investigadores fueron mostrando que BSP también era

capaz de abordar eficientemente la paralelización de otras aplicaciones de Ciencia de la

Computación, y problemas fundamentales en algoritmos y estructuras de datos discretas.

El objetivo fue proponer soluciones escalables a sistemas de gran tamaño, y por lo tanto

la atención estuvo centrada en sistemas de memoria distribuida.

La contribución del modelo BSP al estado del arte de la época no fue proponer una

forma de computación paralela completamente nueva. En realidad, ese tipo de paralelismo

ya existı́a informalmente en numerosas soluciones a problemas variados (e.g., [29]). La

contribución de BSP fue su formalización en un modelo de computación paralela completo, sobre el cual el diseñador de algoritmos y software puede desarrollar soluciones sin

necesidad de recurrir a otros métodos de paralelización o explotar caracterı́sticas del hardware tales como la topologı́a de interconexión de procesadores. Posteriormente, el modelo

pareció desaparecer.

Sin embargo, las ideas detrás de BSP — procesamiento sincrónico por lotes — han

prevalecido puesto que actualmente se les ve claramente presentes en sistemas de amplia

difusión para procesamiento paralelo en grandes clusters de memoria distribuida. Ellos

son Map-Reduce y Hadoop los cuales, aunque son formas restringidas de BSP, mantienen

1

la caracterı́stica principal de BSP, es decir, su simplicidad, donde un aspecto clave en la

concreción de esa simplicidad es que el modelo no aleja radicalmente al diseñador de lo

que es una solución secuencial intuitiva al mismo problema.

Lo anterior a nivel macroscópico, es decir, sistemas de memoria distribuida, lo que

para la aplicación de interés en esta tesis toma la forma de clusters de nodos procesadores

que se comunican entre sı́ mediante una red de interconexión. A nivel microscópico, la

tendencia actual indica que dichos nodos están formados por un grupo de procesadores

multi-core que comparten la misma memoria principal. Dichos procesadores permiten la

ejecución eficiente de muchos threads en el nodo, donde modelos de programación tales

como OpenMP están especialmente diseñados para explotar esta caracterı́stica. OpenMP

ha alcanzado gran difusión en los últimos años en aplicaciones de cómputo cientı́fico.

Curiosamente, una de las formas que promueve OpenMP para organizar la computación realizada por los threads también tiene mucha similitud con BSP. Tal es ası́ que

se propuso recientemente una extensión de BSP para procesadores multi-core (Multi-BSP

[84, 101]). La extensión desde el modelo para memoria distribuida es casi directa puesto

que los procesadores multi-core están construidos en base a una jerarquı́a de memorias.

Esto se puede ver como una distancia entre los núcleos y la memoria principal, lo cual se

puede modelar en BSP como una latencia de comunicación entre ambas unidades.

La paradoja es que mientras para personas no expertas en computación paralela parece

resultar incluso natural organizar sus códigos en el estilo sincrónico por lotes promovido

por BSP en los noventas, al menos para la aplicación que se estudia en este trabajo de

tesis — máquinas de búsqueda para la Web — los especialistas en computación paralela

tienden a organizar sus soluciones como sistemas completamente asincrónicos. Lo habitual

es encontrar soluciones que destinan un thread asincrónico a resolver secuencialmente una

determinada tarea y donde los mecanismos principales de control de acceso a los recursos

compartidos son de tipo locks. Desde la experiencia adquirida en las implementaciones

desarrolladas en esta tesis, se puede afirmar que dichas soluciones resultan ser bastante

más intrincadas y difı́ciles de depurar, que las desarrolladas utilizando el estilo BSP.

La pregunta que responde este trabajo de tesis es si el estilo BSP aplicado a nivel

microscópico viene también acompañado de un rendimiento eficiente. Para lograr este

objetivo fue necesario diseñar, analizar, implementar y evaluar estrategias sincrónicas de

procesamiento de transacciones y compararlas con sus contrapartes asincrónicas.

El requerimiento de eficiencia, tanto en rendimiento como en uso de recursos de hardware es ineludible en las máquinas de búsqueda para la Web. Se trata de sistemas com2

puestos por decenas de miles de nodos procesadores, los cuales reciben centenas de miles

de consultas de usuario por segundo. Entonces, es imperativo ser eficientes en aspectos de

operación tales como consumo de energı́a y cantidad de nodos desplegados en producción.

Respecto de calidad de servicio, la métrica a optimizar es la cantidad consultas resueltas

por unidad de tiempo pero garantizando un tiempo de respuesta individual menor a una

cota superior. Por lo tanto, si se diseña una estrategia de procesamiento de consultas que

le permita a cada nodo alcanzar una mayor tasa de solución de consultas que otra estrategia alternativa, la recompensa puede ser una reducción del total de nodos desplegados

en producción.

No obstante, aun cuando el estilo BSP alcance la misma eficiencia que la mejor estrategia asincrónica, la recompensa proviene desde la simplificación del desarrollo de software

requerido para implementar los distintos servicios que componen una máquina de búsqueda. Tı́picamente, éstas contienen servicios de front-end (broker), servicios de cache de

resultados, servicios de ı́ndices y servicios de datos para ranking de documentos basado en

aprendizaje automático. Entre éstos, el servicio de ı́ndice es el de mayor costo en tiempo

de ejecución puesto que dicho costo es proporcional al tamaño de la muestra de la Web

almacenada en cada nodo del cluster de procesadores.

Para consultas normales enviadas por los usuarios a la máquina de búsqueda, no es

difı́cil demostrar que, en el caso promedio, tanto un algoritmo completamente asincrónico

como uno sincrónico por lotes como BSP puede alcanzar un rendimiento muy similar. Sin

embargo, las máquinas de búsqueda han dejado de ser sistemas en que las transacciones

(consultas) son de sólo lectura. Estas han comenzado a posibilitar la actualización online de sus ı́ndices, lo cual implica desarrollar estrategias que sean eficientes tanto para

el procesamiento concurrente o paralelo de transacciones de lectura como de escritura.

Esto demanda desafı́os más exigentes para estas estrategias, puesto que deben resolver el

problema de los posibles conflictos de lectura y escritura cuando ocurren periodos de alto

tráfico de transacciones que contienen términos o palabras en común. Este trabajo propone

soluciones eficientes a este problema en el contexto de servicios implementados utilizando

el enfoque BSP de paralelización de threads ejecutados en procesadores multi-core.

Como ejemplos de aplicaciones de máquinas de búsqueda que requieren de la actualización en tiempo real de sus ı́ndices se pueden mencionar las siguientes.

En sistemas Q&A como Yahoo! Answers, miles de usuarios por segundo presentan

preguntas sobre temas variados a la base de texto, las cuales son resueltas eficientemente con la ayuda de ı́ndices invertidos. Al mismo tiempo, otros usuarios responden

3

con textos pequeños a las preguntas de usuarios anteriores, donde dichos textos contienen palabras que coinciden con las de las respectivas preguntas, originando de

esta manera posibles conflictos entre threads lectores y escritores al momento de

actualizar el ı́ndice invertido. Ciertamente, a los usuarios les gustarı́a que sus textos

sean parte de las respuestas a las preguntas lo antes posible. Estos sistemas entregan incentivos a los usuarios que proporcionan respuestas pertinentes a preguntas

de otros usuarios, aplicando votaciones sobre la calidad de las respuestas.

En sistemas para compartir fotos como Flickr, los usuarios suben constantemente nuevas fotos que son etiquetadas por ellos con pequeños textos y un conjunto

pre-definido de tags describiendo el contenido. Esto permite que esas fotografı́as

aparezcan en los resultados de las búsquedas que realizan otros usuarios en el sistema en forma concurrente. Se estima que en Flickr se suben decenas de millones

de fotografı́as por dı́a. Si alguien sube una fotografı́a que es pertinente a un tema

que ha capturado el interés repentino de muchos usuarios, lo deseable es que dicha

imagen sea visible a las búsquedas tan pronto como sea posible.

Aunque aún incipiente, un caso muy exigente de procesamiento concurrente o paralelo de transacciones de lectura y escrituras surge cuando se desea incluir en el proceso

de ranking de documentos, los efectos de las preferencias de usuarios anteriores por

documentos seleccionados para consultas similares, pero anteriores en la escala de

los últimos segundos o minutos. En este caso, los clicks realizados por los usuarios

sobre los URLs presentados como respuestas a sus consultas, deben ser enviados

de vuelta a la máquina de búsqueda e indexados de manera on-line. El objetivo es

utilizar estos clicks para refinar el ranking de los resultados de consultas posteriores.

Los clicks pueden ser indexados usando un ı́ndice invertido y ahora la concurrencia

aparece entre la actualizaciones sobre el ı́ndice y las operaciones necesarias para ejecutar tareas tales como la determinación de los términos de consultas similares y los

clicks en los documentos (URLs) relacionados con dichos términos.

Recientemente, las principales máquinas de búsqueda para la Web han comenzado

a incluir en los resultados de consultas a documentos recuperados de sistemas online con cientos de millones de usuarios, muy activos en generación de nuevos textos

pequeños, es decir, con gran probabilidad de coincidencia de palabras entre ellos,

tales como Twitter. Esto fuerza a las máquinas de búsqueda a incluir estos textos

en sus ı́ndices invertidos en tiempo real de manera que puedan ser incluidos en el

proceso de ranking de documentos para las consultas que se recepcionan desde sus

usuarios.

4

Claramente el requerimiento de actualizaciones en tiempo real de los ı́ndices no puede

ser satisfecho por las técnicas convencionales de realizar la indexación de manera off-line

y luego reemplazar la copia en producción del ı́ndice por una nueva. Generalmente la

indexación off-line se hace utilizando sistemas como Map-Reduce ejecutados en cluster de

computadores y sistemas de archivos distintos al cluster o los clusters en producción. La

latencia entre ambos sistemas de archivos es grande y el proceso de copiado a todos los

nodos del cluster de producción puede tomar varios minutos o incluso decenas de minutos.

El enfoque abordado en este trabajo de tesis es indexación on-line, es decir, los nuevos

documentos son enviados directamente a los nodos del cluster ejecutando el servicio de

ı́ndice en producción, y cada nodo indexa localmente los documentos recibidos al mismo

tiempo que procesa las consultas que recibe desde el servicio de front-end. Por lo tanto, el

nodo debe realizar estas operaciones de manera eficiente para evitar degradar el tiempo

de respuesta a las consultas de usuario o transacciones de lectura.

1.1.

Organización de la Tesis

Este trabajo está organizado de la siguiente manera:

Capı́tulo 2 Describe conceptos básicos en máquinas de búsqueda para la Web y revisa

la bibliografı́a relevante para este trabajo de tesis.

Capı́tulo 3 Presenta un estudio de la factibilidad de software del estilo BSP en procesadores multi-core. Se propone un modelo de programación hı́brida utilizando implementaciones C++ y una combinación de las bibliotecas MPI y OpenMP.

Capı́tulo 4 Contiene la contribución principal de este trabajo de tesis. Propone algoritmos de procesamiento sincrónico de transacciones y gestión de caches.

Capı́tulo 5 Presenta una comparación de las estrategias propuestas en el Capı́tulo 4 con

estrategias asincrónicas conocidas. El estudio utiliza implementaciones en C++ y la

biblioteca Posix-Threads.

Capı́tulo 6 Presenta un análisis basado en simulación discreta para validar los resultados

obtenidos con las ejecuciones reales.

Capı́tulo 7 Se presentan las conclusiones finales y se plantea trabajo futuro.

5

Parte del trabajo desarrollado en el transcurso de esta tesis ha sido publicado en los

siguientes lugares:

C. Bonacic, C. Garcia, M. Marin, M. Prieto-Matias and F. Tirado, “Building Efficient Multi-Threaded Search Nodes”, In 19th ACM Conference on Information and

Knowledge Management (CIKM 2010), Toronto, Canada, Oct 26-30, 2010.

C. Bonacic, M. Marin, C. Garcia, M. Prieto and F. Tirado, “Exploiting Hybrid

Parallelism in Web Search Engines”, In 14th European International Conference on

Parallel Processing (Euro-Par 2008), Gran Canaria, Aug. 26-29, Spain, Lecture Notes

in Computer Science 5168, pp.414-423, Springer, 2008.

C. Bonacic, C. Garcia, M. Marin, M. Prieto and F. Tirado, “On-Line Multi-Threaded

Processing of Web User-Clicks on Multi-Core Processors”, In 9th International Meeting High Performance Computing for Computational Science (VECPAR 2010), Berkeley, California, June 22-25, 2010.

C. Bonacic, C. Garcia, M. Marin, M. Prieto and F. Tirado, “Improving Search

Engines Performance on Multithreading Processors”, In 8th International Meeting on

High Performance Computing for Computational Science (VECPAR 2008), Revised

Selected Papers, LNCS 5336, pp. 201-213, Toulouse, France, June 24-27, 2008.

C. Bonacic, M. Marin, “Comparative Study of Concurrency Control on Bulk Synchronous Parallel Search Engines”, In International Conference on Parallel Computing

(ParCo 2007), Aachen, Germany, Sep. 4-7, Advances in Parallel Computing Vol. 15,

pp. 389-396, ISBN 978-1-58603-796-3, IO Press, 2007.

Algunos de los resultados de este trabajo de tesis fueron adaptados a sistemas de

memoria distribuida y fueron publicados en colaboración con otros grupos de investigación

en los siguientes lugares:

M. Marin, V. Gil-Costa, C. Bonacic, R. Baeza-Yates, I.D. Scherson, “Sync/Async

Parallel Search for the Efficient Design and Construction of Web Search Engines”,

In Parallel Computing 36(4): 153-168, 2010

M. Marin, R. Paredes and C. Bonacic, “High-Performance Priority Queues for Parallel Crawlers”, In 10th ACM International Workshop on Web Information and Data

Management (WIDM 2008), California, US, Oct. 30, 2008.

6

M. Marin and C. Bonacic, “Bulk-Synchronous On-Line Crawling on Clusters of

Computers”, In 16th Euromicro International Conference on Parallel, Distributed

and Networkbased Processing (Euro-PDP 2008), Toulouse, France, Feb. 13-15, pp.

414-421, IEEE-CS Press, 2008.

M. Marin, C. Bonacic, V. Gil-Costa, C. Gomez, “A Search Engine Accepting OnLine Updates”, In 13th European International Conference on Parallel Processing

(Euro-Par 2007), IRISA, Rennes, France, Aug. 28-31, Lecture Notes in Computer

Science 4641, pp. 340-349, Springer, 2007.

7

Capı́tulo 2

Estado del Arte

Las máquinas de búsqueda para la Web alcanzan un rendimiento eficiente mediante

la combinación de varias técnicas de indexación, caching, multi-threading, heurı́sticas,

métodos de ranking de documentos, entre otras optimizaciones. En este capı́tulo se revisa

la bibliografı́a y conceptos básicos que sirven de base para este trabajo de tesis.

2.1.

Clusters de Servicios de Indice

Las máquinas de búsqueda para la Web están construidas sobre clusters de nodos,

los cuales ejecutan los distintos servicios que componen el sistema. Los nodos del cluster

están interconectados entre sı́ mediante una red de alta eficiencia que les permite enviarse

mensajes entre ellos. Estos mensajes se utilizan para recolectar la información necesaria

para resolver una determinada tarea, como por ejemplo la solución a una consulta de

un usuario. Cada nodo del cluster tiene su propia memoria principal y discos locales para

almacenar información. Cada nodo puede leer y escribir información en su propia memoria

y si necesita información almacenada en otro nodo debe enviarle un mensaje y esperar la

respuesta. Una descripción simplificada de lo que hacen las máquinas de búsqueda para

resolver las consultas de usuario es la siguiente.

En un cluster utilizado como máquina de búsqueda, cada nodo almacena una parte

de la información del sistema completo. Por ejemplo, si se tiene una colección de texto

que ocupa n bytes y se tiene un cluster con P nodos, entonces se puede asignar a cada

uno de los P nodos una fracción n/P del tamaño de la colección. En la práctica si la

8

colección completa tiene nd documentos o páginas Web, entonces a cada nodo del cluster

se le asignan nd /P documentos.

Las consultas de los usuarios llegan a un nodo recepcionista llamado broker, el cual

distribuye las consultas entre los P nodos que forman el cluster.

Dado que cada nodo del cluster tiene un total de nd /P documentos almacenados en

su memoria, lo que hacen las máquinas de búsqueda más conocidas es construir un ı́ndice

invertido (detalles en la siguiente sección) en cada nodo con los documentos almacenados

localmente en cada uno de ellos. Un ı́ndice invertido permite acelerar de manera significativa las operaciones requeridas para calcular las respuestas a las consultas de los usuarios.

Cada vez que el broker recibe una consulta de un usuario, éste envı́a una copia de la

consulta a todos los nodos del cluster. En el siguiente paso, todos los nodos en paralelo leen

desde su memoria las listas invertidas asociadas con las palabras o términos de la consulta

del usuario. Luego se realiza la intersección de las listas invertidas para determinar los

documentos que contienen todas las palabras de la consulta. Al finalizar este paso todos

los nodos tienen un conjunto de respuestas para la consulta. Sin embargo, la cantidad de

respuestas puede ser inmensamente grande puesto que las listas invertidas pueden llegar

a contener miles de identificadores de documentos que contienen todas las palabras de

la consulta. Es necesario entonces hacer un ranking de los resultados para mostrar los

mejores K resultados al usuario como solución a la consulta.

Para realizar el ranking de documentos es necesario colocar en uno de los nodos del

cluster los resultados obtenidos por todos los otros. Esto con el fin de comparar esos

resultados unos con otros y determinar los mejores K. Sin embargo, enviar mensajes conteniendo una gran cantidad de resultados entre dos nodos puede consumir mucho tiempo.

Es deseable reducir la cantidad de comunicación entre nodos.

Ahora, si cada nodo ha calculado los mejores resultados para la consulta considerando

los documentos (listas invertidas) que tiene almacenados en su memoria local, entonces no

es necesario enviarlos todos al nodo encargado de realizar el ranking final. Basta con enviar

a este nodo los K mejores de cada uno de los P − 1 nodos restantes. Es decir, el ranking

final se puede hacer encontrando los K mejores entre los K × P resultados aportados por

los P nodos.

Pero esto se puede mejorar más aun y ası́ reducir al máximo la cantidad de comunicación entre los nodos [59]. Dado que los documentos están uniformemente distribuidos en

los P nodos es razonable pensar que cada nodo tendrá más o menos una fracción K/P de

9

los mejores K resultados mostrados al usuario. Entonces se puede trabajar en iteraciones.

En la primera iteración todos los nodos envı́an sus mejores K/P resultados al nodo encargado de hacer el ranking final. Este nodo hace el ranking y luego determina si necesita más

resultados desde los otros nodos. Si es ası́, entonces pide nuevamente otros K/P resultados

y ası́ hasta obtener los K mejores. En el peor caso podrı́a ocurrir que para una consulta

en particular uno de los nodos posea los K mejores resultados que se le van a entregar al

usuario, caso en que se necesitan P iteraciones para calcular la respuesta al usuario. Pero

es muy poco probable que esto ocurra para todas las consultas que se procesan en una

máquina de búsqueda grande. En la práctica se ha observado [59] que se requieren una o

a lo más dos iteraciones para la inmensa mayorı́a de las consultas, lo cual permite reducir

considerablemente el costo de comunicación entre los nodos del cluster.

Una manera de explotar al máximo la capacidad de los nodos del cluster es hacerlos

trabajar en paralelo. Esto se puede lograr asignando los nodos de manera circular para

hacer el ranking final de las consultas. Por ejemplo, el nodo broker elige al nodo 0 para

hacer el ranking de la consulta q0 , al nodo 1 para la consulta q1 , ..., el nodo P − 1 para

la consulta qp−1 , el nodo 0 para la consulta qp , y ası́ sucesivamente de manera que en

un instante dado del tiempo se pueda tener a P nodos haciendo el ranking de P o más

consultas distintas en paralelo.

2.2.

Índices Invertidos

Consiste en una estructura de datos formada por dos partes. La tabla del vocabulario

que contiene todas las palabras (términos) relevantes encontradas en la colección de texto.

Por cada palabra o término existe una lista de punteros a los documentos que contienen

dichas palabras junto con información que permita realizar el ranking de las respuestas

a las consultas de los usuarios tal como el número de veces que aparece la palabra en el

documento. Ver figura 2.1. Dicho ranking se realiza mediante distintos métodos [9]. En

este trabajo de tesis se utiliza el llamado método del vector [9, 80, 81].

Para construir un ı́ndice invertido secuencial [31, 38, 88], es necesario procesar cada

documento para extraer las palabras o términos de importancia, registrando su posición

y la cantidad de veces que éste se repite. Una vez que se obtiene el término, con su

información correspondiente, se almacena en el ı́ndice invertido.

El mayor problema que se presenta en la práctica, es la memoria RAM. Para solventar

esta limitación se suele guardar de forma explı́cita en disco ı́ndices parciales cuando se

10

azul

casa

perro

rojo

doc 2 1

doc 1 2

doc 3 1

doc 1 1

doc 3 1

doc 2 1

Figura 2.1: Estructura de un ı́ndice invertido.

superan ciertos umbrales, liberándose de este modo la memoria previamente utilizada. Al

final de esta operación, se realiza un merge de los ı́ndices parciales, el cual no requiere

demasiada memoria por ser un proceso en que se unen las dos listas invertidas para cada

término y resulta relativamente rápido.

Respecto de la paralelización eficiente de ı́ndices invertidos existen varias estrategias.

Las más utilizadas consisten en (1) dividir la lista de documentos en p nodos y procesar

consultas de acuerdo a esa distribución y en (2) distribuir cada término con su lista

completa uniformemente en cada nodo.

2.2.1.

Distribución por documentos

Los documentos se distribuyen uniformemente al azar en los nodos. El proceso para

crear un ı́ndice invertido aplicando esta estrategia (figura 2.2), consiste en extraer todos los

términos de los documentos asociados a cada nodo y con ellos formar una lista invertida por

nodo. Es decir, las listas invertidas se construyen basándose en los documentos que cada

nodo posee. Cuando se resuelve una consulta, ésta se debe enviar a cada nodo (broadcast).

2.2.2.

Distribución por términos

Consiste en distribuir uniformemente entre los nodos, los términos del vocabulario

junto con sus respectivas listas invertidas. Es decir, la colección completa de documentos

es utilizada para construir un único vocabulario para luego distribuir las listas invertidas completas uniformemente al azar entre todos los nodos. En esta estrategia, no es

conveniente ordenar lexicográficamente las palabras de la tabla vocabulario, ya que si se

mantienen desordenadas, se obtiene un mejor balance de carga durante el procesamiento

de las consultas. Ver figura 2.3. En este caso la consulta es separada en los términos que

la componen, los cuales son enviados a los nodos que los contienen.

11

N

o

d

e

1

N

o

d

e

2

Figura 2.2: Estrategia de Distribución por Documento.

2.2.3.

Diferencias entre ambas estrategias

En el ı́ndice particionado por términos la solución de una consulta es realizada de

manera secuencial por cada término de la consulta, a diferencia de la estrategia por documentos donde el resultado de la consulta es construido en paralelo por todos los nodos. La

estrategia por documentos exhibe un paralelismo de grano más fino ya que cada consulta

individual se resuelve en paralelo. En la estrategia por términos sólo puede explotarse

paralelismo si se resuelven dos o más consultas concurrentemente.

Por otra parte, la estrategia de indexación por documentos permite ir ingresando nuevos documentos de manera fácil, el documento se envı́a a la máquina id doc mod P , y se

modifica la lista local de ese nodo. Sin embargo, para el caso de ranking mediante el método del vector (descrito más abajo), se requiere que las listas se mantengan ordenadas por

frecuencia, entonces no es tan sencillo modificar la lista. No obstante, para la estrategia

por términos, también es necesario hacer esa actualización cuando se modifican las listas.

La gran desventaja del ı́ndice particionado por términos está en la construcción del ı́ndice

debido a la fase de comunicación global que es necesario realizar para distribuir las listas

invertidas. Inicialmente el ı́ndice puede ser construido en paralelo como si fuese un ı́ndice

particionado por documentos para luego re-distribuir los términos con sus listas invertidas.

12

N

o

d

e

1

N

o

d

e

2

Figura 2.3: Estrategia de Distribución por Término.

2.3.

Ranking de documentos

El método vectorial [9] es bastante utilizado en recuperación de información para

hacer ranking de documentos que satisfacen una consulta. Las consultas y documentos

tienen asignado un peso para cada uno de los términos (palabras) de la base de texto

(documentos). Estos pesos se usan para calcular el grado de similitud entre cada documento

almacenado en el sistema y las consultas que puedan hacer los usuarios. El grado de

similitud calculado, se usa para ordenar de forma decreciente los documentos que el sistema

devuelve al usuario, en forma de clasificación (ranking).

Se define un vector para representar cada documento y consulta:

El vector dj está formado por los pesos asociados de cada uno de los términos en el

documento dj .

El vector q está compuesto por los pesos de cada uno de los términos en la consulta

q.

Ası́, ambos vectores estarán formados por tantos pesos como términos se hayan encontrado

en la colección, es decir, ambos vectores tendrán la misma dimensión.

13

El modelo vectorial evalúa el grado de similitud entre el documento dj y la consulta

q, utilizando una relación entre los vectores dj y q. Esta relación puede ser cuantificada.

Un método muy habitual es calcular el coseno del ángulo que forman ambos vectores.

Cuanto más parecidos sean, más cercano a 0 será el ángulo que formen y en consecuencia,

el coseno de este ángulo se aproximará más a 1. Para ángulos de mayor tamaño el coseno

tomará valores que irán decreciendo hasta −1, ası́ que cuanto más cercano de 1 esté el

coseno, más similitud habrá entre ambos vectores, luego más parecido será el documento

dj a la consulta q.

La frecuencia interna de un término en un documento, mide el número de ocurrencias

del término sobre el total de términos del documento y sirve para determinar cuan relevante

es ese término en ese documento. La frecuencia del término en el total de documentos,

mide lo habitual que es ese término en la colección, ası́, serán poco relevantes aquellos

términos que aparezcan en la mayorı́a de documentos de la colección. Invirtiéndola, se

consigue que su valor sea directamente proporcional a la relevancia del término.

Una de las fórmulas utilizadas para el ranking vectorial es la siguiente:

Sea {t1 ...tn } el conjunto de términos y {d1 ...dn } el conjunto de documentos, un

documento di se modela como un vector:

di → d~i = (w(t1 , di ), ..., w(tk , di ))

donde w(tr , di ) es el peso del término tr en el documento di .

En particular una consulta puede verse como un documento (formada por esas palabras) y por lo tanto como un vector.

La similitud entre la consulta q y el documento d está dada por:

0 <= sim(d, q) =

P

t (wq,t

∗ wd,t )/W d <= 1.

Se calcula la similitud entre la consulta q y el documento d como la diferencia coseno,

que geométricamente corresponde al coseno del ángulo entre los dos vectores. La

similitud es un valor entre 0 y 1. Notar que los documentos iguales tienen similitud

1 y los ortogonales (si no comparten términos) tienen similitud 0. Por lo tanto esta

fórmula permite calcular la relevancia del documento d para la consulta q.

El peso de un término para un documento es:

14

0 <= wd,t = fd,t /maxk ∗ idft <= 1.

En esta fórmula se refleja el peso del término t en el documento d (es decir qué tan

importante es este término para el documento).

fd,t /maxk es la frecuencia normalizada. fd,t es la cantidad de veces que aparece el

término t en el documento d. Si un término aparece muchas veces en un documento,

se supone que es importante para ese documento, por lo tanto fd,t crece. maxk es

la frecuencia del término más repetido en el documento d o la frecuencia más alta

de cualquier término del documento d. En esta fórmula se divide por maxk para

normalizar el vector y evitar favorecer a los documentos más largos.

idft = log10(N/nt), donde N es la cantidad de documentos de la colección, nt es

el número de documentos donde aparece t. Esta fórmula refleja la importancia del

término t en la colección de documentos. Le da mayor peso a los términos que

aparecen en una cantidad pequeña de documentos. Si un término aparece en muchos

documentos, no es útil para distinguir ningún documento de otro (idft decrece). Lo

que se intenta medir es cuanto ayuda ese término a distinguir ese documento de los

demás. Esta función asigna pesos altos a términos que son encontrados en un número

pequeño de documentos de la colección. Se supone que los términos raros tienen un

alto valor de discriminación y la presencia de dicho término tanto en un documento

como en una consulta, es un buen indicador de que el documento es relevante para

la consulta.

P

2 ))1/2 . Es utilizado como factor de normalización. Es el peso del doW d = ( (wd,t

cumento d en la colección de documentos. Este valor es precalculado y almacenado

durante la construcción de los ı́ndices para reducir las operaciones realizadas durante

el procesamiento de las consultas.

wq,t = (fq,t/maxk ) ∗ idft , donde fq,t es la frecuencia del término t en la consulta q

y maxk es la frecuencia del término más repetido en la consulta q, o dicho de otra

forma, es la frecuencia mas alta de cualquier término de q. Proporciona el peso del

término t para la consulta q.

15

2.4.

Trabajo Relacionado

2.4.1.

Índices invertidos

Existe abundante literatura que describe como resolver de manera eficiente consultas

sobre ı́ndices distribuidos sobre un conjunto de P nodos [4, 15, 17, 32, 33, 37, 50, 86, 87]. En

esos trabajos se discute la eficiencia de los métodos de indexación basados en partición por

documentos y partición por términos. Para cada una de estas estrategias, se han propuesto

diferentes técnicas para resolver consultas sobre el ı́ndice distribuido y, técnicas hı́bridas

para mejorar el rendimiento y/o balance de carga (ver por ejemplo [6, 19, 28, 61, 65, 66,

73, 74, 79, 96, 98, 104]).

2.4.2.

Compresión de ı́ndices invertidos

En la compresión de ı́ndices invertidos [72, 75, 76, 102, 105], y en particular de la lista

de posteos o invertida, la literatura actual habla de Variable-Byte [91], S9 [3], S16 [90] y

PForDelta [111] como métodos modernos que ofrecen la mejor velocidad de descompresión

sin dejar de lado la tasa de compresión [14, 90, 106]. Es por esto que han sido seleccionados

para presentar una breve descripción de cada uno de ellos a modo de estado del arte. Para

ello se considerará una lista de posteos ordenada por IDsdoc, donde la lista comienza con

el IDdoc del primer documento y de allı́ en adelante cada número representa la diferencia

con el IDdoc del documento anterior.

Variable-Byte: Expresa un número en la menor cantidad de bytes posibles. Para ello

ocupa el bit más significativo de cada byte como un bit de marca, que le indica si el byte

actual es el último de la secuencia, el último byte de la secuencia es marcado con un 0

en el bit más significativo. Los restantes 7 bits se ocupan para representar el número a

codificar en formato binario. Ası́ por ejemplo el número 513, que en binario es 1000000001,

codificado con Variable-Byte queda 10000100 00000001.

Es un método muy sencillo y también eficiente a la hora de descomprimir. El inconveniente que éste presenta para las listas de posteo, es que cuando son muy largas y

las diferencias se hacen pequeñas, Variable-Byte representa en un byte números que sólo

requieren un par de bits, desperdiciando gran cantidad de espacio.

S9: Este método trata de guardar la mayor cantidad posible de números en una palabra

de 32 bits. Para hacer esto, los cuatro primeros bits son ocupados como bits de estado,

16

donde se especifica como son ocupados los restantes 28 bits. S9 obtiene su nombre de los

9 posibles casos que se dan al dividir 28 bits en cantidades iguales; 1 número de 28 bits

(y su recı́proco 28 números de 1 bit), 2 números de 14 bits (y su recı́proco), 3 números

de 9 bits (y su recı́proco, desperdiciando 1 bit), 4 números de 7 bits (y su recı́proco) y 5

números de 5 bits (desperdiciando 3 bits).

Para diferencias entre números consecutivos que son muy pequeñas, con este método

se logra empaquetar una gran cantidad de números en una palabra de 32 bits, y además

se logra una buena velocidad de descompresión. Sin embargo, estas ventajas se pierden

cuando entre las diferencias entre números consecutivos existen valores grandes. En este

caso el método no se comporta bien respecto al ahorro de espacio.

S16: Variante de S9, que toma algunos casos especiales que no dividen los 28 bits en

forma regular, logrando con esto completar 16 casos (de ahı́ su nombre). De esta manera se

pretende ocupar la mayor cantidad de bits posibles en forma eficiente, eliminando algunos

casos que desperdiciaban bits, como por ejemplo 5 números de 5 bits, se reemplaza por 2

casos; el primero es 3 números de 6 bits y 2 números de 5 bits, el segundo es 2 números

de 5 bits y 3 números de 6 bits.

En compresión este método logra resultados levemente mejores a S9, manteniendo su

velocidad de descompresión, sin embargo aún mantiene las debilidades del método original.

PForDelta: Este método deriva originalmente del método de compresión FOR [35]

(Frame Of Reference). Para un cierto rango de números, FOR toma ambos extremos, observa cuantos casos posibles existen entre el menor y el mayor de los extremos, codificando

cada caso en binario desde 0 para el menor hasta el número binario que sea necesario para

cubrir todo el rango, ocupando ası́ la menor cantidad posible de bits para representar

cada caso. Por ejemplo, se tiene un rango en la lista de posteos donde se repiten muchas

diferencias entre 2 y 5, se sabe que los posibles casos son {2,3,4,5}, para diferenciar entre

ellos nos basta con usar 2 bits, ası́ cada caso quedarı́a; 00 para 2, 01 para 3, 10 para 4 y

11 para 5.

El método FOR presenta problemas al tener rangos con diferencias demasiado grandes,

PForDelta ataca ese problema. Para esto, PFordelta separa la mayorı́a (aproximadamente

el 90 % según el autor [111]) de los números que pueden ser representados en b bits (coded),

de los que no pueden ser representados en b bits (exceptions). De esta manera los números

codificables son guardados con FOR y las excepciones se guardan descomprimidas.

17

2.5.

Caches

Inicialmente los motores de búsqueda para la Web mantenı́an los resultados de las

consultas frecuentes a lo largo del tiempo en un cache estático. Posteriormente, en [69] se

muestra que el rendimiento del cache estático es deficiente, ya que muchas consultas que

llegan a la máquina de búsqueda son frecuentes por periodos cortos de tiempo y por lo

tanto, el cache estático no las considera. Dado esto, técnicas de caching dinámico basadas

en polı́ticas de reemplazo como LRU presentan mejor rendimiento. En [53] se calcula un

valor de relevancia para las consultas y se estima la probabilidad de que una consulta se

repita en el futuro cercano, esta técnica es llamada Probability Driven Caching (PDC).

En [27] se propone una estrategia de caching donde se mantiene en el cache de resultados una sección estática y otra dinámica, obteniendo buenos resultados, Static-Dynamic

Caching (SDC). En SDC, la parte estática mantiene las consultas más frecuentes en largos

periodos del tiempo, y la parte dinámica es implementada con polı́ticas de reemplazo como

LRU. Esta estrategia, logra una tasa de aciertos superior al 30 % en experimentos basados

en el log de Altavista. En [54] se muestra que al almacenar intersecciones de pares de

términos frecuentes, determinados por la co-ocurrencia en el log de consultas, es posible

mejorar el rendimiento significativamente. En [8] se muestra que al tener un cache de listas

invertidas, se logran mejores resultados que al tener un cache de resultados únicamente.

En [30] se estudia el cache de resultados con ponderación (Weighted Result Caching), donde el costo de procesar una consulta se considera en el momento de decidir su admisión

en el cache de resultados.

Las técnicas anteriores entregan una respuesta exacta a las consultas a través de la

información que existe en el cache. El uso de técnicas de aproximación mediante análisis

semántico puede ayudar a sacar mejor utilidad del contenido en el cache de resultados.

En [34] se utiliza esta técnica donde se proporciona una pauta para identificar los distintos

casos surgen al considerar distintas relaciones entre los términos de la nueva consulta y

los términos de las consultas almacenadas en el cache. Esto permite obtener resultados

aproximados para una consulta que, aún cuando no está exactamente en el cache, comparte

términos con otras consultas. Esta técnica se puede utilizar para permitir a la máquina de

búsqueda seguir respondiendo consultas incluso en casos en que sus nodos están saturados

debido a subidas bruscas en el tráfico de consultas.

En [20, 21] se presentan nuevos métodos semánticos para resolver consultas. Se propone mantener clusters de respuestas co-ocurrentes identificadas en una región, cada uno

de ellos asociados a una firma. Las nuevas consultas frecuentes también son identifica18

das con una firma, donde las regiones con firmas similares son capaces de entregar una

respuesta. Los resultados experimentales muestran que el rendimiento de los diferentes

métodos semánticos dependen del tipo de solapamiento. En [2] se estudia el problema de

escalabilidad para métodos de caching semántico.

En [83] se propone un método que utiliza un log de consultas para formar P clusters

de documentos y Q clusters de consultas. Los clusters son formados mediante el uso de un

algoritmo de co-clustering. Esto permite la creación de una matriz en la máquina broker

donde cada elemento indica que tan pertinente es un cluster de consultas a un cluster

de documentos. Además, para cada cluster de consultas, se mantiene un archivo de texto

que contiene todos los términos presentes en las consultas del cluster. Cuando la máquina

broker recibe una consulta q, ésta calcula que tan pertinente es q a uno de los clusters de

consultas mediante el uso de métodos de similitud. Estos valores de similitud se utilizan

en combinación con los elementos de la matriz de co-clustering, para calcular un ranking

de clusters de documentos. Los primeros lugares del ranking representan los nodos que

son capaces de responder a una consulta con mayor precisión. Es decir, son los nodos

que tienen mayor probabilidad de aportar documentos, y formar parte de los resultados

top-k globales de una consulta. La idea es enviar la consulta a los nodos más probables de

aportar documentos para la respuesta.

Los métodos presentados en [28, 71, 77] persiguen un objetivo similar pero utilizando

técnicas diferentes. Estos métodos están basados en el uso de un cache de aplicación llamado Location Cache (LCache) el cual registra los nodos que aportan los top-K documentos

para consultas almacenadas en cache. Los métodos propuestos utilizan técnicas semánticas y de aprendizaje sobre la LCache. Siempre el objetivo final es enviar la consulta a

un conjunto reducido de nodos con el fin de evitar saturar al motor de búsqueda frente a

situaciones de alzas en el tráfico de consultas.

El trabajo presentado en [28] propone usar el LCache como un cache semántico. El

método semántico para la evaluación de las nuevas consultas, utiliza la frecuencia inversa

de los términos de las consultas almacenadas en cache, que determinan cuando los resultados recuperados desde el cache son buenas aproximaciones al resultado exacto. La

precisión de los resultados varı́a en función de la coincidencia semántica de los casos analizados. En [60] se propone una combinación de LCache y RCache (cache de resultados

estándar) usando estrategias dinámicas de caching, obteniendo un desempeño eficiente en

escenarios de tráfico variable de consultas, opuesta a la estrategia que sólo utiliza RCache

la cual se satura ya que no es capaz de trabajar de manera eficiente con variaciones de

19

tráfico. El trabajo en [71] aplica métodos de máquinas de aprendizaje sobre el LCache

para determinar cual es el mejor nodo de búsqueda.

Una idea similar, pero basada en el modelo vectorial se aplica en [77] que predice los

nodos de búsqueda para las consultas que no se encuentran en la LCache. En todos los

casos, la motivación es reducir la carga sobre los nodos de búsqueda frente a cambios bruscos en el tráfico de consultas. La idea es entregar una buena aproximación de respuestas

a las consultas utilizando pocos nodos de búsqueda por cada una y evitar de esta manera

la saturación y el comportamiento inestable del motor de búsqueda.

2.6.

Arquitectura de una máquina de búsqueda

Los centros de datos para motores de búsqueda en la Web, contienen miles de nodos

intercomunicados, formando diferentes clusters. Por lo general, cada cluster se especializa

en una sola operación relacionada con el procesamiento de una consulta. La operación que

más tiempo demanda en el proceso de resolver una consulta, es determinar los mejores K

(top-K [42, 52]) documentos (IDs) que mejor coinciden con una consulta dada. Hay otras

operaciones atendidas por otros clusters, tales como la construcción de la página Web de

resultados de los mejores K documentos y la publicidad relacionada con los términos de

la consulta. Determinar los top-K documentos, es la parte más costosa [25] del proceso

dado el gran tamaño de la colección de texto de la Web.

Para el conjunto top-K, una arquitectura estándar de cluster es un arreglo (array) de

P × D nodos, donde P indica el nivel de partición de la colección de texto y D el nivel de

replicación de la colección.

El tiempo de respuesta de una consulta es proporcional al tamaño de la colección de

texto y para obtener tiempos de respuesta por debajo de un cierto lı́mite, la colección de

texto es dividida en P particiones diferentes. Cada consulta es enviada a las P particiones

y, en paralelo, se determinan los top-K locales a cada partición. A partir de los K locales,

se generan los K globales de la consulta. Existe una máquina aparte llamada broker que se

encarga de enviar las consultas a los nodos de búsqueda, para luego recopilar los resultados.

El nivel de replicación indica que cada una de las P particiones son replicadas D

veces. El propósito de replicar es por dos motivos. Entregar un soporte tolerante a fallos

y alanzar una tasa de solución de consultas por unidad de tiempo (throughput) eficiente.

20

En cualquier instante de tiempo, diferentes consultas, pueden ser resueltas por diferentes

réplicas. En cada partición una de las réplicas es seleccionada uniformemente al azar.

La implementación de una máquina de búsqueda en un arreglo logra un desempeño

eficiente utilizando técnicas de indexación [26, 56, 99, 110] y caching [5, 7, 11, 16, 64, 68,

78, 94, 107, 108]. Con respecto a la indexación, cada nodo de búsqueda contiene una lista

invertida que es usada para mapear de manera eficiente los términos de la consulta con los

documentos relevantes [61, 74]. Las listas invertidas asociadas a los términos de la consulta,

rápidamente entregan un conjunto de documentos relevantes que son ordenados mediante

técnicas de ranking. Las listas invertidas pueden ser muy grandes y por lo general sólo se

hace referencia a un subconjunto de ellas. Por este motivo, muchas de las listas invertidas

son almacenadas en memoria secundaria o en formato comprimido en memoria principal,

y sólo un subconjunto de ellas se mantienen descomprimidas en memoria principal, a esto

se llama cache de listas invertidas (posting list cache). Este cache es administrada bajo el

estándar LRU.

Un segundo cache, llamado cache de resultados (results cache), se mantiene en la

máquina broker. Este se encarga de recibir las consultas, enviarlas al arreglo de nodos

para que sean resueltas, y recolectar los resultados. El cache de resultados, almacena las

respuestas a las consultas más frecuentes. Las polı́ticas de administración para el cache de

resultados, se basa en la estrategia SDC [27]. Se mantiene una sección de sólo lecturas para

almacenar las respuestas de las consultas más frecuentes por un periodo largo de tiempo.

Una primera parte se administra como un cache estática, con la polı́tica LFU. La segunda

parte, representa el cache dinámico, administrado con LRU, se encarga de las consultas

más populares por un corto periodo de tiempo. Experimentos presentados en [27] sugieren

destinar un 80 % para la parte estática y un 20 % para la parte dinámica.

Recientemente [30] mostró que la parte dinámica es mejor administrarla utilizando

una polı́tica llamada Landlord, la cual es una generalización de LRU. Esta polı́tica de

administración, considera el costo de procesar una consulta cuando se decide si se encuentra

o no en cache. Inicialmente la prioridad de entrada a el cache está dada por el costo

promedio L de procesar una consulta en cada nodo de búsqueda. Cuando la entrada es

re-usada por la misma consulta (cache hit) la prioridad se incrementa por L unidades.

Cuando una entrada es sustituida por una nueva consulta, todas las entradas que quedan

en la memoria cache disminuyen su prioridad en L unidades. Una implementación eficiente

de esta estrategia es utilizando colas de prioridad. Cada nueva entrada recibe una prioridad

s + L con un valor inicial s = 0. La siguiente entrada que va ser sustituida es aquella que

tiene el menor valor numérico v en la cola de prioridad y se hace s = v para la prioridad

21

(a) Jerarquı́a estándar de Cache

(b) Camino de una consulta en un search node

Figura 2.4: Enfoque base del procesamiento de una consulta.

s+L del nuevo elemento que se almacena en la entrada. Para la cache estática se considera

f · L para los valores de prioridad donde f es la frecuencia de ocurrencia de las consultas

en un log.

Alternativamente, una tercera cache es mantenida en este esquema. Esta es la cache

de intersecciones (intersection cache) [54] la cual mantiene en cada nodo de búsqueda la

intersección de las listas invertidas que están asociadas a los términos más frecuentes de las

consultas. La operación de intersección es útil para detectar los documentos que contienen

todos los términos de la consulta, requerimiento tı́pico para encontrar los top-K resultados

en los principales motores de búsqueda.

De esta manera, las tres caches definen una jerarquı́a que va desde los datos más especı́ficos pre-computados para las consultas (cache de resultados) a los datos más genéricos

para resolver una consulta (cache de listas invertidas).

La Figura 2.4.a ilustra el estado del arte para una jerarquı́a de caches para máquinas de

búsqueda, donde un cache de intersecciones y listas invertidas son mantenidas en cada uno

de los P × D nodos de búsqueda. La Figura 2.4.b muestra qué ocurre cuando una consulta

no encuentra los resultados en el cache de resultados de la máquina broker. En este caso,

la consulta es enviada a un nodo de búsqueda por cada columna. En cada columna, el

respectivo nodo de búsqueda es seleccionado al azar de manera uniforme.

22

202

Answer 214

Broker 204

201

Rankers

212c

208

212b

S

Fetchers

S

212a

206(1)

206(2)

206(3)

206(i)

206(P−2) 206(P−1)

206(P)

Figura 2.5: Arquitectura para el proceso de una consulta.

2.7.

Procesamiento Round-Robin de Consultas

Es un método diseñado para optimizar el uso de los recursos del cluster de servicio de

ı́ndice, en situaciones con un alto tráfico de consultas. El proceso de resolver una consulta

utilizando P nodos se ve reflejado en la Figura 2.5: (202) las consultas llegan a la máquina

broker (204). Cada nodo 206(1) a 206(P) tiene 2 roles: fetcher y ranker. En general, el

proceso llamado fetcher puede simplemente reunir datos (por ejemplo, desde memoria

secundaria) y también puede ejecutar algunos pre-procesos. El proceso llamado ranker

recibe los resultados parciales desde el fecther y calcula la respuesta final para la consulta

(204).

En la Figura 2.5, el doble rol se ve reflejado en la linea 208. En este ejemplo, para el

proceso fetching, cada nodo (206) reúne los datos desde el ı́ndice para una consulta en

particular. Para el caso del ranking, cada nodo (206) realiza una unión (merge) de los

datos asociados a la consulta. El ranker envı́a la consulta (201) a T fetchers (212), donde

cada T trabaja de acuerdo al tipo de partición del ı́ndice. En relación al tráfico, el ranker

puede trabajar con varias consultas en paralelo en un perı́odo de tiempo.

El broker es el encargado de enviar las consultas a los nodos del cluster y recibir las

respectivas respuestas. La distribución de las consultas a través de los nodos, es mediante

heurı́sticas de balance de carga. En particular, la heurı́stica depende de la partición del

ı́ndice invertido con que se esté trabajando.

La máquina de búsqueda puede cambiar dinámicamente su modo de operación de

acuerdo al tráfico de consultas observado.

23

Modo Asincrónico (Async). Un tráfico bajo de consultas activa el modo Async.

Cada consulta es atendida por un único thread maestro encargado de resolver la

consulta. El thread maestro se puede comunicar con otros P threads esclavos; cada

uno se ubica en un nodo del cluster.

Modo Sincrónico (Sync). Un tráfico alto de consultas activa el modo Sync. Todos

los threads activos son bloqueados y solo un thread tiene el control del proceso de

consultas. En este caso los mensajes son almacenados en el buffer de todos los nodos

del cluster y enviados al comienzo de cada iteración, punto en el cual los nodos

son sincronizados. En este modo operacional, los recursos del sistema son utilizados

de mejor manera dada la forma de distribuir los threads. Se reducen los costos de

sincronización y comunicación, que son ejecutados en bloques. Se le llama superstep

al periodo que transcurre entre dos sincronizaciones en forma de barrera de los

procesos que participan en la solución de una o más consultas.

El procesamiento de una consulta aplicando el modelo round-robin, se realiza en cualquier de los modos de funcionamiento de una máquina de búsqueda. La Figura 2.6 ilustra,

para P = 2 nodos y en cada nodo T = 2 procesos o threads, el proceso iterativo de 7 consultas etiquetas como A, B, C, D, E, F y G. El proceso es distribuido a través de 2 nodos y

8 supersteps donde existe uso exclusivo de los supersteps para las operaciones de fetching

y ranking. En la figura, las consultas son procesadas secuencialmente en cada nodo. Por

ejemplo, el thread del nodo 0 procesa por completo la consulta A y, a continuación, se

otorga el quantum a la consulta B.

El mismo esquema de la Figura 2.6 puede ser usado para operar en el modo asincrónico.

La diferencia es que los periodos de ranking y fetching se van a solapar entre los procesos

o threads, pero la tendencia global de sincronización de operaciones se va a mantener.

24

Ranking

K/P

K

A

A

A

G

B

B

E

E

C

C

F

F

D

D

D

D

Proc 0

Proc 1

K

K/P

Superstep 1

2

3

4

5

6

7

8

Fetching

Figura 2.6: Procesamiento round-robin sincrónico para siete consultas.

25

Capı́tulo 3

Paralelismo Hı́brido

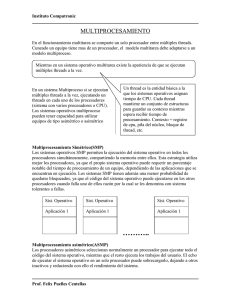

La arquitectura de software de los motores de búsqueda está compuesta de un conjunto

de servicios que son alojados en los nodos del cluster del centro de datos. La comunicación

entre servicios es vı́a paso de mensajes puesto que para alcanzar un rendimiento eficiente

es necesario asignar un servicio por nodo. Los servicios tı́picos son módulos de software

tales como servicio de broker, servicio de cache de resultados, servicio de ı́ndice y servicio de datos para soporte al ranking de documentos basado en aprendizaje automático.

Normalmente el servicio de ı́ndice está compuesto de un conjunto de P × D sub-servicios,

los cuales coinciden con el nivel P de partición del ı́ndice y el nivel D de replicación del

ı́ndice, y donde también se asigna un sub-servicio por nodo del cluster.

Cuando los nodos son procesadores multi-core se debe decidir cómo administrar los

diferentes núcleos (cores) para explotar el paralelismo disponible [1, 40, 109]. Básicamente

existen dos alternativas. La primera es la que dicta la evolución natural desde un sistema

en producción diseñado originalmente para procesadores con un solo núcleo y consiste en

alojar en cada procesador tantos sub-servicios como núcleos tenga. Cada uno de estos

sub-servicios mantiene sus propias estructuras de datos locales para alojar sus propios

ı́ndices y caches. Es decir, sistema cuyos nodos integran T núcleos, es necesario mantener

la sección del ı́ndice que le corresponde al nodo particionada en T partes. Entonces para

un cluster con P nodos encargados de procesar consultas en P particiones generales del

ı́ndice se tendrán en realidad T · P particiones. No obstante, se pueden emplear bibliotecas

de memoria compartida con el fin de mantener sólo una partición del ı́ndice en cada nodo.

La segunda alternativa consiste en intervenir la implementación de los servicios, transformándolos en sistemas con múltiples hebras de ejecución (multi-threading) [97] y asig-

26

nando cada thread a un núcleo del procesador. Esto implica un cambio importante en el

diseño del software que implementa el servicio, y por lo tanto su adopción se justifica sólo

si es posible alcanzar una mejora significativa en rendimiento.

En este capı́tulo se investiga la factibilidad de esta alternativa con respecto al rendimiento que es posible alcanzar en dos arquitecturas conocidas de procesadores multi-core.

La experimentación es realizada utilizando un método de indexación y ranking particular

pero representativo de las cargas de trabajo en este tipo de aplicaciones. El estudio se

concentra en el servicio de ı́ndice, puesto que es el componente que demanda la mayor

cantidad de cómputo en una máquina de búsqueda. La razón es que, al contrario de los

otros servicios, el tiempo de ejecución del servicio de ı́ndice es proporcional a la muestra

de la Web almacenada en la máquina de búsqueda.

También, sin pérdida de generalidad, el estudio se hace en el contexto de motores de

búsqueda Sync/Async descritos en el Capı́tulo 2. La estrategia Sync/Async fue diseñada

bajo el paradigma de P procesadores mono núcleo con memoria distribuida, y donde la

existencia de más núcleos en un nodo del cluster es tratada de manera transparente considerando que las T núcleos adicionales equivalen a nuevos procesadores hasta completar

un total de T · P procesadores mono núcleo con memoria distribuida. Es decir, se realiza

paso de mensajes incluso entre procesadores ubicados en el mismo nodo. Una contribución

de este capı́tulo es la adaptación de la estrategia Sync/Async a clusters equipados con

procesadores multicore utilizando de forma explı́cita modelos de programación basados en

memoria compartida.

Como se verá en el resto de los capı́tulos, varias de las técnicas propuestas son posibles sólo cuando la implementación de los servicios se realiza mediante multi-threading.

Por tanto, es de interés cuantificar la mejora en rendimiento que es factible alcanzar al

menos para transacciones de sólo lectura como lo es el procesamiento de consultas de

usuarios utilizando el servicio de ı́ndice presentado en este capı́tulo. Los resultados experimentales sobre dos arquitecturas diferentes constituyen una evidencia preliminar de que

la aplicación de paralelismo sincrónico por lotes (bulk-synchronous parallelism) a nivel de

procesador multi-core es una alternativa que produce mejor rendimiento que la alternativa más tradicional que consiste en desplegar sub-servicios asincrónicos en los núcleos del

procesador.

La base de software utilizada en la experimentación destinada a evaluar ambos enfoques

para el despliegue de servicios en los nodos, la constituyen las bibliotecas de comunicación

y sincronización MPI, BSPonMPI y OpenMP. Para este tipo de aplicaciones se ha observa-

27

do que tanto OpenMP como PThreads alcanzan el mismo rendimiento y se pueden utilizar

intercambiablemente. No obstante, una aplicación de producción con certeza utiliza mecanismos de más bajo nivel para la comunicación entre procesos y la coordinación entre

threads. No obstante, dada la alta granularidad del procesamiento de consultas, nuestra

conjetura es que los rendimientos alcanzados por el sistema propietario y las bibliotecas

escogidas para nuestra experimentación serán similares.

3.1.

Introducción

En el Capı́tulo 2 se comentó que para lograr un uso eficiente de los recursos de hardware asignados al procesamiento de las consultas, es conveniente variar dinámicamente

el método de procesamiento de consultas entre los modos sincrónicos y asincrónicos de

operación. A esto se le llama modos Sync/Async de operación [62] y el objetivo es poder