ANÁLISIS DE LA VARIANZA

Anuncio

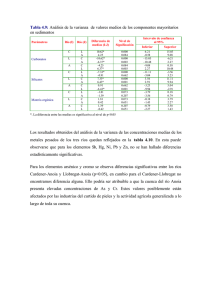

UNIDAD III:INFERENCIA ESTADÍSTICA ANÁLISIS DE LA VARIANZA TEMA 14.1.INTRODUCCIÓN 14.2.NOTACIÓN EN EL ADEVA Y MATRIZ DE DATOS 14.3.SUPUESTOS DEL ADEVA 14.4.PARTICIÓN DE LA SUMA DE CUADRADOS 14.5.PRUEBAS DE F EN EL ADEVA 14.5.1. Estadígrafo de prueba. 14.5.2. Distribución muestral del estadígrafo de prueba. 14.5.3. Valor crítico del estadígrafo de prueba. 14.6.TABLA DE ADEVA Y FÓRMULAS DE CÁLCULO 14.7.MODELO ADEVA: CASO DE CLASIFICACIÓN ÚNICA 14.8.TRANSFORMACIONES 14.9.ANÁLISIS DE RESIDUOS 14.10.ANÁLISIS DESPUÉS DEL ADEVA 14.10.1. Comparaciones múltiples de medias 14.10.2. Prueba de tukey 14.10.3. Prueba de duncan 14.1. INTRODUCCIÓN Las pruebas de hipótesis consideradas hasta ahora, primeramente se refirieron a problemas donde los datos eran proporciones o frecuencias (análisis inferencial de datos categóricos) y, luego se pasó a problemas relacionados con la media o la varianza de poblaciones donde se vieron diferentes casos: a) para una muestra, pruebas referidas a una media poblacional (H0: µ = µo) o bien a una varianza poblacional (H0: σ2 = σ2o), que requirieron aplicar la distribución en el muestreo de un estadígrafo Z o T, o bien (n-1)S2/σ 2 respectivamente y, b) para dos muestras, referidas a dos medias poblacionales (H0: µ 1= µ2 ) o bien a dos varianza poblacionales (H0: σ21 = σ22), que también requirieron aplicar la distribución en el muestreo de un estadígrafo Z o T, o bien χ2, respectivamente. A menudo interesa la comparación de más de dos poblaciones, por ejemplo esto ocurre cuando se quiere comparar el rendimiento de tres líneas de producción industrial, los resultados de cinco analistas o bien cinco métodos de determinación, el efecto de varios insecticidas en el control de pulgones, el rendimiento de veinte híbridos de maíz, etc. Con las herramientas disponibles hasta ahora, se debería proceder a efectuar todas las comparaciones posibles de las poblaciones tomadas de a pares, pero este procedimiento implicaría comparaciones que no son independientes entre sí, lo cual afectaría el nivel de significación de la prueba (en lugar del α fijado se estaría evaluando a otro nivel). Así para el caso de comparar cinco medias poblacionales, si se tuvieran datos de cinco muestras pequeñas, se recurriría a una serie de diez pruebas de t para probar lo siguiente: Ho1 : µ1 = µ2 Ho 2 : µ1 = µ3 Ho 3 : µ1 = µ4 Ho4 : µ1 = µ5 Ho5 : µ2 = µ3 Ho6 : µ2 = µ4 Ho7 : µ2 = µ5 Ho8 : µ3 = µ4 Ho9 : µ3 = µ5 Ho10 : µ4 = µ5 Es claro que tales pruebas no son independientes entre sí, condición que impacta en la probabilidad del error tipo I global de modo que en realidad, cada prueba queda asociada a un valor αi que es mayor al α fijado, tanto más cuanto mayor sea el número de pruebas de la serie. Por ejemplo, si se fija un α=0,05, los valores αi cuando se comparan 3, 4 ó 5 medias son igual, en correspondencia, a 0,14; 0,26 y 0,40 El análisis de la varianza, o resumidamente ADEVA o bien ANOVA (del inglés, analysis of variance), es una técnica que permite investigar simultáneamente k ≥ 3 medias poblaciones, mediante pruebas de hipótesis que toman la siguiente forma: H0: µ1 = µ2 = … µ j=….=µ k ; j = 1, 2, …, k H1: al menos una media es diferente Es decir, se prueba la hipótesis nula de que “todas las medias son iguales”, contrastada con la alternativa que postula “al menos una media es diferente” Los datos a los que se aplica el análisis de la varianza, pueden provenir de estudios observacionales o bien de estudios experimentales. En el primer caso, los datos son las mediciones que corresponden a muestras aleatorias tomadas de las poblaciones de interés sin modificar el estado de la naturaleza; en el segundo, los datos son las mediciones hechas en unidades experimentales que 233 Cátedra de Cálculo Estadístico y Biometría – Facultad de Ciencias Agrarias – UNCuyo / Ciclo 2013 UNIDAD III:INFERENCIA ESTADÍSTICA manifiestan la respuesta a cierto estímulo o tratamiento. Este segundo enfoque, se profundizará al desarrollar el tema diseño y análisis de experimentos. El problema más sencillo de ADEVA es el que trataremos en esta oportunidad. Es el ADEVA de clasificación única y modelo de efectos fijos. 14.2. NOTACIÓN EN EL ADEVA Y MATRIZ DE DATOS En el análisis de la varianza se acostumbra a utilizar la letra Y para representar la variable aleatoria, además se utilizan dos subíndices (i, j) de modo que el primero indica a cual unidad de la muestra corresponde la posible medida y el segundo, a que población pertenece la muestra considerada. De este modo se tiene Yij : variable aleatoria que representa la i-ésima medición tomada en la j-ésima muestra yij : el valor observado en la i-ésima unidad de la j-ésima muestra La información completa para una problemática dada puede presentarse en una tabla rectangular como la siguiente: Tabla 14.1. Tabla matricial de datos para el ADEVA (n puede o no ser constante). MUESTRAS (GRUPOS) Unidades k 1 2 ... j ... 1 ... ... 2 ... ... . . . . . . . . . . . . . . . I . . . . . . . . . . . . . . . n ... ... Total • • • … • … • • Medias • • … • … • ... ... . Total general •• Media general •• En las columnas aparece el único criterio para la clasificación de los datos, la muestra a que pertenecen y, en las filas se indican las unidades de análisis medidas, siendo yij el término genérico que representa el valor observado de la variable en la i-ésima unidad de análisis que pertenece a la j-esima muestra. En la tabla, en relación a los totales aparece la notación punto a) Total de columna, y.j : el punto reemplazando el primer subíndice, indica que se ha hecho una suma a través de todos los posibles valores de i o sea, suma a través de todas las filas (desde i=1 hasta n). b) Total general, y.. : el doble punto indica la suma a través de todas las filas (i=1,2,…,n) y de todas las columnas (j=1,2,…,k) o sea, suma de los nk datos. 14.3. SUPUESTOS DEL ADEVA En las pruebas de hipótesis para una media y dos medias, se presentaron supuestos que debían ser cumplidos para que su aplicación fuera válida. Por ejemplo, en el caso de querer probar una hipótesis del tipo Ho : µ = µo , a partir de la evidencia proporcionada por una muestra pequeña, se supuso que X− N(x; µ,σ) y, también que la muestra era aleatoria. En el ADEVA los supuestos son: 1. Supuesto de la normalidad , Yij ∼ N: Debe suponerse que los efectos debidos al azar, así como los factores no comparados, están distribuidos en forma normal. Afortunadamente, la prueba del análisis de varianza es “robusta” en relación a las desviaciones de la distribución normal (así como lo es la prueba t). Esto significa que, en tanto las distribuciones de Yij no sean extremadamente diferentes de la distribución normal, el nivel de significación de la prueba de hipótesis no resulta afectado en gran 234 Cátedra de Cálculo Estadístico y Biometría – Facultad de Ciencias Agrarias – UNCuyo / Ciclo 2013 UNIDAD III:INFERENCIA ESTADÍSTICA medida, lo que acontece sobre todo cuando se tienen muestras grandes. En la práctica suele utilizarse una gráfica de probabilidad normal para comprobar el cumplimiento de este supuesto aplicada al conjunto nk de datos (Gráfico 14.1). ∼ N(y; µj, σ): Esta suposición, afirma que la 2. Homogeneidad de la varianza (u homoscedasticidad), Y∼ varianza poblacional de las k poblaciones es igual ( = = = ⋯ = = )y además es igual a la varianza debido al error aleatorio = = = ⋯ = = ). Se necesita esta suposición con el fin de combinar o agrupar las varianzas dentro de los grupos en una sola fuente de variación “dentro del grupo (SCE). Si hay tamaños de muestras iguales en cada grupo, las inferencias basadas en la distribución F quizás no resulten seriamente afectadas por las varianzas desiguales, de otro modo, las varianzas desiguales de un grupo a otro pueden tener efectos serios sobre la obtención de inferencias hechas del análisis de varianza. Por lo tanto, desde el punto de vista de la sencillez de cálculo de la robustez y potencia, siempre que sea posible deben existir tamaños de muestra iguales en todos los grupos. En la práctica, se puede analizar el cumplimiento del supuesto a través de un análisis exploratorio gráfico o analítico (la mayor desviación típica sj resulta más de dos veces mayor a la menor desviación típica) o bien mediante algún procedimiento formal (Pruebas inferenciales de homogeneidad de varianzas). 3. Independencia. Debe suponerse independencia entre todas las observaciones. (Recuérdese que la independencia significa que el resultado de una observación experimental no afecta el resultado de cualquier otra observación). Esta suposición, se refiere a la diferencia de cada valor yij con respecto a la media de su propio grupo . Por lo general, la toma de muestras al azar (estudios observacionales) o la asignación de los tratamientos (estudios experimentales) en forma aleatoria, asegura la independencia entre los errores aleatorios de las observaciones. Con frecuencia no se cumple esta suposición, es decir, los errores están correlacionados, cuando los datos se recopilan a lo largo de un periodo, porque las observaciones hechas en puntos cercanos en el tiempo con frecuencia resultan más parecidas que las obtenidas en tiempos muy diferentes. Considérese por ejemplo la temperatura registrada cada día durante un mes. La temperatura de cualquier día determinado es probable que se parezca a la del día anterior, pero menos probable que se aproxime a la temperatura registrada varias semanas después. Las desviaciones de esta suposición pueden afectar, de modo serio, las inferencias del análisis de varianza. En general, cuando no se cumplen las suposiciones de normalidad ni la de homogeneidad, se puede usar una “transformación de datos” o bien recurrir a la alternativa de un ADEVA no paramétrico. Ejemplo ilustrativo: Sean los siguientes datos MUESTRAS (GRUPOS) Unidades 1 2 3 4 5 6 • Medias 1 2 3 4 655 788 734 721 679 699 789 772 787 686 732 775 737 639 696 672 717 727 535 629 542 559 587 520 713 757 698 562 Media general •• = 682 La prueba de la hipótesis nula H0 : µ1 = µ2 = µ3 = µ4, nos lleva a realizar, en primer lugar, un análisis exploratorio de los datos muestrales, con el siguiente resultado: 1) El gráfico 14.2 muestra un diagrama de cajas comparativo para los datos de las cuatro muestras. Se observa un traslapamiento bastante notable en el caso de las muestras 1, 2 y 3, en tanto que la cuarta muestra se presenta en posición marcadamente diferente y en correspondencia a valores bajos de la variable observada. Esto nos hace sospechar, que existe la posibilidad de que la hipótesis nula propuesta resulte rechazada2) Cumplimiento de los supuestos del ADEVA: a) Es razonable suponer que se cumple el supuesto de normalidad: en el gráfico 14.1, la tendencia lineal del patrón de datos se ajusta bien a una recta trazada a 45º. b) Es razonable suponer homogeneidad de las varianzas: en el gráfico 14.2 no se observan diferencias importantes en relación a la variabilidad, lo que también es confirmado por el cálculo de las desviaciones típicas muestrales (s1= 46,57; s2= 40,35; s3= 37,11; s4= 40,04; siendo s mayor / s menor igual a 1,26). 235 Cátedra de Cálculo Estadístico y Biometría – Facultad de Ciencias Agrarias – UNCuyo / Ciclo 2013 Desviación UNIDAD III:INFERENCIA ESTADÍSTICA -2,10 -1,22 -0,33 0,55 1,44 Percentil z Gráfico 14.1 1 2 3 4 Muestras Gráfico 14.2 14.4. PARTICIÓN DE LA SUMA DE CUADRADOS El procedimiento del análisis de varianza esencialmente consiste en discriminar o particionar la variación general de los datos, suma de cuadrados de desvíos general (desvíos de los valores observados respecto a la media general o gran media) indicada como SCG, en dos fuentes de variación: la variación ENTRE grupos (SCT) y la variación DENTRO de grupos (SCE). Variación total o general = variación ENTRE grupos + variación DENTRO de grupos SCG = SCT + SCE A los efectos de facilitar la interpretación, introduciremos un ejemplo. Ejemplo 14.1: Consideremos una planta, donde se fabrica y envasa cereal en cajas de 368 gramos, y que el gerente de producción piensa sustituir una máquina antigua por problemas de bajo rendimiento. Supóngase que en el mercado encuentra tres máquinas que pueden mejorar su producción y que frente a esto, el gerente piensa que no todas las máquinas llenarán las cajas con igual tiempo medio (o que al menos alguna de las tres tendrá una media de llenado diferente). Para tomar la decisión de compra, el gerente solicita a los tres proveedores datos de pruebas de llenado con sus respectivos modelos de máquinas para las condiciones de su proceso. Se desprende, que la intención del gerente es someter a prueba la siguiente hipótesis: H0 : µ1 = µ2 = µ3 esperando que su rechazo, lo lleve a confirmar su hipótesis de investigación que se corresponde con la hipótesis alternativa H1 : al menos dos medias son diferentes La interpretación gráfica de estas hipótesis es la siguiente: Gráfico 14.3.a.Gráfico de poblaciones, cuando Ho es verdadera y se satisfacen las suposiciones Gráfico 14.3.b. Gráfico de las poblaciones, cuando se cumplen las suposiciones de varianzas iguales y poblaciones con distribución normal, pero Ho es falsa debido a que ninguna de las medias de las poblaciones es igual a otra (uno de los posibles casos contemplados por la H1) Sigamos suponiendo que el gerente, a partir de los informes recibidos, toma una muestra aleatoria de cinco tiempos de llenado (en segundos) para cada caso, con el resultado de tabla 14.2. Tabla 14.2: Tiempo (en segundos) para envasar una caja de cereal Total Medias Máq. 1 25,40 26,31 24,10 23,74 25,10 y.1 = 124,65 . = 24,93 Máq. 2 23,40 21,80 23,50 22,75 21,60 y.2 =113,05 . = 22,61 Máq. 3 20,00 22,20 19,75 20,26 20,40 y.3 =102,95 . = 20,59 236 Cátedra de Cálculo Estadístico y Biometría – Facultad de Ciencias Agrarias – UNCuyo / Ciclo 2013 UNIDAD III:INFERENCIA ESTADÍSTICA Media general y •• = 340,31 = 22,71 segundos 3 x5 Ahora, queda demostrar si los datos muestrales aportan evidencia suficiente para rechazar la hipótesis nula, de igualdad entre las medias poblacionales µ1, µ2 y µ3. Un análisis gráfico exploratorio de estos datos, a través de un puntigrama múltiple (gráfico 14.4), muestra aparentemente, que las tres medias muestrales difieren entre si, lo cual llevaría a concluir que las poblaciones estudiadas tienen distintos valores de medias. Pero, a esta conclusión, no se llegará en forma directa por comparación de las medias, sino en forma indirecta analizando la variabilidad que presentan los datos muestrales. Para esto, se deben reconocer tres tipos de desviaciones vinculadas a las tres sumas de cuadrados de desvíos dadas (SCG, SCT y SCE) Desvíos en el ADEVA de clasificación única Definición Desvío entre un valor observado y la media general Desvío entre un valor de media grupal y la media general Desvío entre un valor observado para un grupo y la media del grupo Nombre Desvío general Desvío entre grupos Desvío dentro de grupos Fórmula y ij − y •• y • j − y •• y ij − y • j Llevado a la práctica, se podrían obtener en correspondencia, los siguientes valores de desvíos y11 − y •• = 25,40 − 22,71 = 2,69 segundos y •1 − y •• = 24,93 − 22,71 = 2,22 segundos y11 − y •1 = 25,40 − 24,93 = 0,47 segundos Del análisis de los desvíos, resultaría que la variabilidad dentro de estas tres muestras es relativamente pequeña, en relación a la variabilidad que existe entre los grupos. yij 27 26 25 y • 1 =24,93 24 y• 1 - y• 2 =2,32 23 22 y • 1 - y• 3 =4,34 y• 2 =22,61 Y•• y• 2 - y• 3 =2,02 21 y•3 =20,59 20 19 18 0 1 2 3 máquina s 4 Gráfico 14.4. Distribución de los datos (en segundos) de las tres máquinas Para formalizar el concepto de partición de sumas de cuadrados, primeramente se trabaja con el concepto de la varianza muestral, es decir, s = 2 sc ν ∑ ( y − y) = 2 n −1 En el ADEVA, se tienen k grupos o muestras, y si se supone que las medias poblacionales de los k grupos son iguales, se puede medir la variación total, o suma total de los cuadrados de desvíos (SCG), sumando las diferencias elevadas al cuadrado entre cada observación (tiempo) y una media global sobre la base de todas las observaciones. Esto es la variación total y se calcularía como: 237 Cátedra de Cálculo Estadístico y Biometría – Facultad de Ciencias Agrarias – UNCuyo / Ciclo 2013 UNIDAD III:INFERENCIA ESTADÍSTICA Variación total o suma total de los cuadrados (SCG) nj k SCG = ∑∑ ( y ij − y•• ) 2 ; j =1 i =1 donde k : número de grupos nj : nº de observaciones en el grupo j yij: i-ésima observación en el grupo j k n ∑∑ Donde y •• = j =1 i =1 n y ij k siendo n el nº total de observaciones, ∑n j =n j =1 La variación total mide el cuadrado de la suma de las diferencias, entre cada valor observado de la variable, yij , y la media global (gran media o media general) y.. . Para el ejemplo considerado, la variación total que presentan los datos es SCG= 58,2172, la cual puede ser explicada a través de los componentes que se indicaron en la fórmula fundamental del ADEVA (partición de la SCG). Variación ENTRE grupos (SCT): involucra las diferencias entre las medias de grupo. Parte de esta variación se debe al efecto de encontrarse en grupos diferentes (es decir, la hipótesis Ho no es cierta), ya que es probable que haya diferencias entre las medias del grupo. La variabilidad entre los trabajadores de cada grupo, hará que sean diferentes las medias de la máquinas µ.j, precisamente porque se tienen k poblaciones diferentes. Una razón de la variación entre los resultados es que un trato diferente a las personas (en este caso al proporcionarles máquinas diferentes) afecta su productividad. Esto explicaría por qué los grupos tienen medias diferentes: cuanto mayor sea el efecto del tratamiento, mayor será la variación que se encontrará en las medias de grupos. La variación ENTRE los grupos, SCT, se mide a través de la suma de las diferencias entre la media de la muestra de cada grupoy.j y la gran mediay.., al cuadrado, ponderada por el tamaño de la muestra n, en cada grupo. Se puede calcular como: k SCT = ∑ n j ( y• j − y•• ) 2 ; j =1 donde k: es el número de grupos nj : es el número de observaciones en el grupo j y • j : es la media muestral del grupo j y •• : es la gran media Variación DENTRO de grupos (SCE): Hay otra razón para la variabilidad de los resultados: las personas son naturalmente variables, tanto si se les trata o no en igual forma. Por lo tanto, aún dentro de un grupo en particular, donde todos reciban el mismo tratamiento (es decir usan la misma máquina) existe variabilidad. Esta variabilidad se conoce como variación dentro del grupo. Cuando la hipótesis nula es cierta, entonces la variación entre grupos estimará la variabilidad de la población al igual que la variación dentro del grupo. Pero si la hipótesis nula es falsa, entonces la variación entre los grupos será mayor. Este hecho forma la base para la prueba estadística de las diferencias de grupos. La variación DENTRO del grupo, llamada también suma de cuadrados internos (SCE), mide la diferencia entre cada valor observado y la media de su propio grupo y acumula los cuadrados de estas diferencias de todos los grupos. La variación dentro del grupo se puede calcular como k nj SCE = ∑∑ ( yij − y• j ) 2 ; j =1 i =1 donde k : es el número de grupos nj : es el número de observaciones en el grupo j yij : es la i-ésima observación en el grupo j y. j : es la media del grupo j, 238 Cátedra de Cálculo Estadístico y Biometría – Facultad de Ciencias Agrarias – UNCuyo / Ciclo 2013 UNIDAD III:INFERENCIA ESTADÍSTICA Se supone que los errores son independientes y que se encuentran normalmente distribuidos con medias cero y varianzas iguales. En otras palabras,εij∼ N(0,σ2) para toda i y j. La suposición sobre los τ j depende de cómo considere el investigador los niveles del factor. Si el investigador está interesado en lo que le pasa a la variable Y, sólo para ciertos grupos que son elegidos de antemano, entonces el modelo ADEVA se conoce como modelo de efectos fijos y las inferencias estadísticas con respecto a los efectos pertenecen, en forma exclusiva, a los niveles seleccionados. Por otro lado, si los grupos empleados han sido seleccionados al azar, a partir de una población de todos los posibles niveles, el modelo ADEVA se conoce como modelo de efectos aleatorios , y las inferencias estadísticas con respecto a los niveles de un factor pertenecen a la población de niveles. Los parámetros µ1 ; µ 2 ;...; µ k y la media general µ no son conocidos, pero pueden estimarse con base en las observaciones de las k muestras aleatorias, como: Media del j-ésimo grupo: nj Y . j = ∑ Yij j = 1,2,..., k , i =1 Y.j = Y.j / nj j = 1,2,..., k Media general: n Y .. = ∑ k k ∑ Yij , n = ∑nj = j =1 , Y .. = Y .. / nk De nuevo, se emplea la notación de punto para indicar que la suma se lleva a cabo sobre el correspondiente subíndice. En particular, Y.j es la suma de las nj observaciones en el j-ésimo tratamiento, Y..j es la media de la muestra del j-ésimo tratamiento, Y.. es la suma de todas las nk observaciones y Y.. es la media de la muestra de todas las observaciones Para determinar una estadística de prueba apropiada, supóngase que se toma el cuadrado de ambos miembros de Yij - Y.. = (Y..j - Y.. ) + (Yij - Y..j ) y se suman sobre todos los i y j, obteniéndose: k nj ∑∑ (Y ij k nj k nj k nj − Y ..) = ∑∑ (Y .i − Y ..) + 2∑∑ (Y . j − Y ..)(Yij − Y . j ) + ∑∑ (Y i j − Y . j ) 2 2 2 j =1 i =1 j =1 i =1 j =1 i =1 j =1 i =1 Pero k nj ( Y . − Y ..)( Y − Y . ) = ( Y . − Y ..) ∑∑ ∑ i ij j j ∑ (Yij − Y . j ) j =1 i =1 i =1 i =1 k nj nj = ∑ (Y . j − Y ..) ∑ (Yij − n j Y . j ) i =1 i =1 k = 0, dado que ∑ nj Y = Y. j = n j Y. j i =1 ij Como resultado se tiene la Ecuación fundamental del análisis de la varianza k nj ∑∑ (Y ij j =1 i =1 k nj k nj − Y•• ) = ∑∑ (Y • i − Y•• ) + ∑∑ (Yij − Y• j ) 2 2 2 j =1 i =1 j =1 i =1 239 Cátedra de Cálculo Estadístico y Biometría – Facultad de Ciencias Agrarias – UNCuyo / Ciclo 2013 UNIDAD III:INFERENCIA ESTADÍSTICA Para el ejemplo 3 5 SCG = ∑∑ ( yij − 22,71) 2 3 [ ] SCT = ∑ 5( y• j − y•• ) = 5 (24,93 − 22,71) 2 + (22,61 − 22,71) 2 + (20,59 − 22,71) 2 = 47,164 2 3 5 5 5 5 SCE = ∑∑ ( yij − y• j ) 2 = ∑ ( y ij − 24,93) 2 + ∑ ( yij − 22,61) 2 + ∑ yij − 20,59) 2 = 11,0532 Luego, se comprueba que: SCG = SCT + SCE 58.2172 = 47.164 + 11.0532 Dado que siempre habrá diferencias en las medias muestrales para las tres máquinas. La pregunta a contestar es, si los resultados arrojados aportan la evidencia suficiente para que el gerente de producción llegue a la conclusión de que los promedios poblacionales no son todos iguales. 14.5. PRUEBAS DE F EN EL ADEVA 14.5.1. Estadígrafo de prueba. El procedimiento de prueba se basa en la comparación de una medida de la variabilidad entre las muestras, el cuadrado medio entre o cuadrado medio de tratamientos (CMT), con una medida de la variabilidad dentro de las muestras, el cuadrado medio dentro o cuadrado medio del error (CME). Los cuadrados medios son estadígrafos que se calculan como un cociente entre una suma de cuadrados de desvíos y los grados de libertad correspondientes. Estadígrafo de prueba F F= CMT SCT / ν T = CME SCE / ν E a) Si Ho es verdadera, todas las medias poblacionales son iguales, en las muestras las medias resultarán aproximadas al promedio general, por tanto los desvíos y. j − y.. dan valores ( ) parecidos y la SCT así como el CMT toman valores relativamente pequeños. Esto significa que E(CMT) = E(CME) = σ2, es decir, que F=1. b) Contrariamente si, Ho no es verdadera, algunas medias poblacionales (o por lo menos una) resultarán alejadas del promedio general, hay mayor dispersión, por tanto el CMT toma un valor relativamente grande. Esto significa que E(CME) = σ2, pero E(CMT) > E(CME), por tanto F>1. 14.5.2. Distribución muestral del estadígrafo de prueba. Bajo Ho verdadera, el estadígrafo razón F sigue una distribución Fα ;ν t ;ν e , esto es el estadígrafo es una variable aleatoria que se distribuye siguiendo a la distribución F para un nivel de significancia α y los grados de libertad que corresponden al numerador y denominador del estadígrafo. ν numerador = ν t = k − 1 ; ν deno min ador = ν e = n k − k En el primer caso, νnumerador , se pierde un grado de libertad porque existen k desvíos para las medias, y. j − y.. , y para calcularlos se necesita estimar el valor de la µ.. o media general. En el ( ) ( ) segundo, νdenominador , se pierden k grados de libertad porque existen nk desvíos para el error, yij − y. j , y para calcularlos se necesita estimar el valor de las k medias poblacionales µ.j. 14.5.3. Valor crítico del estadígrafo de prueba. La distribución F, en realidad es una familia de distribuciones. En la tabla de la función de distribución de F, se entra por columnas con los grados de libertad para el CM entre las medias grupales o CM del numerador y, por filas con los grados de libertad para el CM dentro de los grupos. Por lo general estos grados de libertad, se conocen, respectivamente, como ν1 o grados de libertad para el CM mayor (ν1 = k - 1 ) y, como ν2 o grados de libertad para el CM menor (ν2 = nk – k), por una interpretación lógica de su significado y por tanto de su valor esperado. 240 Cátedra de Cálculo Estadístico y Biometría – Facultad de Ciencias Agrarias – UNCuyo / Ciclo 2013 UNIDAD III:INFERENCIA ESTADÍSTICA f(F) Figura: La regla de decisión es: rechazar la hipótesis nula, de que no hay diferencia entre las medias poblacionales de los grupos, al nivel de significación α si 1-α α F(α ,ν1 ,ν2) < F(α ,ν1 ,ν2), es el valor crítico de la distribución F con k – 1 y nk - k grados de libertad o percentil F. F 0 Región de rechazo Región de aceptación CMT CME donde , 0 < F < +∞ Regiones de rechazo y de no rechazo, para la prueba de F en el análisis de varianza Si se decidió utilizar un nivel de significación de 0.01, el valor crítico de la distribución F resulta F(0,01; 2, 12) = 6.93. Este valor se encuentra tabularmente como se muestra a continuación. Tabla de la función de distribución F. Obtención del valor crítico de F(0,01; 2, 12). Denominador df2 6 7 8 9 10 11 12 13 Numerador, df1 1 2 3 13,75 10,92 9,78 12,25 9,55 8,45 11,26 8,65 7,59 10,56 8,02 6,99 10,04 7,56 6,55 9,65 7,21 6,22 9,33 6,93 5,95 9,07 6,70 5,74 4 9,15 7,85 7,01 6,42 5,99 5,67 5,41 5,21 5 8,75 7,46 6,63 6,06 5,64 5,32 5,06 4,86 6 8,47 7,19 6,37 5,80 5,39 5,07 4,82 4,62 7 8,26 6,99 6,18 5,61 5,20 4,89 4,64 4,44 8 8,10 6,84 6,03 5,47 5,06 4,74 4,50 4,30 9 7,98 6,72 5,91 5,35 4,94 4,63 4,39 4,19 10 7,87 6,62 5,81 5,26 4,85 4,54 4,30 4,10 12 7,72 6,47 5,67 5,11 4,71 4,40 4,16 3,96 Por lo tanto, la regla de decisión sería rechazar la hipótesis nula (H0 : µ1 = µ2 = µ3 ) si la F calculada es igual, o excede a 6.93. f(F) Regiones de rechazo y de no rechazo para el análisis de varianza al nivel de significancia 0,01 con 2 y 12 grados de libertad. 0.01 α= 1-α F 0 F(α; 2,12) = 6,93 Volviendo al estudio del proceso productivo de cereales en caja , puesto que SCT = 47,164, con νt = 3 - 1, y SCE = 11,0532 con νe = (5x3)-3 , se tiene: CMT = 23,582 y CME = 0,9211. Luego, el valor muestral del estadígrafo de prueba es Fm = CMT 23,582 = = 25,60 CME 0,9211 Dado que Fm > F(0,01; 2, 12) , ya que 25.60 > 6.93, la decisión estadística es rechazar la hipótesis nula. Así el gerente de producción puede concluir que al nivel de significancia considerado, hay una diferencia importante en el tiempo promedio para terminar un trabajo (al menos una media es diferente de otra). 14.6. TABLA DE ADEVA Y FÓRMULAS DE CÁLCULO Por conveniencia, se utilizará una tabla denominada tabla de análisis de la varianza para mostrar las sumas de cuadrados y otros datos que requieren los cálculos restantes y además sirve para presentar los resultados finales del análisis. La estructura de tal tabla se muestra a continuación 241 Cátedra de Cálculo Estadístico y Biometría – Facultad de Ciencias Agrarias – UNCuyo / Ciclo 2013 UNIDAD III:INFERENCIA ESTADÍSTICA Tabla 14.3 Tabla de análisis de varianza para un ADEVA con un criterio de clasificación. Fuente de variación Total SC k n ∑∑ y 2 j =1 i =1 Grupos n y2. j i =1 nj ∑ Error ij Gl CM Estadígrafo F y 2 .. − nk F= CMT/CME nk -1 y 2 .. − nk y 2 .. − nk k -1 n y2. j i =1 nj ∑ nk - k Por diferencia ( k − 1) SCE/(nk-k) El término común que aparece como sustraendo en las sumas de cuadrados para el total y los grupos, recibe el nombre de factor de corrección (C), entonces: Factor de corrección C= y 2 .. nk El cálculo de las cantidades que aparecen en la ecuación fundamental del ADEVA puede hacerse en forma fácil mediante el empleo de cualquier software estadístico. Para llevar a cabo el cálculo a mano, las sumas de los cuadrados deben calcularse mediante la utilización del procedimiento abreviado, que es el que se muestra en la tabla 14.3 La SCE mide la cantidad de variación en las observaciones debida a un error aleatorio. Si todas las observaciones que se encuentran dentro de un mismo tratamiento son las mismas, y si este hecho es cierto para todos los k tratamientos, entonces SCE = 0. De acuerdo con lo anterior, entre más grande es SCE, mayor es la variación en las observaciones que puede atribuirse a un error aleatorio. SCT, mide la extensión de la variación, en las observaciones, que se debe a las diferencias entre los tratamientos. Si todas las medias de los tratamientos son iguales entre sí, entonces SCT = 0. De esta forma, entre más grande es el valor de SCT, mayor es la diferencia que existe entre las medias de los tratamientos y la media global. Los grados de libertad se obtienen al separar la suma total de cuadros. SCG tiene nk- 1 grados de libertad debido a que se pierde un grado de libertad al ser necesario que la suma de las desviaciones (Yij=Y..) Para toda k y j sea cero. La suma de los cuadrados de los tratamientos, SCT, ∑ tiene k - 1 grados de libertad debido a que se impone la restricción desviaciones (Y.j -Y.. ). Esta restricción surge del hecho de que ∑ k i =1 k i =1 n j (Y. j − Y ..) = 0 para las k n jτ j = 0 .Entonces, con base en (11), el número de grados de libertad para SCE será igual a la diferencia entre el número de grados de libertad para SCG y SCT, gl(SCE) = gl(SCG) - gl(SCT) = (nk – 1) - (k - 1) = nk - k. Una suma de cuadrados dividido entre sus grados de libertad da origen a lo que se conoce como cuadrado medio. De acuerdo con lo anterior, el cuadrado medio del tratamiento es CMT = SCT/(k - 1), y el cuadrado medio del error es CME = SCE/(nk - k) Ahora se puede argumentar que, dado que SCT/σ2 y SCE/σ2 son dos variables aleatorias independientes Ji-cuadrada con k - 1 y nk - k grados de libertad, respectivamente, entonces el cociente CMT/CME tiene una distribución F con k - 1 y nk - k grados de libertad. Este cociente es la estadística apropiada para probar la hipótesis nula H0 : τj =0 Dado que E(CMT) = σ2, bajo H0, tanto CME como CMT, son estimadores no sesgados de la varianza del error. Pero si la hipótesis nula no es de cierta, CMT, tiende generalmente a ser mayor que CME, dado que el término ∑ nτ j 2 j será positivo. En otras palabras, entre más grande sea la diferencia entre las medias de los tratamientos y la media global, mayor será CMT. Pero una ocurrencia de este 242 Cátedra de Cálculo Estadístico y Biometría – Facultad de Ciencias Agrarias – UNCuyo / Ciclo 2013 UNIDAD III:INFERENCIA ESTADÍSTICA tipo sugiere que las medias de los k tratamientos no son todas iguales entre sí y de esta forma debe rechazarse la hipótesis nula. De acuerdo con lo anterior, la hipótesis nula será rechazada cuando el valor del cociente 12, se encuentre dentro de una región crítica superior de tamaño α. k nj ∑∑ (Y . j − Y ..) 2 /( k − 1) j =1 i =1 F= k nj ∑∑ (Y ij − Y . j ) 2 /( nk − k ) j =1 i =1 14.7. MODELO ADEVA: CASO DE CLASIFICACIÓN ÚNICA Bajo hipótesis nula cierta, el modelo que explica el comportamiento de la variable a observar es : Yij = µ + ε ij ; j = 1,2, ..., k e i = 1,2, ..., Nj Según este modelo, el valor de yij está formado por la suma de dos componentes o efectos: un efecto común (µ) y un efecto aleatorio (εij). Este modelo se conoce como modelo de media. Esto es, en términos de este modelo, existen influencias sobre la variable a medir que son inexplicables (o sea, “influencias aleatorias”). Una observación resulta igual al valor promedio general de energía de los sistemas de calentamiento para todos los k niveles de aislamiento térmico y cualquier desviación se debe a un error aleatorio. El error aleatorio, denotado por el símbolo εij (ε es la letra griega épsilon) afecta a cada una de las posibles observaciones, y se define como εij = Yij - µ .. Si la hipótesis nula se rechaza, el modelo es otro. Existirá una diferencia entre la media de la jésima población o grupo (µj) y la media general (µ) que se puede atribuirse a lo que se llama un efecto del grupo o muestra. A este efecto lo denotaremos por τj( τ es la letra griega tau), de modo que τ j = µj − µ o bien µj =τ j + µ para j = 1,2, ..., k. Con base a esto, puede formularse el modelo ADEVA : Modelo ANOVA de clasificación única: Yij = µ + τ j + ε ij ; j = 1,2, ..., k e i = 1,2, ..., nj en donde Yij es el i-ésimo valor que se espera observar en el j-ésimo grupo, µ es la media sobre todas las k poblaciones, τ j es el efecto sobre la respuesta debido al j-ésimo grupo y εi es el error experimental para la i-ésima observación bajo el j-ésimo grupo Según este modelo, el valor de yij está formado por la suma de tres componentes o efectos: un efecto común (µ), un efecto del j-ésimo grupo ( τ j ) y un efecto aleatorio (εij). 14.8. TRANSFORMACIONES En la vida real, no se conoce con certeza si se cumplen las suposiciones de normalidad y de una varianza común. Por lo tanto, tenemos que saber cuándo las pruebas de ADEVA y los intervalos de confianza tienen las propiedades teóricas que esperamos. La falta de normalidad no afecta seriamente la metodología mientras las distribuciones poblacionales no sean demasiado sesgadas. Si las varianzas poblacionales no difieren mucho y los tamaños muestrales son iguales, las propiedades de las pruebas estadísticas y de los intervalos de confianza serán aproximadamente las mismas que si las suposiciones fueran satisfechas. Si las varianzas poblacionales difieren sustancialmente, podemos transformar los datos antes de realizar el ADEVA. Por ejemplo, una manera de transformar los datos es sacar la raíz cuadrada de cada valor de y. O podríamos tomar el logaritmo de cada valor de y. La transformación que hay que utilizar depende del tipo de datos involucrados en el experimento. Una vez transformados los datos se realiza el ADEVA. 243 Cátedra de Cálculo Estadístico y Biometría – Facultad de Ciencias Agrarias – UNCuyo / Ciclo 2013 UNIDAD III:INFERENCIA ESTADÍSTICA Observación: Los resultados de las pruebas para diferencias en medias de tratamientos transformados, log (y), se basan en la comparación de medias geométricas. Los tipos de datos más comunes que incumplen las suposiciones del análisis de varianza, son los datos donde “y” representa el número de ocurrencias de algún evento o donde y es una proporción muestral (o porcentaje). Datos enumerativos se generan a menudo por una variable aleatoria y que posee una distribución de Poisson. Como se explicó oportunamente, la varianza de una variable aleatoria de Poisson es igual a su media (es decir σ2=µ). Por lo tanto, las varianzas de poblaciones de datos de Poisson, variarán probablemente de un tratamiento a otro. Las varianzas de proporciones muestrales, obtenidas de experimentos binomiales, también variarán con su media. Así, si y es una proporción muestral, el valor medio de la proporción muestral es p, y su varianza σ2 = p (1 − p ) n Una fórmula para transformar los datos tipo Poisson, para que las diferentes poblaciones de tratamientos tengan aproximadamente la misma varianza, es y* = y o bien, cuando se tienen valores cero y* = y + 1/ 2 donde y es la respuesta original, e y* es la respuesta transformada. El siguiente ejemplo ilustrará el procedimiento. En la discusión anterior explicamos cómo transformar conteos de Poisson y proporciones binomiales para que satisfagan las suposiciones de un análisis de varianza. Se pueden desarrollar transformaciones para otro tipo de datos donde la varianza σ 2 de una población es alguna función de la media poblacional µ. El procedimiento para determinar transformaciones apropiadas para una relación específica entre σ2 y µ se explica en numerosos textos (Ver Steel-Torrie). Como conclusión, el uso de una transformación tiene sus desventajas. Muchas veces es difícil hacer una interpretación práctica de la variable transformada y las medias de tratamientos. Por consiguiente, muchos estadísticos no usan las transformaciones, a no ser que existan evidencias que indiquen diferencias tangibles entre las varianzas de las poblaciones de los tratamientos. El siguiente recuadro da transformaciones que son de utilidad. Relación entre la varianza y la media de una población Aplicación Transformación σ2 = µ Datos de una variable Poisson y* = y y* = y + 1/ 2 (cuando hay valores cero) σ 2 = µ (1 − µ ), (0 < µ < 1) σ 2 = µ2 Datos: Proporciones binomiales con tamaños muestrales iguales Datos: porcentajes Varianzas muestrales para datos cuantitativos: Tamaños muestrales iguales y falta de homocedasticidad y* = sen −1 y (arcoseno) y* = ln y y* = log y 14.9. ANÁLISIS DE RESIDUOS Una forma sencilla y útil para detectar la discrepancia con el modelo propuesto se basa en un análisis de residuos. Un residuo es un estimador del error aleatorio εij. Dado que εij = yij - µj, El residuo correspondiente denotado por eij, se define como eij = yij − y. j donde j = 1, 2, ..., k, i = 1, 2, ..., nj. 244 Cátedra de Cálculo Estadístico y Biometría – Facultad de Ciencias Agrarias – UNCuyo / Ciclo 2013 UNIDAD III:INFERENCIA ESTADÍSTICA Los residuos no son estimados en el sentido de estimación de parámetros, sino como estimadores de los valores de las variables aleatorias no observables εij con base en los estimadores y. j para las k medias de población. Si es válida la suposición de que los errores aleatorios tienen las mismas varianzas para todos los niveles de k, entonces una gráfica de los residuos de cada tratamiento no revelará ninguna diferencia apreciable en la dispersión de los residuos alrededor del cero. Si esta dispersión es notablemente diferente para algunos tratamientos, entonces es posible que las varianzas no sean iguales para todos los tratamientos. Para normalizar la escala de magnitudes de los residuos es preferible emplear los residuos estandarizados e * ij = eij CME . Entonces, dado que por hipótesis los errores aleatorios se encuentran normalmente distribuidos, un residuo estandarizado rara vez se encontrará más allá de un intervalo de +3. Se ilustrará el análisis de residuos empleando los datos de tabla 14.4. Tabla 14.4. Residuos estandarizados. 6 8 10 0.58 -0.15 -0.77 -0.96 1.00 0.77 0.96 -0.54 0 -0.58 -0.92 0.62 4 -1.00 0.54 2.08 -1.39 -0.23 12 0.39 -0.77 -0.39 0.77 1.16 -1.16 El gráfico 14.5 ilustra los residuos estandarizados para cada tratamiento. Se observa que no existe ninguna diferencia notable en la dispersión para cada uno de los cinco tratamientos excepto para uno de los residuos del primer tratamiento. De acuerdo con lo anterior, parece que la hipótesis de que las varianzas de los cinco tratamientos son las mismas, es razonable en este caso. También se encuentran disponibles en la literatura estadística procedimientos formales para verificar la hipótesis de igualdad entre las k varianzas. Dos de los usados con más frecuencia son la prueba de Bartlett y la prueba de Hartley. Residuos estandarizados 3 2 1 0 -1 -2 0 2 4 6 8 10 12 14 Espesor del aislamiento del techo Gráfico 14.5. Gráfica de los residuos estandarizados para los cinco tratamientos del ejemplo. Si las varianzas de todos los tratamientos no son iguales entre sí, puede aumentarse el tamaño de la región crítica de la estadística F para el caso de efectos fijos; pero, este efecto puede minimizarse mediante el empleo de muestras de igual tamaño para cada tratamiento. En otras palabras, en el análisis de varianza, la estadística F también es más robusta ante varianzas desiguales siempre y cuando los tamaños de la muestra de los tratamientos sean iguales. La suposición crucial en el desarrollo del análisis de varianza es que los errores aleatorios son independientes. Si los errores son interdependientes, el tamaño real de la región crítica puede ser, en forma substancial, más grande (cinco o más veces) que lo supuesto. 14.10. ANÁLISIS DESPUÉS DEL ADEVA 14.10.1. Comparaciones múltiples de medias El análisis de varianza es un procedimiento poderoso para probar la homogeneidad de un conjunto de medias. Sin embargo, si se rechaza la hipótesis nula y se acepta la alternativa planteada (lo que significa que no todas son iguales) aún no se sabe cuáles de las medias poblacionales son iguales y cuáles diferentes. Se ha demostrado que un contraste simple (es decir, una comparación de dos medias) puede llevarse a cabo a través de una prueba F, una prueba t o mediante el cálculo de un intervalo de confianza para la diferencia entre dos medias. Sin embargo, se presentan serias dificultades cuando el analista intenta realizar muchas o todas las comparaciones pareadas posibles. Para el caso de k 245 Cátedra de Cálculo Estadístico y Biometría – Facultad de Ciencias Agrarias – UNCuyo / Ciclo 2013 UNIDAD III:INFERENCIA ESTADÍSTICA medias, habrá, por supuesto, r = k(k-1)/2 posibles comparaciones pareadas. Al suponer comparaciones independientes, la tasa de error experimento-juicio (es decir, la probabilidad del rechazo equivocado de al menos una de las hipótesis) está dada por 1 - (1 - α) r, donde α es la probabilidad seleccionada del error tipo I para una comparación específica y r el número de comparaciones entre muestras. Es evidente que esta medida del error tipo I del experimento-juicio puede ser bastante grande. Por ejemplo, incluso si sólo existen seis comparaciones, póngase el caso de 4 medias, y α = 0.05, la tasa experimento-juicio es: 1 - (0.95)6 ≅ 0.26 Con la tarea de probar muchas comparaciones pareadas por lo común se requiere hacer el contraste efectivo en una sola comparación más conservadora. Esto es, mediante el enfoque del intervalo de confianza, los intervalos de confianza serían mucho más amplios que el intervalo obtenido a partir de + tα/2 2CME utilizado en el caso de una sola comparación. n 14.10.2. Prueba de Tukey Existen varios métodos estándar para realizar comparaciones pareadas que permitan sustentar la credibilidad de la tasa de error tipo I. Se presentarán y ejemplificarán dos de ellos en esta sección. El primero, llamado procedimiento de Tukey, permite la formación de intervalos de confianza del 100(1-α)% simultáneos para todas las comparaciones pareadas. El método se basa en la distribución del rango estudentizado. El punto percentil apropiado es un valor que se encuentra en tabla de rangos estudentizados q (α, k, νe). El estadígrafo de prueba es DHS= q(α, k, νe) CME , donde DHS es la diferencia honestamente n significativa. El método de comparaciones pareadas por el procedimiento de Tukey implica encontrar una diferencia significativa entre las medias µj y µk , lo que ocurre si y k − y j excede q(α, k, νe) CME n El procedimiento de Tukey se ejemplifica con facilidad. Considérese un ejemplo hipotético en el cual se tienen seis tratamientos en un diseño completamente aleatorizado de un solo factor con 5 observaciones por tratamiento. Supóngase que el cuadrado medio del error que se toma de la tabla de análisis de varianza es s2 = 2.45 (24 grados de libertad). Las medias muestrales están dadas por (en orden ascendente) y2 14.50 y5 16.75 y1 19.84 y3 21.12 y6 22.90 y4 23.20 Con α = 0.05 el valor de q(0.05, 6, 24) = 4.37. Entonces todas las diferencias absolutas deben compararse con 4,37 2,45 = 3,059. 5 Como resultado, lo siguiente representa las medias encontradas que son significativamente diferentes utilizando el procedimiento de Tukey: 4 y 1, 4 y 5, 4 y 2, 6 y 1, 6y5 6 y 2, 3 y 5, 3 y 2, 1 y 5, 1 y 2. 14.10.3. Prueba de Duncan El segundo procedimiento que se explicará recibe el nombre de procedimiento de Duncan o prueba de rango múltiple de Duncan. Este procedimiento también se basa en la noción general del rango estudentizado. El rango de cualquier subconjunto de p medias muestrales debe exceder un cierto valor antes de que se encuentre que cualquiera de las p medias son diferentes. Este valor se llama rango menos significativo para las p medias y se representa por Rp, donde RP = rp CME n Los valores de la cantidad rp, llamado el rango estudentizado menos significativo, dependen del nivel deseado de significancia y del número de grados de libertad del cuadrado medio del error. Estos valores pueden obtenerse de la tabla para p = 2, 3, ..., 10 medias. Para ejemplificar el procedimiento de la prueba de rango múltiple, considérese el caso hipotético en el cual se comparan 6 tratamientos con 5 observaciones por tratamiento. Este es el mismo ejemplo que el que se utilizó para demostrar la prueba de Tukey. Se obtiene Rp multiplicando cada rp por 0.70. Los resultados de estos cálculos se resumen de la siguiente manera: 246 Cátedra de Cálculo Estadístico y Biometría – Facultad de Ciencias Agrarias – UNCuyo / Ciclo 2013 UNIDAD III:INFERENCIA ESTADÍSTICA p rp Rp 2 2,919 2,043 3 3,066 2,146 4 3,160 2,212 5 3,226 2,258 6 3,276 2,293 Al comparar estos rangos menos significativos con las diferencias en las medias ordenadas, se llega a las siguientes conclusiones: 1. Dado que y4 −y2 = 8.70 > R6 = 2.293, se concluye quey4 yy2, son significativamente diferentes 2. Al comparar y4 −y5 y y6 −y2. con R5 , se concluye quey4 es significativamente más grande que y5 yy6 . es significativamente más grande quey2 . 3. Al comparary4 -y1 ,y6 -y5 , y y3 -y2 . con R4, se concluye que cada diferencia es significativa. 4. Al comparar y4 -y3 , y6 -y1 , y3 -y5 , y y1 -y2 . con R3, se encuentran todas las diferencias significativas excepto para y4 -y3 . Por lo tanto y4 , y3 y y6 constituyen un subconjunto de medias homogéneas. 5. Al comparar y3 -y1 , y1 -y5 , y y5 -y2 . con R2 se concluye que únicamentey3 y y1 no son significativamente diferentes. Es cuestión de resumir las conclusiones anteriores dibujando una línea debajo de cualquier subconjunto de medias adyacentes que no sean significativamente diferentes. Entonces se tiene. y2 . y5 . y1 . y3 . y6 . y4 . 14.50 16.75 19.84 21.12 22.90 23.20 Está claro que, en este caso, los resultados de los procedimientos de Tukey y Duncan son muy similares. El procedimiento de Tukey no detecta una diferencia entre 2 y 5, mientras que el de Duncan sí. 247 Cátedra de Cálculo Estadístico y Biometría – Facultad de Ciencias Agrarias – UNCuyo / Ciclo 2013