Trabajo de investigación realizado por: Alejandro Salazar Couso

Anuncio

Trabajo de investigación realizado por:

Alejandro Salazar Couso

como proyecto de fin de máster para el:

Máster Oficial en Estadística Aplicada

de la:

Universidad de Granada

2 Índice.

Capítulo 1: Introducción ........................................................................................... 6

Capítulo 2: Metodología........................................................................................... 11

2.1 Los modelos de respuesta discreta .............................................................. 11

2.1.1 El modelo lineal ............................................................................... 12

2.1.1 El modelo logit ................................................................................. 13

2.1.1 El modelo probit ............................................................................... 14

2.2: Modelo de regresión logística binaria .......................................................... 15

2.2.1: Formulación e interpretación ............................................................... 15

2.2.1.1: Formulación del modelo .............................................................. 15

2.2.1.2: Interpretación ............................................................................... 17

2.2.2 Estimación ............................................................................................ 18

2.2.3 Contrastes sobre los parámetros.......................................................... 21

2.2.3.1: Contrastes ................................................................................... 21

2.2.3.2: Intervalos de confianza ................................................................ 22

2.2.4: Bondad de ajuste ................................................................................. 23

2.2.5: Selección de variables ......................................................................... 26

2.2.6: Validación y diagnosis ......................................................................... 28

Capítulo 3: Aplicación en R...................................................................................... 31

3.1 Primeros pasos con R .................................................................................. 32

3.2 Estadística descriptiva básica con R ............................................................ 37

3.2.1 Variables categóricas ............................................................................ 37

3.2.2 Variables cualitativas ordinales ............................................................. 41

3.2.3 Variables cuantitativas .......................................................................... 43

3 3.2.4 Variables de intervalo ........................................................................... 44

3.2.5 Variables de razón ................................................................................ 45

3.3 Análisis exploratorio de datos multidimensionales ....................................... 50

3.4 Ajuste de un modelo logístico binario con R ................................................. 52

3.4.1: Formulación ......................................................................................... 53

3.4.2: Parámetros .......................................................................................... 56

3.4.3: Bondad de ajuste ................................................................................. 58

3.4.4: Selección de variables ......................................................................... 60

3.4.5: Validación y diagnosis ......................................................................... 61

Capítulo 4: Aplicación a datos reales....................................................................... 64

4.1: Introducción y antecedentes del problema .................................................. 64

4.2: Material y método ........................................................................................ 65

4.3 Resultados .................................................................................................... 67

4.3.1: Análisis descriptivo .............................................................................. 67

4.3.2: Prevalencia de dolor crónico diagnosticado ........................................ 76

4.3.3: Factores asociados a la presencia de dolor. Modelo logit ................... 77

4.3.3.1: Selección de variables ................................................................. 77

4.3.3.2: Parámetros del modelo................................................................ 82

4.3.3.3: Bondad de ajuste ......................................................................... 85

4.3.3.4: Validación y diagnosis ................................................................. 86

4.4: Conclusiones ............................................................................................... 87

Anexo: Sentencias de R .......................................................................................... 89

Bibliografía ............................................................................................................... 97 4 5 Capítulo 1

Introducción

En el presente trabajo se estudiarán modelos de respuesta discreta, su

formulación, su ajuste y evaluación con R y se aplicarán a un conjunto de datos reales.

En particular, nos centraremos en los modelos de regresión logística binaria.

Los modelos de respuesta discreta son la herramienta estadística apropiada

para modelizar el comportamiento de una variable dependiente (respuesta) de

naturaleza discreta a partir de un conjunto de variables independientes (predictoras),

que pueden ser tanto discretas como continuas. Estos modelos son un caso particular

de los “Modelos Lineales Generalizados” introducidos por Nelder y Wedderburn en

1972. Para un mayor conocimiento de éstos, pueden consultarse obras como las de

McCullagh y Nelder1 o Agresti2.

Existen distintos tipos de modelos de respuesta discreta que dependen, entre

otros aspectos, del tipo de respuesta. En particular, si la variable dependiente es

dicotómica, estamos hablando de “modelos de respuesta binaria”, mientras que si

tiene más de dos categorías de respuesta, estamos hablando de “modelos de

respuesta múltiple”. Más aún, si esas categorías tienen un orden natural, entonces

estamos hablando de “modelos de respuesta ordenada”. Según la función utilizada

para la estimación de la probabilidad, encontramos el “modelo lineal”, el “modelo Logit”

y el “modelo Probit”. Cuando las variables explicativas que se utilizan para estimar las

probabilidades asociadas a cada una de las posibles alternativas que presenta la

variable dependiente se refieren a atributos de las distintas alternativas, y no a

características específicas de los individuos, entonces hablamos de un “modelo

condicional”.

En el ejemplo que se estudiará en el último capítulo de esta memoria, la

variable respuesta es dicotómica, por lo que debería ajustarse un modelo de respuesta

binaria.

6 Existen diversas alternativas para la aplicación de modelos de respuesta

discreta, pero en el presente trabajo usaremos la alternativa ofrecida por R. El

programa R es un entorno para la estadística computacional y gráficos. Funciona en

una amplia variedad de plataformas UNIX, Windows y MacOS. Es un lenguaje de

órdenes (funciona con comandos) basado en los lenguajes previos S y Scheme.

Ofrece un amplio abanico de posibilidades (modelos lineales y no lineales, test

estadísticos, análisis de series temporales, clasificación, análisis clúster…) así como

técnicas gráficas, y puede ser ampliado casi sin límites. El propósito, por tanto es de

estadística general, pero al ser software libre permite crear paquetes más específicos,

otorgándole mayor versatilidad. Sus gráficos son de reconocida calidad e incluye

simbología matemática. Tal y como se afirma en la página oficial3 del proyecto R, se

trata de un entorno en el que se implementan técnicas estadísticas, pero que ofrece

muchas más opciones. En el presente trabajo se hará uso de la versión “R 2.13.0” con

“R-Commander,” que es una Interfaz Gráfica de Usuario que permite hacer uso del

entorno estadístico R de una forma mucho más intuitiva, sin necesidad de conocer

completamente el lenguaje de comandos propio de este entorno. R-Commander dota

a R de una interfaz mucho más amigable de cara al usuario, tratando de corregir uno

de los aspectos más criticados del paquete estadístico.

Como se ha indicado previamente en la presente memoria, se mostrará una

aplicación con datos reales de los modelos de respuesta discreta. Se describe a

continuación la información disponible:

La base de datos escogida es la correspondiente a la “Encuesta de

Discapacidad, Autonomía personal y situaciones de Dependencia” (EDAD-2008)4

llevada a cabo por el Instituto Nacional de Estadística (INE) entre noviembre de 2007 y

febrero de 2008. En la misma se recogen datos de diferente índole (sociodemográficos y de carácter sanitario principalmente) de individuos discapacitados en

España. Los objetivos de esta encuesta son ofrecer información sobre los fenómenos

de la discapacidad, la dependencia, el envejecimiento y el estado de salud de la

población. Además de en 2008, el INE ha realizado esta encuesta en otras dos

ocasiones: 1986 y 1999, y pone a disposición de todo el mundo los datos recogidos en

1999 y en 2008, debidamente anonimizados. Sin embargo, las versiones de algunas

preguntas en ambos cuestionarios difieren en mayor o menor medida, lo que hace

complicada la comparación entre ambos años, razón por la que se optó por un estudio

de corte transversal con la versión del año 2008.

7 En cuanto a nuestro estudio, nos centraremos en aquellos individuos

discapacitados que padezcan dolor crónico, ya que se trata de dos problemas de salud

frecuentes (discapacidad y dolor) actualmente y que pueden estar ligados5-7. Se trata,

por tanto, de un ejemplo relativo a la sanidad, con evidentes aplicaciones y utilidad

real, que pone de manifiesto la importancia de los modelos de respuesta discreta, que

trasciende lo puramente estadístico para meterse de lleno en otras áreas de la ciencia

y el conocimiento humano. Son muchos los estudios epidemiológicos (como el de

nuestro ejemplo) que hacen uso de estas herramientas estadísticas. Para saber más

sobre el papel que la estadística juega en los estudios epidemiológicos, puede

consultarse el libro de Selvin, “Statistical Analysis of Epidemiological Data”8.

En vista de lo expuesto, los objetivos de este trabajo son:

1. Profundizar en los modelos de respuesta discreta (y en particular en el modelo de

regresión logística binaria) desde un punto de vista teórico, mostrando el desarrollo

matemático que subyace.

2. Explicar el funcionamiento del paquete estadístico R, particularmente el de

aquellas funciones que serán necesarias para la realización de este trabajo, y

mostrar las técnicas disponibles para el ajuste y evaluación de un modelo de

respuesta discreta con R.

3. Aplicar la metodología expuesta al conjunto de datos reales especificado

anteriormente. Con esta aplicación nuestros objetivos son, a su vez, conocer la

prevalencia,

características

y

factores

asociados

al

dolor

crónico

en

discapacitados, así como la comorbilidad dolor crónico-ansiedad y dolor crónicodepresión. Las conclusiones del estudio están encaminadas a mejorar el

tratamiento del dolor en estos pacientes mediante la exploración sistemática de

trastornos psiquiátricos asociados.

8 Para lograr nuestros objetivos, y al objeto de facilitar la lectura y comprensión

del trabajo, se ha dividido el mismo en 4 capítulos, cada uno enfocado a un objetivo:

El capitulo 1, “Introducción”, es el capítulo donde se introducen los conceptos,

la metodología, los objetivos y la estructura del trabajo. Es una breve visión del

mismo a modo de resumen, para tener una idea global de este trabajo.

El capítulo 2, “Metodología”, es el capítulo que entra de lleno en la base teórica

de los modelos de respuesta discreta. En él se presentan de forma genérica los

modelos de respuesta discreta y, con rigor, la formulación, interpretación,

ajuste, contraste de bondad de ajuste, validación y diagnosis de los modelos de

regresión logística binaria. Este capítulo responde al primer objetivo planteado.

El capítulo 3, “Aplicación en R”, ofrece una descripción detallada del software

utilizado para el análisis estadístico propuesto. Para adaptarnos a cualquier

nivel de conocimientos previos sobre R, el capítulo comienza con unos

primeros pasos en R y R-Commander, desde su instalación hasta la creación e

importación de bases de datos, incluyendo unas pinceladas sobre la creación y

manejo de objetos en R. También se describen las técnicas para la realización

de todos los análisis que se verán en el capítulo 4, desde los análisis

descriptivos

básicos,

incluyendo

figuras,

pasando

por

análisis

multidimensionales, hasta el propio ajuste de un modelo logístico binario. Este

capítulo responde al segundo objetivo planteado.

El capítulo 4, “Aplicación a datos reales”, se dedica al análisis de los

resultados. En él se expone de manera detallada la base de datos reales

seleccionada para ilustrar la metodología, se ofrece una visión global del

problema de salud planteado en el ejemplo, se detalla el procedimiento seguido

para los análisis descriptivos y el ajuste del modelo, se muestran y se explican

los resultados obtenidos y se sacan conclusiones. Este capítulo responde al

tercer y último objetivo planteado, incluidos los objetivos específicos marcados

para el ejemplo concreto con datos reales.

9 10 Capítulo 2

Metodología

En el presente capítulo se presentan de forma genérica los modelos de

respuesta discreta y, con rigor, la formulación, interpretación, ajuste, contraste de

bondad de ajuste, validación y diagnosis de los modelos de regresión logística binaria.

2.1: Los modelos de respuesta discreta.

Como se ha avanzado en la introducción del trabajo, los modelos de respuesta

discreta son la herramienta estadística apropiada para modelizar el comportamiento de

una variable dependiente (respuesta) de naturaleza discreta a partir de un conjunto de

variables independientes (predictoras), que pueden ser tanto discretas como

continuas. Estos modelos son un caso particular de los “Modelos Lineales

Generalizados” introducidos por Nelder y Wedderburn en 1972. Veremos en este

capítulo distintos modelos de respuesta discreta, pero para un mayor conocimiento de

éstos, remitimos nuevamente a los libros de McCullagh y Nelder1 y Agresti2.

Recordando la clasificación que ya ha sido introducida en el capítulo 1,

encontramos que los modelos de respuesta discreta pueden clasificarse en modelos

de respuesta binaria y modelos de respuesta múltiple, según la variable dependiente

tenga, respectivamente, 2 categorías o más de 2. Si existe un orden natural en las

categorías, entonces es un modelo de respuesta ordenada. También se han

presentado anteriormente los modelos condicionales. Finalmente, según la función

utilizada para la estimación de la probabilidad, encontramos el “modelo lineal”, el

“modelo Logit” y el “modelo Probit”.

Como los modelos de respuesta múltiple (en los que la variable dependiente

tiene J posibles respuestas (J>2)) no son el objeto de este trabajo, nos remitimos a los

libros de Agresti, “Multivariate Analysis: Discrete Variables (Overview)”9 y ”Categorical

11 data analisys”2. Estos libros son una lectura recomendada tanto para modelos de

respuesta múltiple como para modelos de respuesta discreta, en general.

Los modelos de respuesta binaria tienen una variable dependiente dicotómica

que llamaremos Y. Esta variable puede tomar dos valores, que podremos recodificar

en 0 y 1. Generalmente se asocia el valor 0 a la “ausencia”, al “fracaso” o a una

respuesta negativa en general, y el valor 1 a la “presencia”, el “éxito” o una respuesta

afirmativa en general. Con la variable así codificada, se tiene que Y sigue una

distribución de Bernouilli de parámetro p (0<p<1).

Puesto que contamos con una serie de variables independientes “X”

predictoras del comportamiento de Y, lo propio es considerar la distribución de Y en

cada valor observado de X, “Y(x)”. Se tiene que es también una Bernouilli de

esperanza p(x) y varianza p(x)[1-p(x)]. El objetivo final será la construcción de un

modelo para Y(x) en función de los parámetros, x, y un error.

Para satisfacer esta necesidad, disponemos de los modelos lineales, los

modelos logit y probit, aunque los modelos lineales tienen ciertos problemas que

veremos a continuación.

2.1.1: El modelo lineal

Supongamos que tenemos R variables independientes con N observaciones en

,…,

cada una. Sea

el vector que contiene las observaciones de cada

variable para el individuo i-ésimo. El modelo de probabilidad lineal, que deriva del

∑

modelo de regresión lineal

, (

1, … , ), (

1, … , )

teniendo en cuenta que los errores son variables aleatorias independientes y de

esperanza 0, es de la forma:

|

∑

, (

1, … , ), (

1, … , )

Este modelo presenta diversos problemas, entre los que destaca la no

normalidad, la no homocedasticidad (varianza de la respuesta no constante sobre los

valores de x), la posibilidad de obtener valores de la probabilidad por debajo de 0 y por

encima de 1, la subestimación del parámetro

y, sobre todo, el hecho de que

aumentos iguales en las variables explicativas originen aumentos iguales en la

probabilidad de respuesta. Esta última situación no es en absoluto realista, ya que en

general esta dependencia no será lineal.

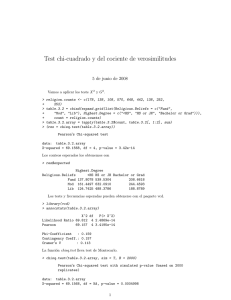

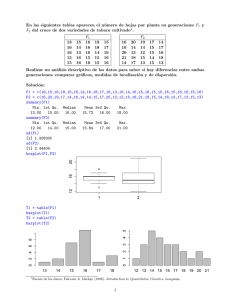

12 En la imagen 2.1 se muestra la representación gráfica de un modelo lineal.

Podemos observar algunos de los problemas explicados como el de los aumentos

constantes y, de forma más evidente, la falta de acotación en el intervalo [0,1].

Imagen 2.1: Representación gráfica de un modelo lineal.

Todos los problemas presentados hacen que estos modelos no sean tan

utilizados y, en su lugar, la comunidad científica tienda a hacer uso de los modelos no

lineales, que vienen a corregir dichos problemas. En el caso de los modelos no

lineales, lo que se busca es un modelo del tipo:

∑

,(

1, … , ), (

1, … , )

Es decir:

∑

1, … , ), (

, (

1, … , )

La elección de esa función F determina el modelo considerado. Los modelos

más destacados son el modelo logit y el modelo probit.

2.1.2: El modelo logit.

Siguiendo con la notación anterior, el modelo de regresión logística es de la

forma:

∑

∑

, (

1, … , ), (

1, … , )

O equivalentemente:

ln

∑

, (

13 1, … , ), (

1, … , )

Este modelo no se sale del rango [0,1] como ocurría con el lineal. Además, las

rectas Y=0 e Y=1 son asíntotas horizontales y la tasa de cambio en p(x

en función de

los cambios en las variables independientes, no es constante en esta ocasión.

En la imagen 2.2 podemos ver una representación gráfica de este modelo

ajustando los mismos datos que se ajustaron linealmente en la imagen 2.1. Dicha

imagen muestra, entre otras cosas, que la curva en esta ocasión sí que está acotada

en [0,1] y que los aumentos no son constantes, dando como resultado una

representación más fiel a la realidad:

Imagen 2.2: Representación gráfica de un modelo logit.

Se trata de un modelo que es ampliamente utilizado por la comunidad

científica10-14 y, en particular, en estudios epidemiológicos15-18 como el que se presenta

en el capítulo 4 de este trabajo. Por esta razón se hará un estudio más detallado del

mismo en el apartado 2.2 del presente capítulo. Paralelamente, para un mayor

conocimiento se pueden consultar los trabajos de Hosmer y Lemeshow19, Kleinbaum20

o Silva Aycaguer21 entre otros.

2.1.3: El modelo probit.

Para el modelo probit se considera la función de densidad de una normal

estándar (N(0,1)), siendo ésta:

1

F x

√2π

e

dt,∀x ∈ R

La expresión del modelo sigue siendo la misma, pero con esa elección

concreta de F:

∑

, (

14 1, … , ), (

1, … , )

Este modelo tiene características similares a las del modelo logit, con la

particularidad de aproximarse a las asíntotas horizontales (Y=0, Y=1) con mayor

rapidez. Es un modelo que también se usa con cierta frecuencia en el ámbito de la

investigación científica22-26 y, particularmente, es muy usado en toxicología27-30. Para

un mayor conocimiento sobre estos modelos pueden consultarse las obras de Bliss31,

Finney32 o Steinbrecher y Shaw33.

2.2: Modelo de regresión logística binaria.

El modelo de regresión logística binaria tiene un gran interés desde el punto de

vista epidemiológico, como ya se ha visto. En este apartado se describirá el modelo

con mayor nivel de detalle. El desarrollo teórico que se presenta a continuación parte

de la base de los principales textos sobre regresión logística como son los de Agresti2,

Hosmer y Lemeshow19 y Kleinbaun20, así como del libro de Aguilera “Modelos de

Respuesta Discreta: Asignatura Modelización y Predicción Estocásticas”34.

2.2.1: Formulación e interpretación.

2.2.1.1: Formulación del modelo

Recordemos que un modelo logit viene expresado a través de:

∑

ln

, (

1, … , ), (

1, … , )

Donde k es el número de variables independientes, n el número de observaciones en

cada una,

,…,

el vector que contiene las observaciones de cada variable

representa la ventaja de respuesta Y=1

para el individuo i-ésimo y el cociente

para los valores observados de las variables independientes. El caso más sencillo de

modelo logístico es aquel en el que se tiene una única variable independiente

continua, esto es:

ln

1

Veamos las principales características de la curva de respuesta en el caso de

una única variable con un único parámetro b. En primer lugar, se tiene que la curva

tiene forma de S y está acotada dentro del intervalo de valores [0,1], siendo las rectas

Y=0 e Y=1 asíntotas horizontales. Su crecimiento es monótono, pudiendo ser creciente

15 (si b>0) o decreciente (si b<0). Por tanto, con b>0 la probabilidad de respuesta tenderá

a 1 para

→ ∞ y a 0 para

→

∞. La situación se invierte si b<0. Si b=0, la curva es

en realidad una recta e Y es independiente de x. La tasa de cambio en p(x) por cada

unidad de cambio en x no es constante, ya que viene dada por la pendiente de la recta

tangente a la curva.

En el caso de tener más de una variable independiente, pero todas continuas,

el modelo adopta la forma:

ln

∑

, (

1, … , ), (

1, … , )

Si se tiene alguna variable independiente categórica, es necesario definir una

serie de variables nuevas, artificiales, que servirán para poder pasar de una variable

categórica con k categorías a k-1 variables indicadoras de la presencia de cada

categoría, por separado35. Dichas variables de diseño, también conocidas como

variables ficticias o “dummies”, son introducidas en el modelo como variables

continuas, tal y como se explica a continuación:

Para crear las k-1 variables de diseño asociadas a una variable con k

categorías podemos elegir entre dos posibles métodos: el método parcial y el método

marginal.

El método parcial consiste en elegir una categoría de referencia dentro de las k

posibles y construir para cada una de las restantes una variable que valga 1 en la

categoría considerada y 0 en el resto. Por ejemplo, si tenemos una variable con las

categorías “bajo”, “medio” y “alto”, podríamos elegir “bajo” como categoría de

referencia y crear dos variables de diseño: una que valga 1 cuando se de la categoría

“medio” y 0 en los otros dos casos y una segunda variable que valga 1 cuando se de la

categoría “alto” y 0 en los otros dos casos. Estas dos variables son las que entran en

el modelo.

El método marginal es similar en su concepto, salvo que en esta ocasión todas

las dummies toman el valor -1 cuando se da la categoría de referencia, en lugar de 0.

Un caso especial es el de las variables ordinales, ya que además de poder usar

los métodos anteriores, contamos con la posibilidad ordenar las categorías, asignar

puntuaciones y tratarla como continua.

16 Lo común en epidemiología es utilizar el método parcial36,

37

, que permite

interpretar los parámetros en términos de cocientes de ventajas de forma sencilla,

como se verá en el siguiente apartado.

2.2.1.2: Interpretación.

En la fórmula del modelo tenemos una serie de coeficientes que son los

parámetros del mismo. Además, a partir de ellos pueden calcularse los denominados

“cocientes de ventajas”, que serán de mucha utilidad a la hora de interpretar el

modelo.

En el caso trivial de que todos los coeficientes “ ” del modelo fuesen 0, la

variable Y sería independiente de las variables explicativas. Obviando este caso,

tenemos que:

En un modelo con una única variable independiente, el riesgo relativo de

y

respuesta Y=1 para dos valores distintos

del predictor se define como:

y el cociente de ventajas de respuesta Y=1 dados dos valores distintos

y

del

predictor se define como:

1

1

Estando ambos conceptos relacionados a través de la expresión:

∗

1

1

De tal forma que si la probabilidad de respuesta Y = 1 es cercana a 0, el riesgo relativo

puede ser aproximado mediante el cociente de ventajas. Esta situación es beneficiosa

para el epidemiólogo, ya que el riesgo relativo no tiene sentido en estudios

retrospectivos al estar el número de enfermos (Y=1) prefijado de antemano, mientras

que el cociente de ventajas tiene sentido siempre. Por esta razón se interpretarán los

parámetros de los modelos en términos de cocientes de ventajas. Teniendo en cuenta

esto, pasamos a interpretar los parámetros del modelo:

17 La constante “a” es el valor del logaritmo de la ventaja de respuesta Y=1 para

un individuo que tiene valor 0 en todas las variables independientes, o bien cuando la

respuesta es independiente de las variables predictoras. Por tanto, es su exponencial

la que indica la ventaja de respuesta Y=1.

A partir de los parámetros “ ” podemos calcular los cocientes de ventaja de

respuesta Y=1 como las exponenciales de dichos parámetros. Es lo que se conoce

como “odds ratio” (OR). La interpretación de estos parámetros varía ligeramente según

la naturaleza de la variable que le acompaña. Si la variable es continua, el cociente de

ventajas representa la variación en la ventaja de respuesta Y=1 por cada unidad de

aumento de la variable, cuando el resto de variables permanece constante. Al

aumentar en una unidad dicha variable y dejar el resto fijas, la ventaja de respuesta

Y=1 queda multiplicada por la exponencial de “ ” (OR). Por lo tanto, si OR=1

(equivalentemente, “ ”=0), significa que dicha variable en concreto no afecta a la

respuesta. Si OR<1 (“ ”<0) se tiene que la ventaja de respuesta Y=1 disminuye. En

términos epidemiológicos se dice que esa variable es un “factor protector”. Si OR>1

(“ ”>0), la ventaja aumenta y se tiene un “factor de riesgo”. Si la variable original es

categórica y se han definido las dummies con el método parcial, tenemos una OR para

cada una de las variables de diseño (es decir, cada una de las categorías) y dicho

valor representa la ventaja de respuesta Y=1 de esa categoría en concreto con

respecto a la categoría de referencia, cuando el resto de variables queda fijo. Los

conceptos de factor protector y factor de riesgo siguen teniendo validez en este caso.

Si las dummies han sido definidas mediante el método marginal, la interpretación de

los parámetros es algo más compleja. Cada parámetro es la desviación del logit de la

categoría que lleva asociada con respecto a la media de todos los logit, por lo que la

exponencial del parámetro es el cociente entre la ventaja de respuesta Y=1 para su

categoría asociada y la media geométrica de todas las ventajas de respuesta Y=1.

2.2.2: Estimación.

Sea

,

,…,

con q=1,...,Q la q-ésima combinación de valores de

las R variables explicativas en la muestra de tamaño N. Sea

e

observaciones muestrales con

observaciones. Sea

1|

el número de

el número de respuestas Y=1 entre dichas

. Considerando la constante “a” del modelo

como primer elemento del vector de coeficientes “ ”, podemos expresar el modelo en

forma matricial como L=XB, donde L es el vector de las transformaciones logit, B es el

vector de parámetros “ ” (incluido a) y X es la matriz del diseño que contiene las

18 observaciones de las variables explicativas. Lo más usual es ajustar el modelo a

través del “método de máxima verosimilitud” (MV).

Los estimadores MV dan máxima probabilidad a los datos observados. Se

calculan maximizando la función de verosimilitud de los datos respecto de los

parámetros del modelo logit, o equivalentemente, maximizando el logaritmo del núcleo

de la función de verosimilitud. Teniendo en cuenta que la función de verosimilitud es el

producto de las Q funciones masa de probabilidad de las Q binomiales

independientes, partimos de:

1

Calculando el logaritmo del núcleo de la función de verosimilitud anterior,

derivando con respecto a cada parámetro

e igualando a 0 obtenemos las

ecuaciones de verosimilitud:

̂

con ̂ el estimador MV de

y

0,

0, … ,

los estimadores MV de

:

∑

̂

1

∑

Debido a la concavidad de la log-verosimilitud, estos estimadores existen y son

únicos siempre que exista cierto solapamiento en los datos. En otras palabras, no

debe darse el caso en el que a todos los valores para los que la variable respuesta sea

0 correspondan valores de la variable explicativa menores que aquellos para los que la

respuesta es 1 (separación completa)38, 39.

Las ecuaciones de verosimilitud no son lineales en los parámetros. Para

resolverlas, se propone el uso de un método iterativo como es el de “NewtonRaphson”, que puede usarse para el cálculo aproximado del máximo de una función40.

Este método parte de una aproximación inicial del máximo y, en cada paso, se toma

como localización del máximo de la función la del polinomio de segundo grado

obtenido truncando el desarrollo de Taylor de la función en un entorno de la

aproximación obtenida en el paso anterior. El método converge siempre que verifique

19 ciertas condiciones de regularidad y el valor inicial sea adecuado. Pueden verse más

detalles en la revisión realizada por Tjalling sobre el método de Newton-Raphson40.

En nuestro caso, aplicando el método a partir de unos valores iniciales

que

más adelante se detallan, podemos obtener la aproximación a través de la fórmula

iterativa:

1

La convergencia de

hacia los estimadores MV ̂ y

y

es de orden 2 y

el criterio de parada suele ser cuando entre dos pasos consecutivos, el cambio en las

probabilidades o la log-verosimilitud es inferior a 10 , o el de los parámetros B inferior

40, 41

a 10

. En cuanto a la elección de los valores iniciales adecuados, algunas

opciones son asumir que son 0, partir de la estimación obtenida mediante mínimos

cuadrados ordinarios, o partir de los valores más adecuados obtenidos mediante

análisis discriminante sobre las variables explicativas, como proponen Hosmer y

Lemeshow19.

Por otra parte, se podría usar el “método de estimación por mínimos cuadrados

ponderados” para la estimación de los parámetros. Este método pondera cada

observación por el inverso de su varianza, debido a la heterocedasticidad. Se trata de

un método que conduce a la obtención de estimadores asintóticamente óptimos para

valores

grandes, aunque no está exento de dificultades, como la fuerte

dependencia de los valores iniciales y el hecho de ignorar los casos en los que

1

y la práctica totalidad de la información de las variables continuas, aunque esto último

puede corregirse sustituyendo las frecuencias de respuesta 0 por el valor 0.5.

Para la aplicación del método de estimación por mínimos cuadrados

ponderados partimos del modelo en forma matricial: L=XB. Sea

la proporción

observada de respuestas Y=1 en la q-ésima combinación de valores de las variables

explicativas. El ajuste del modelo logit se corresponde con el del modelo lineal:

, siendo Z el vector de elementos

ln

y “e” el vector de errores

centrados e independientes. La estimación por mínimos cuadrados ponderados de sus

parámetros viene dada por:

1

1

20 Los estimadores de máxima verosimilitud tienen, bajo ciertas condiciones,

distribución asintótica normal de media el valor poblacional del parámetro estimado y

matriz de covarianzas dada por la inversa de la matriz de información de Fisher. Así,

son asintóticamente insesgados y además se puede hacer inferencia sobre ellos

basándose en dicha distribución normal cuando el tamaño muestral es suficientemente

grande. Estos resultados se deben a Wald.

2.2.3: Contrastes sobre los parámetros.

2.2.3.1: Contrastes.

Sobre los parámetros podemos realizar contrastes de Wald, contrastes

condicionales de razón de verosimilitudes y test de Score.

El “contraste de Wald” se basa en la normalidad asintótica de los estimadores

MV. La hipótesis nula es que un subconjunto de los parámetros “ ”, denotado

,…,

′ es nulo. El estimador MV de los parámetros del subconjunto C tiene

distribución asintótica de media c y matriz de covarianzas igual a la submatriz de la

matriz de covarianzas de los parámetros “ ” generada por el subconjunto de

̂ ). El estadístico de Wald es la forma

parámetros C (a la que llamaremos

cuadrática ̂

̂

̂ que asintóticamente sigue una

con l grados de libertad (l

es el número de parámetros nulos bajo la hipótesis nula), rechazándose ésta a nivel

de significación

si el valor del estadístico es mayor o igual que el cuantil 1

de la

distribución.

El “contraste condicional de razón de verosimilitudes” es más fiable en general

que el de Wald, siendo su uso más recomendable, razón por la que la selección de

variables en el apartado 2.2.5 se plantea con este tipo de contrastes. En este contraste

se parte de un modelo M que se ajusta bien y se quiere contrastar si un subconjunto

de los parámetros “ ”, denotado

,…,

′ es nulo. Al hacer 0 esos parámetros

en M obtenemos un modelo MA anidado a M. La hipótesis nula es C=0 frente al

modelo completo M y el estadístico de contraste verifica que:

|

, es decir, es la diferencia de los contrastes de razón de verosimilitudes de

bondad de ajuste para cada modelo. Éste tiene, bajo el modelo ME, distribución

con l grados de libertad. Se rechazará la hipótesis nula en las mismas condiciones que

en el test de Wald.

El “test de Score”, basado en la distribución de las derivadas parciales de la

log-verosimilitud, reduce los cálculos con respecto a los anteriores contrastes. Las

21 hipótesis siguen siendo las mismas pero el estadístico, en esta ocasión, es la forma

cuadrática:

1

donde

es el estimador MV de los parámetros del modelo MA, D( ) el vector de

derivadas parciales de la log-verosimilitud evaluado en

, con

y X es tal que

el vector de valores esperados. Este estadístico tiene, bajo la hipótesis

nula, distribución

con grados de libertad igual al número de componentes nulas en

MA.

2.2.3.2: Intervalos de confianza.

Basándonos en la distribución normal asintótica de los estimadores MV,

podemos construir los siguientes intervalos de confianza a nivel 1

Para los parámetros: Para cada

(que sigue una N

:

,

), se tiene el

intervalo:

z σ

.

Para las transformaciones logit (L(x)): Teniendo en cuenta que el estimador MV

de L,

, tiene distribución asintótica N(L(x),

), se tiene el

intervalo:

z σ

.

Para las probabilidades de respuesta Y=1: A través de la transformación

̂

se obtiene el intervalo:

1

Para los cocientes de ventajas: Al tratarse de las exponenciales de las “ ”,

basta con tomar exponenciales en sus intervalos de confianza, quedando los

intervalos de la forma:

22 2.2.4: Bondad de ajuste.

Sea y el número de respuestas Y=1 en las n observaciones correspondientes

a la q-ésima combinación de valores de las variables explicativas, con q=1,...,Q. Sean

p las probabilidades y m

n p las frecuencias esperadas de valores Y=1. Sean p

y m sus estimaciones de máxima verosimilitud.

El test global de bondad de ajuste del modelo contrasta la hipótesis nula:

∑

:

∀

∑

1

1, … ,

frente a la alternativa de ser distinto para algún valor de q. Si el número de

observaciones en cada combinación de valores de las variables explicativas es

grande, podemos hacer uso del estadístico

de Pearson y del estadístico de Wilks

de razón de verosimilitudes. En cambio, si el número de observaciones no es

demasiado grande, existe una modificación del estadístico

conocida como el

estadístico de Hosmer y Lemeshow. Finalmente, algunas medidas globales para la

bondad del ajuste son la tasa de clasificaciones correctas, el área bajo la curva ROC y

las medidas tipo

. Se explican a continuación todos los contrastes y las medidas

mencionadas:

El estadístico “

de Pearson” es el resultado de sumar los estadísticos

de

bondad de ajuste a cada una de las distribuciones B(n , p ) que generan a los datos

muestrales bajo la hipótesis nula de que las probabilidades p verifiquen el modelo,

resultando ser:

̂

̂ 1

̂

Este estadístico tiene distribución asintótica

con tantos grados de libertad

como la diferencia entre el número de parámetros p

(transformaciones logit

muestrales) y el número de parámetros independientes en el modelo, es decir, Q(R+1), de tal modo que se rechazará

a nivel de significación

estadístico supere al cuantil de orden 1- , esto es,

equivalentemente, cuando el p-valor sea

cuando el valor del

;

, o

.

El “test chi-cuadrado de razón de verosimilitudes” se basa en el “estadístico de

Wilks”, calculado como menos dos veces el logaritmo del cociente entre el supremo de

23 la verosimilitud bajo la hipótesis nula y el supremo de la verosimilitud en la población.

El estadístico resulta ser:

2

Este estadístico, también conocido como “devianza”, tiene la misma

distribución asintótica que el de Pearson, de modo que se rechazará la hipótesis nula

en las mismas condiciones que en aquel.

Para poder asumir la distribución chi-cuadrado de ambos estadísticos, ha de

ocurrir que el 80% de las frecuencias estimadas bajo el modelo, m

n p , sean

mayores que cinco y todas mayores que uno. En caso contrario debe hacerse uso del

“test de Hosmer y Lemeshow”19. Para la construcción del estadístico, se agruparán las

variables explicativas en G grupos o clases (los autores recomiendan 10 grupos

basados en los deciles de las probabilidades estimadas). Sea n el número total de

observaciones en el g-ésimo grupo,

el número de respuestas Y=1 en el g-ésimo

grupo, y ̅ la probabilidad estimada bajo el modelo de respuesta Y=1 para el g-ésimo

grupo obtenida como la media de las probabilidades p de los valores

de dicho

grupo. El estadístico viene dado por:

̅

̅ 1

̅

que tiene distribución asintótica chi-cuadrado con G-2 grados de libertad, por lo que

con ésta compararemos para rechazar o aceptar la hipótesis nula.

Además de los tests previamente descritos, podemos calcular distintas

medidas de bondad de ajuste global como la “tasa de clasificaciones correctas”, el

“área bajo la curva ROC” o las “medidas tipo

”.

La tasa de clasificaciones correctas se calcula como el cociente entre los

aciertos y el tamaño muestral. Se entiende por “acierto” el hecho de que la predicción

del modelo para la respuesta coincida con el verdadero valor de la respuesta. Para

clasificar a los individuos se fija un punto de corte (cut off) tal que si la probabilidad

estimada por el modelo para un individuo es menor, se clasifica como Y=0, y si es

mayor, como Y=1. Aunque muchas veces ese cut off se toma como 0.5, es más

apropiado tomar como punto de corte la proporción de valores Y=1 en la muestra, e

24 incluso más aconsejable es probar distintos puntos de corte y quedarnos con el que

maximice la tasa de clasificaciones correctas.

La curva ROC es una gráfica que permite evaluar la capacidad del modelo para

discriminar. El área bajo la curva ROC representa la probabilidad de que un individuo

enfermo elegido al azar tenga mayor probabilidad estimada de padecer la enfermedad

que un individuo no enfermo elegido también al azar. Por tanto, lo deseable es que

esta medida sea lo más alta posible, considerándose que el modelo es preciso y tiene

alta capacidad de discriminación cuando el área es al menos 0.7

19

. El rango de

posibles valores es entre 0.5 y 1, correspondiendo el primero a la peor curva ROC

posible (la recta y=x) y el segundo a la curva ROC ideal. Para construirla, se

representa gráficamente la tasa de verdaderos positivos (en el numerador, el número

de individuos con Y=1 para los que el modelo predice también Y=1; en el

denominador, total de individuos en la muestra con Y=1) frente a la tasa de falsos

positivos (en el numerador, el número de individuos con Y=0 para los que el modelo

predice Y=1; en el denominador, total de individuos en la muestra con Y=0) para

distintos puntos de corte. En la imagen 2.3 vemos un ejemplo de curva ROC dibujada

junto a la recta y=x.

Imagen 2.3: Ejemplo de curva ROC.

Las medidas tipo

intentan adaptar a la regresión logística la medida

de la

lineal, aunque no son tan potentes19. Se pueden definir distintas medidas de este tipo,

pero muchas de ellas presentan inconvenientes como el hecho de decrecer al añadir

una variable explicativa al modelo o que llegue a tomar valores pequeños cuando el

ajuste es casi perfecto. Como medida

en regresión logística se propone la

de

Cox y Snell:

1

donde V es el máximo de la verosimilitud bajo el modelo nulo y V el máximo de la

verosimilitud bajo el modelo ajustado con todos los parámetros. No obstante, el

25 máximo de esa medida es 1

la

, pero puede ajustarse para que sea 1 a través de

de Nagelkerke, cuya definición es:

á

2.2.5: Selección de variables.

De todos los posibles modelos que se pueden ajustar, debemos escoger un

único modelo final que explique el comportamiento de la variable dependiente en

función de las variables independientes. Para tal efecto, la regla de oro que se debe

tener siempre presente es el conocido como “principio de parsimonia”, consistente en

la elección del modelo que ajuste bien los datos con el menor número de variables

posible y lleve a una interpretación sencilla en términos de cocientes de ventajas.

Ajustar todos y cada uno de los posibles modelos a partir de n variables

explicativas para compararlos entre sí es una labor tediosa e innecesaria. En su lugar,

existen procedimientos que ahorran tiempo y cálculos y que nos guían a través de un

camino más directo en la búsqueda del mejor modelo posible, como son los

procedimientos paso a paso (stepwise). En cada paso del procedimiento stepwise se

incluye una nueva variable (stepwise forward) o se elimina una variable (stepwise

backward) y se determina si el modelo resultante mejora al anterior.

El procedimiento stepwise forward-backward ajusta en primer lugar un modelo

para cada una de las variables y, selecciona para entrar en el modelo final aquella

variable que origine el mejor modelo. En el siguiente paso, parte del modelo con la

variable introducida en el paso anterior y vuelve a calcular todos los modelos posibles

que combinan dicha variable con cada una de las restantes, seleccionando para entrar

en el modelo la mejor entre todas las que mejoran el modelo del paso anterior.

Asimismo, en cada paso se analiza el modelo resultante si se eliminaran variables de

los pasos anteriores (salvo el inmediatamente anterior). El procedimiento se repite

hasta que en un determinado paso ningún modelo mejore al del paso anterior,

quedándonos entonces con este último modelo como el modelo definitivo.

La forma de determinar si un modelo mejora a otro o no es a través de

contrastes de hipótesis. En los pasos en los que se prueba introducir una nueva

variable, se realizan contrastes condicionales de razón de verosimilitudes con el

modelo del paso anterior como hipótesis nula y cada uno de los nuevos como

hipótesis alternativa en cada contraste. Aquellos contrastes cuyo p-valor sea inferior al

26 nivel de significación requerido determinarán las variables susceptibles de ser

introducidas en el modelo en ese paso. Entre todas, se elegirá la más mejore el

modelo, en el sentido de reducir más la devianza, con un p-valor adecuado. En los

pasos en los que se prueba eliminar una variable, los contrastes tienen como hipótesis

nula los modelos resultantes de eliminar cada una de las variables y como hipótesis

alternativa el modelo que se tenía del paso anterior. En esta ocasión, las variables

susceptibles de ser eliminadas serán aquellas cuyos modelos proporcionen un p-valor

que supere el nivel de significación establecido, que por otra parte debe ser mayor que

el nivel de significación fijado para la entrada de variables, de modo que se evite que

salga la variable introducida en el paso anterior.

Hay ciertos detalles que deben tenerse en cuenta cuando se está eligiendo el

modelo definitivo. El primero de ellos hace referencia a las variables categóricas: si al

menos una variable de diseño es significativa y decide dejarse en el modelo, todas y

cada una de las variables de diseño asociadas a la misma variable categórica original

deben permanecer en el modelo, sean o no significativas. En este caso se puede

contrastar el modelo completo frente al modelo si se sacan todas las dummies de la

variable categórica en bloque para tomar una decisión. También hay que tener en

mente la recomendación de que el número total de variables en el modelo sea tal que

haya al menos 10 individuos de la muestra para cada categoría de respuesta por cada

variable del modelo42. Para poder ajustar un modelo con 10 variables, por ejemplo,

deberíamos tener al menos 100 individuos con respuesta Y=0 y otros 100 con

respuesta Y=1. En el mejor de los casos (50%-50%) se requeriría una muestra de 200

personas, pero el tamaño total de la muestra se dispara si tenemos en cuenta que la

distribución de la respuesta no suele ser equitativa sino muy desigual.

Mención aparte merecen los conceptos de “interacción”43 y “confusión”44. En

ciertas ocasiones ocurre que el grado de asociación de la variable respuesta Y y una

variable explicativa X depende de los valores de otra variable explicativa X que se

relaciona con X . Decimos entonces que tenemos una interacción de orden 1 entre

esas variables. En general, una interacción de orden k es aquella que involucra k+1

variables predictoras, si bien es cierto que en la práctica suelen considerarse solo las

de orden 1 porque interacciones de órdenes superiores complican demasiado el

modelo y suelen ser difíciles de interpretar. No obstante, si la asociación entre Y y X

cambia significativamente por el mero hecho de incluir X en el análisis, diremos que X

es una variable de confusión.

27 Cada interacción entre variables continuas añade un sumando a la fórmula del

modelo, estando dicho sumando formado por un coeficiente “ ” junto al producto de

las variables que interaccionan. En el caso de dos variables categóricas, se añade al

modelo un sumando por cada uno de los posibles productos cruzados entre sus

variables de diseño. Si se tiene una variable continua interaccionando con una

categórica, se incluye en el modelo el producto de la continua con cada una de las

variables de diseño de las categóricas.

Un último detalle que debe tenerse en cuenta si se introducen interacciones en

el modelo es el conocido como “principio jerárquico”43, que obliga a dejar en el modelo

todos los términos de orden inferior, hasta las propias variables que forman parte de la

interacción, aunque por sí solos no fuesen significativos.

2.2.6: Validación y diagnosis.

En el apartado 2.2.4 se han ofrecido herramientas para contrastar la bondad

global del ajuste. En éste se describen métodos para estudiar la bondad del ajuste

observación a observación, así como la naturaleza de la falta de ajuste. Las técnicas

más usadas son las de los residuos y las medidas de influencia.

Podemos definir dos tipos de residuos distintos, dependiendo de si están

basados en el estadístico

o en el

. Basados en

se definen los “residuos de

Pearson” o “residuos estandarizados”:

̂

̂ 1

̂

Estos residuos pueden ajustarse para que sigan una N(0,1)45:

1

con h

el elemento diagonal de la matriz

̂ 1

̂

y

. Entonces se contrasta la hipótesis nula de que los residuos son 0

frente a que no lo son, rechazando H cuando el residuo en valor absoluto es

z .A

veces los residuos no ajustados son tratados como N(0,1) para obviar el paso del

ajuste. En ese caso se rechaza H si el valor absoluto del residuo es mayor que 2.

Basados en

se definen los “residuos de la devianza” o “residuos

estudentizados”:

28 2

ln

ln

que pueden ajustarse igualmente para seguir una N(0,1), siendo la convergencia más

rápida que en los residuos estandarizados:

1

El contraste de hipótesis es similar al anterior.

Existe una última opción muy útil cuando los tamaños

son pequeños. Se

trata de los “residuos de la devianza modificados”:

1

∗

2 ̂

̂ 1

̂

Si un resido resulta ser significativo, debe estudiarse su influencia sobre el

ajuste del modelo a través de “medidas de influencia” como las “distancias de Cook”46.

Se define las distancias de Cook como:

1

1

1

Y las distancias de Cook modificadas:

∗

Donde p

X

1

1 1

̂

∗

̂

1

̂

1

es el estimador de p obtenido eliminando las observaciones para las que

x . Cada observación tiene su distancia y se considera significativa si es mayor

que 1 46.

Aparte de los procedimientos anteriores, en estos casos resulta muy útil recurrir

también a métodos gráficos. Podemos representar gráficamente los residuos frente a

los valores predichos por el modelo ajustado y observar si están todos en una banda

horizontal alrededor del 0, o bien representar gráficamente las observaciones frente a

los valores predichos y observar si se mantienen en una banda en torno a la recta Y=x,

como se sugiere en el libro de Aguilera34.

29 30 Capítulo 3

Aplicación en R

El presente capítulo ofrece una descripción detallada del software utilizado para

el análisis estadístico propuesto. El software elegido para tal efecto es el paquete

estadístico R. Las razones de su elección son diversas: en primer lugar cabe destacar

su cantidad y calidad de técnicas y funciones implementadas. Es reseñable también su

manejabilidad, así como su versatilidad. Es fácilmente adaptable a una gran variedad

de tareas. Además, es libre, accesible y tiene una mayor implantación en la comunidad

científica, hasta el punto de considerarse un referente e incluso el estándar para el

análisis de datos. En este trabajo se hace uso de la versión “R 2.13.0” con la Interfaz

Gráfica de Usuario “R-Commander”, que permite hacer uso del entorno estadístico R

de una forma mucho más intuitiva, dotando a R de una interfaz mucho más amigable

de cara al usuario.

Imagen 3.1: Consola de R (izquierda) e interfaz de R-Commander (derecha).

31 Como ya se detalló en la introducción del trabajo, R es un entorno para la

estadística computacional y gráficos, que funciona en una amplia variedad de

plataformas. En nuestro caso, Windows XP. Este lenguaje de órdenes ofrece un

amplio abanico de posibilidades, entre las cuales detallaremos aquellas que

respondan a las necesidades específicas de este proyecto, como son la estadística

descriptiva y los modelos de respuesta discreta. Pero antes, veremos unas nociones

básicas sobre el manejo de R, dejando, obviamente, cosas en el tintero que pueden

consultarse tanto en la página oficial como en el centro de documentación o en otros

artículos o libros publicados. En particular, se recomienda como libro de iniciación el

de Arriaza et al.47

3.1 Primeros pasos con R.

Dedicaremos este apartado a lo que puede considerarse como una “puesta a

punto” y unos primeros pasos antes de entrar de lleno en el análisis estadístico, de

cara al usuario que se encuentre por primera vez con este software estadístico.

Para instalar R, el usuario puede acudir a la página oficial3 del Proyecto R, que

tiene el inconveniente de no estar en castellano, y seguir las instrucciones según la

plataforma sobre la que se desee instalar. También se podrán instalar paquetes

adicionales y revisar la documentación. Además, dicha página es un punto de

encuentro en el que se resuelven dudas y se intercambia información. Téngase en

cuenta que, dada su naturaleza, R no ofrece un servicio de atención al cliente ni

soporte técnico. Corresponderá, por tanto, a la propia comunidad científica solucionar

los problemas derivados del uso de R, si queremos que el proyecto funcione.

Imagen 3.2: Página oficial del proyecto R.

32 Una vez instalado R, la instalación de R-Commander es tan sencilla como

ejecutar R y pinchar en Paquetes->Instalar Paquete(s), elegir el “mirror” de descarga,

que en nuestro caso puede ser “Spain (Madrid)” y seleccionar “Rcmdr.” Para ejecutar

R-Commander, es necesario escribir la orden “library(“Rcmdr”)” en R. Si se cerrara RCommander sin haber cerrado R, se puede volver a cargar mediante la orden

“Commander()”

Con R perfectamente operativo en nuestro ordenador, nos disponemos a

realizar nuestros primeros análisis estadísticos. Pero antes necesitamos lo primordial,

el elemento esencial para poder realizar cualquier estudio estadístico: los datos.

Podemos tener datos de diversa índole y en muy diferente formato. Lo primero

que debemos saber es cómo introducir esos datos en R. Existe, en primer lugar, la

posibilidad de introducir esos datos manualmente. En R-Commander, debemos entrar

en “Datos->Nuevo conjunto de datos”. Se nos pedirá que le demos un nombre al

conjunto de datos y se abrirá la ventana del editor de datos, en forma de tabla, donde

podremos introducirlos sin mayor dificultad, además de otorgarle nombre a cada

variable e indicar el tipo de variable que es. Sencillamente hay que tener en cuenta

que cada fila representa un caso y cada columna representa una variable. En la

siguiente imagen vemos el editor de datos con un cuadro de diálogo abierto para una

variable:

Imagen 3.3: Editor de datos en R-Commander.

En R, la orden para la creación de una base de datos es “data.frame”, pero

antes de explicar esta orden, veamos cómo podemos crear un objeto en R y, en

particular, un vector de valores o una matriz.

33 Para crear un objeto en R hay que escribir su nombre seguido de los

caracteres que se muestran entrecomillados, “<-“, pero sin las comillas. A continuación

se escribe la expresión deseada. Con ello hemos realizado una “asignación” y ahora el

objeto que lleva por nombre el que pusimos a la izquierda del símbolo tiene asignado

el valor a la derecha del símbolo.

Para crear un vector debemos usar la orden “c()”, escribiendo dentro del

paréntesis los valores de cada coordenada separados por comas. Para crear una

matriz usamos la orden “matrix()”, especificando el número de filas con “nrows” y el

número de columnas con “ncol”

Volviendo a la creación de datos, la orden “data.frame” tiene la siguiente

sintaxis:

data.frame(..., row.names = NULL, check.rows = FALSE, check.names = TRUE,

stringsAsFactors = default.stringsAsFactors())

Tanto ésta como el resto de sintaxis que veremos en este capítulo se pueden

consultar en el centro de documentación de R, al cual podemos acceder directamente

desde la consola de comandos escribiendo “help(nombre-de-la-función)”. Para hacer

uso de este comando, lo esencial es introducir al principio del paréntesis los datos del

modo deseado, bien sea a través de listas o vectores creados previamente con

órdenes como “c()”, generando valores o usando cualquier otra función cuya salida

sea un conjunto de datos. Si se desea convertir alguna variable en factor, debe

indicarse “stringsAsFactors=TRUE”. Recordemos que un “factor” es un tipo especial

de vector que está formado por distintos niveles de la variable en cuestión, como en el

caso de las variables cualitativas. El resto son argumentos que permiten indicar los

nombres de las filas o hacer comprobaciones de consistencia.

Una vez que tenemos creada nuestra base de datos, puede almacenarse y

volver a cargarse en cualquier otro momento.

Pero en la realidad, lo habitual es tener una base de datos en algún formato

electrónico previo, de modo que no tengamos que generar los datos nosotros mismos,

sino tan solo importarlos. R ofrece posibilidades también para esos casos. En

particular, R es capaz de importar sin problema bases de datos que estén en formato

34 de archivo de texto, portapapeles, URL, SPSS, Minitab, STATA, Excel, Access o

dBase. Desde R-Commander lo único que tenemos que hacer es pinchar en “Datos>Importar datos”, elegir la fuente y seguir las instrucciones. La orden equivalente en R

se encuentra dentro de la librería “foreign” y es “read.formato-deseado”, por ejemplo,

“read.spss”. La sintaxis de esta orden es:

read.spss(file, use.value.labels = TRUE, to.data.frame = FALSE, max.value.labels =

Inf, trim.factor.names = FALSE, trim_values = TRUE, reencode = NA, use.missings =

to.data.frame)

Donde los principales argumentos que se usarán son:

“file”: es el archivo original que queremos importar. Tenemos que escribir el

nombre y la ubicación dentro de nuestro ordenador (c:/Archivos de

programas/...)

“use.value.labels”: sirve para convertir variables con etiquetas de valores en

factores de R con esos niveles.

”to.data.frame”: permite devolver el marco de datos.

“max.value.labels” indica si sólo deben convertirse a factores aquellas variables

con etiquetas de valores.

Y el resto son argumentos para recodificar datos (aunque se recomienda usar por

separado la función “recode”, que se explica en este mismo capítulo), para el

tratamiento de los espacios en blanco o los datos perdidos. Un “dato perdido” es una

casilla en la base de datos (el data.frame) que no tiene ningún valor asignado. Estos

valores surgen en algunas ocasiones cuando una base de datos tiene valores que son

incorrectos, están ausentes o presentan anomalías. En algunos de estos casos se le

puede asignar al individuo un valor que sea congruente con el resto de caracteres,

mediante “técnicas de imputación”. Los casos que queden irremediablemente sin un

valor asignado son los que llamaremos “valores perdidos” o “missing”. R se referirá a

estos valores como “NA”.

Por último, antes de comenzar con los análisis estadísticos, es posible que

todavía quede un fleco suelto en nuestra base de datos: que algunas variables no

tengan el formato adecuado para los análisis que queremos realizar con ellas. En ese

35 caso, la solución consiste en recodificar dichas variables. En R-Commander

realizamos esta tarea entrando en “Datos->Modificar variables de los datos activos>Recodificar variables”. R, por su parte, cuenta con la función “recode”, que se detalla

a continuación:

La sintaxis de la función recode es:

recode(var, recodes, as.factor.result, as.numeric.result=TRUE, levels)

Donde:

“var” es la variable a recodificar (vector numérico, vector de cadena o factor).

“recodes” son las instrucciones propias de la recodificación. Si queremos

recodificar un valor aislado, sencillamente se escribirá el valor antiguo, se

pondrá “=” y se igualará al valor nuevo asignado. Si queremos recodificar

varios valores a un mismo valor nuevo, podemos usar la notación de vector,

por ejemplo c(1,2,5)=9, lo que hará que todos los valores que antes eran 1, 2 o

5, ahora valgan 9. Si además los valores que queremos recodificar en un único

valor nuevo están seguidos, podemos usar la notación “:” para indicar un rango

de valores, por ejemplo, 5:10=’Aprobado’. Y si queremos recodificar el resto de

valores que faltan por recodificar, podemos indicarlo mediante “else”, que hace

referencia a todo lo que queda por especificar.

“as.factor.result es un valor lógico que indica si se devuelve un factor.

“as.numeric.result” es un valor lógico que hace que los resultados se

consideren numéricos.

“levels” es un argumento opcional para especificar el orden de los niveles del

factor devuelto.

Con todo lo anterior, ya sabemos lo básico y estamos en condiciones de usar R

con una base de datos para comenzar a realizar análisis sobre los mismos, como

veremos en los siguientes apartados.

36 3.2 Estadística descriptiva básica con R

Antes de realizar cualquier análisis estadístico, es muy recomendable realizar

un análisis descriptivo de las variables que entran en juego. Lógicamente, las medidas

y gráficas consideradas dependerán de la naturaleza de cada variable. A continuación

se exponen diferentes formas de explorar y mostrar la información de las variables,

según sean categóricas, cualitativas ordinales, cuantitativas, de intervalo o de razón.

3.2.1 Variables categóricas.

En caso de tener variables categóricas, al no tener valores numéricos ni orden,

lo que procede es calcular la distribución de frecuencias y, en todo caso, la moda.

Gráficamente sería adecuado decantarse por un diagrama de sectores.

Para calcular la distribución de frecuencias (con los porcentajes) desde RCommander, podemos seleccionar “Estadísticos -> Resúmenes -> Distribución de

Frecuencia”, elegir la variable y pulsar aceptar. Las órdenes correspondientes en R

son:

> .Table<-table(Datos$V1)

> 100*.Table/sum(.Table)

“Datos” es el nombre que le hayamos puesto al data.frame, es decir, la base de datos

con la que estamos trabajando y “V1” es la variable objeto de estudio dentro de

data.frame. El comando “table” nos tabula las frecuencias absulutas y mediante la

segunda orden obtenemos las relativas. En la imagen 3.4 puede verse el ejemplo

sencillo de una variable dicotómica con sus frecuencias absolutas y relativas

tabuladas:

Imagen 3.4: Ejemplo de tablas de distribución de frecuencias.

37 Es posible que queramos calcular también los intervalos de confianza para las

proporciones

calculadas,

o

realizar

un

contraste

de

hipótesis.

La

orden

correspondiente en R para dichas operaciones es “prop.test” y se explica a

continuación:

prop.test(x, n, p = NULL, alternative = c("two.sided", "less", "greater"), conf.level =

0.95, correct = TRUE)

Donde:

“x” puede ser el vector con el recuento de éxitos o una matriz con el recuento

de éxitos y fracasos.

“n” es el vector de recuento de intentos, salvo que ya estuviese incluido en el

argumento anterior.

“p” es un vector de probabilidades de los sucesos, por lo que oscilará entre 0 y

1 y su longitud coincidirá con la de “x”.

“alternative” es una cadena de caracteres con la hipótesis alternativa, que

puede ser "two.sided" (dos colas), "greater" (mayor que) or "less" (menor que).

Basta con dar la inicial. Se usa con la hipótesis nula de que una proporción es

igual a un valor dado, o dos proporciones son iguales. En ningún otro caso.

“conf.level” es el nivel de confianza del intervalo de confianza, expresado entre

0 y 1. Se usa en los mismos casos que el argumento anterior.

“correct” es un valor lógico que indica si debe usarse corrección por

continuidad de Yates48.

Entre los objetos que devuelve esta función, los más importantes son:

“statistic”: devuelve el valor del estadístico chi-cuadrado de Pearson.

“parameter”: devuelve los grados de libertad de la distribución chi-cuadrado

aproximada.

“p.value”: devuelve el p-valor del test.

“conf.int”: devuelve un intervalo de confianza para el parámetro poblacional si

hay un grupo, o para la diferencia de proporciones si hay dos grupos y no se

especifica el valor de “p”.

38 Imagen 3.5: Ejemplo de contraste de hipótesis y cálculo de un intervalo de confianza

para una proporción en R.

La moda no viene implementada en R, de modo que tendremos que crear

nuestra propia función. Normalmente no es necesario calcular la moda porque puede

verse simplemente mirando la distribución de frecuencias. No obstante, es posible que

en algunos casos concretos venga bien tener definida dicha función. Podemos

programar la función moda como sigue:

> moda=function(x){names(sort(table(x),decreasing=T))[1]}

Siguiendo con el ejemplo anterior, si definimos la función moda y solicitamos la

moda de dicha variable, obtenemos que su valor es la categoría “Sí”, como puede

verse en la imagen 3.6.

Imagen 3.6: Ejemplo de aplicación de la función “moda” definida manualmente.

Finalmente, para representar los datos a través de un diagrama de sectores,

podemos seleccionar “Gráficas->Gráfica de sectores” desde R-Commander y

conformarnos con las opciones que R-Commander estime oportunas para dicha

representación, o bien podemos tomar el control sobre las opciones usando la función

“pie” en R, que se describe a continuación:

La función “pie” tiene la siguiente sintaxis:

39 pie(x, labels = names(x), edges = 200, radius = 0.8, clockwise = FALSE, init.angle =

if(clockwise) 90 else 0, density = NULL, angle = 45, col = NULL, border = NULL, lty =

NULL, main = NULL, ...)

Donde los principales argumentos que se usarán son:

“x”: es un vector de cantidades no negativas cuyos valores se muestran en las

areas de las porciones del sector.

“labels”: son las etiquetas para las porciones.

“radius”: es el radio del sector, que se puede reducir para dejar espacio a las

etiquetas.

“col”: es el vector de colores que se desea usar. Se recomienda cargar el

paquete “colorspace” (desde “Paquetes->Cargar paquetes” en R) para

aumentar las posibilidades de coloreado de la gráfica, con funciones como por

ejemplo “rainbow_hcl”, que distribuye todo el espectro de colores según el

número de objetos a colorear.

“main”: sirve para introducir un título.

Y el resto de argumentos permiten, esencialmente, personalizar la gráfica todo lo que

se quiera. Un ejemplo de gráfico de sectores realizado en R a través de la orden “pie”

es el siguiente:

>

pie(table(Datos$ANDAR_FUERA),

edges=200,

radius=0.7,

labels=levels(Datos$ANDAR_FUERA),

density=30,

angle=45,

main="ANDAR_FUERA",

col=rainbow_hcl(length(levels(Datos$ANDAR_FUERA))))

Figura 3.7: Gráfico de sectores en R.

40 Si quisiéramos dibujar varios gráficos juntos, debemos usar la orden

“par(mfrow=c(x,y))”, donde “x” es el número de filas e “y” el número de columnas en

los que queremos dividir el espacio gráfico.

3.2.2 Variables cualitativas ordinales.

Cuando tenemos variables cualitativas ordinales, lo adecuado es dar sus

medidas de posición, generalmente la mediana y el resto de cuartiles como medidas

centrales (aunque puede considerarse cualquier cuantil) y el recorrido intercuartílico

como medida de dispersión. La representación gráfica más recomendada es el

diagrama de barras.

Para calcular los cuantiles desde R-Commander podemos entrar en

“Estadísticos->Resúmenes->Resúmenes

numéricos”,

seleccionar

la

variable

y

especificar los cuantiles deseados. La orden desde R es:

> numSummary(Datos[,"V1"], statistics=c("quantiles"), quantiles=c(0,.25,.5,.75,1))

Donde “Datos” es el nombre de la base de datos (data.frame), “V1” es la

variable objeto de estudio y los valores 0,.25,.5... corresponden a los cuantiles

concretos que se quieran calcular. En el ejemplo se están calculando el mínimo, Q1, la

mediana, Q3 y el máximo. Podemos ver un ejemplo de los resultados de este análisis

en la imagen 3.8.

Imagen 3.8: Ejemplo del cálculo de cuantiles.

El recorrido intercuartílico relativo se define como el cociente entre la diferencia

de los cuartiles tercero y primero, y la mediana. No existe una orden para su cálculo

directo, de modo que tendremos que definirlo a mano a partir de los cuartiles ya

obtenidos:

> RIR<-as.numeric((Q3-Q1)/Q2)

41 En el ejemplo anterior, si solicitamos el cálculo de este parámetro obtenemos:

Imagen 3.9: Ejemplo del cálculo de recorrido intercuartílico relativo.

Para la representación del diagrama de barra, entramos en “Gráficas->Gráfica

de barras” y elegimos la variable, todo ello desde R-Commander. No obstante, es

recomendable hacer las representaciones gráficas siempre desde R, ya que nos

permite controlar todos los aspectos relacionados con el gráfico. Para ello contamos

con la función “barplot”, que se detalla a continuación:

La sintaxis de la función barplot es:

barplot(height, width = 1, space = NULL, names.arg = NULL, legend.text = NULL,

beside = FALSE, horiz = FALSE, density = NULL, angle = 45, col = NULL, border =

par("fg"), main = NULL, sub = NULL, xlab = NULL, ylab = NULL, xlim = NULL, ylim =

NULL, xpd = TRUE, log = "", axes = TRUE, axisnames = TRUE, cex.axis =

par("cex.axis"), cex.names = par("cex.axis"),

inside = TRUE, plot = TRUE, axis.lty

= 0, offset = 0, add = FALSE, args.legend = NULL, ...)

Donde los principales argumentos que se usarán son:

“col” y “main”, que son argumentos ya explicados en la función “pie”.

“height” es un vector o matriz que determina las alturas de las barras que

formarán el gráfico. Si es un vector, el gráfico será de barras sencillas con sus

alturas. Si es una matriz, el gráfico será de barras juxtapuestas o apiladas,

dependiendo del valor lógico en el argumento “beside”.

“names.arg” es el vector de nombres que se quieren colocar bajo cada barra.

“beside” es un valor lógico que indica si las barras en “height” deben apilarse

(FALSE) o aparecer en juxtaposición (TRUE).

“sub” añade un subtítulo al gráfico.

“xlab” e “ylab” son las etiquetas de los ejes, y “xlim” e “ylim” sus límites.

“add” es un valor lógico que indica si las barras deberían agregarse a un

gráfico previo.

42 Y el resto de argumentos permiten, esencialmente, personalizar la gráfica todo lo que

se quiera. Podemos ver a continuación un ejemplo de diagrama de barras:

> barplot(table(Datos$GRUPOS_EDAD), xlab="Grupos de edad", ylab="Frecuancia",

col=c("green"), main="Distribución por edades", sub="Población global")

Figura 3.10: Ejemplo de diagrama de barras en R.

3.2.3 Variables cuantitativas.

En esta ocasión las medidas recomendadas son la media y la desviación típica.

En cuanto a gráficos, el diagrama de barras, detallado en el apartado anterior, se

presenta como la opción más adecuada.

En

R-Commander,

podemos

entrar

en

“Estadísticos->Resúmenes-

>Resúmenes numéricos”, seleccionar la variable e indicar que deseamos la media y la

desviación típica. No obstante, el valor “sd” devuelto no es la desviación típica de la

población, sino la cuasi-desviación típica calculada a partir de la muestra de tamaño n

con n-1 en el denominador. La orden correspondiente en R es:

> numSummary(Datos[,"V1"], statistics=c("mean", "sd"))

43 Donde “Datos” es el nombre de nuestra base de datos (data.frame) y “V1” el

nombre de la variable objeto de estudio dentro de data.frame. Obsérvese que pueden

realizarse con una sola orden los calculos de la media, desviación típica y cuantiles, si

fuera necesario:

> numSummary(Datos[,"V1"], statistics=c("mean", "sd", "quantiles"),

quantiles=c(0,.25,.5,.75,1))

Un ejemplo de lo anterior puede verse en la imagen 3.11.

Imagen 3.11: Ejemplo del cálculo de la media, DT y cuantiles en R.

3.2.4 Variables de intervalo.

Cuando se trata de datos que están recogidos o van a presentarse en forma de

intervalos, la media y la desviación típica siguen siendo medidas adecuadas. En lo que

a gráficas se refiere, la elección correcta es el histograma.

Desde R-Commander podemos dibujar un histograma entrando en “Gráficas>Histograma”, pudiendo elegir entre el recuento de frecuencias, los porcentajes o las

densidades como escala de los ejes. No ostante, se insiste en la recomendación de

dibujar usando directamente los comandos de R, en esta ocasión la función “hist”,

cuya sintaxis es:

hist(x, breaks = "Sturges", freq = NULL, probability = !freq, include.lowest = TRUE,

right = TRUE, density = NULL, angle = 45, col = NULL, border = NULL, main =

paste("Histogram of" , xname), xlim = range(breaks), ylim = NULL, xlab = xname, ylab,

axes = TRUE, plot = TRUE, labels = FALSE, nclass = NULL, warn.unused = TRUE,

...)

Los principales argumentos ya han sido explicados con anterioridad en otras funciones

gráficas. El argumento “freq” es un valor lógico que indica si el histograma debe

44 representarse con las frecuencias (TRUE) o densidades de probabilidad (FALSE). El

resto de argumentos permiten personalizar el gráfico, pero no son necesarios. En la

figura 3.12 podemos ver un ejemplo de histograma en R, generado a partir del

siguiente código:

Hist(Datos$ALTURA_RECOD,

scale="percent",

breaks="Sturges",

col="red",

main="Ejemplo de histograma", xlab="Alturas", ylab="Porcentajes", density=20,

angle=110)

Figura 3.12: Ejemplo de histograma en R

3.2.5 Variables de razón.

Una variable de razón es similar a una de intervalo, con la diferencia de que

cuenta con un cero absoluto, es decir, el valor cero representa la ausencia total de

medida. Por ejemplo, la temperatura (ºC) es una variable de intervalo (la diferencia

real entre 2 y 3 grados es la misma que entre 40 y 41 grados), pero no de razón (0ºC

no es ausencia de temperatura y no se pueden afirmar cosas como que con 30ºC

haga el doble de calor que con 15º). En cambio, el peso (Kg) sí es de razón porque

0Kg es ausencia de peso y se pueden afirmar cosas como que un objeto de 20Kg

pesa el doble que otro de 10 Kg.

Para el caso de variables de razón podemos usar la media geométrica como