Teorema del Límite Central

Anuncio

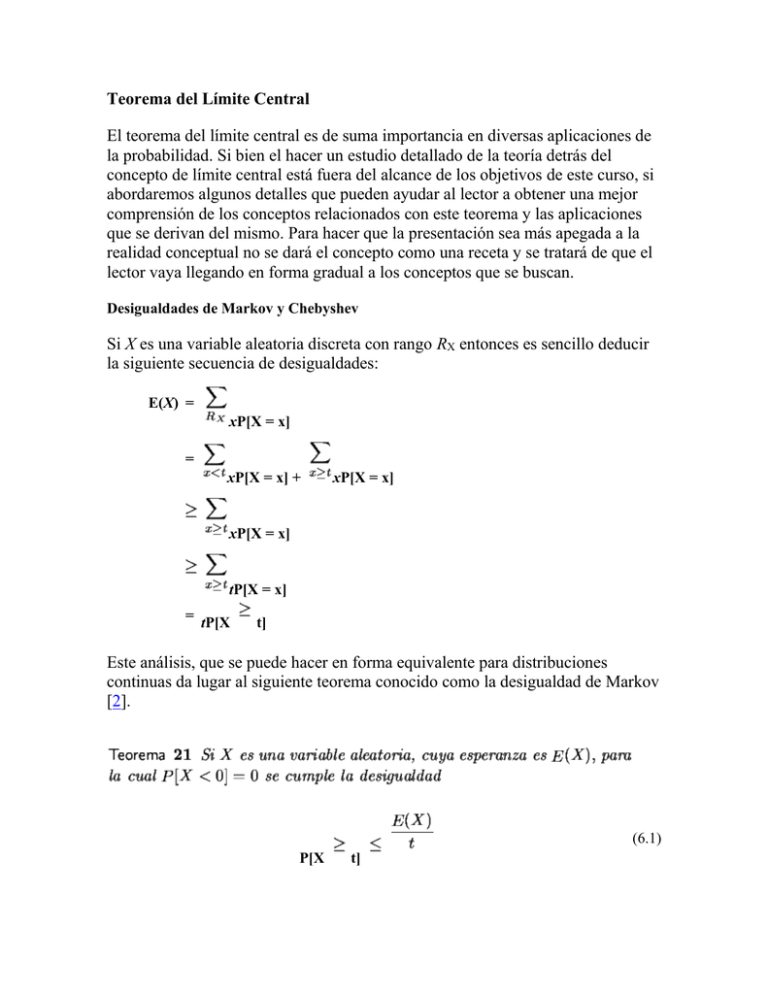

Teorema del Límite Central El teorema del límite central es de suma importancia en diversas aplicaciones de la probabilidad. Si bien el hacer un estudio detallado de la teoría detrás del concepto de límite central está fuera del alcance de los objetivos de este curso, si abordaremos algunos detalles que pueden ayudar al lector a obtener una mejor comprensión de los conceptos relacionados con este teorema y las aplicaciones que se derivan del mismo. Para hacer que la presentación sea más apegada a la realidad conceptual no se dará el concepto como una receta y se tratará de que el lector vaya llegando en forma gradual a los conceptos que se buscan. Desigualdades de Markov y Chebyshev Si X es una variable aleatoria discreta con rango RX entonces es sencillo deducir la siguiente secuencia de desigualdades: E(X) = xP[X = x] = xP[X = x] + xP[X = x] xP[X = x] tP[X = x] = tP[X t] Este análisis, que se puede hacer en forma equivalente para distribuciones continuas da lugar al siguiente teorema conocido como la desigualdad de Markov [2]. (6.1) P[X t] Esta desigualdad permite hacer aproximaciones vagas acerca del comportamiento de variables aleatorias tomando en cuenta únicamente la esperanza. Veamos el siguiente ejemplo. Ejemplo 30 En una caja hay 10 bolillas rojas y 6 negras. Se extraen con remplazo 8 bolillas y se registra el número de bolillas rojas extraídas. X sigue una distribución binomial b(x;8, 10/16) y usando la herramienta para binomiales, es simple verificar por ejemplo que P[X 0.3697. 6] = 1 - P[X Utilizando la desigualdad de Markov se obtiene que P[X 6] 5] = 5/6 = 0, 8333. Comparando estos dos valores nos damos cuenta que la cota que se obtiene por la desigualdad de Markov no necesariamente es buena. Es importante notar que si en la desigualdad (6.1) utilizamos t = n P[X n obtenemos ] Es decir la probabilidad de que los valores de una variable aleatoria estén a más de n veces la media es menor a 1/n. Si además de la media o esperanza se conoce la varianza entonces existe la posibilidad de hacer acotaciones con un poco más de precisión. Supongamos que X es una variable aleatoria con esperanza consideramos la variable aleatoria (X - y varianza )2, aplicando la desigualdad de Markov a esta variable, cuya esperanza es precisamente P[(X - )2 Si t2] (3.9), se obtiene Dado que (X )2 t2 es equivalente a | X conocido como la desigualdad de Chebyshev. | t se obtiene el teorema (6.2) P[| X - )| t] La desigualdad de Chebyshev permite acotar la probabilidad de que los valores de la distribución queden alrededor de la media. Estas aproximaciones no necesariamente son buenas, no obstante mejorar los resultados que se pueden obtener con esta desigualdad implicaría restringir mucho las hipótesis iniciales, como se verá en un ejemplo posterior. Ejemplo 31 Una persona puede digitar un texto en un tiempo que sigue una distribución con media 50 minutos y desviación 10 minutos. Para estimar una cota para la probabilidad de que esta persona tarde entre 30 y 50 minutos se puede recurrir a la desigualdad de Chebyshev y se obtiene P[30 T 70] = 1 - P[| X - 50| 20] 1- = Aún cuando este tipo de estimaciones pueden resultar innecesarias cuando se dispone de la distribución de probabilidad el ejemplo siguiente sirve para comparar los resultados que se obtienen usando la de la desigualdad (6.2). Ejemplo 32 El tiempo que tarda un computador en resolver un problema sigue una distribución exponencial con media 2 minutos. Para estimar la probabilidad que el tiempo de solución de un problema al azar esté entre 0 y 6 minutos si utilizamos la desigualdad de Chebyshev obtenemos P[0 T 6] = 1 - P[| X - 2| 4] 1- = .75 Es decir con la desigualdad de Chebyshev obtenemos que la probabilidad de que el tiempo esté entre 0 y 6 minutos es superior a 0.75. Si usamos la distribución en forma directa obtenemos que: P[0 T dx = 1 - e-3 = 0.95 6] = Lo que nos indica que las cotas que se obtienen de la desigualdad de Chebyshev pueden no ser muy buenas, no obstante como veremos no es tan fácil mejorar las cotas que se obtienen con esta desigualdad sin imponer restricciones adicionales. El siguiente ejemplo, [2], es ilustrativo en ese sentido. Ejemplo 33 Sea X una variable aleatoria discreta cuya distribución de probabilidad se da en la siguiente tabla: x1 = - 2 x2 = 0 x3 = 2 P[X = x1] = 1/8 P[X = x2] = 3/4 P[X = x3] = 1/8 Es muy sencillo verificar que E[X] = 0 y que VAR[X] = 1 Si aplicamos la desigualdad de Chebyshev obtenemos que P[| X - | 2] que en este coincide con el valor pues P[| X - | 2] = P[X = 2] + P[X = - 2] = + = Este ejemplo indica que aún cuando las cotas obtenidas de la desigualdad (6.2) no siempre son buenas a veces son exactas. Leyes de los Grandes Números Para poner en contexto las implicaciones de este teorema es importante revisar las siguientes observaciones. Dado un experimento con espacio muestral , para un evento se ha indicado que si se hacen n repeticiones del experimento y se nota que en esas n repeticiones del experimento ocurren (n) veces el evento , intuitivamente se define la probabilidad del evento por P[ ]= . Sin embargo, como ya hemos apuntado antes esta definición deja abiertas una serie de preguntas. Por ejemplo si aceptamos definir la probabilidad como el valor límite de estos cocientes entonces la definición se complica. Primero que todo, qué garantiza que ese límite existe, segundo esta definición no es operacional en el sentido de que no es posible repetir infinitamente tal experimento. Estudiaremos la ley de los grandes números que nos ayudará a precisar un poco mejor el sentido de (6.3) P[ ]= . Simplificando un poco el problema, cada una de las repeticiones del experimento que se realicen en el contexto citado puede verse como un ensayo de Bernoulli donde el éxito coincide con la ocurrencia de . Así el número de éxitos X en los n ensayos del experimento es una variable aleatoria binomial en la cual la probabilidad de éxito es un valor desconocido p. Para esta variable sabemos que la media es np y la varianza es np(1 p) (teorema 15). Si consideramos la variable aleatoria Y = X / n es muy sencillo demostrar que la esperanza de Y es np/n = p y que la varianza es (np(1 - p))/n2 = p(1 - p)/n. Aplicando la desigualdad de Chebyshev a Y con t = obtenemos: (6.4) P -p . Es decir el límite (6.3) existe o dicho en palabras algo más simples dada cualquier precisión se puede encontrar un valor n de manera que el cociente éxitos entre el total de ensayos esté tan cerca del valor p desconocido como queramos. En cierta forma esta última desigualdad da legitimidad al proceso estadístico que se ha citado en la definición (10), pues garantiza que el proceso descrito en esta definición en realidad converge al valor de la probabilidad del evento. Por supuesto que no resuelve en forma simple el problema operacional de saber cuál debe ser el número de repeticiones del experimento necesarias para obtener aproximaciones precisas de la probabilidad buscada. Se puede utilizar la desigualdad de Chebyshev para obtener aproximaciones del valor de n pero el teorema del límite central, que abordaremos en la sección siguiente será de mayor utilidad en ese sentido. Las conclusiones que se han obtenido hasta ahora se resumen en el siguiente teorema conocido como una forma débil de la ley de los grandes números [2]. (6.5) P - P[ ] = 0. Paralela a la la forma débil de la ley de los grandes números existe una generalización que se llama la Ley de los grandes Números cuya justificación está fuera de los objetivos de este curso [6] y se enuncia en el siguiente teorema: (6.6) P - ] = 0. Dicho en otras palabras la probabilidad de que el promedio Sn/n difiera de la esperanza menos que un cualquiera, tiende a uno. El Teorema del Límite Central El último teorema de la sección previa es generalizado por otro teorema cuya importancia en aplicaciones de la probabilidad y estadística es mucho mayor. El teorema del límite central se enuncia seguidamente: (6.7) P x Donde y = (y) - (x). (z) es la distribución normal estándar. La importancia de este teorema es enorme, en especial porque no tiene ninguna condición especial sobre el tipo de distribución al que se aplica. Puede ser continua o discreta, no importa como sean, en promedio la suma de estas variables se distribuyen como una normal con media n aleatoria media y varianza n . Este teorema también es válido para la variable = Sn/n para la que, si n se hace grande, distribuye como una normal de y varianza /n. Para explorar mejor el valor de este teorema se presesenta la siguiente aplicación que permite partir de una distribución de datos cualquiera y analizar la distribución de probabilidad de los posibles promedios de muestras sobre la distribución original. Aproximación Normal Binomial El teorema del límite central tiene una implicación adicional que también resulta sorprendente. Si Sn sigue una distribución binomial de parámetros n y p entonces si x y y son enteros no negativos tales que x < y, según el teorema del límite central se tiene que si n es suficientemente grande se cumple. (6.8) P x Sn - y . Este resultado se conoce como la aproximación normal de la binomial y dado que es aproximación continua de una distribución discreta deben tenerse algunos cuidados adicionales. La mejor manera de utilizar este resultado puede obtenerse en la expresión: (6.9) pk(1 - p)n - k = - El valor 1/2 que se agrega a cada lado se llama un factor de corrección de continuidad. La razón para agregar tal factor de corrección es que si uno usa una distribución normal, que es continua, para aproximar una binomial que es discreta, en cada extremo del intervalo la distribución discreta incluye la mitad de una barra que la distribución continua omite, por eso debe agregarse. Las siguientes gráficas pueden ayudarle a comprender la necesidad de este factor de corrección. Ejemplo 34 Se sabe que en una ciudad el 35% de los habitantes tienen sobrepeso. Se eligen 500 personas, cuál es la probabilidad de que haya entre 200 y 300 con sobrepeso. La solución de este problema se obtiene por la expresión (0.35)k(0.65)500 - k - . Usando la herramienta para cálculo de binomiales se obtiene que la parte izquierda es 0.008864 mientras que la parte derecha, usando la herramienta correspondiente es 0.0108. Existen varios criterios para asegurar la precisión de este tipo de aproximaciones. Los ejemplos abundan, por ejemplo en [5] se afirma que si np 5 y n(1 - p) 5 la aproximación es adecuada, en [2] se presenta un resumen de diferentes condiciones para asegurar precisión, al final de cuentas lo que si es válido es que valores de p muy cercanos a 0 o 1 hacen que las aproximaciones normales de binomiales no sean buenas. En la Herramienta que se da a continuación el lector puede colocar valores de n y p y verificar por si mismo la calidad de la aproximación normal de la binomial. Ejemplo 35 Dos empresas de venta de servicios telefónicos optan por el mismo mercado, hay n clientes que seleccionan al azar alguna de las dos empresas. Si una de las empresas tiene capacidad de atender a lo sumo r < n clientes entonces la probabilidad de que esta empresa reciba solicitudes de más de r clientes está dada por (.5)k(.5)n - k 1- =1Por ejemplo si hay 1000 clientes y una de las empresas desea que el total de solicitudes sin atender no exceda el 10% entonces usando las herramientas disponibles se obtiene que 0.9, de donde se obtiene que r = 520, líneas bastarán para satisfacer al menos el 90% de las demandas de servicio. Si ese porcentaje se elevara y se quisiera que el porcentaje de solicitudes sin atender no exceda el 1% entonces se debe resolver 0.99, usando las herramientas disponibles y despejando se obtiene que r = 537 líneas son suficientes. Esta aproximación no solo es buena, es excelente como puede verificarse usando las herramientas para binomiales que se han programado. Para estas herramientas se ha obtenido una precisión sorprendente, si hiciéramos el mismo análisis pero con una probabilidad de 0.7 de que cada cliente elija a esta empresa; usando la aproximación normal se obtendría que se necesitan 734 líneas si se usa la binomial en forma directa se ve que 733 bastan. Se invita al lector a ver el comportamiento para otros valores de p. Como nota aparte es interesante hacer notar que el desempeño de estas herramientas programadas mejoran los resultados que se obtienen en tablas como las de [6] además permiten una serie de exploraciones que de otra manera serían muy complicadas. Estimadores Un estimador de un parámetro de una variable aleatoria X es una variable aleatoria, que puede depender de una muestra aleatoria X1, X1,..., Xn. Los dos estimadores más usuales son el promedio usual llamado también media muestral y denotado por y la varianza muestral denotado por S2. Estos estimadores son a su vez variables aleatorias, (6.10) = Xi (6.11) S2 = (Xi - )2 La desviación estándar muestral S es la raíz de la varianza. Como sus nombres lo indican, se tiene que , S2 lo es para la varianza Var[X] y S para la desviación esperanza estándar es un estimador para la . El siguiente teorema, que en algunos textos [5] se llama teorema del límite central, es sumamente útil pues permite resolver diversos ejercicios de manera bastante simple. 1. E[ ]= 2. E[S2] = 3. Var[ ] = 4. Si n es suficientemente grande, entonces la variable Z= (6.12 ) 5. sigue una distribución que se aproxima a una normal estándar. Este teorema puede ampliarse de forma directa a la distribución T = n = X1 + X2 + ... + Xn la cual también sigue una distribución normal con media n y desviación estándar . Nuevamente, entre mayor sea el valor de n mejor será la aproximación. Hemos desarrollado una aplicación que nos permite simular el comportamiento de los promedios de las varianzas cuando se parte de una distribución con k valores cualesquiera y se estudia valores de n suficientemente grandes. El estudiante puede variar la distribución de probabilidad inicial así como los datos iniciales y la herramienta le muestra cual es la distribución de probabilidad de la variable promedio. El estudiante mediante exploración podrá validar los resultados que se han discutido previamente, en especial puede ver como a valores mayores de n la distribución de las medias se acerca más a una normal. En papel la aplicación es bastante simple, toma una distribución de probabilidad y un valor n que es el tamaño del muestreo. Calcula todas las combinaciones de X1, X2,..., Xn, hace los promedios, les calcula las probabilidades a cada uno y construye la distribución de probabilidad de los mismos, la cual se presenta en forma de tabla y en forma gráfica. Algunos Ejemplos Ejemplo 36 En una gran empresa el 60% de las personas tiene problemas de tensión. Cuál es la probabilidad de que en una muestra de 1000, 615 o más presenten este problema. Solución Este problema es de tipo binomial, puede resolverse calculando en forma directa 1 - B(614;1000,.6) lo que conduce al valor 0.158528, También podemos recurrir a la aproximación normal de binomial y la probabilidad solicitada es: P[X 615] = =1- (.93597) = 0.174 Ejemplo 37 Las consultas a un sistema tienen una duración cuya media es de 4 segundos y su desviación estándar es de 1.5 segundos. Si llegan 50 consultas en forma independiente, cuál es la probabilidad de que las 50 tengan una duración promedio entre 3.5 y 3.8 segundos. Solución Si aplicamos los resultados descritos hasta ahora el promedio de la muestra de las 50 consultas sigue una distribución que es aproximadamente normal con media = 1.5/ = 4 y desviación estándar = 0.2121. Luego: P[3.5 X 3.8] = - = 0.1645. Ejemplo 38 Una sonda espacial cuenta con un juego de 10 computadores para controlar su estado. En todo momento se encuentra trabajando un único computador y estos trabajan en forma serial de manera que en el instante en que uno falle empieza a funcionar el siguiente, y así sucesivamente hasta utilizar los 10 computadores. La sonda está por pasar detrás de un planeta, por lo que se espera no tener comunicación con ella durante 4000 horas. Si cada computador opera correctamente 440 horas en promedio con una desviación estándar de 30 horas, entonces el tiempo acumulado de funcionamiento, Y de todas los computadores sigue una distribución que se puede aproximar por una normal con media 1440 y desviación estándar 30 . P[Y > 4000] = 1 =1- (- 4.21) 1. Si el promedio de funcionamiento de cada computador fuera de 410 horas y la desviación estándar de 30 entonces la probabilidad pedida sería: P[Y > 4000] = 1= 1 - (- 1.05409) = 1 - 0.14592 = 0.85408. Ejemplo 39 El rendimiento de cierto cilindro de gas está normalmente distribuido con una media de 6 horas y una desviación estándar de 0.5 horas. Este gas se vende en paquetes de 5 cilindros y en cada paquete se utilizan los cinco cilindros en forma secuencial, es decir se empieza uno solamente si se ha terminado el anterior. Se desea determinar el tiempo máximo de duración de cada paquete de manera que éste sea excedido sólo por el 3% de los paquetes. Solución Como el tiempo de duración de cada cilindro es normal la distribución del tiempo TP = T1 + ... + T5 de cada paquete también es normal con media 30 y desviación estándar 0.5 , lo que se solicita es un valor c tal que. P[TP < c] = 0.97 = P[Z < ] = 0.97 De la herramienta correspondiente se obtiene = 1.8807 es decir c = 31.977, es decir solo un 3% de los paquetes tienen una duración de más de 31.977 horas. Ejemplo 40 La duración de una batidora de un cierto fabricante es de 5 años, con una desviación estándar de un año. Si asumimos que las duraciones de estos mezcladores siguen aproximadamente una distribución normal, la aplicación de los teoremas estudiados nos permiten hacer las siguientes deducciones. Si se toma una muestra aleatoria de 9 de estas batidoras entonces como la duración de un mezclador es de 5 años con una desviación de 1 año, la duración promedio sigue una distribución normal con la media de 5 años con una desviación de = = 0.3333. Si se quiere la probabilidad de que en promedio este grupo dure entre 4.4 y 5.2 años se tiene P[4.4 5.2] = P[- 1.8 Z .60] = 0.9918 - 0.0359 = 0.9559 O por ejemplo el valor de a la derecha del cual caería el 15% de las medias calculadas de la muestras aleatorias de tamaño 9 se obtiene del cálculo. P[ ] = 0, 15 o bien P[ ] = P[Z ] = 0, 85 de la tabla y despejando se obtiene = 5, 35, es decir si se compraran 9 batidoras un 15% de éstas funcionaría por un período superior a 5.35 años. Ejemplo 41 Un médico atiende un paciente en un tiempo que es una variable aleatoria con media = 8 minutos y desviación estándar 3 minutos. Si debe atender un total de 40 pacientes la probabilidad de que atienda todos los pacientes en menos de 5 horas, asumiendo que los pacientes ingresan, en forma continua es P[T = T1 + ... + T40 300] = P[Z < ] = 0, 1469 La probabilidad de que el tiempo promedio de atención sea superior a 7.5 minutos se obtiene de P[ > 7.5] = 1 - P[Z ] = 0.8531