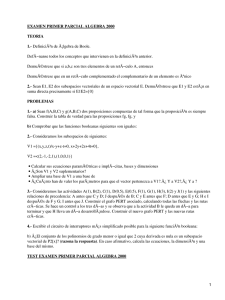

(Contents of) J. Rojo ´Algebra lineal (2a edición) Editorial MacGraw

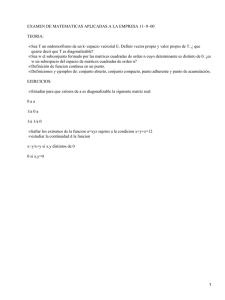

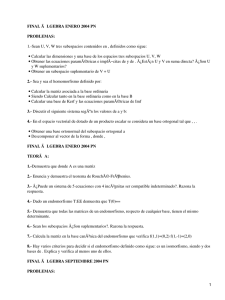

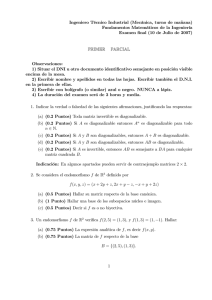

Anuncio