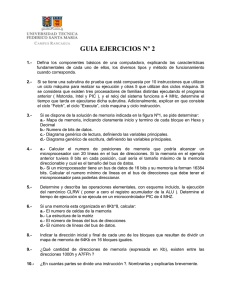

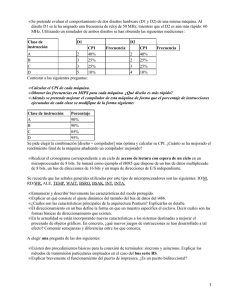

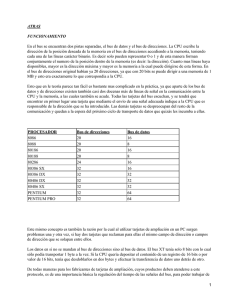

Small Computer System Interface

Anuncio