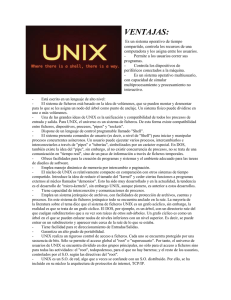

administraci´on de sistemas unix

Anuncio