La Internet que no aparece en los buscadores - e

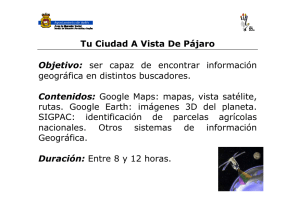

Anuncio