Chapitre 3 : solution des équations différentielles linéaires

Anuncio

Chapitre 3 : solution des équations différentielles linéaires

Philippe Chartier

20 octobre 2016

1

Systèmes différentiels linéaires

Dans cette section, E désigne un K-espace vectoriel de dimension finie d avec K = R ou K = C,

et I un intervalle ouvert de R. On étudie ici les équations différentielles linéaires du type :

ẏ(t) = A(t)y(t) + b(t)

(1.1)

où A ∈ C(I; L(E)) et b ∈ C(I; E). D’après le théorème de Cauchy-Lipschitz (dans le cas d’une

fonction globalement Lipschitzienne), on est assuré de l’existence d’une solution unique sur I au

problème de Cauchy pour f (t, y) = A(t)y + b(t), et ce pour tout (t0 , y0 ) ∈ I × E.

Remarque 1.1 On confondra souvent l’endomorphisme A de L(E) et sa représentation matricielle

dans Md (K)

Exemple 1.2

1. Le système de deux équations à deux inconnues y1 (t) et y2 (t)

ẏ1 (t) = ty1 (t) + y2 (t) − 1

ẏ2 (t) = cos(t)y1 (t) + exp(t)y2 (t)

est de la forme (1.1) avec

y1 (t)

y(t) =

,

y2 (t)

A(t) =

t

1

cos(t) exp(t)

et b(t) =

−1

0

.

2. L’équation différentielle du second ordre

ÿ(t) + q(t)y(t) = 0

est également de la forme (1.1), avec y1 (y) = y(t), y2 (t) = ẏ(t), b(t) = (0, 0)T et

0

1

A(t) =

.

−q(t) 0

1

1.1

Formule intégrale et résolvante

(i) Systèmes différentiels homogènes

On suppose dans un premier temps que b ≡ 0. On dit alors que le système est homogène.

Théorème 1.3 L’ensemble V des solutions de l’équation (1.1) avec b ≡ 0 est un sous-espace vectoriel de C 1 (I; E) de dimension finie d. Plus précisément, si y(t; t0 , y0 ) désigne la solution au temps t

de l’équation (1.1) avec condition initale y(t0 ) = y0 , alors l’application

ϕt0 : E → C 1 (I; E)

y0 7→ y(t; t0 , y0 )

est un isomorphisme d’espaces vectoriels entre E et V .

Preuve. Si y(t) et z(t) sont deux applications de C 1 (I; E) satisfaisant l’équation (1.1) pour tout

t ∈ I, alors il est clair qu’il en est de même pour (λy + µz)(t) pour tout (λ, µ) ∈ K2 , de sorte que V

est un sous-espace vectoriel de C 1 (I; E). L’unicité de la solution de (1.1) pour une condition intiale

donnée assure par ailleurs que ϕt0 est linéaire, injective et comme V = ϕt0 (E), c’est finalement une

isomorphisme de E and V . On a ainsi dim(V ) = dim(E) = d.

Définition 1.4 On appelle système fondamental de solutions de l’équation (1.1) avec b ≡ 0 une base

de l’espace vectoriel V .

Notons que, en vertu du théorème précédent, (y1 , . . . , yd ) est un système fondamental de solutions si

et seulement si il existe t ∈ I tel que (y1 (t), . . . , yd (t)) constitue une famille libre de E. La famille

(y1 (s), . . . , yd (s)) est alors libre pour tout s ∈ I. Cette équivalence est également une conséquence

de la proposition suivante :

Proposition 1.5 Soient y1 , . . . yd , d solutions de (1.1) avec b ≡ 0 et w ∈ C 1 (I; R), leur Wronskien,

défini par

w(t) = det (y1 (t), . . . , yd (t)) .

Alors, pour (s, t) ∈ I 2 , on a la formule suivante, dite de Liouville :

Z t

w(t) = w(s) exp

Tr(A(σ))dσ .

s

d

Preuve. On note Y (t) la matrice de M(K ) dont les colonnes sont constituées des vecteurs solutions

de (1.1) avec b ≡ 0, notées y1 (t), ..., yd (t). La matrice Y (t) est alors solution du système différentiel

matriciel

Ẏ (t) = A(t)Y (t).

Désignons alors par l1 (t), ..., ld (t) les lignes de Y (t) et par ai,j (t) les coeffiients de A(t) pour i et j

compris entre 1 et d. Il est immédiat que

∀i ∈ {1, . . . , d}, l˙i (t) =

d

X

j=1

2

ai,j (t)lj (t).

En remarquant que w(t) peut aussi s’écrire

l1 (t)

w(t) = det ... ,

ld (t)

on a par multi-linéarité du déterminant

l1 (t)

..

.

l (t)

d

d

d

i−1

X

˙

XX

ẇ(t) =

det li (t) =

ai,j (t) det

i=1

li+1 (t) i=1 j=1

..

.

ld (t)

l1 (t)

..

.

d

li−1 (t) X

lj (t) =

ai,i (t)w(t) = Tr(A(t))w(t).

li+1 (t) i=1

..

.

ld (t)

On obtient finalement la formule de Liouville en résolvant cette équation différentielle entre s et t.

Définition 1.6 On appelle matrice résolvante du système (1.1) avec b ≡ 0, l’unique solution du

système différentiel matriciel

Ẏ (t) = A(t)Y (t)

(1.2)

satisfaisant la condition initiale Y (t0 ) = Id , où Id désigne la matrice identité de Md (K), et on la

note S(t; t0 ).

Proposition 1.7 Pour tout (t, t0 , t1 ) ∈ I 3 , la matrice résolvante S vérifie l’égalité suivante

S(t; t0 ) = S(t; t1 )S(t1 ; t0 ).

En outre, pour tout (t1 , t0 ) ∈ I 2 , S(t1 ; t0 ) ∈ GLd (K) et

(S(t1 ; t0 ))−1 = S(t0 ; t1 ).

Par ailleurs, la solution du problème de Cauchy

ẏ(t) = A(t)y(t)

y(t0 ) = y0

est donnée par y(t) = S(t; t0 )x0 .

Preuve. La première égalité est une conséquence immédiate de l’unicité de la solution de (1.2) avec

condition initiale Y (t0 ) = Id et du fait que, pour toute matrice P ∈ Md (K) à coefficients constants,

on a

(Y ˙P )(t) = Ẏ (t)P = A(t)Y (t)P = A(t) (Y (t)P ) .

L’inversibilité de S(t1 ; t0 ) et l’expression de l’inverse s’obtiennent alors en prenant t = t0 dans cette

première égalité. Le dernier point est évident.

3

(ii) Systèmes différentiels non homogènes

On s’intéresse désormais au cas non homogène, c’est-à-dire au système (1.1) pour b quelconque

non nécessairement nul. Si z est une solution particulière de (1.1), alors l’ensemble des solutions

est l’espace affine de dimension finie d, z + V où V est l’espace vectoriel des solutions du système

homogène.

Le solution générale du système (1.1) est donnée par la formule intégrale suivante, dite formule

de Duhamel :

Z t

S(t; s)b(s)ds.

∀t ∈ I, y(t) = S(t; t0 )y0 +

t0

Elle s’obtient par la technique de variation de la constante : étant donnée S(t; t0 )y0 la solution du

système homogène, on cherche la solution de (1.1) sous la forme y(t) = S(t; t0 )z(t), de sorte que

Ṡ(t; t0 )z(t) + S(t; t0 )ż(t) = A(t)S(t; t0 )z(t) + b(t),

d’où l’on tire l’équation

ż(t) = (S(t; t0 ))−1 b(t) = S(t0 ; t)b(t).

L’intégration terme à terme entre t0 et t donne alors

Z t

z(t) =

S(t0 ; s)b(s)ds + z0

t0

où z0 reste à déterminer. En reportant z(t) dans y(t), il vient

Z t

y(t) = S(t; t0 )z0 +

S(t; t0 )S(t0 ; s)b(s)ds.

t0

La condition initiale impose de prendre z0 = y0 et la formule de Duhamel en découle.

1.2

Systèmes à coefficients constants

Dans le cas où les coefficients de la matrice A et du vecteur b ne dépendent pas du temps, le

système devient autonome et il possible d’expliciter complètement les solutions de (1.1). Dans cette

section, nous supposons donc que le système différentiel est de la forme

ẏ(t) = Ay(t) + b

avec A ∈ Md (K) et b ∈ Kd .

(i) Exponentielle de matrices

Définition 1.8 L’exponentielle d’une matrice A ∈ Md (K) est définie par la série (absolument)

convergente suivante

∞

X

1 n

A .

e =

n!

n=0

A

4

Si k.k désigne la norme matricielle subordonnée à la norme notée identiquement k.k définie sur Kd ,

alors

kAn k ≤ kAkn ,

de sorte que keA k ≤ ekAk . L’exponentielle de matrices possède un certain nombre de propriétés

remarquables dont celles établies dans la proposition suivante :

Proposition 1.9 Soient A et B deux matrices de Md (K) et 0 la matrice nulle de Md (K). On a :

— Si A et B commutent, alors eA+B = eA eB .

— e0 = Id et eA est inversible d’inverse e−A .

−1

— Si B est inversible, alors eBAB = BeA B −1 .

P

1 n

— Si A est nilpotente d’indice de nilpotence m ≤ d, alors eA = m−1

n=0 n! A .

Preuve. Le premier point s’obtient aisément par produit de Cauchy de séries absolument convergentes. Le second en est une conséquence immédiate, puisque eA e−A = e0 = Id . Le troisième repose

n

sur l’observation que (BAB −1 ) = BAn B −1 . Enfin, le dernier point est clair dès lors que An = 0

pour n ≥ m.

Remarque 1.10 Lorsque A et B ne commutent pas comme la proposition précédente, alors eA eB

est encore, sous certaines conditions que nous n’énoncerons pas ici, l’exponentielle d’une matrice

C, qui s’obtient par la fomule de Baker-Campbell-Hausdorff. Les premiers termes de cette formule

s’écrivent

1

1

C = A + B + [A, B] +

[A, [A, B] + [B, [B, A] + . . . ,

2

12

où [A, B] désigne le commutateur de A et B, à savoir [A, B] = AB − BA.

(ii) Résolvante

Dans la cas constant, la matrice résolvante devient S(t; t0 ) = e(t−t0 )A et les solutions du système

différentiel (1.1) avec b ≡ 0 s’écrivent y(t) = e(t−t0 )A y0 . La résolvante ne dépend donc que de t − t0 ,

c’est-a-dire que S(t; t0 ) = Σ(t − t0 ) où Σ(t) = etA et la propriété multiplicative devient

∀(s, t) ∈ I 2 , Σ(s + t) = Σ(s)Σ(t).

Ainsi, Σ(.) est un homomorphisme de groupes de (R, +) dans (GLd (K), ·).

(iii) Calcul des solutions du système homogène

Il est aisé de voir que si y0 est un vecteur propre de A associé à la valeur propre λ, alors t 7→

eλ(t−t0 ) y0 est solution du problème de Cauchy

ẏ(t) = Ay(t)

.

y(t0 ) = y0

5

En effet, dtd eλ(t−t0 ) y0 = λeλ(t−t0 ) y0 = A(eλ(t−t0 ) y0 ) = Ay(t). Plus généralement, si A est diagonalisable, c’est-à-dire s’il existe P ∈ GLd (K) et D ∈ Md (K) diagonale, telles que A = P DP −1 , alors

les solutions de (1.1) avec b ≡ 0 s’obtiennent par le changement de variable z(t) = P −1 y(t). Le

vecteur z(t) vérifie en effet les équations

ż(t) = P −1 AP z(t) = Dz(t)

,

z(t0 ) = z0 = P −1 y0

dont la solution est donnée par z(t) = etD z0 . Donc y(t) = P etD P −1 y0 . Lorsque A n’est pas diagonalisable, il faut recourir à sa forme de Jordan. On rappelle donc le résultat :

Proposition 1.11 Soit A ∈ Md (K) une matrice dont le polynôme caractéristique PA (x) est scindé

sur K, de la forme

l

Y

PA (x) = (−1)

(x − λj )mj

d

j=1

où les λj sont les l valeurs propres distinctes de A de multiplicités algébriques respectives mj (avec

Pl

j=1 mj = d) . La matrice A admet alors la décomposition de Jordan suivante : il existe P ∈

GLd (K) telle que

P −1 AP =

Jµ1

Jµ2

..

.

..

.

(1.3)

Jµr

où Jµ est un bloc de Jordan, c’est-à-dire une matrice de la forme

µ 1 0

. . . ..

0 µ 1

.

.

... ...

..

0

.

..

µ 1

0 ... ... 0 µ

et où les µj ∈ {λ1 , . . . , λl } ne sont pas forcément disctincs (à une valeur propre peuvent être associés

plusieurs blocs de Jordan) et où pour tout j = 1, . . . , l, on a

X

dim(Jµq ) = mj .

q=1,...,r/µq =λj

6

L’exponentielle d’un bloc de Jordan Jµ = µIm + Nm , où Nm = Jµ − µIm est nilpotente d’indice de

nilpotence m, s’obtient par application du premier point de la proposition précédente ; puisque Im et

Nm commutent, on a :

!

m−1

X tn

n

.

etJµ = etµ

Nm

n!

n=0

Il devient ainsi aisé de calculer les solutions du système homogène dans le cas où K = C, puisque C

étant un corps algébriquement clos, tout polynôme y est scindé.

Proposition 1.12 Soit A ∈ Md (C) une matrice de polynôme caractéristique

l

Y

PA (x) = (−1)

(x − λj )mj

d

j=1

où les λj sont les l valeurs propres distinctes de A de multiplicités algébriques respectives mj (avec

Pl

j=1 mj = d) . Pour tout j ∈ {1, . . . , l}, il existe mj solutions indépendantes de l’équation ẏ(t) =

Ay(t) de la forme

yj,k (t) = etλj pj,k (t), k = 1, . . . , mj ,

d

où

tλpj,k (t) est un polynôme à coefficients dans C de degré au plus k − 1. L’ensemble de ces solutions

e j pj,k (t); j = 1, . . . , l; k = 1, . . . , mj constitue un système fondamental de solutions.

Preuve. En vertu de la proposition précédente, il existe une matrice P ∈ GLd (C) telle que P −1 AP

soit de la forme (1.3). En effectuant le changement de variable z = P −1 y, le système (1.1) se

“découple” en r systèmes indépendants

żq (t) = Jµq zq (t), q = 1, . . . , r,

avec (z1T , . . . , zrT )T = z. Si dq désigne la dimension de ce sous-système (dq = dim(Jµq )), alors il

possède dq solutions indépendantes de la forme

!

!

dq −k n

dq −k n

Xt

Xt

etµq

Ndnq zq,k = etµq

zq,k+n , k = 1, . . . , dq ,

n!

n!

n=0

n=0

où les zq,kPdésignent les vecteurs de la base canonique de Cdq . A une valeur propre λj sont donc

associées q/µq =λj nq = mj solutions indépendantes de la forme etλj pj,k (t) avec pj,k (t) de degré au

plus k − 1.

Dans le cas où K = R, les solutions revêtent une forme plus complexe, en raison du fait que R n’est

pas algébriquement clos. Il est cependant possible d’exhiber la forme générale des solutions :

Proposition 1.13 Soit A ∈ Md (R) une matrice dont le polynôme caractéristique PA (x) est de la

forme

l

Y

PA (x) = (−1)

(x − λj )mj

d

j=1

7

où les λj = αj + iβj sont les l valeurs propres distinctes de A de multiplicités algébriques respectives

P

mj (avec lj=1 mj = d) . Alors il existe une système fondamental de solutions de la forme

t 7→ tr etαj cos(βj t)a et t 7→ ts etαj sin(βj t)b

où a et b sont des vecteurs de Rd et r et s deux entiers plus petits ou égaux à mj − 1.

1.3

Groupe à un paramètre

Définition 1.14 On appelle groupe à un paramètre une application différentiable, morphisme de

groupes de (R, +) dans (GLd (K), ·).

Si A est une matrice de Md (K), alors t 7→ etA est une groupe à un paramètre. Réciproquement, si

t 7→ B(t) ∈ Md (K) est une groupe à un paramètre, on a, en posant A = B 0 (0) :

B(t + h) − B(t)

B(h) − B(0)

0

B (t) = lim

= lim

B(t) = AB(t),

h→0

h→0

h

h

où l’on a utilisé les relations B(t + h) = B(h)B(t) et B(0) = Id . Ainsi, B(t) est solution du système

0

B (t) = AB(t)

,

B(0) = Id

et s’écrit donc B(t) = etA . La matrice A est dite générateur du groupe.

Exemple 1.15

1. Pour A = Id , on a {etA , t ∈ R} = {et Id , t ∈ R}. Le groupe à un paramètre

de générateur A est donc le groupe des homothéties de rapport strictement positif.

2. Le groupe à un paramètre de générateur

A=

0 −1

1 0

,

est le groupe des matrices de rotations

cos(t) − sin(t)

tA

e =

.

sin(t) cos(t)

1.4

Equations linéaires scalaires d’ordre supérieur

On s’intéresse ici aux équations différentielles du type :

z (n) (t) + an−1 (t)z (n−1) (t) + . . . + a1 (t)z (1) (t) + a0 (t)z(t) = g(t),

(1.4)

où les applications ak , pour k = 0, . . . , n − 1, et g, sont supposées continues de l’intervalle I dans

R. On suppose par ailleurs que z ∈ C n (I; R). Une telle équation est dite d’ordre n en raison de

l’occurence de la dérivée n-ième de z.

8

(i) Transformation en un système d’ordre 1

En posant y(t) = (z(t), z 0 (t), . . . , z (n−1) (t))T , b(t) = (0, . . . , 0, g(t))T

matrice compagnon

0

1

0

...

0

..

.

..

0

0

1

.

.

.

.

A(t) =

..

..

..

0

0

...

...

0

1

−a0 (t) −a1 (t) . . . −an−2 (t) −an−1 (t)

et en prenant pour A la

,

l’équation (1.4) se réécrit sous la forme d’un système différentiel linéaire (1.1) d’ordre 1 et y est solution de (1.1) si et seulement si z est solution de (1.4) . Ainsi, pour tout t0 ∈ I, et tout (z0 , . . . , zn−1 )T ∈

Rn , il existe une solution unique z(t; z0 , . . . , zn−1 ) de (1.4) satisfaisant les conditions intiales z(t0 ) =

z0 , z 0 (t0 ) = z1 , ..., z (n−1) (t0 ) = zn−1 . La structure de l’espace des solutions est également une

conséquence de cette réécriture :

Théorème 1.16 Si g ≡ 0, l’ensemble V des solutions de (1.4) est une sous-espace vectoriel de dimension n de C n (I; R). De plus, l’application

Rn → C n (I; R)

(z0 , . . . , zn−1 )T 7→ z(t; z0 , . . . , zn−1 ),

est un isomorphisme d’espaces vectoriels de Rn dans V . Si g n’est pas nulle, l’ensemble des solutions

est un sous-espace affine z̃ + V de dimension n de C n (I; R), où z̃ désigne une solution particulière

de (1.4).

(ii) Wronskien

Soient z1 , z2 , ..., zn , n solutions de l’équation (1.4) où l’on suppose que g ≡ 0. On appelle matrice

wronskienne associée à (z1 , . . . , zn ) la matrice suivante :

z1 (t)

z2 (t)

...

zn (t)

(1)

(1)

z (1) (t)

z2 (t) . . . zn (t)

1

W (t) =

.

..

..

..

.

.

.

(n−1)

z1

(n−1)

(t) z2

(n−1)

(t) . . . zn

(t)

On a alors, d’après la formule de Liouville,

Z t

∀(s, t) ∈ I , w(t) = w(s) exp −

an−1 (s)ds .

2

t0

En particulier, si an−1 ≡ 0, alors w est constant : cette propriété se traduit en termes géométriques (le

flot d’une telle équation conserve le volume).

9

(iii) Calcul des solutions

On obtient la solution générale de l’équation (1.4) en superposant une solution particulière à la

solution générale de l’équation homogène.

Cas des coefficients constants : Soient a0 , . . . , an−1 des coefficients réels et g(t) une fonction de

C(I; R). On cherche les solutions de l’équation

z (n) (t) + an−1 z (n−1) (t) + . . . + a1 z (1) (t) + a0 z(t) = g(t).

On introduit le polynôme caractéristique de l’équation :

P (X) = X n + an−1 X n−1 + . . . + a1 X + a0 .

C’est le polynôme caractéristique de la matrice compagnon A(an−1 , . . . , a0 ).

Proposition 1.17 Si λ est une racine de multiplicité m du polynôme caractéristique de A, alors les

zr (t) = tr eλt , r = 0, . . . , m − 1 sont des solutions indépendantes de l’équation (1.4) à coefficients

constants pour g ≡ 0.

Preuve. Soit donc z(t) = Q(t)eλt où Q est un polynôme de degré inférieur ou égal à m − 1. Par la

formule de Leibniz, on a

k X

j

(k)

z (t) =

Q(j) (t)(eλt )(k−j)

k

j=0

= e

λt

k

X

j=0

k!

Q(j) (t)λk−j .

j!(k − j)!

Il vient alors en posant an = 1

n

X

ak z (k) (t) = eλt

k=0

= eλt

n

X

k=0

n

X

j=0

ak

k

X

j=0

(j)

k!

Q(j) (t)λk−j

j!(k − j)!

n

n

X Q(j) (t)

Q (t) X k!

ak λk−j = eλt

P (j) (λ)

j! k=j (k − j)!

j!

j=0

et l’annulation de P (j) (λ), pour j = 0, . . . , m − 1 et de Q(j) (t) pour j ≥ m permet de conclure.

L’indépendance de ces solutions est assurée par l’indépendance de leurs valeurs initiales.

Proposition 1.18 Soient λ1 , . . . , λl les racines du polynôme caractéristique, de multiplicités respectives m1 , . . . , ml . Pour j = 1, . . . , l, on note αj et βj les parties réelle et imaginaire de λj . Alors il

existe un système fondamental de solutions de l’équation (1.4) à coefficients constants pour g ≡ 0 de

la forme :

t 7→ tr eαj t cos(βj t) et t 7→ ts eαj t sin(βj t),

où r et s deux entiers inférieurs ou égaux à mj − 1.

10

Cas des coefficients variables : On utilise ici la méthode de variation de la constante. Soit

(z1 , . . . , zn ) un système fondamental de solutions de l’équation homogène et soit W (·) la matrice

Wronskienne. Alors, il existe une solution particulière de l’équation (1.4) avec second membre g(t)

de la forme :

z(t) = c1 (t)z1 (t) + . . . cn (t)zn (t)

où les fonctions ci appartiennent à C 1 (I; R) pour i = 1, . . . , n et satisfont

0

ċ1 (t)

..

..

−1

. = W (t) . .

0

ċn (t)

g(t)

En effet, si z(t) est une solution de (1.4), on a pour y(t) = (z(t), z 0 (t), . . . , z (n) (t))T et b(t) =

(0, . . . , 0, g(t))T , le système différentiel :

ẏ(t) = A(t)y(t) + b(t)

où A(t) est la matrice compagnon associée à (an−1 (t), . . . , a0 (t)). La résolvante S(t; t0 ) s’écrit ici

S(t; t0 ) = W (t)W −1 (t0 ) et on a plus généralement S(t; s) = W (t)W −1 (s). La formule de Duhamel

devient alors :

Z

t

y(t) = W (t)W −1 (t0 )y0 +

W (t)W −1 (s)b(s)ds

t0

et en posant c(t) = W

−1

(t)y(t), on voit que

ċ(t) = W −1 (t)b(t).

2

2.1

Comportement qualitatif des solutions

Portraits de phase en dimension 2

On étudie ici en détail les portraits de phase des systèmes linéaires homogènes de dimension 2,

c’est-à-dire de la forme

ẏ(t) = Ay(t), t ∈ R+ ,

avec

A=

a b

c d

.

Le changement de variable x = P −1 y est un isomorphisme (linéaire) qui envoie les trajectoires de

ẏ(t) = Ay(t) sur les trajectoires de ẋ(t) = (P −1 AP )x(t). Il suffit donc d’étudier les trajectoires de

x(t) pour les différentes classes de similitude de A. Pour déterminer ces dernières, on introduit donc

le polynôme caractéristique de A :

PA (X) = X 2 − Tr(A)X + det(A) = X 2 − (a + d)X + (ad − bc).

On pose alors ∆ = (a + d)2 − 4(ad − bc) = (a − d)2 + 4bc ce qui conduit à distinguer les cas suivants :

11

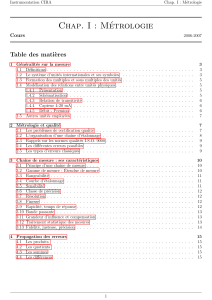

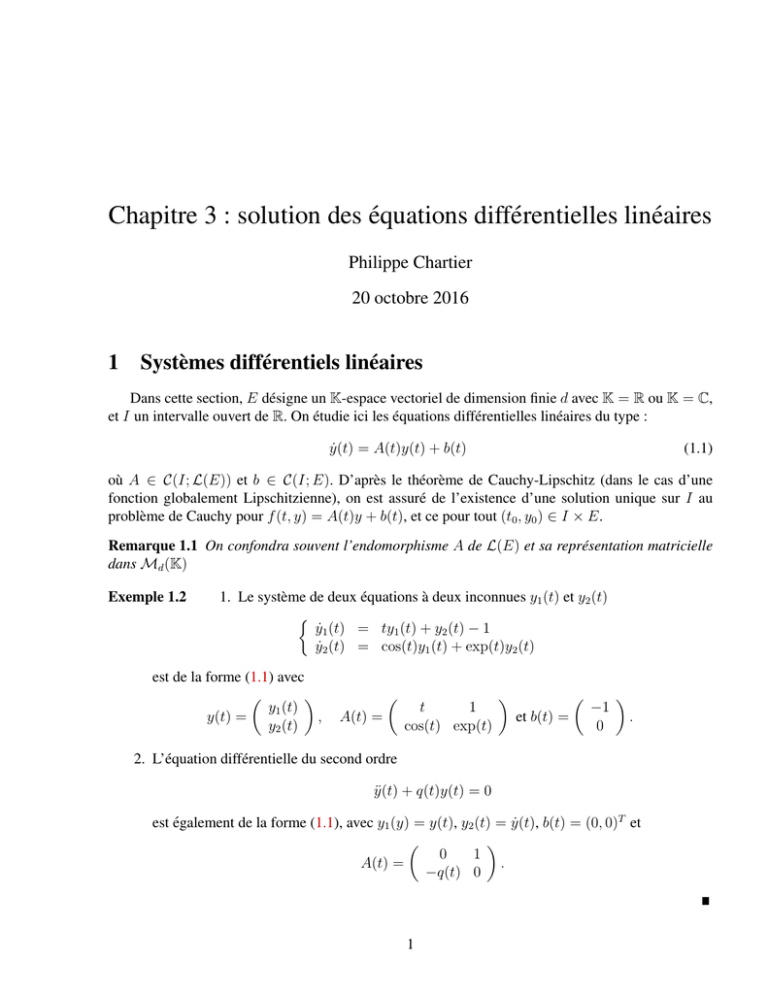

1. Premier cas : ∆ < 0. On a √

alors deux valeurs propres de A complexes conjuguées α ± iβ,

avec α = 21 (a + d) et β = 12 −∆. En prenant

β

−b 0

−1

P =

a−d

1

2b

8

8

6

6

4

4

2

2

0.5

0.4

0.3

0.2

0

x2

x2

x2

0.1

0

0

−0.1

−2

−2

−4

−4

−0.2

−0.3

−0.4

−6

−10

−8

−6

−4

−2

0

2

4

6

8

−6

−10

−8

−6

−4

−2

x1

0

x1

2

4

6

8

−0.5

−0.5

−0.4

−0.3

−0.2

−0.1

0

x1

0.1

0.2

0.3

0.4

0.5

F IGURE 1 – Foyers stable (α < 0) et instable (α > 0) ; centre (α = 0).

α −β

−1

P AP =

β α

et le passage en coordonnées polaires x1 (t) = r(t) cos(θ(t)), x2 (t) = r(t) sin(θ(t)) conduit

aux équations

ṙ = αr

.

θ̇ = β

Pour α 6= 0, les solutions correspondantes “spiralent” autour de leur point initial, soit vers

l’extérieur (lorsque α > 0), soit vers l’intérieur (lorsque α < 0) et on a un foyer instable ou

stable respectivement. Lorsque α = 0, la solution décrit un cercle (voir la figure 1).

2. Deuxième cas : ∆ > 0. On a deux valeurs propres de A réelles et distinctes, et A est alors

semblable à la matrice diagonale

λ 0

.

0 µ

Si det(A) < 0, λ et µ sont de signes opposés, et on a alors un point selle (voir la figure 2).

Si det A > 0, λ et µ sont de même signe, positif si Tr(A) > 0, et négatif dans le cas contraire

(voir là-encore la figure 2). Si det(A) = 0, l’une des deux valeurs propres de A est nulle, par

exemple µ. Suivant le signe de λ, on a alors les deux portraits de phase de la figure 3.

3. Troisième cas : ∆ = 0. Il y une valeur propre double. Si A est semblable à la matrice λI2 ,

avec λ 6= 0 (le cas λ = 0 conduit à une solution triviale stationnaire), on obtient un noeud,

soit stable (si λ < 0), soit instable (si λ > 0). Les portraits de phase correspondants sont

représentés sur la figure 4. Si A est semblable à la matrice

λ 1

,

0 λ

12

3

2

2

2

1

1

1

0

x2

3

x2

x2

3

0

0

−1

−1

−1

−2

−2

−2

−3

−8

−6

−4

−2

0

x1

2

4

6

−3

−1.5

8

−1

−0.5

0

x1

0.5

1

−3

−1.5

1.5

−1

−0.5

0

x1

0.5

1

1.5

3

3

2

2

1

1

x2

x2

F IGURE 2 – Point selle, équilibre stable, équilibre instable.

0

0

−1

−1

−2

−2

−3

−3

−2

−1

0

x1

1

2

3

−3

−3

−2

−1

0

x1

1

2

3

3

3

2

2

1

1

x2

x2

F IGURE 3 – Une valeur propre nulle et une valeur propre positive, respectivement négative.

0

0

−1

−1

−2

−2

−3

−3

−2

−1

0

x

1

2

3

1

−3

−3

−2

−1

0

x

1

2

3

1

F IGURE 4 – Noeud stable, noeud instable.

alors là-encore, trois cas se présentent suivant le signe de λ. Pour λ > 0, le portrait de phase

contient un noeud dégénéré instable. Pour λ < 0, un noeud dégénéré stable. Enfin pour λ = 0,

les trajectoires sont rectilignes. Les différents cas sont représentés sur la figure 5.

2.2

Stabilité asymptotique de l’origine

Théorème 2.1 Soit A ∈ L(E) où E est un K-espace vectoriel de dimension finie d et soit σ(A) son

spectre. Les propositions suivantes sont équivalentes :

1. Toute solution de ẏ(t) = Ay(t) tend vers 0 lorsque t tend vers +∞.

13

3

2

3

1.5

2

2

1

1

1

0

x2

x2

x2

0.5

0

0

−0.5

−1

−1

−1

−2

−2

−1.5

−3

−40

−30

−20

−10

0

x1

10

20

30

40

−2

−60

−40

−20

0

x1

20

40

60

−3

−3

−2

−1

0

x1

1

2

3

F IGURE 5 – Noeud dégénéré stable ou instable ; cas dégénéré rectiligne.

2. σ(A) ⊂ {z ∈ C; <(z) < 0}.

Preuve. Les solutions de ẏ(t) = Ay(t) s’écrivent y(t) = etA y0 . Par ailleurs, il existe P ∈ GLd (C)

telle que A = P (D + N )P −1 où D est une matrice diagonale et N une matrice nilpotente. En outre,

σ(D) = σ(A) et D et N commutent. Ainsi, etA = P etD etN P −1 de sorte que :

ketA k ≤ kP kkP −1 kketD kketN k.

Si µ = maxλ∈σ(A) <(λ) < 0, alors il existe une constante C > 0 telle que ketD k ≤ Ceµt . Dans le

même temps, il existe C 0 > 0 telle que ketN k ≤ C 0 td−1 pour t suffisamment grand. Ainsi, 2. implique

1. Réciproquement, si σ(A) contient une valeur propre λ de partie réelle positive ou nulle, alors il

existe une solution de la forme eλt p(t) où p est un polynôme de degré plus petit que d, qui ne tend

donc pas vers 0 quand t tend vers +∞.

2.3

Solutions bornées

Théorème 2.2 Soit A ∈ L(E) où E est un K-espace vectoriel de dimension finie d et soit σ(A) son

spectre. Les propositions suivantes sont équivalentes :

1. Toute solution de ẏ(t) = Ay(t) est bornée sur R+ .

2. σ(A) ⊂ {z ∈ C; <(z) ≤ 0} et la multiplicité géométrique des valeurs propres de A de partie

réelle nulle est égale à la multiplicité algébrique (les sous-espaces propre et caractéristique

sont identiques).

Preuve. La preuve reprend les arguments de celle du théorème précédent. Si λ est une valeur propre

de partie réelle strictement positive, alors les solutions correspondantes eλt p(t) ne sont pas bornées.

Si λ est une valeur propre de partie réelle nulle et de multiplicité algébrique égale à la multiplicité

géométrique, alors p(t) est constant et la solution correspondante est de module constant, donc bornée.

La proposition suivante est de nature différente. Elle ne caractérise pas l’ensemble des solutions, mais

affirme l’existence d’une solution bornée de l’équation avec second membre.

14

Proposition 2.3 Soit A ∈ L(E) où E est un C-espace vectoriel de dimension finie d et soit σ(A) son

spectre. Les propositions suivantes sont équivalentes :

1. Pour toute donnée b(t) ∈ C(R+ ; Rd ) bornée, il existe une unique solution y(t) ∈ C 1 (R+ ; Rd )

bornée de l’équation ẏ(t) = Ay(t) + b(t).

2. σ(A) ⊂ {z ∈ C; <(z) > 0}.

Preuve. Montrons que 1. implique 2. Soit donc λ ∈ σ(A) et y0 un vecteur propre associé. Alors

y(t) = eλt y0 est solution de l’équation pour b ≡ 0. Si <(λ) ≤ 0, alors cette solution est bornée, ainsi

que µeλt y0 pour tout µ ∈ C. L’unicité d’une solution bornée n’est alors pas assurée. Donc σ(A) ne

peut contenir de valeurs propres de partie réelle négative ou nulle.

Pour établir la réciproque, considérons tout d’abord deux solutions y1 et y2 , toutes deux bornées.

Alors, y = y2 − y1 est solution de l’équation homogène et est encore bornée. Ce qui n’est possible,

d’après le théorème précédent, que si y est constamment nulle. Donc, si il existe une solution bornée,

elle est unique. Montrons l’existence d’une telle solution. D’après la formule de Duhamel, les solutions sont de la forme

Z t

tA

y(t) = e y0 +

e(t−s)A b(s)ds,

0

d

avec y0 ∈ C . Considérons alors

t

Z

e−sA b(s)ds.

y0 = − lim

t→+∞

0

Cette limite existe, car σ(A) ⊂ {z ∈ C; <(z) > 0}, de sorte qu’il existe µ > 0 et C > 0, vérifiant :

∀s ≥ 0, ke−sA k ≤ Ce−µs ,

et

Z t

−sA

e b(s)ds ≤ kbk∞ (1 − e−tµ ).

0

On a alors

+∞

Z

e(t−s)A b(s)ds

y(t) = −

t

et

Z

ky(t)k ≤ kbk∞ +∞

e

t

2.4

(t−s)A

Ckbk∞

.

ds ≤

µ

Solutions périodiques

On suppose ici que A(·) ∈ C(R; L(Cd )) et b(·) ∈ C(R; Cd ) sont des fonctions périodiques de

même période T et on s’intéresse à la question de savoir s’il existe des solutions T -périodiques de

l’équation

ẏ(t) = A(t)y(t) + b(t).

15

On note, comme précédemment, y(·; t0 , y0 ) la solution satisfaisant la condition intiale y(t0 ) = y0 .

Remarquons que cette question n’a pas de réponse triviale, comme en atteste l’exemple suivant :

ẏ(t) = Ay(t) + b

où b est un vecteur constant non nul, et A la matrice

0 1

A=

.

0 0

Les solutions, de la forme

y(t) =

b2 t2 /2 + (y2 (0) + b1 )t + y1 (0)

b2 t + y2 (0)

ne sont en effet périodiques que pour y2 (0) = −b1 et b2 = 0, bien que A et b soient périodiques de

période T pour tout T > 0.

Théorème 2.4 (Existence de solutions périodiques) Supposons que A(·) ∈ C(R; L(Cd )) et b(·) ∈

C(R; Cd ) sont des fonctions périodiques de même période T . Alors les propositions suivantes sont

équivalentes :

1. Il existe une solution périodique de ẏ(t) = A(t)y(t) + b(t)

2. Pour tout t0 ∈ R, l’application y0 7→ y(T + t0 ; t0 , y0 ) a un point fixe.

3. Il existe t0 ∈ R tel que l’application y0 7→ y(T + t0 ; t0 , y0 ) a un point fixe.

Preuve. L’implication 1. ⇒ 2. est immédiate, de même que 2. ⇒ 3. Montrons la dernière, 3. ⇒

1. Soit y0 ∈ Cd un point fixe de l’application y0 7→ y(T + t0 ; t0 , y0 ) et posons y∗ = y(·; t0 , y0 ).

L’application z∗ (t) = y∗ (t + T ) est alors solution de l’équation différentielle. On a en effet,

ż∗ (t) = ẏ∗ (t + T ) = A(t + T )y∗ (t + T ) + b(t + T ) = A(t)y∗ (t + T ) + b(t) = A(t)z∗ (t) + b(t),

en utilisant la périodicité de A et b. En outre, z∗ (t0 ) = y∗ (t0 + T ) = y∗ (t0 ) puisque y0 est point fixe.

Par unicité de la solution du problème de Cauchy, z∗ et y∗ coincident donc partout.

Théorème 2.5 (Solution périodique et solution bornée) Supposons que A(·) ∈ C(R; L(Cd )) et b(·) ∈

C(R; Cd ) sont des fonctions périodiques de même période T . Alors il existe une solution périodique

de ẏ(t) = A(t)y(t) + b(t), si et seulement si, il existe une solution bornée de ẏ(t) = A(t)y(t) + b(t)

sur R+ .

Preuve. Il est clair qu’une solution périodique est bornée. On suppose donc qu’il existe une solution

bornée, mais aucune solution périodique. Alors, d’après le théorème précédent, l’équation

Z T

y0 = S(T ; 0)y0 +

S(T ; s)b(s)ds

0

16

n’a pas de solution sur Cd . En posant U = S(T ; 0) et z =

z∈

/ Im(I − U ). Or, on a

RT

0

S(T ; s)b(s)ds, ceci signifie que

Ṡ(t + nT ; nT ) = A(t + nT )S(t + nT ; nT ) = A(t)S(t + nT ; nT )

avec S(nT ; nT ) = Id . Ainsi, S(t + nT ; nT ) et S(t; 0) satisfont la même équation différentielle, avec

la même condition intiale et par le théorème de Cauchy Lipschitz, sont donc égales. On a donc en

particulier

S((n + 1)T ; nT ) = S(T ; 0) = U.

En reportant cette égalité dans la formule de Duhamel, il vient alors

Z (n+1)T

y((n + 1)T ) = U y(nT ) +

S((n + 1)T ; s)b(s)ds

nT

soit encore, en utilisant la périodicité de b et de S((n + 1)T ; s) 1 :

Z T

y((n + 1)T ) = U y(nT ) +

S((n + 1)T ; s + nT )b(s + nT )ds = U y(nT ) + z.

0

∗

Soit alors U l’adjoint de U pour le produit scalaire canonique < ·, · > sur Cd . Pour tout (x, x0 ) ∈

Im(I − U ) × Ker(I − U ∗ ), on a x = u − U u et

< x, x0 >=< u − U u, x0 >=< u, x0 > − < u, U ∗ x0 >= 0,

de sorte que Im(I − U ) = (Ker(I − U ∗ ))⊥ . Ainsi, il existe u ∈ Cd tel que U ∗ u = u et < u, z >6= 0.

On en déduit que

< y((n + 1)T ), u > = < U y(nT ), u > + < z, u >

= < y(nT ), U ∗ u > + < z, u >

= < y(nT ), u > + < z, u >

et donc par récurrence

< y((n + 1)T ), u >=< y(0), u > +(n + 1) < z, u >

ce qui contredit le caractère borné de y(·).

1. On a en effet en utilisant les propriétés de la résolvante : S((n + 1)T ; s + nT ) = S((n + 1)T ; nT )S(nT ; s + nT ) =

S(T ; 0)S −1 (s + nT ; nT ) = S(T ; 0)S −1 (s; 0) = S(T ; 0)S(0; s) = S(T ; s)

17