Lección 1: TÉCNICAS PARA MEJORAR LA CALIDAD DE

Anuncio

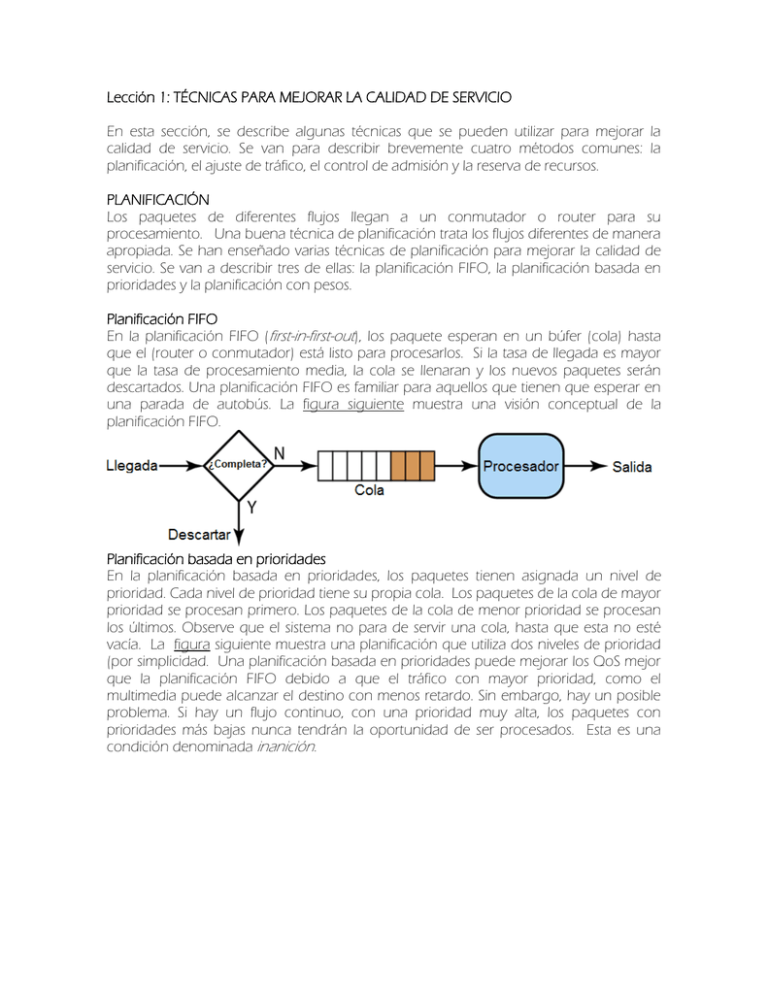

Lección 1: TÉCNICAS PARA MEJORAR LA CALIDAD DE SERVICIO En esta sección, se describe algunas técnicas que se pueden utilizar para mejorar la calidad de servicio. Se van para describir brevemente cuatro métodos comunes: la planificación, el ajuste de tráfico, el control de admisión y la reserva de recursos. PLANIFICACIÓN Los paquetes de diferentes flujos llegan a un conmutador o router para su procesamiento. Una buena técnica de planificación trata los flujos diferentes de manera apropiada. Se han enseñado varias técnicas de planificación para mejorar la calidad de servicio. Se van a describir tres de ellas: la planificación FIFO, la planificación basada en prioridades y la planificación con pesos. Planificación FIFO En la planificación FIFO (first-in-first-out), los paquete esperan en un búfer (cola) hasta que el (router o conmutador) está listo para procesarlos. Si la tasa de llegada es mayor que la tasa de procesamiento media, la cola se llenaran y los nuevos paquetes serán descartados. Una planificación FIFO es familiar para aquellos que tienen que esperar en una parada de autobús. La figura siguiente muestra una visión conceptual de la planificación FIFO. Planificación basada en prioridades En la planificación basada en prioridades, los paquetes tienen asignada un nivel de prioridad. Cada nivel de prioridad tiene su propia cola. Los paquetes de la cola de mayor prioridad se procesan primero. Los paquetes de la cola de menor prioridad se procesan los últimos. Observe que el sistema no para de servir una cola, hasta que esta no esté vacía. La figura siguiente muestra una planificación que utiliza dos niveles de prioridad (por simplicidad. Una planificación basada en prioridades puede mejorar los QoS mejor que la planificación FIFO debido a que el tráfico con mayor prioridad, como el multimedia puede alcanzar el destino con menos retardo. Sin embargo, hay un posible problema. Si hay un flujo continuo, con una prioridad muy alta, los paquetes con prioridades más bajas nunca tendrán la oportunidad de ser procesados. Esta es una condición denominada inanición. Planificación con pesos Una técnica mejor de planificación es la planificación con pesos. En esta técnica, los paquetes tienen asignadas clases diferentes y se admiten en colas distintas. Las colas, sin embargo, llevan asignadas unos pesos de acuerdo al nivel de prioridad de las colas. Las colas de mayor prioridad tienen pesos mayores. El sistema procesa los paquetes en cada cola de manera cíclica con el número de paquetes seleccionado para cada cola de acuerdo al peso correspondiente. Por ejemplo, si los pesos son 3, 2, 1, se procesarán tres paquetes en la primera cola, dos en la segunda y uno en la tercera. Si el sistema no impone prioridades a las clases, todos los presos todos los pesos son iguales. La figura siguiente muestra la técnica con tres clases. AJUSTE DE TRÁFICO El ajuste de tráfico es un mecanismo para controlar la cantidad y tasa de tráfico enviado a la red. Existen dos técnicas de ajuste de tráfico: algoritmo del cubo de escape y algoritmo del cubo con testigo. Algoritmo del cubo con escape Si un cubo tiene un pequeño agujero su parte inferior, el agua deja el cubo a una velocidad constante mientras haya agua en el cubo. La velocidad con la que el agua deja el cubo no depende de la velocidad con la que el agua se introduce en él. La velocidad de entrada puede variar, pero la velocidad de salida permanece constante. De forma similar, en una red, una técnica denominada cubo con escape, puede suavizar la salida de tráfico a ráfagas. Los bloques a ráfagas se almacenan en un cubo y se envían a una tasa media. La figura siguiente muestra un cubo con escape y sus efectos. La figura, se asume que la red ha comprometido un ancho de banda de 3 Mbps para una estación. El uso de un cubo con escape ajusta el tráfico de entrada para que se cumpla este compromiso. En la figura siguiente la estación envía una ráfaga de datos a una tasa de 12 Mbps durante 2 s, con un total de 24 Mbits. La estación está en silencio durante 5 s y envía datos a una taza de 2 Mbps durante 3 s, con un total de 6 Mbits de datos. En total, la estación enviado 30 Mbps de datos en 10 s. Sin un cubo con escape, la ráfaga inicial puede afectar a la red y consumir más ancho de banda del que está fijado para esta estación. Se puede también ver que el cubo con escape previene la congestión. La figura siguiente muestra una sencilla implementación de un cubo con escape. Una cola FIFO almacena los paquetes. Si el tráfico consta de paquetes de tamaño fijo (por ejemplo celdas de una red ATM), el proceso elimina un número fijo de paquetes de la cola en cada pulso de reloj. Si el tráfico consta de paquetes de longitud variable, la tasa de salida fija debe basarse en el número de bits o bytes. A continuación se muestra un algoritmo para paquetes de longitud variable: 1. Inicializar un contador a n en cada pulso de reloj. 2. Si n es mayor que el tamaño del paquete, enviar el paquete y restar al contador el tamaño del paquete. Repetir esta etapa hasta que n sea más pequeño que el tamaño del paquete. 3. Poner el contador a cero y volver al paso 1. Un algoritmo de cubo con escape ajusta el tráfico de ráfagas en un tráfico con tasa fija promediando la tasa de datos. Puede perder paquetes si el cubo está lleno. Cubo de testigos El cubo con escape es muy restrictivo. No da crédito a una estación inactiva. Por ejemplo, si una estación no envía datos durante un cierto tiempo, su cubo está vacío. Ahora sí la estación tiene datos a ráfagas, el cubo con escape sólo permite una tasa media. El tiempo en el que la estación está inactiva no se tiene en cuenta. Por otro lado, cubo de testigos, permite a la estación inactivas acumular crédito para que el futuro en forma de testigos. En cada pulso de reloj, el sistema envía n testigos al cubo. El sistema elimina un testigo para cada celda (o byte) de datos enviados. Por ejemplo, si n es 100 y la estación está inactiva durante 100 pulsos de reloj, el cubo tendrá 10.000 testigos. Ahora la estación puede consumir todos estos testigos en un pulso de reloj con 10.000 celdas o la estación tarda 1000 pulsos con 10 celdas por pulsos. En otras palabras, la estación puede enviar datos a ráfagas siempre que el cubo no esté vacío. En la figura siguiente se muestra la idea. El cubo de testigos se puede implementar de forma sencilla con un contador. El testigo se inicializa a cero. Cada vez que se añade un testigo se incremente el contador en uno. Cada vez que se envía una unidad de datos, al contador se le resta 1. Cuando el contador se hace cero, la estación no puede enviar datos. El cubo de testigos permite tráfico a ráfagas a una tasa máxima regulada Combinación del cubo de testigos y del cubo con escape Las dos técnicas anteriores se pueden combinar para dar crédito a una estación inactiva al mismo tiempo que se regula el tráfico. El cubo con escape se aplica después de cubo de testigos; la tasa del cubo con escape necesita ser mayor que la tasa de testigos descartados en el cubo de testigos. RESERVA DE RECURSOS Un flujo de datos necesita recursos como un búfer, ancho de banda, tiempo de CPU, etc. La calidad del servicio se mejora si estos recursos están reservados por adelantado. En esta sección se describe un modelo de calidad de servicio denominado servicios integrados, que depende de la reserva de recursos para mejorar la calidad del servicio. CONTROL DE ADMISIÓN El control de admisión se refiere al mecanismo utilizado por un router, o un conmutador para aceptar o rechazar un flujo de acuerdo a los parámetros predefinidos denominados especificaciones del flujo. Antes de que un router acepte un flujo para su procesamiento, comprueba las especificaciones del flujo para ver si su capacidad (en términos de ancho de banda, tamaño de búfer, velocidad de la CPU, etc.) y sus compromisos anteriores para otro flujos pueden tratar el nuevo flujo. Lección 2: SERVICIOS INTEGRADOS De acuerdo a los temas tratados se han diseñado dos modelos para mejorar la calidad de servicio de Internet: los servicios integrados y los servicios diferenciados. Ambos modelos enfatizan el uso de la calidad de servicio en el nivel de red (IP), aunque el modelo también se puede utilizar en otros niveles de enlace de datos. En esta sección se tratan los servicios integrados y en la sección siguiente se describen los servicios diferenciados. IP fue originalmente diseñado con una entrega lo mejor posible. Esto significa que cada usuario recibe al mismo nivel de servicio. Este tipo de entrega no garantiza el mínimo de servicios, como ancho de banda, a las aplicaciones que transmite audio o vídeo en tiempo real. Si una aplicación que necesita de forma accidental un ancho de banda extra, puede ir en detrimento de otras aplicaciones, dando lugar a situaciones de congestión. Los servicios integrados, conocidas también como IntServ, constituyen un modelo de QoS basada en flujo, lo que significa que un usuario necesita crear un flujo, un tipo de circuito virtual, desde el origen hasta el destino e informar a todos los routers de sus requisitos de recursos. Los servicios integrados constituyen un modelo de QoS basada en flujo diseñado para IP. SEÑALIZACIÓN El lector puede recordar que IP es un protocolo no orientado a conexión, basado en datagramas que utiliza conmutación de paquetes. ¿Cómo se puede implementar un modelo basado en flujo sobre un protocolo no orientado a conexión? La solución es un protocolo de señalización que ejecuta sobre IP que at ofrece el mecanismo de señalización por hacer la reserva. Este protocolo se denomina Protocolo de reservas de recursos (RVSP) y se describirá en breve. ESPECIFICACIÓN DEL FLUJO Cuando un origen hace una reserva, necesita definir una especificación de flujo. Una especificación de flujo tiene dos partes: Rspec (especificación del recurso) y Tspec (especificación de tráfico). Rspec define los recursos que necesita reservar el flujo (búfer, ancho de banda, etc.) Tspec define las características del tráfico del flujo. ADMISIÓN Cuando un router recibe la especificación del flujo de una aplicación, decide admitir o denegar el servicio. La decisión se basa en los compromisos previos del router y la disponibilidad actual de recursos. CLASES DE SERVICIOS Se han definido dos clases de servicios para los servicios integrados: servicios garantizados y servicios controlados por la carga. Clase de servicios garantizados Este tipo de servicio está diseñado para tráfico de tiempo real que necesita un retardo extremo a extremo mínimo garantizado. El retardo extremo a extremo es la suma de los retardos de todos los routers, retardo de propagación en el medio y el mecanismo de configuración. Sólo el primero, las sumas de los retardos en los routers, puede ser garantizado por el router. Este tipo de servicio garantiza que los paquetes llegarán dentro de un cierto tiempo y que no serán descartados si el tráfico del flujo se encuentra dentro del límite de Tspec. Se puede decir que los servicios garantizados son servicios cuantitativos, en los que la cantidad de retardo extremo a extremo y la tasa de datos deben ser definidas por la aplicación. Clase de servicio controlado por la carga Este tipo de servicio está diseñado para aplicaciones que pueden aceptar algunos retardos, pero que son sensibles a la sobrecarga de la red y al peligro por la pérdida de paquetes. Buenos ejemplos de este tipo de aplicaciones son la transferencia de archivos, el correo electrónico y el acceso a Internet. El servicio controlado por la carga es un servicio lo cualitativo en que la aplicación solicitar la posibilidad de bajar pérdida o no pérdida de paquetes. RVSP En el modelo de servicios integrados, un programa de aplicación necesita una reserva de recursos. Como se vio en la descripción del modelo IntServ, la reserva de recursos se realizada para un flujo. Esto significa que si se quiere utilizar el modelo IntServ en el nivel IP, se necesita crear un flujo, un tipo de red basada en circuitos virtuales, fuera del nivel IP, que fue originalmente diseñado como una red de conmutación de paquetes basada en datagramas. Una red basada en circuitos virtuales necesita un sistema de señalización para configurar el circuito virtual antes de que el tráfico de datos pueda comenzar. El protocolo de reserva de recursos (RSVP) es un protocolo de señalización que ayudar protocolo IP a crear un flujo y consecuentemente a hacer una reserva de recursos. Antes de describir el protocolo RVSP, es necesario mencionar que es un protocolo independiente y separado del modelo de servicios integrados. Se puede utilizar en otros modelos en el futuro. Árboles de multienvío RVSP es diferente de otros sistemas de señalización que se han visto antes en que es un sistema de señalización diseñado para multienvío. Sin embargo, el protocolo RVSP también se puede utilizar para envío unidestino debido a que éste es un caso especial de multienvío con sólo un miembro en el grupo de multienvío. La razón de este diseño permitir al protocolo RVSP ofrecer una reserva de recursos para todo tipo de tráfico de incluyendo multimedia que con frecuencia utiliza multienvío. Reserva basada en el receptor En el protocolo RVSP, los receptores, no el emisor, hacen la reserva. Esta estrategia coincide con otros protocolos de multienvío. Por ejemplo, en uno de los protocolos de encaminamiento de multienvío, los receptores, no el emisor, hacen la decisión de unirse o dejar el grupo de multienvío. Mensajes del protocolo RVSP RVSP tiene varios días tipos de mensajes. Sin embargo, se va a escribir sólo dos de ellos: Path y Resv. Mensajes path. Recuerde que los receptores en un flujo hacen la reserva en el protocolo RVSP. Sin embargo, los receptores no saben el camino atravesado por los paquetes antes de que se haga la reserva. Es necesario el camino para hacer la reserva. Para solucionar este problema, el protocolo RVSP utiliza mensajes path. Un mensaje path viaja desde el emisor y alcanza a todos los receptores en el camino multienvío. Un mensaje path, almacena la información necesaria para los receptores. Un mensaje path se envía en un entorno de envío multidestino; un nuevo mensaje se crea cuando el camino diverge. La figura siguiente muestra mensajes de tipo path. Mensajes resv. Una vez que el receptor ha recibido un mensaje path, envía un mensaje resv. El mensaje Resv viaja hacia el emisor (en el flujo ascendente) y hace la reserva de recursos en los routers que soportan RVSP. Si un router en el camino no soporta RVSP encamina el paquete de acuerdo a los métodos de mejor entrega posible. La figura siguiente muestra los mensajes resv. Mezcla de reservas En el protocolo RVSP, los recursos no se reservan para cada receptor en un flujo; las reservas se mezclan. En la figura siguiente, Rc3 solicita un ancho de banda de 2 Mbps mientras que Rc2 solicita un ancho de banda de 1 Mbps. El router R3, necesita hacer una reserva de ancho de banda, mezcla las dos solicitudes. La reserva se hace para 2 Mbps, mayor de los dos, debido a que una reserva de 2 Mbps puede tratar ambas solicitudes. La misma situación es cierta para R2. El lector puede preguntarse por qué Rc2 y Rc3, ambos pertenecientes a un mismo flujo, los visitan diferentes cantidades de ancho de banda. La respuesta de que, en un entorno multimedia, diferentes receptores pueden tratar diferentes grados de calidad. Por ejemplo, Rc2 puede ser capaz de recibir vídeo sólo a 1 Mbps (baja calidad) mientras que Rc3 puede ser capaz de recibir vídeo a 2 Mbps (mayor calidad). Estilos de reserva Cuando hay más de un flujo, el router necesita hacer la reserva para acomodar todos ellos. El protocolo RVSP define tres tipos de estilos de reserva. 1. Estilo de filtro will card. En este estilo, el router crea una única reserva para todos los emisores. La reserva se basa en la petición mayor. Este tipo de estilo que se utiliza cuando los flujos de diferentes emisores no ocurren al mismo tiempo. 2. Estilo de filtro fijo. En este estilo, el router crea una reserva distinta para cada flujo. Esto significa que si hay n flujos, se hace n diferentes reservas. Este tipo de estilo se utiliza cuando hay una alta probabilidad de que los flujos de diferentes emisores no ocurran al mismo tiempo. 3. Estilo explícito compartido. En este estilo, el router crea una única reserva que es compartida por todos los flujos. Estado de tipo soft La información de reserva (estado) almacenada en cada nodo para un flujo necesita ser refrescada periódicamente. Esto se conoce como un estado de tipo soft comparado con un estado de tipo hard utilizado en otros protocolos basados en circuitos virtuales como ATM o Frame Relay, donde la información sobre el flujo se mantiene hasta que se borra. El intervalo por defecto es actualmente de 30 s. PROBLEMAS CON LOS SERVICIOS INTEGRADOS Hay al menos dos problemas con los servicios Integrados que pueden evitar su completa implementación en Internet: la escalabilidad y la limitación del tipo de servicio. Escalabilidad El modelo de servicios integrados requiere que cada router mantenga información para cada flujo. Como Internet está creciendo día a día, esto es un serio problema. Limitación del tipo de servicio El modelo de servicios integrados proporciona sólo dos tipos de servicios, garantizado y controlado por la carga. Aquellos que se oponen a este modelo argumentan que las aplicaciones pueden necesitar más de estos dos tipos de servicios. Lección 3: SERVICIOS DIFERENCIADOS Los servicios diferenciados (DS o DiffServ) fueron introducidos por el IETF (Internet Engering Task Force) para solucionar los problemas de los servicios integrados. Se hicieron dos cambios fundamentales: 1. El principal procesamiento fue movido del núcleo de la red al extremo de la red. Esto soluciona el problema de escalabilidad. Los encaminadores no tienen que almacenar la información sobre los flujos. Las aplicaciones, o estaciones, definen el tipo de servicio que ellos necesitan cada vez que envía un paquete. 2. El servicio por flujo se ha cambiado a un servicio por clase. El encaminador encamina el paquete de acuerdo a la clase de servicio definido en el paquete, no en el flujo. Esto soluciona el problema de limitación del tipo de servicio. Se pueden definir diferentes tipos de clases de acuerdo a las necesidades de las aplicaciones. Los servicios diseñada para IP. diferenciados un modelo QoS basada en clases CAMPO DS En DifServ, cada paquete contiene un campo denominado campo DS. El valor de este campo es fijado en los extremos de la red por las estaciones o por el primer encaminador designado como encaminador frontera. El IETF propone sustituir el campo TOS (tipo de servicio) existente en IPv4 o el campo de clase IPv6 por el campo DS, como se muestra en la figura siguiente. El campo DS contiene dos subcampos: DSCP y CU. El campo de DSCP (punto de código de servicios diferenciados) es un subcampo de 6 bits que define el funcionamiento por salto (PHB). El campo CU en un campo de 2 bits que no se utiliza actualmente. Funcionamiento por salto El modelo DifServ define funcionamientos por salto (PHB) para cada nodo que recibe un paquete. Hasta ahora se han definido tres PDH: DE PHB, EF PHB y AF PHB. DE PHB. Este funcionamiento (PHB por defecto) es el mismo que la entrega mejor posible, que es compatible con el campo TOS. EF PHB. Este funcionamiento (PHB de reenvío rápido) ofrece los siguientes servicios: Pérdida baja. Latencia baja. Ancho de banda asegurado. Esto es lo mismo que tener una conexión virtual entre el origen y el destino. AF PHB. Este funcionamiento (PHB de reenvío asegurado) entrega el paquete con una alta seguridad siempre que el tráfico no exceda el perfil de tráfico del nodo. Los usuarios de la red necesitan ser conscientes de que algunos paquetes pueden ser descartados. Acondicionador de tráfico Para implementar DifServ, el nodo DS utiliza acondicionadores de tráfico como contadores, marcadores, adaptadores y descartadores, como se muestra en la figura siguiente. Contador. El contador comprueba si el flujo de entrada coincide con el perfil de tráfico negociado. El contador también envía este resultado a otros componentes. El contador puede utilizar varias herramientas como un cubo de testigos para comprobar el perfil. Marcador. Un marcador puede remarcar un paquete si está utilizando la entrega mejor posible (DSCP: 000000) o marcar por debajo un paquete de acuerdo a la información recibida por el contador. El marcado por debajo (marca a un nivel de servicio más bajo) ocurre si el flujo no coincide con el perfil. Un marcador no hace un marcado hacia arriba (eleva el nivel de servicio) de un paquete. Adaptador. Un adaptador utiliza la información recibida del contador para adaptar o ajustar el tráfico si no cumple con el perfil negociado. Descartador. Un descartador, que funciona como un adaptador sin búfer, descarta los paquetes si el flujo viola de forma severa el perfil negociado. Lección 4: QoS EN FRAME RELAY Se utilizan cuatro atributos diferentes para controlar el tráfico en Frame Relay: tasa de acceso, tamaño de la ráfaga comprometido Bc, tasa de información comprometida y tamaño de la ráfaga en exceso. Estos atributos se fijan durante la negociación entre el usuario y la red. Para conexiones PVC, se negocian sólo una vez; para conexiones SVC se negocian en cada conexión durante la fase de establecimiento de la conexión. La figura siguiente muestra las relaciones entre estas cuatro medidas. Velocidad de acceso Para cada conexión se define una velocidad de acceso (en bits/segundo). La velocidad de acceso realmente depende del ancho de banda del canal que conecta al usuario con la red. El usuario no puede nunca exceder esta velocidad. Por ejemplo, si el usuario se conecta a una red Frame Relay mediante una línea T-1, la velocidad de acceso es de 1,544 Mbps y ésta no se puede sobrepasar. Tamaño de la ráfaga comprometido Para cada conexión, Frame Relay define un tamaño de ráfaga comprometido (Bc). Este es el número máximo de Bits durante un periodo predefinido de tiempo que la red se compromete a transferir sin descartar ninguna trama o activar el bit DE. Por ejemplo si se compromete un valor para Bc de 400 kbits durante un periodo de cuatro segundos, el usuario puede enviar hasta 400 kbits durante un u intervalo de cuatro segundos sin preocuparse de que se pierdan tramas. Observe que no se trata de una velocidad definida para cada segundo. Es una medida acumulativa. El usuario puede enviar 300 kbits durante el primer segundo, ningún dato durante los dos siguientes segundos y finalmente 100 kbits durante el cuarto segundo. Velocidad de información comprometida La velocidad de información comprometida (CIR) es similar al concepto de tamaño de ráfaga comprometido excepto que define una velocidad media de bits por segundo. Si el usuario mantiene esta velocidad, la red se compromete entregar la trama. Sin embargo debido a que es una medida media, un usuario puede enviar en algunos instantes datos a una velocidad mayor al CIR. Siempre que se cumpla la media para el período pre definido, las tramas serán entregadas. El número acumulativo de bits enviados durante el periodo predefinido no debería exceder de Bc Observe que el CIR no es una medida independiente; se puede calcular utilizando la siguiente fórmula: CIR =Bc/T bps Por ejemplo, si el Bc es de cinco kbits en un período de cinco segundos, el CIR es 5000/5 = 1kbps. Tamaño de la ráfaga en exceso Para cada conexión, Frame Relay define un tamaño de la ráfaga en exceso (Bc). Este valor es el número máximo de bits, que pueden exceder a Bc que un usuario puede enviar durante un periodo predefinido de tiempo. La red se compromete a transferir estos bits si no hay congestión. Observe que en este caso existe menos compromiso que en el caso de Bc. El compromiso de la red es condicional. Tasa del usuario La figura siguiente muestra cómo puede un usuario enviar datos a ráfagas. Si un usuario nunca excede Bc, la red se compromete a transferir las tramas sin descartarlas. Si el usuario excede el valor de Bc, en menos que Be (es decir, el número total de bits es menor que Bc + Be), la red se compromete a transferir todas las tramas si no hay congestión. Si existe congestión, algunas tramas serán descartadas. El primer conmutador que recibe las tramas del usuario tiene un contador y fija el bit DE para aquellas tramas que exceden el valor Bc. El resto de conmutadores descartarán esta trama si hay congestión. Observe que un usuario que necesita enviar datos más rápido puede exceder el nivel Bc. Siempre que el nivel no supere Bc + Be, existe la posibilidad de que las tramas alcancen el destino sin ser descartadas. Recuerde, sin embargo, que el momento en el que el usuario supere Bc + Be, todas las tramas enviadas después son descartadas por el primer conmutador. Lección 5: QoS EN ATM La QoS en ATM se basa en las clases, los atributos relacionados con el usuario y los atributos relacionados con la red. Clases El foro ATM define cuatro clases de servicios: CBR, VBR, ABR y UBR. CBR. La clase de tasa de bits constante (CBR) se ha diseñado para los clientes que necesitan servicios de vídeo y audio de tiempo real. El servicio es similar al ofrecido por una línea dedicada como la línea T. VBR. La clase de tasa de bits variable (VBR) se divide en dos subclases: tiempo real (VBRNRT). VBR-RT se diseñó para los usuarios que necesitan servicio de tiempo real (como transmisión de audio y vídeo) y utilizan técnicas de compresión para crear una tasa de bits variable. VBR-NRT se diseñó para aquellos usuarios que no necesitan servicios de tiempo real de utilizan técnica de compresión para crear una tasa de bits variable. ABR. La clase de tasa de bits disponible (ABR) entrega las celdas a la mínima tasa. Si hay más capacidad de red, la tasa mínima puede incrementarse. ABR es particularmente adecuado para aplicaciones que utilizan por su naturaleza ráfagas. UBR. La clase de tasa de bits no especificada (UBR) es un servicio de mejor entrega posible que no garantiza nada. La figura 31 muestra la relación entre las diferentes clases y la capacidad total de la red. ATRIBUTOS RELACIONADOS CON EL USUARIO ATM define dos conjuntos de atributos. Los atributos relacionados con el usuario son aquellos que definen la velocidad con la que el usuario quiere enviar los datos. Estos atributos se negocian cuando se realiza el contrato entre un usuario y una red. A continuación se describen algunos atributos relacionados con el usuario. SCR. La tasa de celdas sostenida (SCR) es la tasa de celdas media en un intervalo de tiempo largo. La tasa de celdas real puede ser mayor o menor, pero la media debería ser igual o menor que la SCR. PCR. La tasa de celdas pico (PCR) define la máxima tasa de celdas del emisor. La tasa de celdas del usuario puede en algunas ocasiones alcanzar este pico, mientras que se mantenga la SCR MCR. La tasa de celdas mínima (MCR) define la tasa de celdas mínima aceptable para el emisor. Por ejemplo, si la MCR 50.000, la red debe garantizar que el emisor puede enviar al menos 50.000 celdas por segundo. CVDT. La tolerancia en el retardo a la variación de celdas (CVDT) es una medida de la variación en los instantes de transmisión de celdas. Por ejemplo, si la CVDT es de 5 ns, entonces la diferencia entre los retardos mínimos y máximos en la entrega de celdas no debería exceder los 5 ns. ATRIBUTOS RELACIONADOS CON LA RED Los atributos relacionados con la red son los que definen las características de la red. A continuación se definen algunos de estos atributos: CLR. La tasa de celdas perdidas (CLR) define la fracción de celdas perdidas (o entregadas demasiado tarde y que se consideran pérdidas) durante la transmisión. Por ejemplo, si el emisor envía 100 celdas y una se pierde, la CLR es: CLR = 1/100 = 10-2 CTD. El retardo en la transferencia de celdas (CTD) es el tiempo medio necesario para que una celda viaje del origen al destino. También se consideran como atributos al CTD máximo y el CTD mínimo. CVD. La variación en el retardo de celdas (CVD) es la diferencia entre el CTD máximo y el CTD mínimo. CER. La tasa de celdas con error (CER) define la fracción de celdas entregadas con error.