Distribuciones Bidimensionales

Anuncio

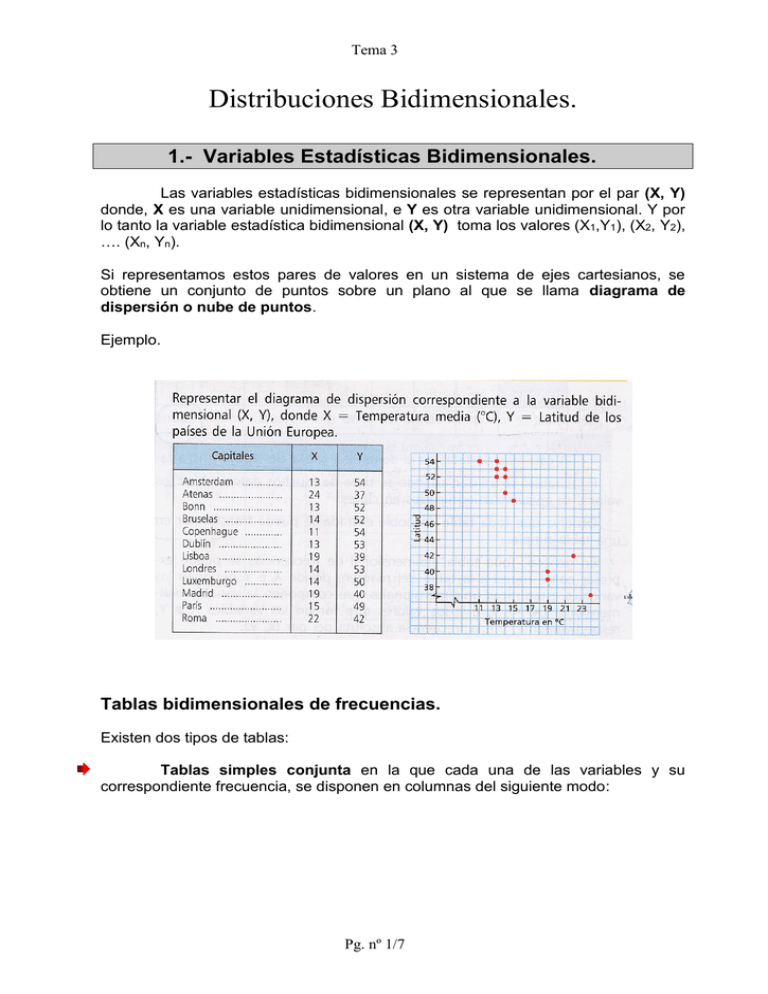

Tema 3 Distribuciones Bidimensionales. 1.- Variables Estadísticas Bidimensionales. Las variables estadísticas bidimensionales se representan por el par (X, Y) donde, X es una variable unidimensional, e Y es otra variable unidimensional. Y por lo tanto la variable estadística bidimensional (X, Y) toma los valores (X1,Y1), (X2, Y2), …. (Xn, Yn). Si representamos estos pares de valores en un sistema de ejes cartesianos, se obtiene un conjunto de puntos sobre un plano al que se llama diagrama de dispersión o nube de puntos. Ejemplo. Tablas bidimensionales de frecuencias. Existen dos tipos de tablas: Tablas simples conjunta en la que cada una de las variables y su correspondiente frecuencia, se disponen en columnas del siguiente modo: Pg. nº 1/7 Tema 3 X Y fi (matemáticas) (física) (nº de alumnos) 3 2 4 4 5 6 5 5 12 6 6 4 6 7 5 7 6 4 7 7 2 8 9 1 10 10 2 Tablas de doble entrada en las que se dispone la variable X en fila, en la parte superior, y la variable Y en columna a la izquierda. Posterior mente se añaden las frecuencias en el cuerpo de la tabla. Todo ello de la siguiente forma: X 3 Y 2 5 6 7 9 10 4 5 6 12 6 7 4 5 4 2 8 10 4 1 2 Como se puede observar, las tablas simples se pueden transformar en tablas de doble entrada, y viceversa. Esto es importante saberlo hacer, porque en los cálculos posteriores necesitaremos ambas formas de tablas. Antes de continuar aprenderemos a sacar lo que se denomina “distribuciones marginales” de X e Y. Su cálculo es muy sencillo, partiendo de la tabla de doble entrada se añade una fila y una columna y se va sumando el cuerpo principal de la tabla por filas y columnas. La nueva columna es la distribución marginal de Y, y la nueva fila es la distribución marginal de X. X Y 3 2 5 6 7 9 10 4 ∑ fx 4 4 6 5 6 7 8 10 ∑ fy 2 2 4 18 8 7 1 2 40 12 4 5 4 2 1 6 12 9 Pg. nº 2/7 6 1 Tema 3 Distribución marginal de X Distribución marginal de Y X fi 3 4 4 6 5 12 6 9 7 6 8 1 10 2 40 Y fi 2 4 5 18 6 8 7 7 9 1 10 2 40 Cálculo de parámetros Tanto con la variable X, como con la variable Y, se pueden realizar todos los cálculos, las representaciones gráficas y sacar las conclusiones que hemos visto en los dos temas anteriores. Hay que tener en cuenta, que muchas veces es importante estudiar cada una de las variables de forma independiente, para conocer su comportamiento individual y luego poder interpretar mejor el comportamiento conjunto. El primer parámetro conjunto que vamos a ver es la covarianza, que viene a ser la varianza conjunta de las variables X e Y. La vamos a definir como la media aritmética de los productos de las desviaciones de cada una de las variables respecto a sus medias respectivas. La covarianza viene representada por σxy ó Sxy, y su cálculo lo realizaremos mediante la formula: xy xi yi fi N xy Más adelante veremos el significado de la varianza, así como su interpretación según su signo. Para su cálculo matemático es preciso partir de la tabla simple conjunta, confeccionando todas las columnas necesarias, como a continuación se muestra: Pg. nº 3/7 Tema 3 Sí en el estudio estadístico no se nos exige el cálculo de modas, medianas, percentíles, etc., todos los datos y los parámetros que necesitamos (medias, varianzas y desviaciones típicas) lo podemos obtener de la tabla anterior. Pero si no es el caso, debemos calcular las distribuciones marginales y operar con ellas. Concepto de correlación Se llama correlación a la teoría que trata de estudiar “la relación o dependencia” que existe entre las dos variables que intervienen en una distribución bidimensional. La correlación es lineal o curvilínea según el diagrama de dispersión se concentre en torno a una línea recta o curva. La correlación es positiva o directa cuando a medida que crece una variable la otra también crece, o viceversa. La correlación es negativa o inversa cuando a medida que crece una variable la otra decrece, o viceversa. La correlación es nula cuando no existe ninguna relación entre ambas variables, y se dice que están incorrelacionadas. La correlación es de tipo funcional si existe una función que satisface todos los valores de la distribución. A continuación representamos todas las posibilidades: Pg. nº 4/7 Tema 3 Pg. nº 5/7 Tema 3 Coeficiente de correlación lineal Una vez observado, mediante un diagrama de dispersión, que existe una correlación entre las variables hay que demostrarlo de forma más precisa y objetiva. Nosotros sólo vamos a estudiar la correlación de tipo lineal. Y el procedimiento más frecuente es el coeficiente de correlación de Pearson, que se define mediante la siguiente expresión: r xy x · y El signo de r viene dado por el signo de la covarianza, ya que las desviaciones típicas son siempre positivas. Así pues, el signo de la covarianza nos indica el comportamiento de la correlación: Si la covarianza es positiva la correlación es directa. Si la covarianza es negativa la correlación es inversa. Si la covarianza es nula existe incorrelación. Está demostrado que el coeficiente de correlación lineal de Pearson es un número real comprendido entre -1 y + 1. Veamos a continuación el tipo de dependencia entre las variables X e Y según el valor de r: Si r = +1 o r = - 1, todos los valores están sobre la recta y en consecuencia se dice que existe una dependencia funcional directa o inversa, respectivamente. Si -1 < r < 0, la correlación es negativa y será tanto más fuerte cuanto más se aproxime a -1. Se dice entonces que existe una relación de dependencia aleatoria. Nosotros vamos a considerar que las variables están altamente relacionadas a partir del -0,80. Si r = 0 las variables están incorrelacionadas y por lo son aleatoriamente independientes. Si 0 < r < +1, la correlación es positiva y será tanto más fuerte cuanto más se aproxime a +1. Se dice entonces que existe una relación de dependencia aleatoria. Nosotros vamos a considerar que las variables están altamente relacionadas a partir del +0,80. Pg. nº 6/7 Tema 3 Estudio analítico de la regresión lineal Si entre dos variables existe una fuerte correlación, el diagrama de dispersión se concentrará en torno a una recta. Entonces el problema consiste en encontrar la ecuación de la recta que mejor se ajuste a la nube de puntos. Existen varios métodos, siendo el más utilizado el denominado mínimos cuadrados. Consiste en hacer mínima la suma de los cuadrados de la diferencia entre los valores observados experimentalmente y los teóricos que se obtengan de la recta. De la aplicación de este método se deduce que: La recta de regresión de y sobre x es y y xy (x x ) 2 x La recta de regresión de x sobre y es xx xy ( y y) y2 Una vez obtenidas las rectas de regresión, o solo una de ellas según haga falta para el estudio, seguiremos operando hasta lograr una expresión del tipo: y ax b O x ay b Estas rectas nos permiten predecir el comportamiento de las variables y con ello podemos sacar conclusiones respecto al futuro. Es conveniente representarlas sobre el diagrama de dispersión para comprobar la bondad del ajuste y que no hemos cometido algún error. No hay que olvidar dos cosas: Sólo realizaremos el estudio de regresión si existe una alta relación entre las variables, que nosotros hemos establecido en a partir del + 0’80. No se puede extrapolar a lo loco y fuera de los límites estudiados, pues nada nos garantiza que la serie estadística se siga comportando igual más allá del campo estudiado. Pg. nº 7/7