Validación de modelos

Anuncio

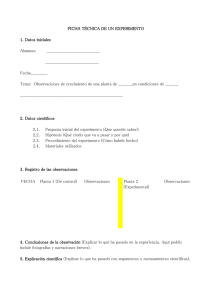

Validación de modelos Prof. Cesar de Prada ISA-UVA [email protected] Indice Modelado Estimación de parámetros Validación de modelos Modelos Representación aproximada de la realidad Abstracción: Incluimos solo aquellos aspectos y relaciones que son de interés. Usos de los modelos: diseño, entrenamiento, que pasa si…., decisiones,... Distintos modelos de un proceso para distintas aplicaciones ¿Como generarlos, resolverlos, utilizarlos, validarlos? Depende del proceso, de la aplicación, de las herramientas y datos disponibles,… ¿Qué es un modelo matemático? Conjunto de ecuaciones que relacionan las variables de interés del proceso y representan adecuadamente su comportamiento Distintas formulaciones para distintos objetivos y tipos de procesos Obtenidas a partir de un conjunto de hipótesis y suposiciones Compromiso entre facilidad de uso en una aplicación y la exactitud de la representación del mundo real Representación adecuada y Proceso u tiempo ym tiempo Modelo tiempo + adecuación y facilidad de uso en la aplicación ¿Como obtener modelos? Mediante razonamientos, usando leyes físicas, químicas, etc Mediante experimentación y análisis de datos Modelos de conocimiento Se obtienen mediante razonamientos y la aplicación de principios de conservación de masa, energía, momento, etc. y otras leyes particulares del dominio de aplicación Basados en un conjunto de hipótesis Tienen validez general si se cumplen las hipótesis de partida Requieren conocimiento profundo del proceso y de las leyes fisico-químicas Identificación El modelo se obtiene a partir de datos experimentales de entrada-salida del proceso U U t Y Y Proceso t Modelo Modelos + Un modelo siempre es una mezcla de conocimiento y de experimentación Modelos Condiciones de uso Hipótesis Objetivos, precisión,.. del modelo Modelado Parametrización Formulación para un fin ¿Se resuelve adecuadamente? Codificación Experimentación Conocimiento Experimentación Lenguaje de simulación Todas las etapas deben ser validadas Hipótesis ci q q c F Mezcla perfecta d Vc = qc i − Fc dt h h F Flujo pistón h Ah V c( t ) = c i ( t − ) = c i ( t − ) = ci (t − ) v Av F Ejemplo: Depósito Conservación de masa q Acumulación= flujo entrada q - flujo salida F h F Parámetros m masa en el depósito A sección del depósito ρ densidad, k constante dm = qρ − Fρ dt m = Aρh F=k h dh V = Ah A = q−k h dt Ecuación diferencial no-lineal Ecuación algebraica Modelos en variables de estado d x(t) = f ( x ( t ), u ( t ), p, t ) dt y( t ) = g ( x , u ( t ), t ) Variables manipuladas y perturbaciones u x x Estados p parámetros y Respuestas observables Modelado d x(t) = f ( x ( t ), u ( t ), p, t ) dt y( t ) = g ( x , u ( t ), t ) Determinación de la estructura del modelo Determinación del valor de sus parámetros Normalmente siempre aparecen alternativas en la formulación del modelo y es necesario escoger entre distintas estructuras En la etapa de validación pueden aplicarse distintos test para elegir que elección fue mas adecuada Parametrización d x(t) = f ( x ( t ), u ( t ), p, t ) dt y( t ) = g ( x , u ( t ), t ) Los parámetros p del modelo pueden obtenerse mediante bibliografía, documentación, etc. pero siempre hay parámetros cuyo valor no se puede determinar de forma sencilla y precisa y que deben ser estimados Ejemplo: reactor químico TT A→B Refrigerante d cA − E RT V cA = Fc Ai − Fc A − Vke dt V d cB = − Fc B + Vke dt −E A Reactor AT Producto RT cA dT − E RT Vρc e = Fρc e Ti − Fρc e T + Vke c A ∆H − UA ( T − Tr ) dt d Tr = Fr ρ r c er Tri − Fr ρ r c er Tr + UA ( T − Tr ) Vr ρ r c er dt Parametrización (calibración) TT u Refrigerante A Reactor AT t y pa pb Producto y u Modelo La respuesta del modelo ante las mismas entradas depende del valor de los parámetros p Parametrización (calibración) Si hay N valores experimentales de la salida se puede definir una función de error como: u 1 N 1 N 2 2 J = ∑ e( t ) = ∑ [y( t ) − y m (u , p, t )] N t =1 N t =1 y(p) y u Modelo t p También pueden usarse otras expresiones para J Parametrización (calibración) 1 N 1 N 2 2 min J = min ∑ e( t ) = min ∑ [y( t ) − y m (u , p, t )] p p p N t =1 N t =1 v u Proceso y e(t) Modelo Optimización ym(p) V es normalmente una función no-lineal en los parámetros. Puede resolverse por minimización numérica p Parametrización por optimización min J = min p p N ∑ [y(t ) − y t =1 x ( t ) = f ( x ( t ), u ( t )) ( p, u , t ) ] 2 m y m (t) = g(x(t), u(t)) p≤p≤p Problema de optimización dinámica con restricciones Entre los parámetros a estimar pueden incluirse también, junto a los parámetros del modelo, estados iniciales desconocidos o entradas no medidas (constantes o parametrizables) Parametrización N 1 1 N 2 min J = min ∑ e( t ) 2 = min ∑ [y( t ) − y m (u , p, t )] p p p N t =1 N t =1 Proceso y Si hay varias salidas a ajustar: 1 N 2 2 2 min ∑ γ1 [y1 ( t ) − y m1 (p, t )] + γ 2 [y 2 ( t ) − y m 2 (p, t )] + γ 3 [y 2 ( t ) − y m 3 (p, t )] p N t =1 Problemas de unidades y pesos relativos. Normalización Qué parámetros estimar Es posible que, para un mismo experimento, la respuesta del modelo con dos valores diferentes p1 y p2 de un parámetro, sea muy o poco diferente u y p1 p2 Solo debería escogerse un parámetro p para la optimización si la salida presenta una sensibilidad razonable ante cambios en p Sensibilidad de las salidas Sensibilidad del índice J N J = ∑ [ y ( t ) − y m ( p, u , t ) ] 2 t =1 x ( t ) = f ( x ( t ), u ( t )) Sij ( t ) = ∂y mi ( t ) ∂p j Sensibilidad de la salida i del modelo respecto al parámetro j en relación a un experimento dado. Es función del tiempo y m (t) = g(x(t), u(t)) ∂J ∂p j Sensibilidad del índice J respecto al parámetro j en relación a un experimento dado. Resume el efecto durante todo el tiempo del experimento Sensibilidades ∂y i ( t ) Sij ( t ) = ∂p j s ij ( t ) = s11 s12 s s 22 21 s m1 s m 2 p j ∂y i ( t ) Dificultad para comparar sensibilidades debido a la diferencia de unidades de cada Sij. Deben usarse factores de escala y i ∂p j s1d s 2d s md La norma de cada columna j de la matriz de sensibilidades da una idea de la importancia del parámetro pj en el valor de las salidas Cálculo de las sensibilidades N J = ∑ [y ( t ) − y m ( p , u , t ) ] t =1 x ( t ) = f ( x ( t ), u ( t )) 2 Pueden obtenerse mediante cocientes de incrementos o analíticamente y m (t) = g(x(t), u(t)) N ∂y m ∂J = 2∑ [y( t ) − y m (p, u , t )] ∂p ∂p t =1 ∂x d ∂x ∂f ∂x ∂f Integrando esta ecuación junto a + = = las del modelo, es posible obtener ∂p dt ∂p ∂x ∂p ∂p la evolución de ∂x/∂p y por tanto las sensibilidades ∂y m ∂g ∂x ∂g + = ∂p ∂x ∂p ∂p Cálculo de las sensibilidades Mediante cociente de incrementos, realizando simulaciones del modelo ∂y i ( t ) y i (p + ∆p, t ) − y i (p, t ) Sij ( t ) = ≈ ∂p j ∆p Las sensibilidades dependen, lógicamente, del punto p en que son evaluadas, y del experimento (a través de las entradas) que se considera Identificabilidad Independientemente del valor de la sensibilidad, puede ocurrir que el efecto sobre la salida de un cambio en un parámetro se anule por un cambio en otro parámetro hecho simultáneamente. Se dice entonces que hay un grado de co-linealidad en las sensibilidades frente a los parámetros, lo que dificulta la identificación La identificabilidad es una propiedad estructural que depende de cómo los parámetros aparecen en el modelo, pero también de las medidas disponibles Identificabilidad Ejemplo: En un reactor, sin medida de temperatura, los parámetros k y E, no pueden ser estimados independientemente V d cB = − Fc B + Vke dt µ ms K+s −E RT cA Si E y R fueran desconocidas, con medida de temperatura se podría identificar el cociente E/R pero no los términos individuales En el modelo de Monod, con datos limitados a sustratos s pequeños, no es posible identificar sino el cociente µm/K Identificabilidad Examinando la matriz de sensibilidades, puede verse si hay un cierto grado de co-linealidad a través del rango de (sub-bloques) de la misma s11 s12 s s 22 21 s m1 s m 2 s1d s 2d s md sij sik La co-linealidad dificulta la identificación t Re-parametrización A veces solo es posible identificar combinaciones de parámetros, o se pueden hacer cambios de variables para obtener una estructura mas sencilla de identificar. Si se ha hecho una transformación de los parámetros a estimar, o se han hecho cambios de variable para facilitar la identificabilidad o linealidad del modelo, debe tenerse en cuenta que: Las características estadísticas de las nuevas variables son diferentes a las de los datos Las regiones de confianza de los nuevos parámetros son diferentes de las de los originales Experimentos u2 TT Ti u1 Tr Reactante T Reactor Refrigerante AT Producto Si hay varias entradas, los cambios en las mismas deben de estar incorrelacionados para que el algoritmo de optimización pueda distinguir los efectos de cada entrada en las salidas Experimentos Si se aplican señales proporcionales a las entradas, u1=αu2, simultaneamente, hay muchas combinaciones de los modelos M1 y M2 que se ajustan a las mismas parejas de entradas y salidas y ( t ) = M 1u 1 ( t ) + M 2 u 2 ( t ) = ( α M 1 + M 2 ) u 2 ( t ) Por otro lado, los experimentos deben cubrir el rango en amplitud y frecuencia adecuado para excitar las dinámicas fundamentales del proceso, y los valores de las sensibilidades de J antes los parámetros a estimar deben presentar unos valores razonables. En caso contrario debe repetirse el experimento Experimentos u2 TT Ti u1 Tr Reactante T Reactor Refrigerante Producto Excitar solo una entrada manteniendo las otras constantes y luego hacer lo mismo con las otras, no es una buena política: alarga el tiempo del experimento y no proporciona datos en condiciones realistas de funcionamiento AT Diseño de experimentos Cabe preguntarse cual es el experimento que mejor facilita la estimación de los parámetros de un modelo N J = ∑ [y( t ) − y m (p, u , t )]' Q[y( t ) − y m (p, u , t )] t =1 Contexto Multivariable Si se hace un desarrollo de 2º orden de J en torno al valor óptimo p* de los parámetros (para cuyo valor ∂J/∂p=0) ' N N ∂y m ( t ) ∂y m ( t ) * E{J(p + δp)} ≈ δp' ∑ Q δp + ∑ tr(CQ) t =1 t =1 ∂p ∂p Con C la matriz de covarianza del ruido de las medidas. Se suele escoger Q=C-1 Diseño de experimentos Para facilitar la estimación, interesa que J(p*+δp) sea lo mayor posible, de modo que unos parámetros distintos del óptimo den un valor de J significativamente mayor ' N N y ( t ) y ( t ) ∂ ∂ * E{J(p + δp)} ≈ δp' ∑ m Q m δp + ∑ tr(CQ) t =1 t =1 ∂p ∂p Para ello puede diseñarse un experimento que maximice la matriz de Información de Fisher (o alguna norma o función ' asociada): N ∂y m ( t ) ∂y m ( t ) Q ∑ t =1 ∂p ∂p FIM Si no hay dependencia lineal entre las sensibilidades, la matriz de información de Fisher debe ser de rango completo. El cociente entre el máximo y mínimo valor propio de la FIM de por tanto una medida de la identificabilidad de los parámetros de un modelo con un experimento dado. N ∂y m ( t ) ' ∂y m ( t ) Q ∑ t =1 ∂p ∂p Parametrización por optimización N min J = ∑ [y( t ) − y m (p, u , t )] p 2 t =1 x ( t ) = f ( x ( t ), u ( t )) y m (t) = g(x(t), u(t)) p≤p≤p Elección del tipo de índice J Problemas de resolución numérica •Simulación •Resolución directa Problemas de estimación de estados Otras funciones objetivo J Maximum Likelihood (ML) Para un valor de los parámetros p, ¿cual es la probabilidad de que los resultados del modelo coincidan con los datos experimentales? Se plantea la estimación como encontrar p de modo que se maximice esa probabilidad max P( y m (0) = y(0), y m (1) = y(1),...., y m ( N) = y( N) | p) p Se suele formular como min − ln( P( y m (0) = y(0), y m (1) = y(1),...., y m ( N) = y( N) | p)) p Mínimos cuadrados ponderados (WLS) Si los datos experimentales están distribuidos de forma normal en torno a las predicciones del modelo y son independientes, la probabilidad de obtener como salida del modelo los datos experimentales es: L( y m (1) = y(1),..., y m ( N) = y( N) | p) = N =∏ t =1 2 N 1 y( t ) − y m ( y, p) 1 exp − ∑ σ 2 ( t ) 2πσ( t ) t = 1 Tomando neperianos, maximizar esta función equivale a N 1 2 ( ) min ∑ y ( t ) − y ( t , p ) m 2 p σ ( t ) t =1 σ2 varianza del error de medida WLS N 1 2 ( ) − J (p) = min ∑ y ( t ) y ( t , p ) m 2 p σ ( t ) t =1 Si los errores son independientes y están de verdad distribuidos normalmente, J(p) debe seguir una distribución χ2 con N-d grados de libertad Puede usarse como un test de las hipótesis anteriores o de la bondad del modelo Otras funciones objetivo N min p ∑ y( t ) − y t =1 m ( t , p) min max y( t ) − y m ( t , p) p t Norma 1 Pesa por igual todos los errores Norma ∞ minimiza el mayor de los errores Resolución con simulación N min J = ∑ [y( t ) − y m ( p, u , t )] p 2 t =1 ( t ) = f ( x ( t ), u ( t )) x y m (t) = g(x(t), u(t)) p≤p≤p Optimizador p J Simulación desde 1 a N para calcular J(p) u(t), y(t) Minimización de funciones θ2 dk J(θ) θ1 θ1 θk+1= θk+αdk Métodos iterativos θ2 Restricciones en p d dirección de búsqueda α longitud del paso Resolución por Discretización N min J = ∑ [y( t ) − y m ( p, u , t ) ] p, x j=1 x ( t + 1) = f ( x ( t ), u ( t )) x ( t + 2) = f ( x ( t + 1), u ( t + 1)) x ( t + 3) = f ( x ( t + 2), u ( t + 2)) ..... p≤p≤p 2 y(t) = g(x(t), u(t) y(t + 1) = g(x(t + 1), u(t + 1)) y(t + 2) = g(x(t + 2), u(t + 1))))) Se incrementa el número de variables de decisión con los estados Es posible imponer restricciones sobre el estado Resolución con SQP / IP La discretización puede ser difícil Optimización local / global Muchos métodos de optimización conducen a soluciones locales que no proporcionan los mejores valores de los parámetros Conviene utilizar métodos globales: Estocasticos (algoritmos genéticos, etc.) Deterministas (α-BB) Varianza de las estimas Una vez que se ha aplicado un procedimiento de optimización y se han obtenido unos parámetros óptimos p* , es importante determinar el grado de confianza en los mismos. Matriz de covarianza Regiones de confianza de los parámetros Isodistancias En el caso de estimación no lineal muchas de las medidas de la imprecisión son aproximadas Covarianza del error N ∂y m ( t ) ' ∂y m ( t ) F = ∑ Q t =1 ∂p ∂p La matriz de información de Fisher es la inversa de la matriz de covarianza del error de estimación de los parámetros, calculados con el mejor estimador lineal no sesgado. Esta medida supone que los errores son solo de medida. Una expresión de la matriz de covarianza de los errores de estimación (para el caso de una sola salida en el ajuste) mas ajustada viene dada por: * V= J (p ) −1 F N−d Regiones de confianza Conocida la matriz de Fisher, la expresión: ' N N ∂y m ( t ) ∂y m ( t ) * E{J(p + δp)} ≈ δp' ∑ Q δp + ∑ tr(CQ) t =1 t =1 ∂p ∂p Permite el cálculo aproximado de regiones de confianza de los parámetros estimados que pueden dibujarse como “elipses” cuyos ejes coinciden on los vectores propios de la FIM Intervalos de confianza Estimada V, es posible determinar intervalos de confianza para cada parámetro, para un determinado nivel de confianza: p ± 2.147 Vii 90% p ± 3.035 Vii 99% Aunque en un entorno multiparamétrico deben tomarse con cierta reserva, pues la región de confianza conjunta no equivale a la caja resultante de la individual de cada parámetro Conjuntos de parámetros factibles Zona de Limites y busqueda p2 Conjunto factible Respuesta admisible Datos experimentales p1 Se define una respuesta aceptable del modelo (por ejemplo con bandas de error, o un valor máximo aceptable de J. Se generan aleatoriamente valores de p dentro de un rango y se hace la simulación del modelo con los mismos. Se incorporan al conjunto de parámetros aceptables los que cumplen el criterio, definiendo la región buscada Identificación Global Criterio de minimización del error :Dado un conjunto de datos experimentales u(t), y(t), buscar los parámetros θ que minimizan la función de coste J : N 1 N 1 2 J = ∑ e( t ) 2 = ∑ [( y( t ) − y m ( t , θ)] N t =1 N t =1 v u y Proceso e(t) Modelo y m m Identificación global 1 N 2 J = ∑ [( y( t ) − M (θ)u ( t )] N t =1 θ2 f (θ) = J = cte. Isodistancia: Lugar geométrico de los puntos del espacio paramétrico con igual valor de J θ1 Todos los modelos sobre una isodistancia tienen la misma validez respecto al criterio de suma de cuadrados de errores Identificación global Isodistancia experimento 2 θ2 Modelos que explican ambos experimentos Isodistancia experimento 1 θ1 Las isodistancias dependen de los datos experimentales y del nivel de exactitud J elegido Isodistancias Exp 1 θ2 θ2 Exp 2 θ1 Informan sobre la calidad de los parámetros, y el rediseño de experimentos θ1 Nivel de calidad no compatible con los experimentos Cálculo de Isodistancias Κ Ejemplo con un modelo sencillo de primer orden x x a −1 1 Kq J = ∑ ( y ( t ) − u ( t ) −1 N t =1 1 + aq N 2 Para cada valor de a se resuelve una ecuación de segundo grado para obtener el correspondiente valor de K Regiones de confianza En un caso mas general, la construcción de isodistancias es compleja. Una forma de construir las curvas de un criterio dado, p.e. con un nivel de confianza del 100(1-α) %, o sea, los puntos para los que d Fα , d , N − d ) J = J (p )(1 + N−d * es establecer una región amplia y partiendo de puntos del contorno, optimizar hasta que J alcanza ese valor F: distribución F con d y N-d grados de libertad y nivel α Parametrización / Metodología Toma de datos experimentales (separar los de calibración y validación) Análisis y depuración de los datos Selección de los parámetros a estimar Identificabilidad estructural Cálculo de Sensibilidades Posible reparametrización del modelo para linealizar la estimación Estimas iniciales y rangos Elegir la función de costo Estimar los parámetros por optimización Estimar los residuos y la región de confianza de los parámetros Ejemplo en EcosimPro: Reactor de Van der Vusse Reactor altamente no lineal y difícil de controlar A→B→C 2A → D Parámetros a estimar: Volumen 10 l Masa de refrigerante 5 Kg Resolución con simulación N min J = ∑ [y( t ) − y m (p, u , t )] p 2 j=1 x ( t ) = f ( x ( t ), u ( t )) y m (t) = g(x(t), u(t)) p≤p≤p resultado Optimizador p Proceso simulado p* J Simulación desde 1 a N para calcular J(p) u(t), y(t) Reactor Van der Vusse Validación Validar un modelo es obtener un grado de confianza en el mismo para el fin al que se destina No hay una “demostración” de la validez de un modelo, sino unos resultados positivos en un conjunto de test que nos dan esa confianza La validez de un modelo puede perderse por un solo test negativo Validación El conjunto de test positivos y negativos permiten establecer el rango de validez del modelo Distintas situaciones implican distintas técnicas: El proceso existe y se trata de construir un modelo que reproduzca la realidad El proceso no existe aún y se trata de construir un modelo para predecir su comportamiento y optimizarlo cara al diseño Validación Conjunto de pruebas de diferente naturaleza que ayudan a validar el modelo La validación ha de hacerse a todos los niveles de construcción del modelo: Hipótesis Formulación Codificación Resolución numérica (verificación) Aplicación Niveles de validación Rango de validez Toma de datos /reconciliación ¿Cómo es de sensible la solución frente a cambios en los parámetros? ¿Es un código robusto, rápido,..? ¿Se resuelve adecuadamente? Hipótesis Las condiciones de uso son las previstas? Modelado ¿Refleja bien los fenómenos de interés? Parametrización Codificación Experimentación ¿Los datos son correctos e informativos? ¿Está bien codificado? ¿Los resultados corresponden a la realidad? Distintos problemas asociados a un modelo d x(t) = f ( x ( t ), u ( t ), p, t ) dt y( t ) = g ( x , u ( t ), t ) ¿Que se supone conocido para estimar el resto? Reconciliación de datos Estimación de estados y perturbaciones Estimación de parámetros Verificación Validación Reconciliación de datos d x(t) = f ( x ( t ), u ( t ), p, t ) dt y( t ) = g ( x , u ( t ), t ) Suele plantearse en estado estacionario El modelo se supone perfecto y se trata de estimar las modificaciones en los datos experimentales que hacen que estos se ajusten exactamente al modelo Puede combinarse con estimación de parámetros Estimación de estados con horizonte deslizante x N 2 [ ] y ( t − i ) − y ( t − i ) + γv( t − i) 2 ∑ m ,v min xt−N i i =0 x ( t + 1) = f ( x ( t ), u ( t ), v( t )) y( t ) = g ( x ( t ), u ( t )) L v ≤ v( t − i) ≤ L V v t-N t y u t t-N Con modelo perfecto ¿Qué estado inicial pasado en t-N y que mínimas perturbaciones v(t-i) harían evolucionar el sistema de la forma mas próxima a la que lo ha hecho al aplicarle los controles que le han sido aplicados? Verificación ¿El modelo de simulación representa adecuadamente al modelo conceptual? Codificación Errores tipo división por cero, etc. Métodos numéricos de solución Precisión Formulación ci q h c d (Vc) = qc i − Fc dt Vc c = dV V = q−F dt dV dc +c = qc i − Fc dt dt dc V + c(q − F) = qc i − Fc dt dc V = q (c i − c) dt V F Mezcla perfecta ρ constante Causalidad dh A = q−F dt q F=k h Causalidad computacional h F Causalidad física q h F ¿Qué pasa si? ¿Qué debo hacer para? La causalidad fija el uso del modelo Computabilidad q1 q2 h1 h2 F1 dh A1 1 = q 1 − F1 dt F1 = k 1 h 1 − h 2 F2 dh A 2 2 = q 2 + F1 − F2 dt h 1 < h 2 ? F2 = k 2 h 2 F1 = k 1 sgn( h 1 − h 2 ) h 1 − h 2 0 ≤ h i ≤ h max Leyes + restricciones qi ≥ 0 Validación Respuestas cualitativas del modelo Comprobación con datos experimentales Test estadísticos Análisis de sensibilidad Capacidad de predicción del modelo Distorsión de parámetros Respuestas cualitativas Respuestas cualitativas del modelo a entradas tipo u y Model Discusión y evaluación de respuestas tipo del modelo con expertos en el proceso Respuestas cualitativas Respuestas cualitativas del modelo a entradas tipo Respuestas cualitativas Test de Turing: ¿Se puede discriminar una respuesta del modelo y de la realidad si se presentan en el mismo formato? Trazas de la evolución de variables tipo flujo, etc. a través de los distintos componentes Comprobación con datos experimentales Comparación de las respuestas del modelo y datos experimentales distintos a los usados en la parametrización v u y Proceso Modelo(p) ym y 1 N 2 ( ) − y ( t ) y ( t ) ∑ m N t =1 modelo experimental condiciones iniciales perturbaciones t Indices de error Medida numérica de las discrepancias entre la respuesta del modelo y los datos experimentales Pueden usarse para comparar varios modelos de un proceso y decidir sobre cual es mas adecuado ym y 1 N 2 ( ) − y ( t ) y ( t ) ∑ m N t =1 modelo experimental t Indices de error Muchos índices ponderan la suma de los errores y el número de parámetros d en el modelo Final Prediction Error FPE 1 1+ d N N )∑ ( y( t ) − y m ( t )) 2 ( N 1 − d N t =1 Estima de la varianza del error de predicción con los datos nuevos Akaike Information Criterion AIC 2d N (1 + )∑ ( y( t ) − y m ( t )) 2 N t =1 N 2 ( ) y ( t )) y ( t − ∑ m + 2d N log t =1 N Indices de error Bayesian Information Criterion BIC 2 ∑ ( y( t ) − y m ( t )) + d log( N) N log t =1 N N Es consistente: La probabilidad de seleccionar un modelo erroneo tiende a cero con N Rissamen’s Minimal Description lenght N 2d (1 + log N)∑ ( y( t ) − y m ( t )) 2 N t =1 Penaliza mas la complejidad del modelo Indices de error Test F para ver si el modelo j (con mas parámetros) es significativamente mejor que el modelo i, con un nivel α de confianza N N 2 2 ∑ ( y( t ) − y m ( t )) /(d j − d i ) − − ( y ( t ) y ( t )) ∑ m t =1 = t 1 mod j mod i N 2 /( N − d j ) ∑ ( y( t ) − y m ( t )) t =1 mod j Debe compararse con la distribución F(dj-di, N-dj) con el nivel α de confianza Errores Los errores de la estimación provienen de: Errores de medida de los datos. Idealmente se suelen suponer independientes, de media cero y varianza constante. Para caracterizarlos pueden usarse datos de las salidas con entradas constantes. Errores del modelo o la estima de parámetros. Si el modelo fuera perfecto, los residuos deberían tener las mismas características estadísticas que los errores de medida. Test estadisticos v u y Proceso e Modelo ym Si el modelo es correcto los residuos no deben presentar una estructura “sistemática”, sino ser el resultado de las perturbaciones aleatorias que actuan sobre el proceso Residuos e(t) = y(t) - ym(t) Test estadísticos Inspección visual de los residuos e e t t nº de cambios de signo de los residuos (ncs) ¿Se ajustan a un modelo AR? N ncs − Puede compararse con una distribución N(0,1) 2 Test: para ver si hay un sesgo en los signos N/2 Test estadísticos No correlación entre la entrada y los residuos: Los errores deben ser independientes de un experimento particular Rue(k) Re(k) 2σ k Blancura de los residuos 2σ k Lazo abierto, lazo cerrado Varianza de los parámetros Las regiones de confianza de los parámetros dan una medida de la calidad de la calibración y, por tanto, de la bondad el modelo. v11 V = v 21 v12 v 22 Los términos cruzados de la matriz de covarianza dan una idea de la independencia de los parámetros, pues deben estar incorrelacionados Sensibilidad ¿ Cuanto varia J ante un cambio unidad en p ? N min J = ∑ [y( t ) − y m ( p, u , t )] p 2 j=1 x ( t ) = f ( x ( t ), u ( t )) y m (t) = g(x(t), u(t)) p≤p≤p Puede obtenerse a partir del problema dual de optimización en ciertos casos Validación Capacidad de predicción del modelo Distorsiones de los parámetros Coherencia de las distintas representaciones Varianza de las estimaciones { var G (e jwt n Φ v ( w) , θ) ≅ N Φ u ( w) } Capacidad de predicción ŷ( t + j) y(t+j) u(t+j) t En ciertos casos, se utilizan fórmulas de predicción de controladores predictivos tales como el DMC, GPC, etc. Distorsión de parámetros d x(t) = f ( x ( t ), u ( t ), p, t ) dt y m ( t ) = g ( x , u ( t ), t ) Tras la estimación de parámetros se obtiene un valor de los mismos p* (constante) que ajusta lo mejor posible la respuesta del modelo a los datos experimentales e* ( t ) = y ( t ) − y m ( p * , t ) Distorsión de parámetros Butterfield 1986 Supongamos que ahora los parámetros p pueden variar a lo largo del tiempo, ¿ Como habría que modificar el valor de los parámetros del modelo para que sus respuestas coincidieran exactamente con las del proceso? El valor de la distorsión da una medida de la credibilidad del modelo p t min y m ( t , p* + ∆p( t )) = y( t ) ∆p t = 1,..., n Distorsión de parámetros d x p (t) = f ( x p ( t ), u ( t ), p* + ∆p( t ), t ) dt y p ( t ) = y( t ) = g ( x p , u ( t ), t ) Problema de índice y p modelo experimental t t Métodos de solución (1) 1 Calcular xp a partir de y( t ) = g ( x p , u ( t ), t ) 2 Calcular dxp /dt a partir de xp 3 Calcular ∆p(t) a partir de d x p (t) dt = f ( x p ( t ), u ( t ), p* + ∆p( t ), t ) Imprecisión en el cálculo de la derivada Métodos de solución (2) Aproximación lineal sobre la respuesta base p* d x p (t) = f ( x p ( t ), u ( t ), p* + ∆p( t ), t ) dt y p ( t ) = g ( x p , u ( t ), t ) = y( t ) d x p (t) dt = f ( x ( t ), u ( t ), p* , t ) + y p ( t ) = g ( x , u ( t ), t ) + ∂g ∂x p ∂f ∂x p (x p − x) + x , p* (x p − x) x , p* ∂f ∆p ∂p x ,p* Linealización sobre una trayectoria ∆x ( t ) x x base tiempo p ∆p( t ) t Métodos de solución (2) d x p (t) = f ( x p ( t ), u ( t ), p* + ∆p( t ), t ) dt y( t ) = g ( x p , u ( t ), t ) dφ dx p dx = − = dt dt dt φ = xp − x ∂f ≈ f ( x ( t ), u ( t ), p , t ) + ∂x p * dφ ∂f = dt ∂x p d x(t) = f ( x ( t ), u ( t ), p∗ , t ) dt y∗m ( t ) = g ( x , u ( t ), t ) ∂f ∆p φ+ ∂p x ,p* x , p* ∂f (x p − x) + ∆p − f ( x ( t ), u ( t ), p* , t ) ∂p x ,p* x , p* Metodos de solución (2) y p ( t ) − y m ( t ) = g ( x p , u ( t ), t ) − g ( x , u ( t ), t ) = = g ( x , u ( t ), t ) + ∂g ∂x p ( x p − x ) − g ( x , u ( t ), t ) x , p* y p ( t ) − y m ( t ) = y( t ) − y m ( t ) = ∂g ∂x p φ x , p* Metodos de solución (2) ∆p e* R + - yp-ym φ = xp − x dφ ∂f = dt ∂x p ∂f ∆p φ+ ∂p x ,p* x , p* yp (t) − ym (t) = ∂g ∂x p φ x , p* Si ∆p es correcto: y p ( t ) − y m ( t ) = y ( t ) − y m ( t ) = e* Resolución como un problema de control Métodos de solución (3) Puede plantearse también como un problema de optimización N min ∑ α ( x p ( t ) − x ( t )) 2 + β∆p 2 + λ ( y( t ) − y p ( t )) ∆p t =1 d x p (t) dt = f ( x p ( t ), u ( t ), p* + ∆p( t ), t ) Multiplicador de Lagrange Problema de optimización dinámica Se calculan las menores distorsiones de parámetros y estados compatibles con la restricción de igualdad de las salidas del modelo distorsionado y del proceso Distorsión de parámetros Los valores de ∆p(t), que suelen tener significado físico, pueden compararse con tolerancias esperadas de variación También puede compararse con un indicador función de V(∆p) V ∆p